《Generative Image Inpainting with Adversarial Edge Learning》论文阅读之edge-connect

Paper:edge-connect

code1:edge-connect

code2:Anime-InPainting

使用对抗边缘学习进行生成图像修复

背景

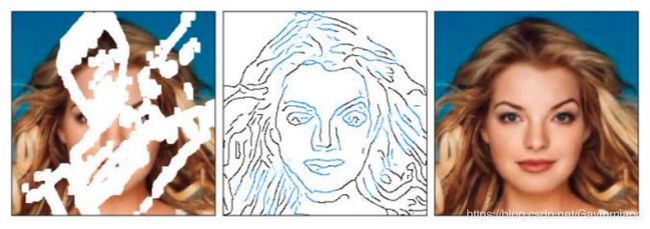

在过去几年中,深度学习技术在图像修复方面取得了显着进步。然而,许多这些技术无法重建合理的结构,因为它们通常过度平滑和/或模糊。比如

或者合成结果很好,视觉效果真实,但和原始照片却不一样。比如:

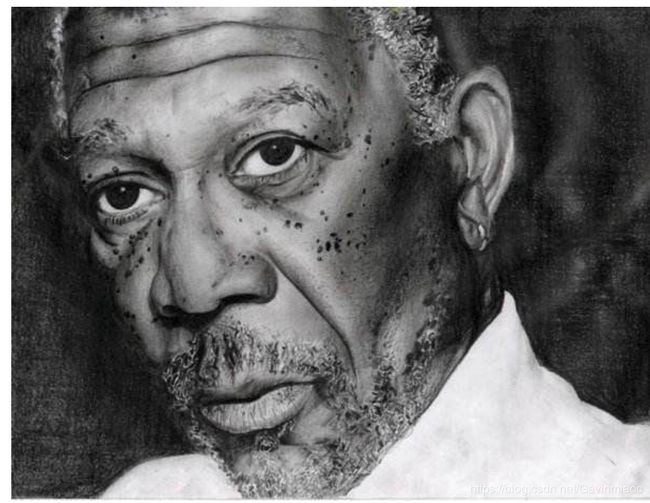

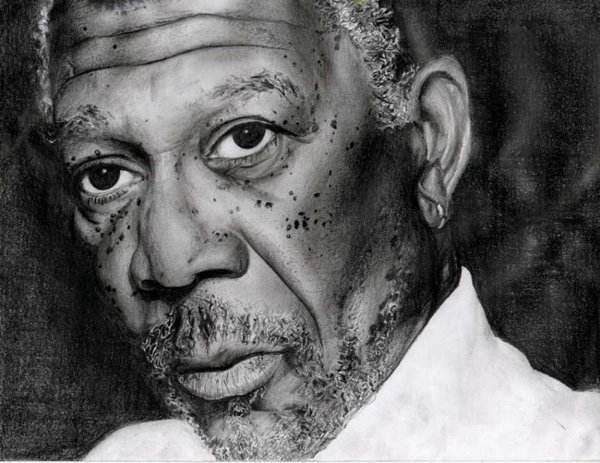

两张修复照片看起来都很正常,但原人不是长这样。深度生成模型只把生成范围限定在了「眼睛」上,而没有定位到更精细的纹理。对比一下庐山真面目:

再看看这个例子,空白区域越多,图像补全的时候就越任性(最右侧是原始图像):

以上示例皆选自论文《Image Inpainting for Irregular Holes Using Partial Convolutions》,读者可参见《心中无码:这是一个能自动脑补漫画空缺部分的 AI 项目》一文。

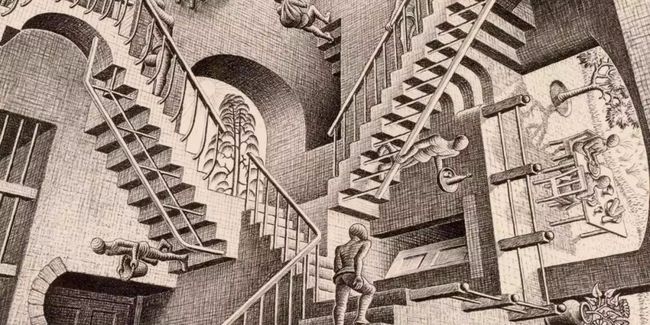

在用媒介还原真实世界的历史上,人们有一个共识,即边缘才是物体最具辨识度的信息。所以,在彩色照相技术出现之前,我们是通过素描、速写、黑白照片等来记录世界,并认为其足够真实和还原。

除非你是立体主义、超现实主义、印象主义、浮世绘主义、国风主义...

不知道是不是也抱着这样的想法,加拿大安大略理工大学理学院的研究者开发了一种结合边缘信息先验的图像修复方法,其可以更好地再现显示精细细节的填充区域。

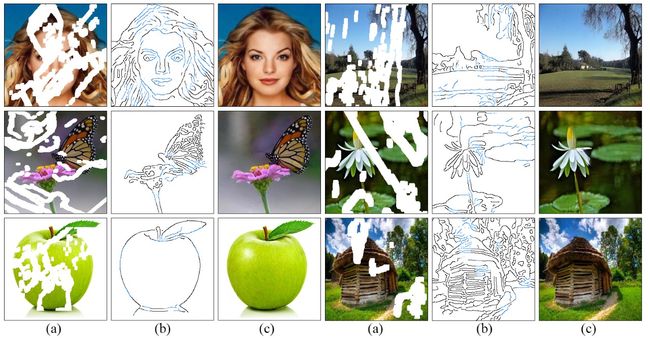

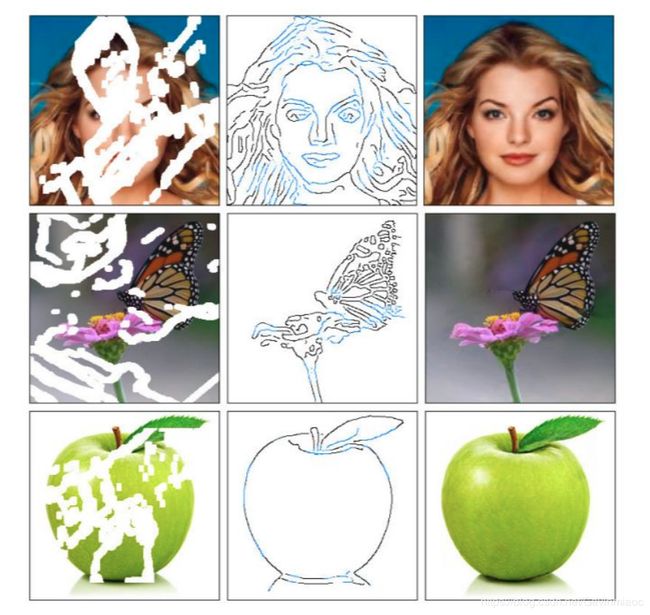

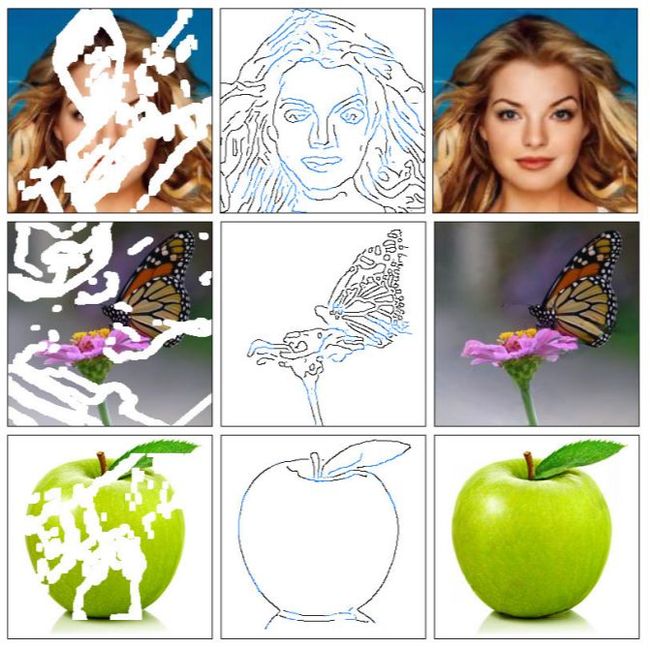

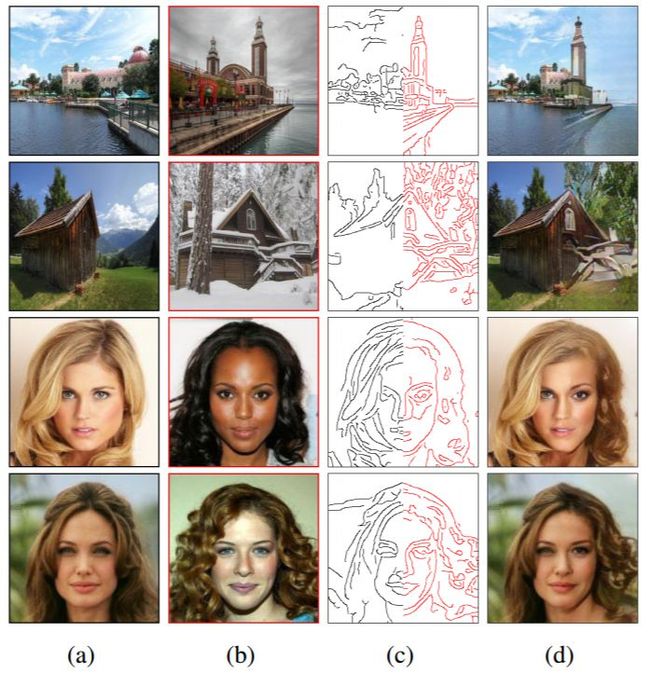

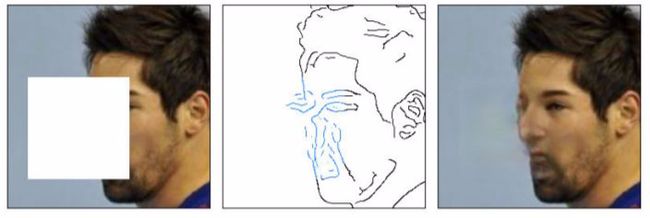

生成效果如下所示,补全模型会先生成中间所示的完整边缘信息,然后结合失真信息一起生成最终的修复图像。

EdgeConnect,一种基于边缘补全的图像修复新方法,这篇文章将图像修复的工作分成了两个部分,首先利用利用启发式的生成模型得到了缺失部分的边缘信息,随后将边缘信息作为图像缺失的先验部分和图像一起送入修复网络进行图像重建。(from 安大略技术大学)

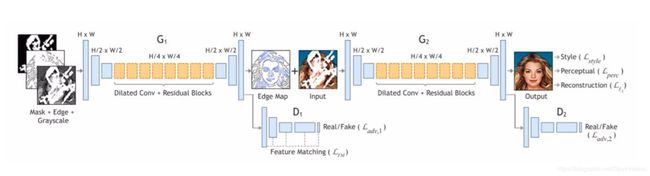

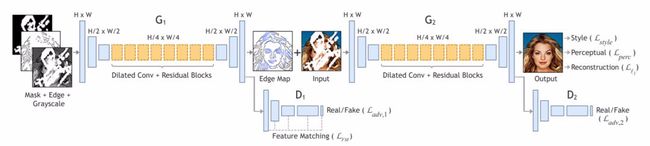

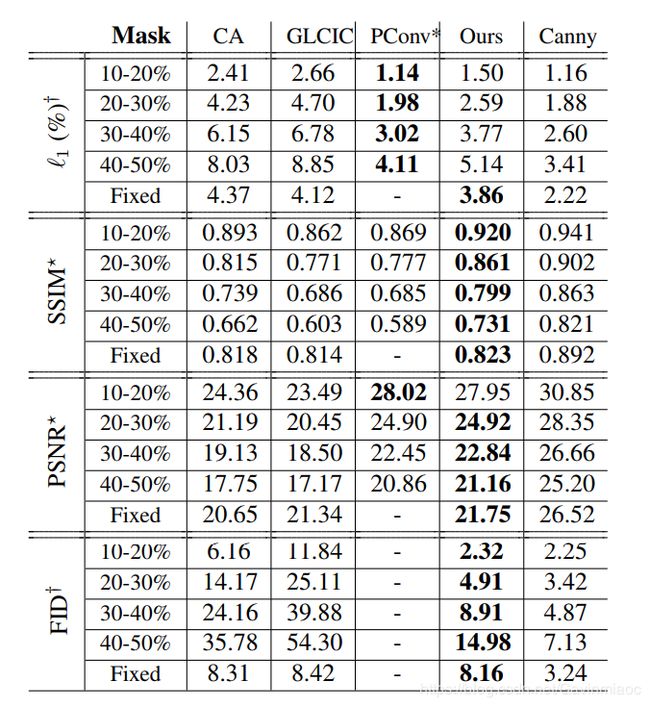

具体来说,作者们提出了一个二阶段生成对抗网络 EdgeConnect,它包括一个边缘生成器,然后是一个图像补全网络。边缘生成器在图像的缺失区域(规则和不规则)生成预测边缘,然后图像补全网络使用预测边缘作为先验填充缺失区域。研究者通过公开可用的数据集 CelebA、Places2 和 Paris StreetView 对模型进行端到端评估,并表明它在数量和质量上优于当前最先进的技术。

-

论文地址:https://arxiv.org/pdf/1901.00212.pdf

-

项目地址:https://github.com/knazeri/edge-connect#citation

研究者已经在 GitHub 中基于 Places2、CelebA 和 Paris-StreetView 数据集给出了全部预训练模型。

介绍

我们开发了一种新的图像修复方法,可以更好地再现填充区域,这些区域展示了受我们对艺术家工作方式的理解启发而产生的细节:首先是线条,然后是颜色。我们为此提出了一个二阶对抗模型EdgeConnect,它包括边缘生成器,然后紧接着是图像补全网络。边缘生成器可以使得图像的缺失区域(包括规则和不规则)的边缘产生幻觉,接下来图像补全网络会利用这个幻觉边缘作为先验补全缺失的区域。有关本系统的详细说明,可以参阅我们的论文。

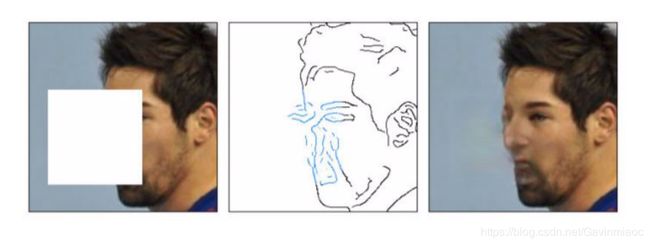

(a)输入缺失区域的图像,并用白色填充缺失的区域。

(b)计算边缘掩码。 使用Canny边缘检测器计算以黑色绘制的边缘(对于可用区域); 而蓝色显示的边缘被边缘发生器网络幻觉化。

(c)图像修复拟议方法的结果。

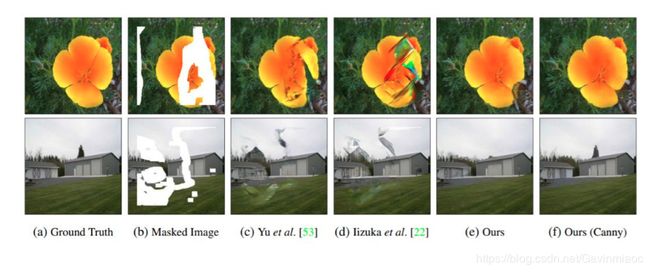

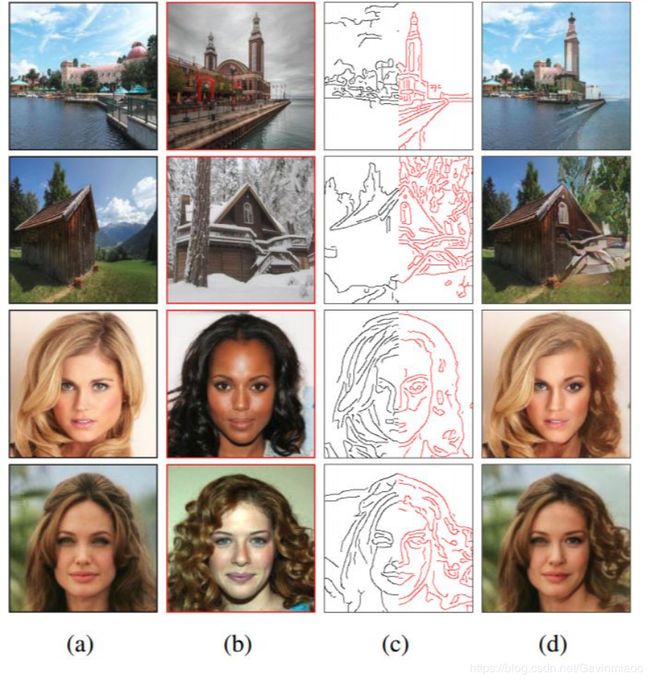

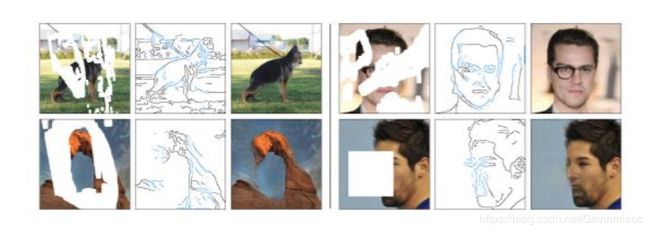

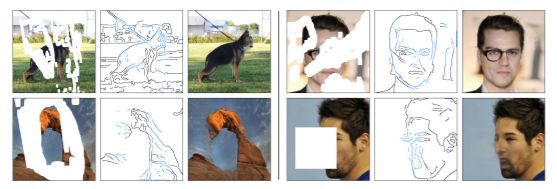

下图中展示了他们的方法和其它已有模型的对比。相比之下,EdgeConnect 修复的边缘信息精确得多,基本不会无中生有,和真实图像最接近。

图 3:和已有方法的定性结果对比。(a)原始图像;(b)添加白色掩码的图像;(c)Yu et al.;(d)Iizuka et al.;(e)本文的方法(端到端);(f)本文的方法(Canny σ = 2)

下图是方法概览。不完整的灰度图像和边缘图以及掩模是第一阶段 G1 的输入,用于预测完整边缘图。将预测的边缘图和不完整的彩色图像传递给第二阶段 G2 以执行修复任务。

其中,下图中间的蓝色显示的边缘是由边缘生成器网络所预测而补全的(对于缺失的区域)。

图 1:(左)输入缺失区域的图像。缺失的区域用白色表示。(中)计算边缘。使用 Canny 边缘检测器计算以黑色绘制的边缘(对于可用区域);而蓝色显示的边缘是由边缘生成器网络所预测而补全的(对于缺失的区域)。(右)图像修复的结果。

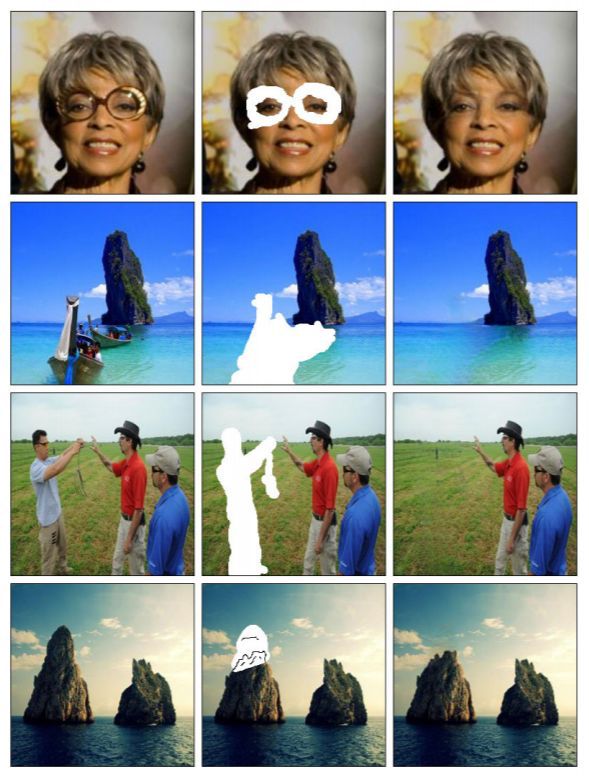

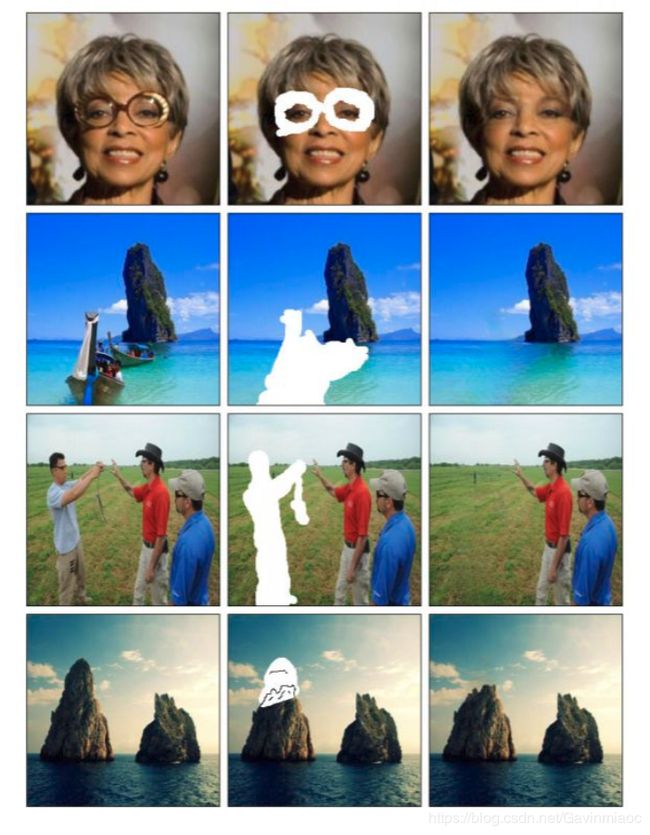

再看看更多的图像拼接、移除和编辑的例子吧:

图 10:使用(a)的左侧和(b)的右侧生成(c)的边缘图,最后生成(d)的拼接图。

图 11:使用 EdgeConnect 进行目标移除和图像编辑的示例。(左)原始图像。(中)使用可选边缘信息移除不想要的目标来引导图像修复。(右)最终生成图像。

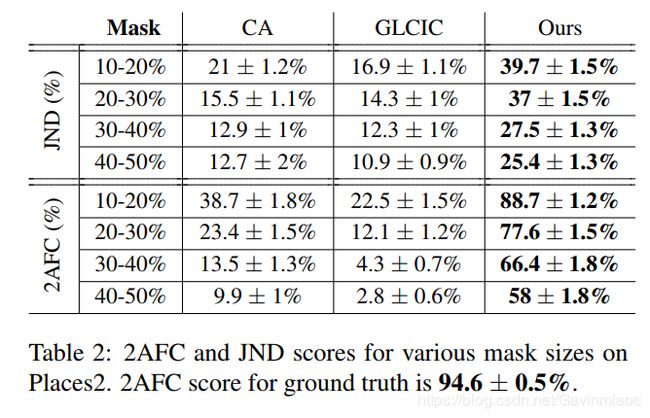

定量分析

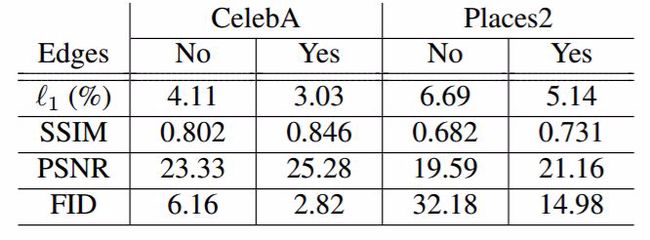

现在将注意力转向这项工作的关键假设:边缘信息有助于图像修复。表 3 显示了有和没有边缘信息的修复结果。当边缘信息被整合到修复模型中时,EdgeConnect 在每个度量上都获得了更好的分数,即使图像的大部分缺失也是如此。

表 3:有边缘信息(完整模型)和无边缘信息(仅包含 G2 阶段)的修复结果的对比。

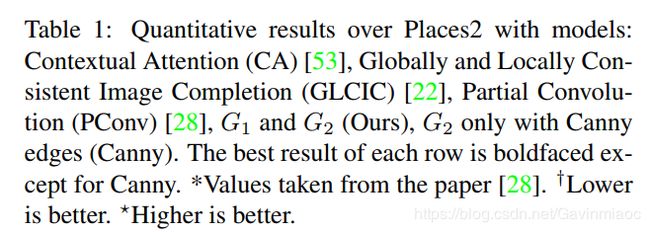

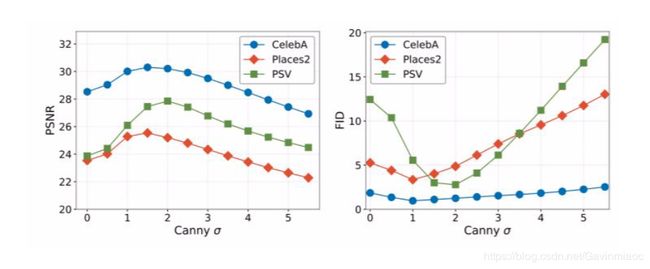

研究者使用了参数σ来控制图像补全网络可用的边缘信息量。

对于较大的σ值,可用的边缘太少,不能保证生成的图像质量。另一方面,当σ太小时,生成太多边缘,这对于所生成图像的质量也会产生不利影响。也就是说,存在合适的最佳σ值,或者说我们只需要适当的边缘信息量。图 6 展示了修复图像的质量随 σ的变化。

图 6:PSNR 和 FID 随 σ的变化。

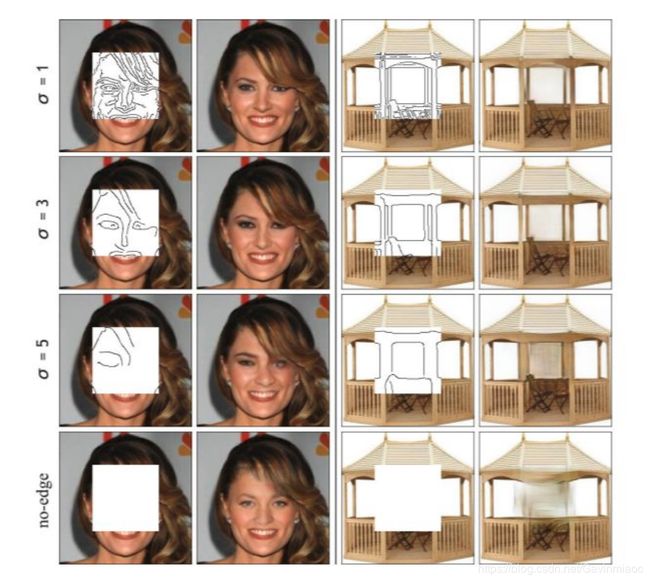

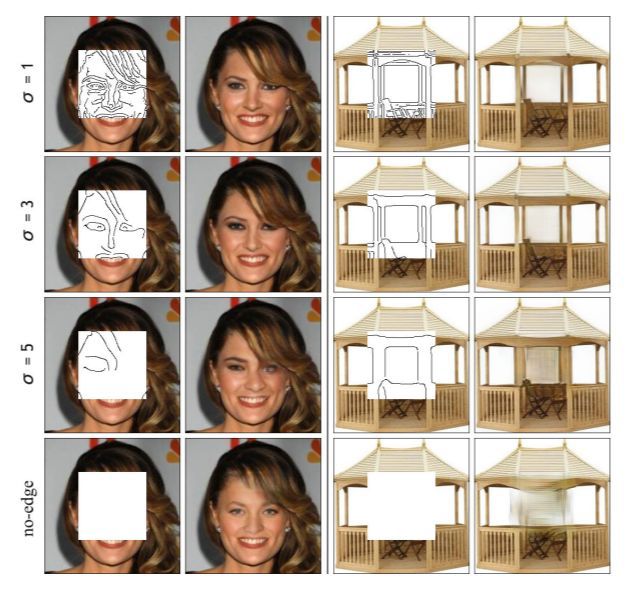

图 7 展示了σ的不同值如何影响具体的修复任务。注意,在边缘数据稀疏的区域中,修复区域的质量降低。例如,在σ= 5 的修复图像中,左侧人脸的左眼重建得比右眼更锐利。但是并不是说每张图像需要的最优σ值都是一样的。

图 7:Canny σ对图像修复结果的影响。

实际上,EdgeConnect 可以看成是两个模型,包含了第一阶段的边缘预测就可以用于图像修复,不包含则可以用于图像编辑,只要描绘出合适的边缘就能在第二阶段生成合适的图像。实际上,在最上方展示的人脸案例中,EdgeConnect 可能也很难还原真实的边缘信息,他们也给出了一些失败案例。

研究者计划开发更好的边缘探测器。虽然有效地描绘边缘比数百条细节线更有用,但是边缘生成模型有时无法准确地描绘高度纹理化区域中的边缘,或者当图像的大部分缺失时,如图 9 所示。

图 9:无法生成相关边缘信息的修复结果的失败案例。

这项研究值得关注的地方在于,使用了多阶段的方法,选择了相关度足够高的、生成难度较低的先验信息,作为下一阶段的先验,简单而高效。

研究者表示,通过改善边缘生成系统,或许可以将该模型扩展到高分辨率修复应用。

参考文章:

1.https://www.jiqizhixin.com/articles/010603

2.https://blog.csdn.net/u014636245/article/details/85700023

3.https://ai.yanxishe.com/page/blogdetail/9801