Document Control

| Author |

Version |

Time |

Comment |

| V0.1 |

Feb 26th, 2019 |

First commit |

|

|

|

|

|

|

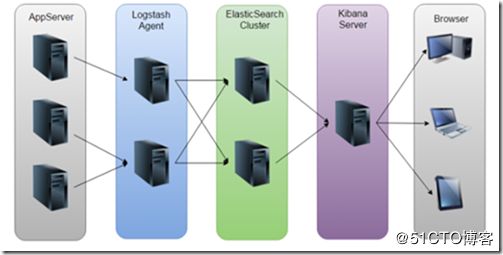

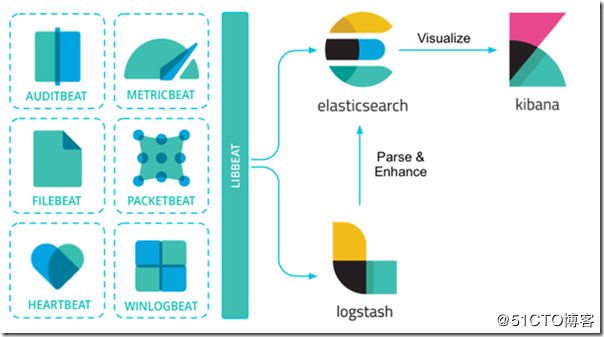

ELK Infrastructure architecture

Installation Elasticsearch on Linux

Goto download page

https://www.elastic.co/downloads/elasticsearch#ga-release

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-6.6.1.rpm

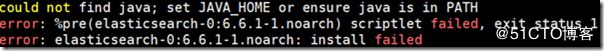

Make sure you have jdk 1.8

If not please install jdk 1.8 first

yum install -y java

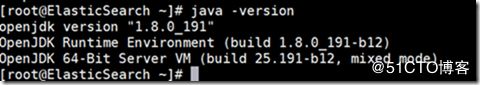

Verify java has been installed successful

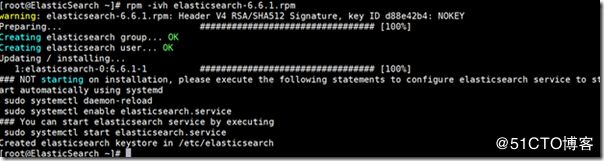

install the elastics rpm

start and check the services

service elasticsearch start

service elasticsearch status -l

make sure port 9200 / 9300 is up and running

netstat -ntlp

setup auto restart

systemctl enable elasticsearch

![]()

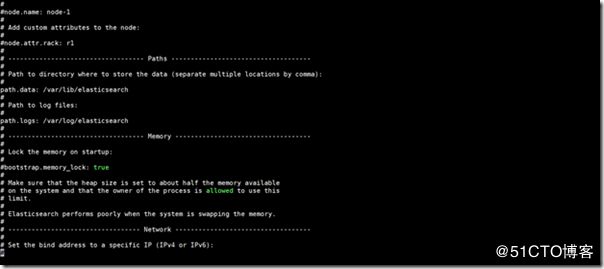

Configuration Elasticsearch

vi /etc/elasticsearch/elasticsearch.yml

update with hostname and port

cat /etc/elasticsearch/elasticsearch.yml | grep -v ^#

path.data: /var/lib/elasticsearch

path.logs: /var/log/elasticsearch

network.host: 10.143.40.130

http.port: 9200

restart the services after yml file has been update

telnet port from other host to make sure port is up

Configuration Elasticsearch option

https://www.elastic.co/guide/en/elasticsearch/reference/7.x/settings.html

elasticsearch的config文件夹里面有两个配置文 件:elasticsearch.yml和logging.yml,第一个是es的基本配置文件,第二个是日志配置文件,es也是使用log4j来记录日 志的,所以logging.yml里的设置按普通log4j配置文件来设置就行了。下面主要讲解下elasticsearch.yml这个文件中可配置的 东西。

cluster.name: elasticsearch

配置es的集群名称,默认是elasticsearch,es会自动发现在同一网段下的es,如果在同一网段下有多个集群,就可以用这个属性来区分不同的集群。

node.name: "Franz Kafka"

节点名,默认随机指定一个name列表中名字,该列表在es的jar包中config文件夹里name.txt文件中,其中有很多作者添加的有趣名字。

node.master: true

指定该节点是否有资格被选举成为node,默认是true,es是默认集群中的第一台机器为master,如果这台机挂了就会重新选举master。

node.data: true

指定该节点是否存储索引数据,默认为true。

index.number_of_shards: 5

设置默认索引分片个数,默认为5片。

index.number_of_replicas: 1

设置默认索引副本个数,默认为1个副本。

path.conf: /path/to/conf

设置配置文件的存储路径,默认是es根目录下的config文件夹。

path.data: /path/to/data

设置索引数据的存储路径,默认是es根目录下的data文件夹,可以设置多个存储路径,用逗号隔开,例:

path.data: /path/to/data1,/path/to/data2

path.work: /path/to/work

设置临时文件的存储路径,默认是es根目录下的work文件夹。

path.logs: /path/to/logs

设置日志文件的存储路径,默认是es根目录下的logs文件夹

path.plugins: /path/to/plugins

设置插件的存放路径,默认是es根目录下的plugins文件夹

bootstrap.mlockall: true

设置为true来锁住内存。因为当jvm开始swapping时es的效率 会降低,所以要保证它不swap,可以把ES_MIN_MEM和ES_MAX_MEM两个环境变量设置成同一个值,并且保证机器有足够的内存分配给es。 同时也要允许elasticsearch的进程可以锁住内存,linux下可以通过`ulimit -l unlimited`命令。

network.bind_host: 192.168.0.1

设置绑定的ip地址,可以是ipv4或ipv6的,默认为0.0.0.0。

network.publish_host: 192.168.0.1

设置其它节点和该节点交互的ip地址,如果不设置它会自动判断,值必须是个真实的ip地址。

network.host: 192.168.0.1

这个参数是用来同时设置bind_host和publish_host上面两个参数。

transport.tcp.port: 9300

设置节点间交互的tcp端口,默认是9300。

transport.tcp.compress: true

设置是否压缩tcp传输时的数据,默认为false,不压缩。

http.port: 9200

设置对外服务的http端口,默认为9200。

http.max_content_length: 100mb

设置内容的最大容量,默认100mb

http.enabled: false

是否使用http协议对外提供服务,默认为true,开启。

gateway.type: local

gateway的类型,默认为local即为本地文件系统,可以设置为本地文件系统,分布式文件系统,hadoop的HDFS,和amazon的s3服务器,其它文件系统的设置方法下次再详细说。

gateway.recover_after_nodes: 1

设置集群中N个节点启动时进行数据恢复,默认为1。

gateway.recover_after_time: 5m

设置初始化数据恢复进程的超时时间,默认是5分钟。

gateway.expected_nodes: 2

设置这个集群中节点的数量,默认为2,一旦这N个节点启动,就会立即进行数据恢复。

cluster.routing.allocation.node_initial_primaries_recoveries: 4

初始化数据恢复时,并发恢复线程的个数,默认为4。

cluster.routing.allocation.node_concurrent_recoveries: 2

添加删除节点或负载均衡时并发恢复线程的个数,默认为4。

indices.recovery.max_size_per_sec: 0

设置数据恢复时限制的带宽,如入100mb,默认为0,即无限制。

indices.recovery.concurrent_streams: 5

设置这个参数来限制从其它分片恢复数据时最大同时打开并发流的个数,默认为5。

discovery.zen.minimum_master_nodes: 1

设置这个参数来保证集群中的节点可以知道其它N个有master资格的节点。默认为1,对于大的集群来说,可以设置大一点的值(2-4)

discovery.zen.ping.timeout: 3s

设置集群中自动发现其它节点时ping连接超时时间,默认为3秒,对于比较差的网络环境可以高点的值来防止自动发现时出错。

discovery.zen.ping.multicast.enabled: false

设置是否打开多播发现节点,默认是true。

discovery.zen.ping.unicast.hosts: ["host1", "host2:port", "host3[portX-portY]"]

设置集群中master节点的初始列表,可以通过这些节点来自动发现新加入集群的节点。

下面是一些查询时的慢日志参数设置

index.search.slowlog.level: TRACE

index.search.slowlog.threshold.query.warn: 10s

index.search.slowlog.threshold.query.info: 5s

index.search.slowlog.threshold.query.debug: 2s

index.search.slowlog.threshold.query.trace: 500ms

index.search.slowlog.threshold.fetch.warn: 1s

index.search.slowlog.threshold.fetch.info: 800ms

index.search.slowlog.threshold.fetch.debug:500ms

index.search.slowlog.threshold.fetch.trace: 200ms

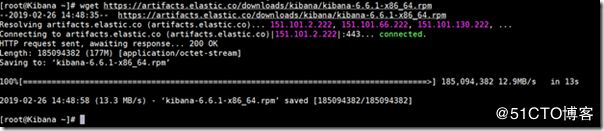

Installation Kibana

goto https://www.elastic.co/downloads/kibana

found the rpm link

wget https://artifacts.elastic.co/downloads/kibana/kibana-6.6.1-x86_64.rpm

rpm -ivh kibana-6.6.1-x86_64.rpm

make sure port 5601 is up and running

netstat -ntlp | grep 5601

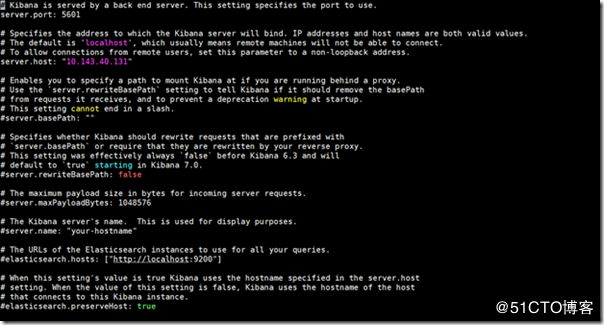

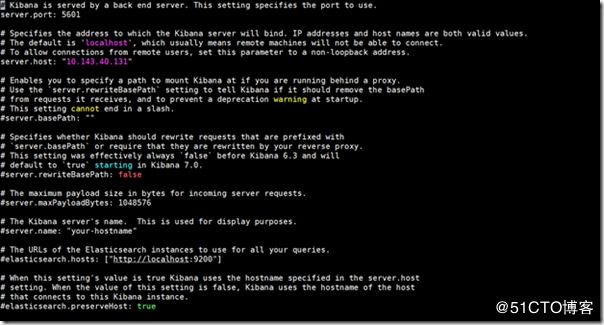

Configuration Kibana

vi /etc/kibana/kibana.yml

update hostname and port

cat /etc/kibana/kibana.yml | grep -v ^#

define kibana hostname / port & elastics host url

server.port: 5601

server.host: "10.143.40.131"

elasticsearch.hosts: ["http://10.143.40.130:9200"]

telnet 10.143.40.131 5601 to make sure port and services is up

goto http://10.143.40.131:5601 you can see the kibana web console

Configuration Kibana option

https://www.elastic.co/guide/en/kibana/current/settings.html

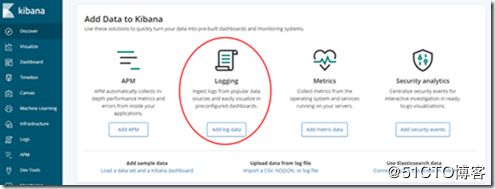

Add Data to Kibana

let’s try to add nginx logging data

follow the instructor from Kibana

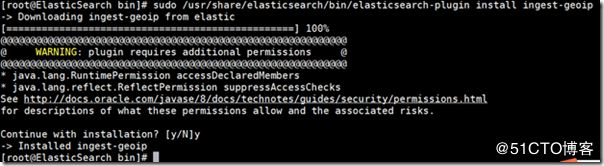

goto elastics server and install plug

sudo /usr/share/elasticsearch/bin/elasticsearch-plugin install ingest-geoip

sudo /usr/share/elasticsearch/bin/elasticsearch-plugin install ingest-user-agent

download and install filebeat

curl -L -O https://artifacts.elastic.co/downloads/beats/filebeat/filebeat-6.6.1-x86_64.rpm

sudo rpm -ivh filebeat-6.6.1-x86_64.rpm

edit filebeat yml file and define in & out configuration

vi /etc/filebeat/filebeat.yml

enable apache2 module

sudo filebeat modules enable apache2

start filebeat

sudo filebeat setup

sudo service filebeat start

make sure log has been output

tail -f /var/log/filebeat/filebeat

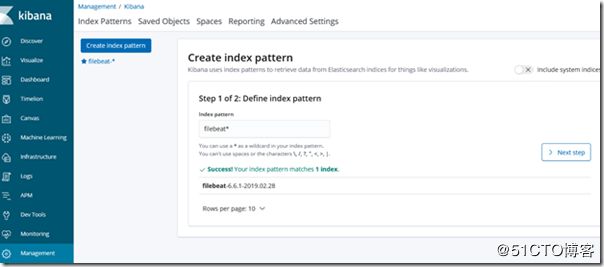

check kibana got log from filebeat

http://10.143.40.140:9200/filebeat-*/_count

check log in kibana UI

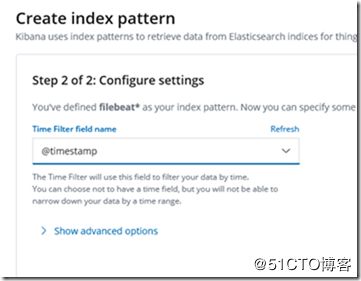

create index patern

discover you data

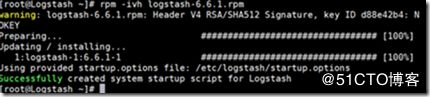

Installation Logstash

goto https://www.elastic.co/downloads/logstash

wget https://artifacts.elastic.co/downloads/logstash/logstash-6.6.1.rpm

rpm -ivh logstash-6.6.1.rpm

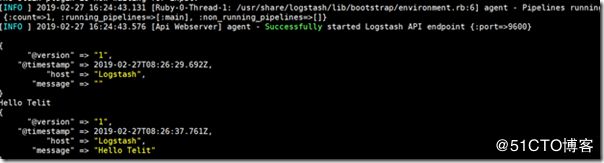

test your Logstash installation

cd /usr/share/logstash/

bin/logstash -e 'input { stdin { } } output { stdout {} }'

type something and press enter , logstash shows you services is up and running .

Configuration Logstash

cat /etc/logstash/logstash-sample.conf

input {

# 从文件读取日志信息

file {

path => "/var/log/httpd/access_log"

type => "error"//type是给结果增加一个type属性,值为"error"的条目

start_position => "beginning"//从开始位置开始读取

# 使用 multiline 插件,传说中的多行合并

codec => multiline {

# 通过正则表达式匹配,具体配置根据自身实际情况而定

pattern => "^\d"

negate => true

what => "previous"

}

}

}

#可配置多种处理规则,他是有顺序,所以通用的配置写下面

# filter {

# grok {

# match => { "message" => "%{IP:client} %{WORD:method} %{URIPATHPARAM:request} %{NUMBER:bytes} %{NUMBER:duration}" }

}

# }

output {

# 输出到 elasticsearch

elasticsearch {

hosts => ["10.143.40.130:9200"]

index => "error-%{+YYYY.MM.dd}"//索引名称

}

}

Running logstash with specify conf file

/usr/share/logstash/bin/logstash -f /etc/logstash/logstash.conf

![]()

Configuration Logstash option

https://www.elastic.co/guide/en/logstash/current/configuration.html

Reference Link

elasticsearch

https://www.elastic.co/guide/en/elasticsearch/reference/7.x/rpm.html

kibana

https://www.elastic.co/guide/en/kibana/current/rpm.html

Logstash

https://www.elastic.co/guide/en/logstash/current/index.html