刷题笔记2

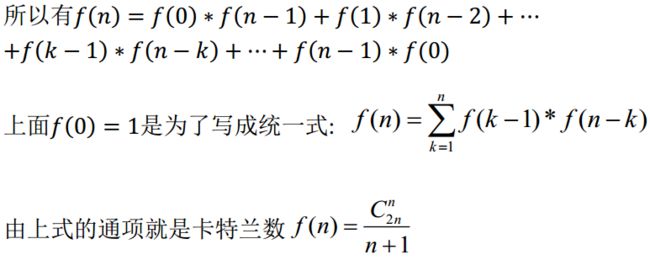

1、若一序列进栈顺序为a1,a2,a3,a4,问存在多少种可能的出栈序列( )

A 12 B 13 C 14 D 15

答案:C

2、下列属于有监督学习算法的是:()

A 谱聚类 B 主成分分析PCA C 主题模型LDA D 线性判别分析LDA

答案:D

3、以下是产生式模型的机器学习算法为:

A LR B SVM C 神经网络 D HMM

答案:D

4、一个序列为(13,18,24,35,47,50,63,83,90,115,124),如果利二分分法查找关键字为90的,则需要几次比较 ?

A 1 B 2 C 3 D 4

答案:B

5、已知一个二叉树前序遍历和中序遍历分别为ABDEGCFH和DBGEACHF,则该二叉树的后序遍历为?

A、DGEBHFCA B.DGEBHFAC C. GEDBHFCA D. ABCDEFGH

答案:A

其实根据前序遍历和中序遍历就能确定根节点是A,D是最下层最左边的节点。

6、以下关于共轭梯度说法正确的是

A共轭梯度需要计算hessien矩阵的逆 B共轭梯度只需要一阶梯度即可,所以收敛速度较慢

C共轭梯度法所需的存储量小,收敛快,稳定性高的优点 D共轭梯度梯度方向与最速下降法的梯度相同

答案:C

7、以下关于准确率,召回, f1-score说法错误的是:

A准确率为TP/(TP+FP) B召回率为TP/(TP + FN)

C f1-score为 2TP/(2TP + FP + FN) D f1-score为 准确率*召回率/(准确率+召回率)

答案:D

8、在贝叶斯线性回归中, 假定使然概率和先验概率都为高斯分布, 假设先验概率的高斯准确率参数为a, 似然概率的高斯准确率参数为b, 则后验概率相当于平方误差+L2正则,则其正则化参数为

A a + b B a / b C a^2 + b^2 D a^2 / (b^2)

答案:A

没找到相关资料,谁知道跟我解释下吧

9、在以下操作中,把14,27,71,50,93,39按顺序插入树,形成平衡二叉树高度为?

A 3 B 4 C 5 D 6

答案:A

10、两个随机变量x,y,服从联合概率分布p(x,y), 以下等式成立的有

A![]() B

B![]() C

C![]() D

D![]()

答案:AC

11、以下关于batch normalization说法正确的是

A normalization的均值方差计算是基于全部训练数据的

B normalization的均值方差只基于当前的minibatch

C normalization对输入层的每一维单独计算均值方差

D normalization的输出分布服从均值为0,方差为1的高斯分布

答案:BC

12、以下关于二项分布说法正确的是

A 二项分布是一种离散概率分布,表示在n次伯努利试验中, 试验k次才得到第一次成功的概率

B 二项分布是一种离散概率分布,表示在n次伯努利试验中,有k次成功的概率

C 当n很大时候,二项分布可以用泊松分布和高斯分布逼近

D 当n很大时候,二项分布可以高斯斯分布逼近,但不能用泊松分布逼近

答案:BC

13、以下关于random forest说法错误的是

A rf中的每棵子树都是独立同分布的

B rf中模型方差随着子树的增加而减少

C rf主要通过增加子树之间的相关性来减少模型的方差

D rf中模型偏差随着子树的增加而减少

答案: AD

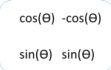

14、在机器学习中,经常采用线性变换,将基变换为正交基, 下列矩阵式正交矩阵的是

答案:AC

The orthogonal matrix,正交矩阵,如果一个矩阵满足以下几个条件,则此矩阵就是正交矩阵:

(1)是一个方阵

(2)和自己的转置矩阵的矩阵乘积 = 单位矩阵E

如果A为一个正交矩阵,则A满足以下条件:

1) A的转置矩阵也是正交矩阵

2) ![]() (E为单位矩阵)

(E为单位矩阵)

3) A的各行是单位向量且两两正交

4) A的各列是单位向量且两两正交

5) (Ax,Ay)=(x,y) x,y∈R

6) |A| = 1或-1

7) ![]() ,A的转置矩阵等于A的逆矩阵

,A的转置矩阵等于A的逆矩阵

15、关于x,y的函数f(x,y)=x*e^(-x^2-y^2),(x,y∈R),则该函数有_____个极小值点

A 0 B 1 C 2 D 3

答案:B

16、随机变量X1,X2...X100都服从[1,9]的均匀分布,则(X1+X2+...+X100)/100近似服从

A 高斯分布 B 泊松分布 C 均匀分布 D 指数分布

答案:高斯分布

对于服从均匀分布的随机变量,只要n充分大,随机变量 就服从均值为零,方差为1的正态分布。

17、某二叉树有2000个结点,则该二叉树的最小高度为()

A 10 B 11 C 12 D 13

答案:B

节点与深度的关系:2^k -1 =n

18、下列方面不可以防止过拟合的是()

A 加入正则项 B 增加样本 C 建立更加复杂的模型 D Bootstrap重采样

答案:C

19、使用中根遍历一棵二叉树得到E A C K F H D B G,则先根遍历将得到()

A FAEKCDBHG B FAEKCDHGB C EAFKHDCBG D FEAKDCHBG

答案:B

20、以下哪些模型是无向图

A 朴素贝叶斯 B LR C CRF D HMM

答案:BC

21、协同过滤经常被用于推荐系统, 包含基于内存的协同过滤, 基于模型的协同过滤以及混合模型, 以下说法正确的是

A基于模型的协同过滤能比较好的处理数据稀疏的问题

B基于模型的协同过滤不需要item的内容信息

C基于内存的协同过滤可以较好解决冷启动问题

D基于内存的协同过滤实现比较简单, 新数据可以较方便的加入

答案:AD

22、以下关于神经网络说法正确的是

A神经网络可以实现非线性分类

B神经网络可以实现线性分类

C神经网络的每层神经元激活函数必须相同

D神经网络的每层神经元激活函数值阈必须在[-1,1]

答案:AB

23、以下为防止过拟合的方法的是

A增加样本 B L1正则 C交叉验证 D增加复杂特征

答案:ABC

24、CRF模型可以用来做专名识别, 语义消歧等, 以下关于CRF模型说法正确的是

A CRF模型是产生式模型 B CRF模型是判别式模型 C CRF模型的图模型为无向图 D CRF模型的图模型为有向图

答案:BC

25、以下属于凸函数的是()

A e^x B e^a C log(x) D f(x, y) = x²/y

答案:AD

26、以下说法正确的是

A XOR问题不能简单的用线性分类解决

B XOR问题可以通过2层感知器解决

C XOR可以通过LR模型解决

D XOR可以通过单层感知器解决

答案:AB

27、以下是基于图的特征降维方法的是

A LE(Laplacian eigenmap) B LLE(local linear embedding)

C PCA D KL

答案:AB

Principal Component Analysis(PCA)是最常用的线性降维方法,它的目标是通过某种线性投影,将高维的数据映射到低维的空间中表示,并期望在所投影的维度上数据的方差最大,以此使用较少的数据维度,同时保留住较多的原数据点的特性。

Linear Discriminant Analysis (也有叫做Fisher Linear Discriminant)是一种有监督的(supervised)线性降维算法。与PCA保持数据信息不同,LDA是为了使得降维后的数据点尽可能地容易被区分!

Locally linear embedding(LLE)[1]是一种非线性降维算法,它能够使降维后的数据较好地保持原有流形结构。LLE可以说是流形学习方法最经典的工作之一。很多后续的流形学习、降维方法都与LLE有密切联系。

Laplacian Eigenmaps(拉普拉斯特征映射)看问题的角度和LLE有些相似,也是用局部的角度去构建数据之间的关系。它的直观思想是希望相互间有关系的点(在图中相连的点)在降维后的空间中尽可能的靠近。Laplacian Eigenmaps可以反映出数据内在的流形结构。

其中最后后两种是基于图的特征降维方法。

28、使用LR来拟合数据, 一般随机将数据分为训练集和测试集。 则随着训练集合的数据越来越多, 以下说法正确的是

A测试集上的测试误差会越来越大

B测试集上的测试误差会越来越小

C训练集上的训练误差会越来越小

D训练集上的训练误差会越来越大

答案:BD

前提:测试数据不变,只增加训练数据

1.减少过拟合,泛化更好,测试误差变小

2.训练集多样性增加,数据输入分布改变,训练误差变大

29、有A,B 两个国家,人口比例为4:6,A国的犯罪率为0.1%,B国的为0.2%。现在有一个新的犯罪事件,发生在A国的概率是?

A0.15 B0.25 C 0.35 D 0.45

答案:0.25