详细教你搭建伪分布式hadoop集群

详细教你搭建伪分布式hadoop

一、简单介绍一下hadoop

1. Apache™Hadoop®项目为可靠的(hadoop能自动地维护数据的多份复制,并且在任务失败后能自动地重新部署(redeploy)计算任务。),可扩展的,分布式计算开发开源软件。hadoop不具有,高可用性:该库本身不是依靠硬件来提供高可用性,而是设计用于在应用层检测和处理故障,从而在一组计算机之上提供高可用性服务,每个计算机都可能出现故障。高可用:(借助第三方)用来弥补集群。(官方网站:apache.org)

2.该项目包括这些模块:Hadoop Common

Hadoop分布式文件系统(HDFS™):一种分布式文件系统,可提供对应用程序数据的高吞吐量访问。

Hadoop YARN:作业调度和集群资源管理的框架

Hadoop MapReduce:一种用于并行处理大型数据集的基于YARN的系统

3.一般使用情况:hadoop2.7.3搭建、8G/固态硬盘、centos6.5/6.8

4.单节点作用:用于调试

伪分:core\hdfs有hadoop进程

默认端口:8020

1.几的版本默认端口9000

二、开始搭环境(我们所有的操作都是在普通用户下,有一个地方用root到时候我会提醒你)

先关闭防火墙iptables -F

2:关闭防火墙和SElinux

查看防火墙的状态:

chkconfig iptables --list

chkconfig ip6tables --list

关闭防火墙(临时)

chkconfig iptables stop

chkconfig ip6tables stop

永久关闭

chkconfig iptables off

chkconfig ip6tables off

1、我用的Centos6.5的桌面版,所以直接进入普通用户就可以不用创建普通用户了,没有的创建一个。

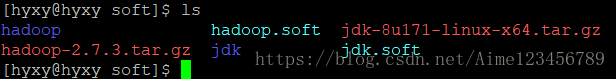

2.在/home/hyxy/文件下用mkdir soft创建一个soft文件夹

3.将hadoop的压缩包和jdk的压缩包进行解压,

tar -zxvf jdk-8u171-linux-x64.tar.gz ,用mv jdk-8u171-linux-x64.tar.gz jdk

tar -zxvf hadoop-2.7.3.tar.gz ,用mv hadoop-2.7.3.tar.gz hadoop

4.建软连接 ln -s hadoop hadoop.soft

ln -s jdk jdk.soft

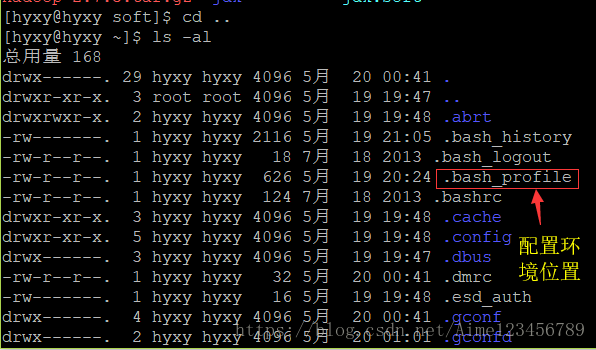

5.先配置jdk,注意我们配置jdk和hadoop的JAVA_HOME等的配置环境,要在. bash_profile中因为普通用户在/etc/profile中没有权限

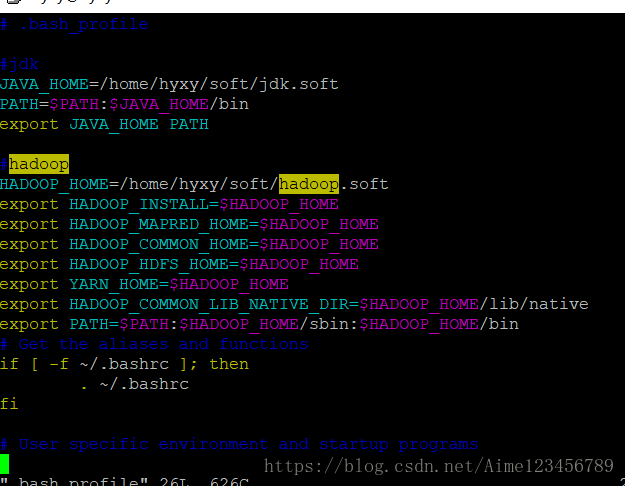

6.vim .bash_profile

#jdk环境

JAVA_HOME=/home/hyxy/soft/jdk.soft

PATH=$PATH:$JAVA_HOME/bin

export JAVA_HOME PATH

#hadoop环境

HADOOP_HOME=/home/hyxy/soft/hadoop.soft

export HADOOP_INSTALL=$HADOOP_HOME

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

7.source .bash_profile更新配置文件

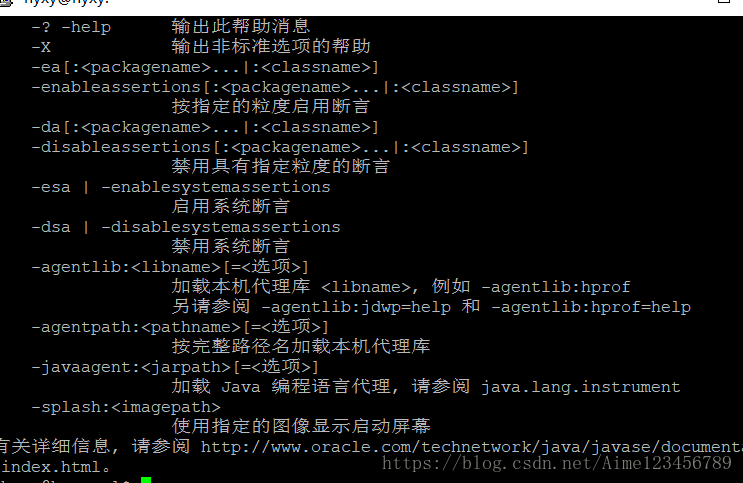

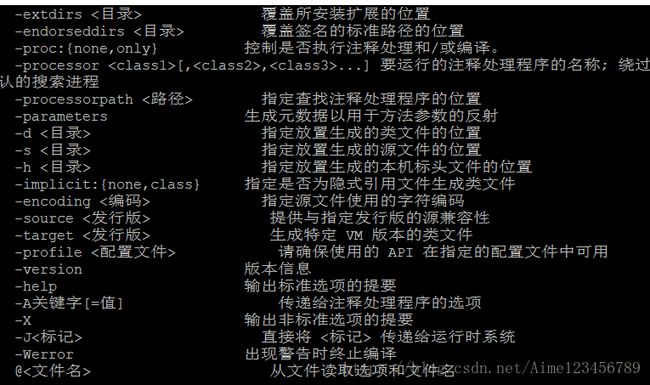

8.java

9.javac

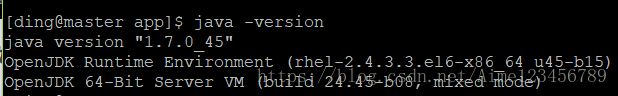

10.当java -version 查看脚本时一般将获得如下信息:但是我装的时1.8.0的版本,所以将系统自带的删去

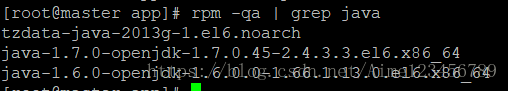

11.进一步查看JDK信息rpm -qa |grep java 结果如下:

rpm -e --nodeps tzdata-java-2013g-1.el6.noarch

rpm -e --nodeps java-1.7.0-openjdk-1.7.0.45-2.4.3.3.el6.x86_64

rpm -e --nodeps java-1.6.0-openjdk-1.6.0.0-1.66.1.13.0.el6.x86_64

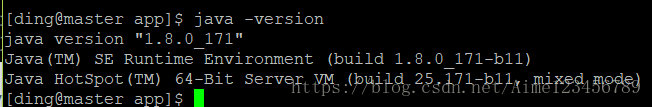

卸载后java -version 效果如下:这样jdk就安装完成了

12.开始配置hadoop

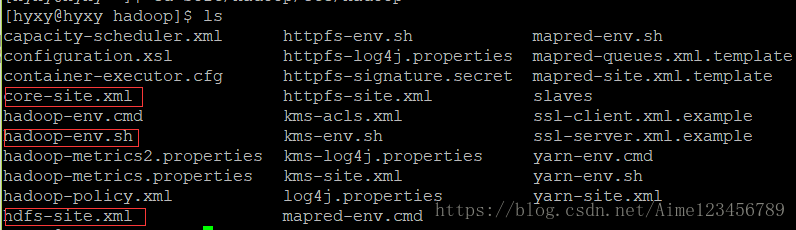

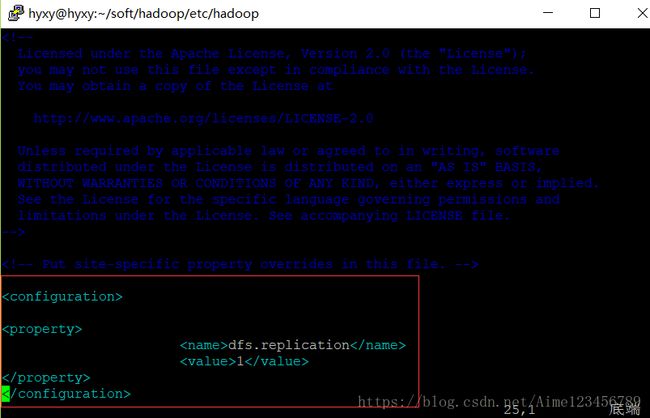

[hyxy@hyxy ~]$ cd soft/hadoop/etc/hadoop/进入这个目录,我们需要配置如下三个配置文件。

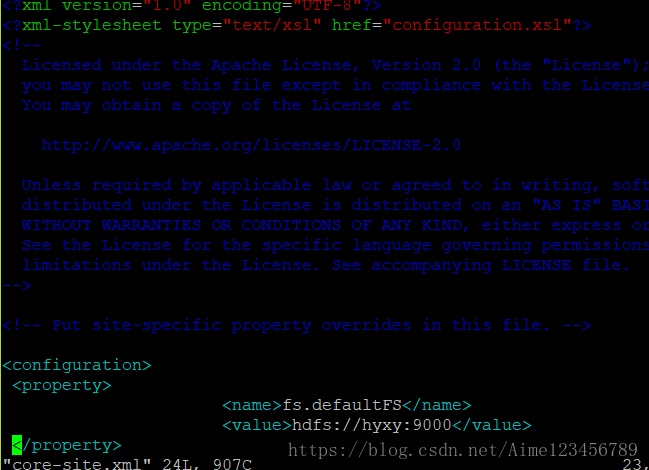

① vim core-site.xml

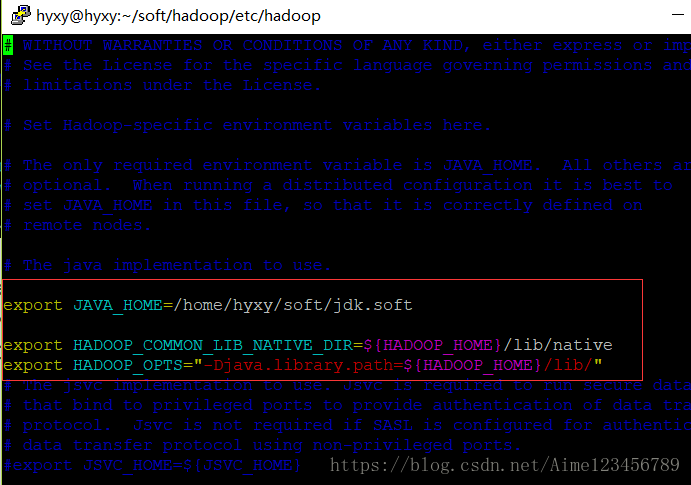

② vim hadoop-env.sh

export JAVA_HOME=/home/hyxy/soft/jdk.soft

export HADOOP_COMMON_LIB_NATIVE_DIR=${HADOOP_HOME}/lib/native

export HADOOP_OPTS="-Djava.library.path=${HADOOP_HOME}/lib/"

③vim hdfs-site.xml

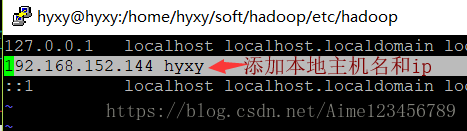

13.先切换root用户vim /etc/hosts 添加本地主机名和ip

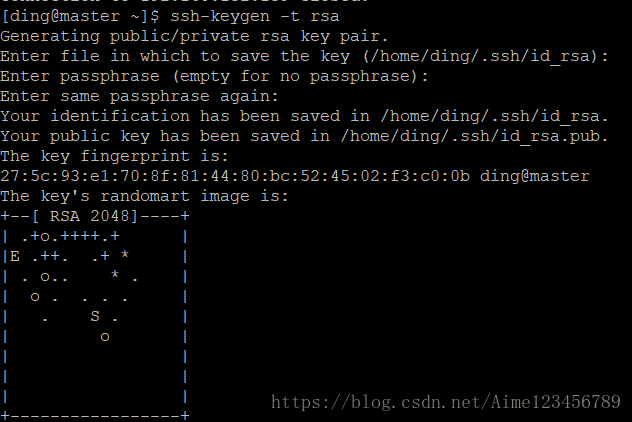

14.ssh免密登陆

a.获取密钥ssh-keygen -t rsa,一路回车下去,下图为产生密钥完成

可以去/home/hyxy目录下ls -a查看到.ssh文件的生成,cd .ssh就会看到密钥

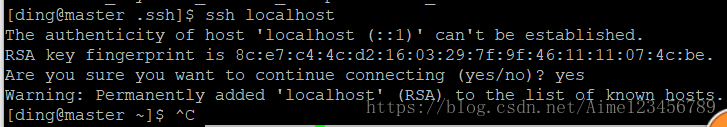

b.cp id_rsa.pub authorized_keys,将公钥复制到authorized_keys文件中此时 ssh localhost就不需要密码了

c.设置权限 chmod 700 .ssh,chmod 600 authorized_keys

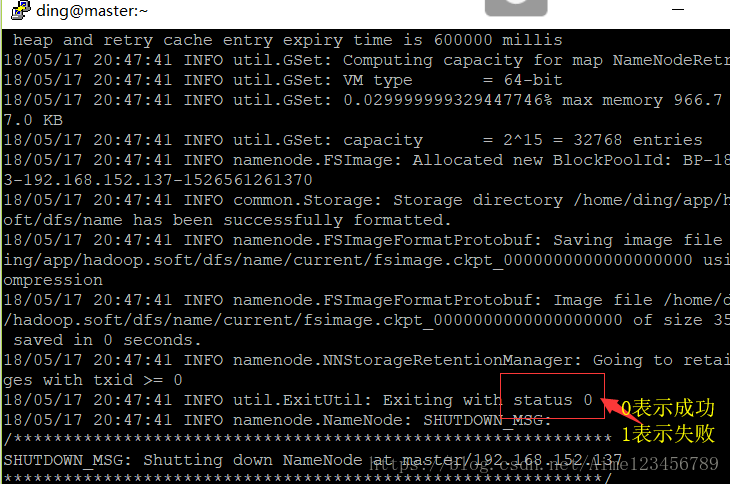

15.格式化

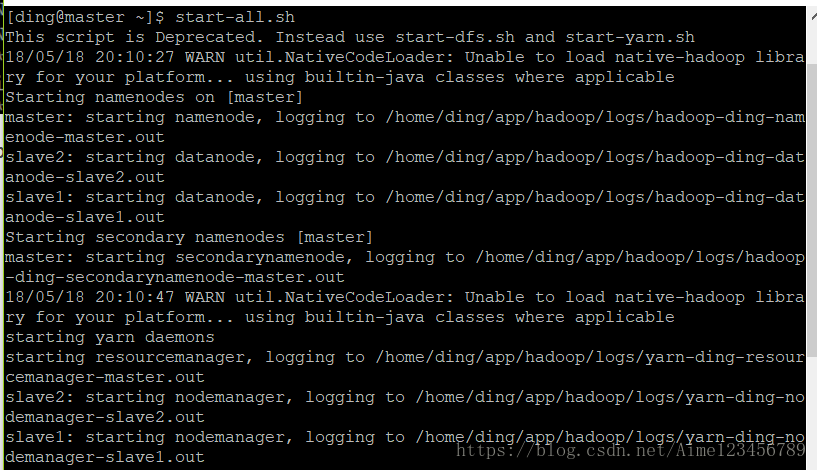

hdfs namenode -format16.start-all.sh开启hadoop所有服务,如下图就成功了

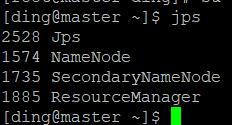

查看jps

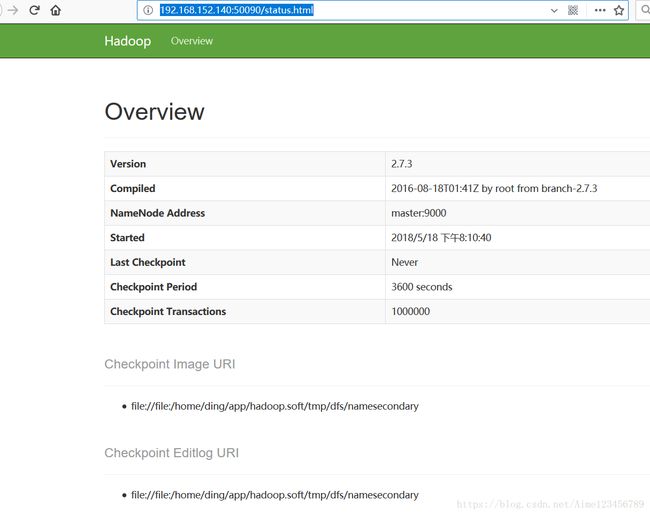

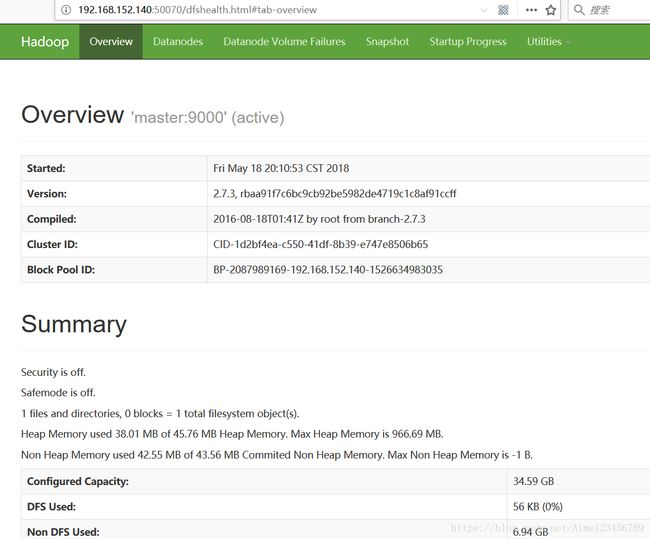

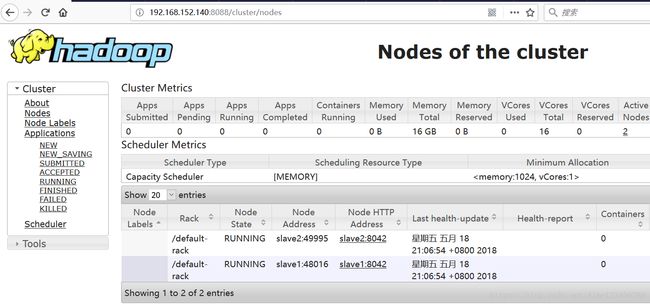

master主机ip地址:8088