centos 服务器 创建Hadoop账户、配置SSH无密码登录,安装Hadoop

安装 CentOS 后尚未创建 “hadoop” 用户,那么需要增加一个名为 hadoop 的用户

- su root #以root账号登录并创建接下来的hadoop新用户

- useradd -m hadoop -s /bin/bash # 创建新用户Hadoop

- passwd hadoop 给hadoop新用户设置登录密码(123456)

- visudo 增加管理员权限(root权限角色)

- 找到root ALL=(ALL)ALL这一行,一般在98行附近,然后在这一行下面 增加下面指令: hadoop ALL=(ALL)ALL (当中的间隔为tab)

6. 添加完之后,保存退出

7. su hadoop,切换到hadoop用户上来

配置SSH无密码登录

sudo yum install openssh-askpass (安装openssh-askpass时不要加-y,否则出错)

sudo yum –y install openssh-clients

sudo yum –y install openssh-server

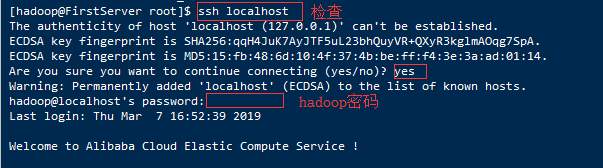

3. 安装完之后,执行如下命令测试一下 SSH 是否可用:

ssh localhost

此时会有如下提示(SSH首次登陆提示),输入 yes 。然后按提示输入 hadoop用户的登录密码,这样就实现登录到本机了

上述的登陆是需要每次输入密码的,但我们的需求是配置成SSH无密 码登陆后会比较方便

4. 接下来,第二步输入:exit #回到原先的终端命令窗口

5. 然后先后执行以下指令:

exit # 退出刚才的

ssh localhost • cd ~/.ssh/ # 若没有该目录,请先执行一次

ssh localhost • ssh-keygen -t rsa # 会有提示,都按回车就可以

cat id_rsa.pub >> authorized_keys # 加入授权

chmod 600 ./authorized_keys # 修改文件权限

安装Hadoop:

- 我们选择将 Hadoop 安装至 /usr/local/ 中:

sudo tar -zxf ~/下载/hadoop-2.6.5-src.tar.gz -C /usr/local # 解压

- cd /usr/local/

- sudo mv ./hadoop-2.6.5/ ./hadoop # 将文件夹名改为hadoop

- sudo chown -R hadoop:hadoop ./hadoop # 修改文件权限

hadoop 解压后即可使用。输入如下命令来检查 Hadoop 是否可用,成 功则会显示 Hadoop 版本信息:

4. cd /usr/local/hadoop

5. ./bin/hadoop version

6. 若已经成功安装hadoop这个软件/项目,接下来进行单机版配置(非 分布式)。 Hadoop 默认模式为非分布式模式,不需要进行其他任何配置即可运行。 非分布式即单 Java 进程,方便进行调试。 运行以下指令:

./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduceexamples-2.6.0.jar

可以看到所有例子,包括 wordcount、terasort、join、grep 等。

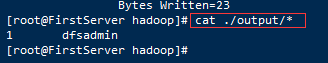

7.为此我们选择运行一个 grep 例子(查找),将 input 文件夹中的所有文件 作为输入,筛选当中符合正则表达式 dfs[a-z.]+ 的单词并统计出现的次数, 最后输出结果到 output 文件夹中。运行如下指令:

- cd /usr/local/hadoop

- mkdir ./input

- cp ./etc/hadoop/*.xml ./input # 将配置文件作为输入文件

- ./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-*.jar grep ./input ./output 'dfs[a-z.]+'

- cat ./output/* # 查看运行结果

8. 若出现提示 “INFO metrics.MetricsUtil: Unable to obtain hostName java.net.UnknowHostException”,这需要执行如下命令修改 hosts 文件,为你的主机名增加IP映射:

sudo vim /etc/hosts

9. 保存文件后,重新运行 hadoop 实例

10. 注意,Hadoop 默认不会覆盖结果文件,因此再次运行上面实例会提示出错,需要先 将./output删除:

rm -r ./output

测试hadoop:

验证指令:jps

验证Hadoop是否安装成功主要通过以下两个网址。

http://localhost:50030(MapReduce的页面)

http://localhost:50070(HDFS的页面)

如果都能查看,说明安装成功。