HBase的集群搭建

HBase集群搭建

Java版本:jdk1.7.0_51,已经安装了。

Hadoop版本:hadoop-1.1.2,已经安装部署了。

zookeeper版本:zookeeper-3.4.5,已经安装部署了。

hbase版本:hbase-0.94.7-security

主节点(HMaster):Master.Hadoop

从节点(Region Server):Slave1.Hadoop、Slave2.Hadoop、Slave3.Hadoop

所有主机的操作用户为:hadoop,而不是root,所以要特别注意权限问题。

1.准备文件

![]()

2.切换到root用户,才能解压。

3.解压

4.给予hadoop对hbase的所有权,后来发现这步可以放在后面,因为是边做边写的博客,所以有点乱,还望见谅。

![]()

5.修改hbase-0.94.7-security文件夹名为hbase,方便管理

![]()

6.修改/usr/hbase/conf/hbase-env.sh

![]()

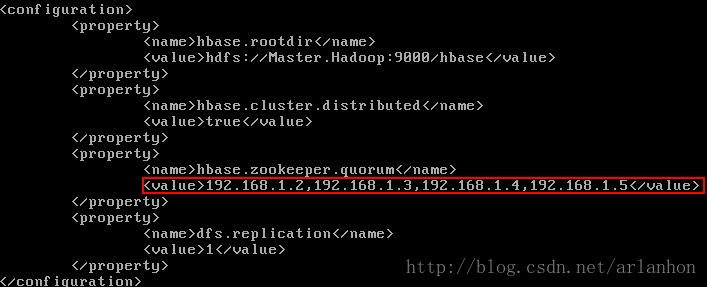

7.修改hbase-site.xml文件

![]()

8.修改regionservers

9.进入/usr/hbase/lib目录下发现hadoop-core-1.0.4.jar的版本与hadoop的(hadoop-core-1.1.2)不一样,所以要删除,然后把hadoop的复制过来。

![]()

![]()

注意修改权限,因为是root用户拷贝的:

![]()

![]()

10.分别复制Master.Hadoop中的hbase文件夹到Slave1.Hadoop,Slave2.Hadoop,Slave3.Hadoop中的/usr/目录下。

![]()

![]()

11.修改Master.Hadoop主节点中的/etc/profile文件

![]()

12.分别复制Master.Hadoop中的/etc/profile到Slave1.Hadoop,Slave2.Hadoop,Slave3.Hadoop中,再分别执行source /etc/profile。

13.分别修改Slave1.Hadoop、Slave2.Hadoop、Slave3.Hadoop上hadoop用户对/usr/目录下的hbase文件夹的所有权。

[root@Slave1 usr]# chown -R hadoop:hadoop hbase

[root@Slave2 usr]# chown -R hadoop:hadoop hbase

[root@Slave3 usr]# chown -R hadoop:hadoop hbase

14.首先启动hadoop,然后启动zookeeper集群。

hadoop的操作这里就不讲了。

zookeeper的操作:

zkServer.sh start:开启zookeeper服务。

zkServer.sh stop:停止zookeeper服务。

zkServer.sh status:查看zookeeper服务状态。

zkCli.sh:进入zookeeper的shell操作,有它自己类似与文件系统的,可以CRUD,我们称之为“节点”,这里不作详细解释。

注意不能有异常信息,如果有异常,要解决,一般就是防火墙没关,或是各个节点的系统时间不致的问题。具体配置请查看:

http://blog.csdn.net/arlanhon/article/details/19262221

15.最后在Master.Hadoop上启动hbase集群。

start-hbase.sh

发现报了以下异常:

知道是免密码登录的问题,分别每个节点上修改/etc/ssh/ssh_config文件,如下:

后发现又报了以下异常:

还是ssh登录的问题,意思是Slave1、Slave2、Slave3没有免密码登录,想起之前安装hadoop时,是用的节点的ip进行免密码登录的,所以还要修改/usr/hbase/conf/hbase-site.xml配置文件,(或者你也可以再加上各个主机的之间通过主机名来实现免密码登录也行,可按自己的实际情况进行选择,切不可直接"搬运")如下:

重启所有节点,然后在Master.Hadoop中使用start-all.sh命令先开启hadoop

开启hadoop后,再退出安全模式,如下:

如果你的主节点没有出现Safe mode is OFF那么还进行以下操作,出现了就不必了。

rm -rf /usr/hadoop/tmp/*

rm -rf /tmp/hadoop*

reboot

然后启动zookeeper服务,操作如上介绍。注意最好是用cd命令切换到自己的主目录,然后zkServer.sh start。以便于查看zkServer.out文件。

最后在Master.Hadoop节点上启动hbase服务,

以下是Master.Hadoop节点上的信息,注意还要输入hbase shell,然后输出list,如果没有提示list命令找不到的信息,就算部署成功

以下是Slave的一些信息,不同的从节点这间,可能会有差异。

经过后面的测试发现,HMaster会自动关闭,最后来了一个大改动,还是因为之前安装hadoop时,是用的节点的ip进行免密码登录的,,所以把所有的主机名换成ip,即可。

还有一些小细节,这里便不再阐述,最后祝大家都部署成功。