windows10+pycharm+Spark

安装环境:Win10

安装软件:hadoop2.6.5,spark2.3.3,python3.7.2,JDK1.8、pycharm

注:win10环境下安装spark2.4,运行pyspark报ImportError: No module named resource,spark2.3无此报错

1、下载并安装好jdk1.8、python和pycharm(此处安装过程省略)

2、Spark环境变量配置

①下载Spark http://spark.apache.org/downloads.html

②下载Hadoop https://hadoop.apache.org/releases.html (binary包)

③本次选择版本分别为spark-2.3.3-bin-hadoop2.6.tgz、hadoop-2.6.5.tar.gz

④将下载后的压缩包解压至安装目录,注意解压缩的时候要用管理员权限进行,解压缩目录中不要有中文。

⑤下载winutils组件 https://github.com/srccodes/hadoop-common-2.2.0-bin, 将winutils目录中的hadoop.dll和winutils.ext这两个文件放到Hadoop的安装目录,也就是解压目录下面的bin里面

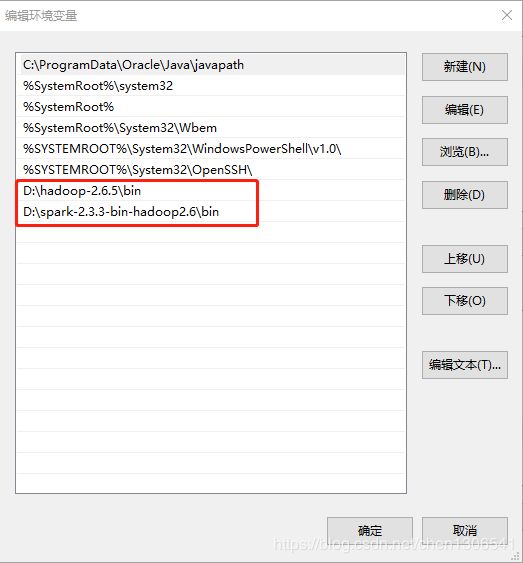

⑥在系统环境变量里添加HADOOP_HOME,SPARK_HOME环境变量,分别指向其安装目录,在系统Path变量中添加hadoop和spark的bin目录

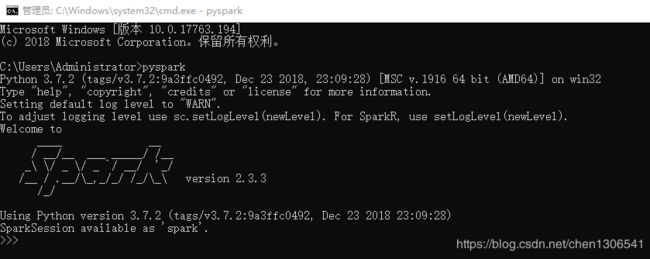

⑦在命令行中执行pyspark命令,验证spark安装是否成功

3、配置pycharm

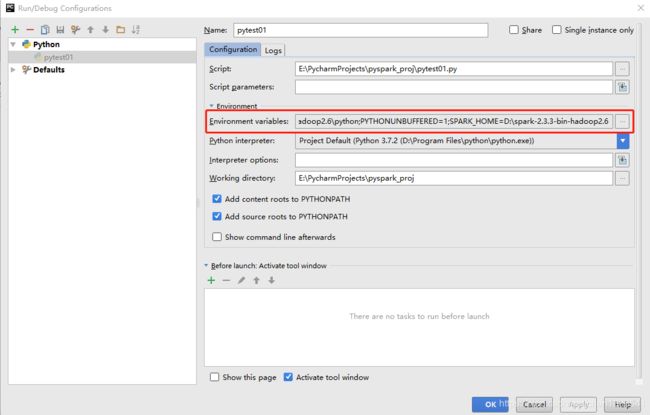

打开PyCharm,创建一个pyspark_proj工程。然后选择“Run” ->“Edit Configurations”

选择 “Environment variables” 增加SPARK_HOME目录与PYTHONPATH目录。

SPARK_HOME:Spark安装目录

PYTHONPATH:Spark安装目录下的Python目录

点击菜单栏"File"–>“Settings”–>“Project:pyspark_proj”–>“Project Structure”–>“Add Content Root”

添加PYTHONPATH目录中lib目录下的pyspark和py4j

新建python文件,编写代码,运行程序