Ubuntu搭建Hadoop2.6.5(伪分布式)

最好不要以root用户进行配置,配置时注意文件的所有用户!!

1.安装jdk

此步略过,可参考我发布的另一篇文章

2.下载hadoop2.6

hadoop2.6下载地址

3.配置环境变量

输入 vim /etc/profile 命令可打开profile文件(若使用的界面版本可在目录中直接打开此文件)

在文件末尾加入以下信息(命令中不要自行加入空格,否则没法使用)

export JAVA_HOME=/usr/lib/jvm/java1.8.0_112 【你的java目录】

export HADOOP_HOME=/home/hadoop【hadoop文件目录】

export PATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

其中 一定要把各个Home路径设置写在 PATH 路径的前面(因为PATH路径会用到这些路径)

执行命令,使环境变量生效:

source /etc/profile

在/etc/hosts 文件中添加本机ip和主机名

127.0.0.1 localhost

192.168.153.133 chenrui0203

4.安装和配置免密码登录ssh

A.先判断是否已安装SSH

执行命令ssh localhost,若提示输入密码,即已安装

B.确认连接到互联网,输入命令安装

apt-get install openssh-server

C.查看在根目录下是否存在.ssh文件夹

切换到根目录下/root,使用命令 ls –a 查看

若没有则创建,使用命令

mkdir .ssh

D.产生密钥

在/root/.ssh 目录下执行ssh-keygen -t rsa –P ‘’ 注意有后面的单引号 一路回车,不要输入任何东西

E.将生成的公钥追加到授权的key中去

cat /root/.ssh/id_rsa.pub >> /root/.ssh/authorized_keys

F.验证安装是否成功

ssh –version

ssh localhost 不需要输入密码即安装成功

退出使用命令exit

5.配置hadoop

A.修改slaves文件,最好配置为ip

切换到hadoop文件夹下,

在slaves文件中加入从节点(此处伪分布式即为这台机器的ip)的ip

B.在hadoop-env.sh,加入环境变量

export JAVA_HOME=/usr/lib/jvm/java1.8.0_112

C.配置HDFS的地址及端口号,文件为core-site.xml

hadoop.tmp.dir

/home/cr/hadoop/tmp 设置临时文件夹,只要在home下即可

fs.defaultFS

hdfs://192.168.16.130:9000 修改为本机IP地址

D.修改hdfs-site.xml,为配置HDFS文件的备份方式,及文件的默认路径

dfs.replication

1 备份数目,单节点是1,多节点一般为3

dfs.namenode.name.dir

/home/cr/hadoop/dfs/name namenode所在路径

dfs.namenode.data.dir

/home/cr/hadoop/dfs/data datanode所在路径

dfs.permissions

false HDFS的权限

E.配置mapred-site.xml

mapreduce.framework.name

yarn

F.配置yarn-site.xml

yarn.resourcemanager.hostname

localhost 本机IP或者localhost

yarn.nodemanager.aux-services

mapreduce_shuffle

6.格式化文件系统HDFS

进入hadoop下的bin文件夹,执行命令

./hadoop namenode -format

7.启动hadoop

进入sbin夹,执行./start-all.sh

8.验证是否安装成功

执行jps命令,会出现5个进程,包括jps一共六个进程

9.查看资源使用状态

http://localhost:8088(MapReduce 的Web页面)

http://localhost:50070(HDFS 的Web页面)

10.查看各节点状态

/home/xx/hadoop/bin/hadoop dfsadmin -report

11.运行自带的wordcount例子

A.在本地创建一个文件夹input,创建两个文本文件

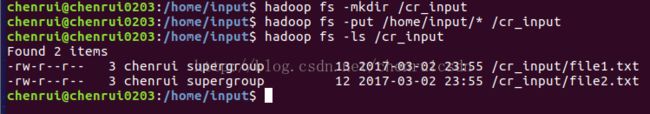

B.在hdfs上创建一个文件夹cr_input 一定要加 /

C.把我们创建的文本文件放进hdfs的cr_input中

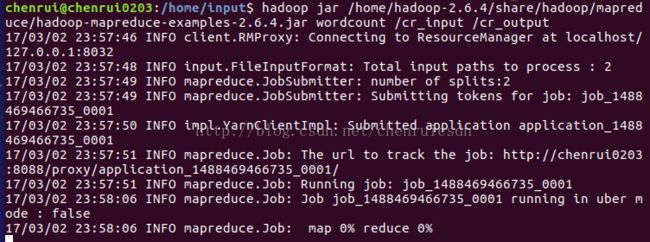

D.执行wordcount例子 cr_output 是结果输出目录,注意jar包的路径可能与我的不一样然后运行等待

E.执行过程

F.查看结果 输出目录下的part-r-0000就是结果