Hadoop-Hbase环境搭建

一. 初始环境

1. hadoop : hadoop-1.2.12. java : jdk1.6.0_45 --> 改为 jdk1.7.0_80

3. hbase : hbase-0.98.24-hadoop1

二. 启动hadoop

hadoop安装目录: /usr/local/src/hbase-0.98.24-hadoop1

1. 格式化hadoop集群

hadoop namenode -format2.启动集群

start-all.sh3.检查hadoop启动状态

3.1 在master上执行jps

2615 JobTracker

13386 Jps

2538 SecondaryNameNode

2395 NameNode3.2 在slave1,slave2节点上执行jps

2306 DataNode

4707 Jps

2385 TaskTracker3.3 测试集群能否上传与读取文件

命令如下:

#查看hadoop文件列表 hadoop fs -ls / #上传文件:(自己随便创建一个文件即可) hadoop fs -put /usr/local/src/test / #读取文件:

hadoop fs -text /test三. 下载安装配置hbase

1. 解压到执行目录

tar xzvf hbase-0.98.24-hadoop1-bin.tar.gz -C /usr/local/src/2. 配置环境变量

vi ~/.bashrc

export HBASE_HOME=/usr/local/src/hbase-0.98.24-hadoop1

export PATH=$HBASE_HOME/bin:$PATH查看环境变量是否生效:

echo $HBASE_HOME3. 修改配置文件

进入目录:

/usr/local/src/hbase-0.98.24-hadoop1/conf3.1 修改hbase-env.sh

export JAVA_HOME=/usr/local/src/jdk1.6.0_45

#使用hbase自带的zk

export HBASE_MANAGES_ZK=true3.2 修改regionservers

添加如下内容:

slave1

slave23.3 修改hbase-site.xml

配置如下内容:

hbase.tmp.dir

/var/hbase

hbase.rootdir

hdfs://master:9000/hbase

hbase.cluster.distributed

true

hbase.zookeeper.quorum

master,slave1,slave2

hbase.zookeeper.property.dataDir

/usr/local/src/hbase-0.98.24-hadoop1/zookeeper

远程复制到其他两个节点上

scp -rp /usr/local/src/hbase-0.98.24-hadoop1 slave1:/usr/local/src

scp -rp /usr/local/src/hbase-0.98.24-hadoop1 slave1:/usr/local/src4. 启动hbase

start-hbase.sh5.查看hbase启动状态

执行命令:

hbase shell之后执行命令:

status如出现以下结果,表示hbase启动成功:

hbase(main):009:0> status

1 active master, 0 backup masters, 2 servers, 0 dead, 1.5000 average load四. 异常总结

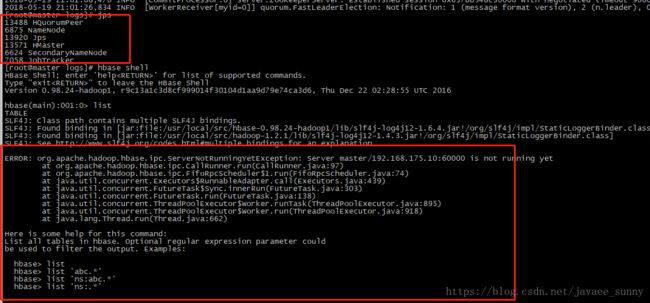

在执行hbase命令时,可能会出现

在master,slave1,slave2节点上执行jps,进程启动均是正常,但执行任何hbase命令,都报错.

解决方案:

方法1:

hadoop dfsadmin -safemode leave这种方法,也是网上找到最多的解决方案,可惜尝试之后,并不起作用;

方法2:

修改JAVA_HOME ,从1.6升级到1.7

#export JAVA_HOME=/usr/local/src/jdk1.6.0_45

export JAVA_HOME=/usr/local/src/jdk1.7.0_80