MFS文件系统

什么是MFS文件系统:

MooseFS是一个具有容错性的网络分布式文件系统。它把数据分散存放在多个物理服务器上,而呈现给用户的则是一个统一的资源。

MooseFS文件系统结构包括一下四种角色:

1.管理服务器master

管理服务器:负责各个数据存储服务的管理文件读写调度,文件空间回收以及恢复,多节点拷贝

2.元数据日志服务器:

负责备份master服务器的变化日志文件,文件类型为changelog_ml.*.mfs,以便于在master server出现问题的时候解体器 进行工作3.数据存储服务器data server(chunk servers)

真正存储用户数据的服务器存储文件时,首先把文件分成块,然后这些块在数据服务器chunkserver之间赋值(复制份数可以手工指定,建议设置副本数为数据服务器可以为多个,并且数据越多,可使用的“磁盘空间越大,”可靠性也越高

4.客户端挂在 使用clinet computers

使用MFS文件系统来存储和访问的主机名称为MFS的客户端,成功挂载MFS系统以后,就可以像以前NFS一样共享这个虚拟性的存储了。

MFS文件系统的配置:

1.在server1安装master和web图形界面

yum install -y moosefs-cgi-3.0.97-1.rhsysv.x86_64.rpm

moosefs-cgiserv-3.0.97-1.rhsysv.x86_64.rpm

moosefs-master-3.0.97-1.rhsysv.x86_64.rpm2.做主节点解析(这个非常重要,一定要做)

vim /etc/hosts

172.25.1.1 server1 mfsmaster # 表明server1是master的身份 master上是存储的元数据

172.25.1.2 server2

172.25.1.3 server33.打开服务

/etc/init.d/moosefs-master start查看端口:netstat -antlp

4.打开图形处理工具

/etc/init.d/moosefs-cgiserv start查看端口netstat -antlp

5.在浏览器中172.25.1.1:9425

在sevrer2和server3中

1.安装MFS的客户端软件

yum install moosefs-chunkserver-3.0.97-1.rhsysv.x86_64.rpm2.编辑客户端的配置文件

vim mfshdd.cfg

/mnt/chunk1 # 确定serer2中存储数据的挂载点

mkdir /mnt/chunk1 # 建立该目录3.修改该挂载目录的所有人和所有组,这样才可以在目录中进行读写操作

chown mfs.mfs /mnt/chunk1/4.在server2中编辑解析文件

vim /etc/hosts

172.25.1.1 server1 mfsmaster5.打开服务

/etc/init.d/moosefs-chunkserver start利用客户端:

1.安装客户端软件

yum install moosefs-client-3.0.97-1.rhsystemd.x86_64.rpm2.编辑解析文件

vim /etc/hosts

172.25.1.1 server1 mfsmaster

(这个解析特别重要,是确定server1的master位置,而且客户端在访问其中的数据时候,是先来master端取得存储数据得元数据,再去server2或server3上取数据)

3.创建在真机挂载数据的目录并编辑配置文件

mkdir /mnt/mfs

vim mfsmount.cfg

/mnt/mfs4.客户端挂载文件系统

cd /mnt/mfs

mfsmount

在该目录下建立目录:

mkdir dir1 mkdir dir2

查看该目录中的文件存储的份数

mfsgetgoal dir1

mfsgetgoal dir2如果出现这种问题,先退出这个目录,再进去看,重新建立文件,重新执行

6. 修改dir1的文件备份份数为1(为了做实验对比)

mfssetgoal -r 1 dir1 7.测试:

mfsfileinfo passwd

dd if=/dev/zero of=file1 bs=1M count=100 # 截取大文件

mfsfileinfo file1 # 查看file1的文件状态8.数据恢复

在/mnt下建立目录mfsmeta

mkdir mfsmeta

mfsmount -m /mnt/mfsmeta/

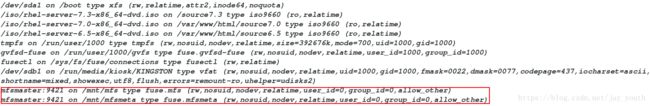

用mount查看挂载情况在该目录下查看是否有trash(如果没有,退出当前目录,再进来查看)

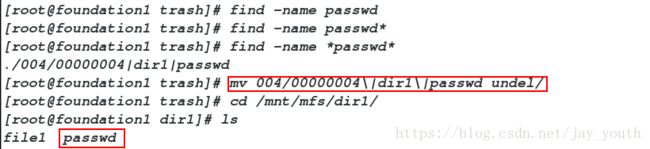

find -name *passmv

004/00000004|dir1|passwd undel/wd*

数据恢复成功: