分析系统调用的处理过程(systemcall->iret)

罗晓波 + 原创作品转载请注明出处 + 《Linux内核分析》MOOC课程http://mooc.study.163.com/course/USTC-1000029000

本片内容接上一篇,是系统调用的续篇,也就是简要分析一下系统调用的处理过程。同样,以一个实验开始。

本实验同样在实验楼环境下完成。下面先介绍一下实验:

1.实验:

将上一个系统调用函数和asm版本的实现整合进入menu的内核中:

int GetPid()

{

int pid = getpid();

printf("The Current Progress pid is : %d\n",pid);

return 0;

}

int GetPidAsm()

{

int pid;

asm volatile(

"mov $0,%%ebx\n\t"

"mov $0x14,%%eax\n\t"

"int $0x80\n\t"

"mov %%eax,%0\n\t"

: "=m" (pid)

);

printf("The Current Progress pid asm is : %d\n",pid);

return 0;

}

int main()

{

PrintMenuOS();

SetPrompt("MenuOS>>");

MenuConfig("version","MenuOS V1.0(Based on Linux 3.18.6)",NULL);

MenuConfig("quit","Quit from MenuOS",Quit);

MenuConfig("time","Show System Time",Time);

MenuConfig("time-asm","Show System Time(asm)",TimeAsm);

MenuConfig("getpid","Show Current Progress id",GetPid);

MenuConfig("getpid-asm","Show Current Progress asm id",GetPidAsm);

ExecuteMenu();

}

在添加了getpid和getpid-asm这两个命令之后,make一下,再重新编译一下内核,make rootfs。再启动一下qemu:

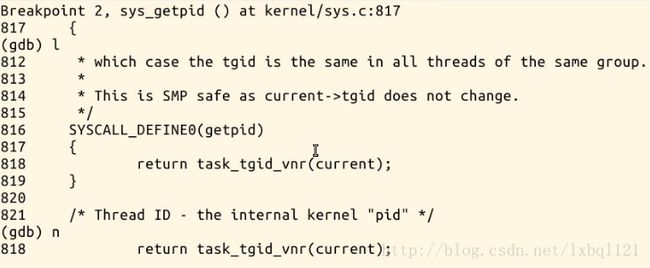

接下来,我们开始调试这个系统调用函数,对应着getpid这个系统调用,在sys_getpid这个内核函数这里打一个断点。continue之后,输入getpid-asm或者getpid这个命令会停在sys_getpid();

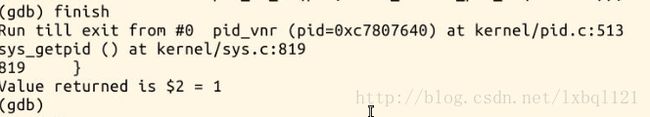

可以看到,在kernel/sys.c中有这么一个sys_getpid()内核函数,这个也就是系统调用的服务例程。跟进这个task_tgid_vnr(current)函数,之后finish之后的返回值是1,也就是init进程的进程号。

当然打印出来的current pid 也是1 。

有点遗憾的是我没有找到让gdb在systemcall这个汇编代码处停止的办法,希望小伙伴可以友情提示。下面来进一步分析从systemcall到系统调用结束之后,iret之间的过程。

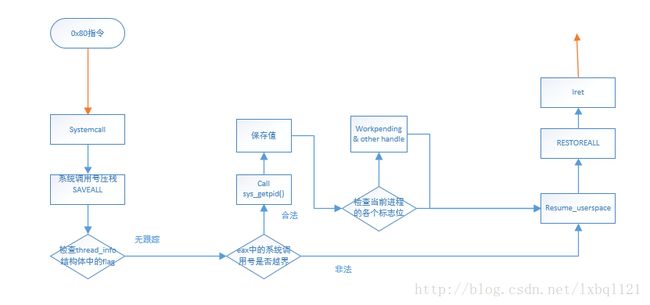

2.从systemcall到iret过程:

Systemcall内核源码(汇编代码)进行简要分析:

490ENTRY(system_call)

491 RING0_INT_FRAME # can't unwind into user space anyway

492 ASM_CLAC

493 pushl_cfi %eax # save orig_eax

494 SAVE_ALL

495 GET_THREAD_INFO(%ebp)

496 # system call tracing in operation / emulation

497 testl $_TIF_WORK_SYSCALL_ENTRY,TI_flags(%ebp)

498 jnz syscall_trace_entry

499 cmpl $(NR_syscalls), %eax

500 jae syscall_badsys501syscall_call:

502 call *sys_call_table(,%eax,4)

503syscall_after_call:

504 movl %eax,PT_EAX(%esp) # store the return value

505syscall_exit:

506 LOCKDEP_SYS_EXIT

507 DISABLE_INTERRUPTS(CLBR_ANY) # make sure we don't miss an interrupt

508 # setting need_resched or sigpending

509 # between sampling and the iret如果上面的都没问题的话,我们来到系统调用函数执行的地方了,调用服务例程,系统调用号乘以4加上sys_call_table的基址,内核系统调用的服务例程,也就是getpid的函数地址就是它了,调用call指令,开始执行,又是顺理成章的将eax的值,也就是系统调用的返回值放到esp的某一个偏移量(PT_EAX)处。

在系统调用退出之前,在restoreall之前,会将threadinfo中的许多标志位进行比较,看是否需要在返回用户态之前做点什么事,比如我们看着一段:

在恢复用户态之前的一段代码:

350 TRACE_IRQS_OFF

351 movl TI_flags(%ebp), %ecx

352 andl $_TIF_WORK_MASK, %ecx # is there any work to be done on

353 # int/exception return?

354 jne work_pending

355 jmp restore_all593work_pending:

594 testb $_TIF_NEED_RESCHED, %cl

595 jz work_notifysig596work_resched:

597 call schedule

598 LOCKDEP_SYS_EXIT

599 DISABLE_INTERRUPTS(CLBR_ANY) # make sure we don't miss an interrupt

600 # setting need_resched or sigpending

601 # between sampling and the iret

602 TRACE_IRQS_OFF

603 movl TI_flags(%ebp), %ecx

604 andl $_TIF_WORK_MASK, %ecx # is there any work to be done other

605 # than syscall tracing?

606 jz restore_all在restoreall之后,就将中断的程序被恢复了。 下面是一张简要流程图: