简单的网络爬虫设计——下载网页图片

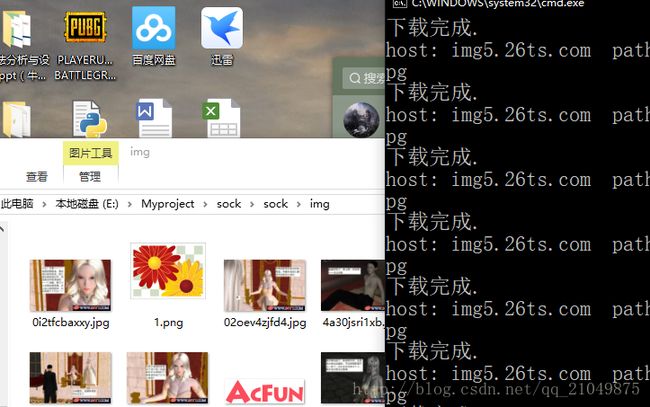

闲着没事,想方便的看一些小网站,就打算动手写一个爬虫,根据使用了上一次写酷q的自动回复机器人封装的clientSocket类,至于为什么不用python,几行代码就可以做完的事,用C++写了200多行,因为觉得用C++造轮子挺有意思的,虽然我的C++用得很烂…….

做完这个后,我发现我对http的请求格式,有很大的误解,所以在上次写酷q请求数据的时候,http没有发送响应消息,就发了报文。

http协议详解:https://www.cnblogs.com/li0803/archive/2008/11/03/1324746.html

爬虫思路:

1、通过访问url(头节点,我们开始输入的网址),从该url中解析出图片资源(.jpg .png)链接与该网页中其他的网页链接(后面统称为节点)并保存至容器(如队列,栈之类)

2、通过请求图片url,下载完当前的网页中的图片后,我们就从刚刚获取的网页链接(节点)中扩展,也就是读取其他的节点,然后重复步骤1。

3、为了防止重复加载同一个节点,用map(字典)对节点进行计数。

碰见的问题:

1、如解析url的时候,我首先想到的是用正则表达式去匹配,(http://)?(^\/)(.*) ,然后通过分组获取host与filepath,程序运行开始下载几张图片的时候是没问题,但是后面会报错然后程序蹦了,通过日志发现,在解析一些的图片资源时,解析会失败,并没有把http:// 给去掉,以至于host是带有http://,这个问题我也不知道怎么回事,正则表达式应该是对的,测试了也是正确的。

解决方法:不用正则表达式,直接用string,将我们要提取的字符串substr提取出来,程序就能正常运行。

2、并不是所有的http网站都可以爬到图片,虽然代码中的这个腾讯新闻网站没事,但是爬http://www.acfun.cn/,的时候会碰到解析图片资源的url错误(应该是正则表达式写法的问题),目前没想好怎么写,改过几次,可能需要根据不同的网站写不同的正则表达式,匹配相应的资源。

3、C++正则表达式的使用,以及regex_serach的使用。

代码:

urlDownload.h

#pragma once

#include urlDownload.cpp

#include"urlDownload.h"

#includemain:

urlDownload t;

t.run("http://news.qq.com/");