Spark Core 和 Spark SQL 实现分组取Top N(基于scala)

分组取Top N在日常需求中很多见:

- 每个班级分数前三名同学的名字以及分数

- 各省指标数量前三的市的名字

等等需求,主要思想就是在某一个分区(班级,省)中取出该分区Top N的数据

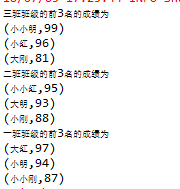

测试数据格式:

如上图,字段含义为,班级,学生姓名,分数

下面我们通过一个Demo来实现各班级分数前三的学生姓名以及分数

1、通过Spark core 实现:

//读取测试数据保存为rdd

val rddtext = sc.textFile("file:///C:/Users/chunyuhe/Desktop/test1.txt")

//将数据转化为Row形式(为下面Spark SQL 生成临时表用)

val rowrdd = rddtext.map(m => Row(m.split(" ")(0), m.split(" ")(1), m.split(" ")(2).toInt))

/**

* spark core 实现分组取topN

*/

val classrdd = rddtext.map(x => {

//取到各数据并赋值给变量

val classname = x.split(" ")(0)

val name = x.split(" ")(1)

val grade = x.split(" ")(2)

//生成一个便于计算的元组

(classname, (name, grade.toInt))

}).groupByKey

//根据key聚合分组得到

classrdd.foreach(x => println(x))

classrdd.map(m => {

val classname = m._1

//如上图将各班级同学信息转化为Array数组并且安装成绩进行降序排列取前三

val top3 = m._2.toArray.sortWith(_._2 > _._2).take(3)

(classname, top3)

}).foreach(m => {

println(m._1 + "班级的前3名的成绩为")

m._2.foreach(x => {

println(x)

})

})

输出结果为:

2、通过Spark sql 实现:

//隐式转换

import spark.implicits._

import spark.sql

//生成数据表表结构

val schema = StructType(mutable.ArraySeq(

StructField("classname", StringType, true),

StructField("name", StringType, true),

StructField("grade", IntegerType, true)))

//将表结构和表数据组合生成表

val tablerow = spark.createDataFrame(rowrdd, schema)

//将生成的df转换为一个表并且命名

tablerow.createTempView("testtable")

val tetrow = sql("select * from testtable")

//tetrow.show()

//运用Spark sql 开窗函数进行计算

PARTITION BY 为需要开窗字段

ORDER BY 为需要排序字段

val resultrow = sql("""

select a.classname,a.name,a.grade from (select classname,name,grade,row_number() OVER (PARTITION BY classname ORDER BY grade DESC) rank from testtable) as a where a.rank <= 3

""")

resultrow.show()

输出结果:

本文结束,希望能帮到大家,也希望大家批评指正!