Python网络爬虫——使用Urllib爬取网页

1、简介

urllib模块是python提供提供的一个用于操作URL的模块

2、使用

第一步:用urllib快速爬去一个网页

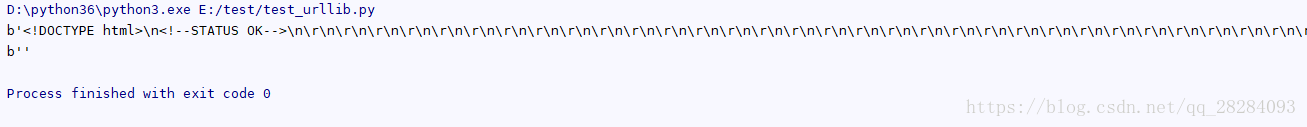

在此以百度为例,如下,答应出爬取到的网页的全部内容和一行内容。

# *-*coding:utf-8*-*

from urllib import request

file = request.urlopen("http://www.baidu.com")

data = file.read() # 读取全部内容

dataline = file.readline() # 读取一行内容

print(data)

print(dataline)运行结果如下:

第二步:将爬取到的网页以网页的形式保存到本地

# *-*coding:utf-8*-*

from urllib import request

file = request.urlopen("http://www.baidu.com")

data = file.read() # 读取全部内容

doc = open("E:/test/1.html","wb")

doc.write(data)

doc.close()浏览器打开:

3、其它

除了上述方法,还可以用其它方式去保存网页:

file = request.urlopen("http://www.baidu.com",filename="E:/test/2.html")在urlretrieve执行的过程中,会产生一些缓存,可以使用如下代码清除缓存:

request.urlcleanup()如果要获取当前爬取网页的状态码:

file.getcode()如果要获取当前爬取网页的URL:

file.geturl()如果要对URL进行编码:

urllib.request.quote("url")如果对URL进行解码:

urllib.request.unquote("url")

大概完结