【总结】Robust physical-world attacks on deep learning models

一、相关工作:

A. 对抗样本:

Goodfellow: the fast gradient sign (FGS)

iterative optimization-based algorithm

universal perturbations: 生成perturbation vector,但是不通用

共同点:

1、都假设有digital access to the input vectorrs of the DNN, 但在深度学习模型中这个假设太强了

2、优化扰动到最小,使得人眼观测不到,但是在物理世界里,来自相机环境等各种因素会破坏这种扰动

B. Physical-Realizability of Adversarial Perturbations

Sharif::攻击了人脸识别系统 by 在眼镜上print 对抗干扰

Kurakin:证明通过只能收即的项集也能增加对抗样本达到误分类

Athalye and Sutskever:改进了Kurakin的,使得对抗样本对一系列二维转动鲁棒,但都没有在物理物体上实现过

Lu:在道路交通标志上进行了实验,他们得出结论对抗样本在实际中无效。而我们证明了也有效

二、Problem statement

用了US和German两国的交通指示标志作为训练集

分别用LISA-CNN和GTSRB*CNN

专注在不知道训练及来源的攻击

关注在白盒攻击

证明了物理上对标志进行改动也能迷惑分类器

流程:

1、得到干净的各个角度各个距离的目标道路指示标志

2、预处理作为RP2的输入,并生成对抗样本

3、在物理上作出结果干扰(poster-printing attacks或者贴贴纸)

4、应用到目标道路标志上

三、鲁棒的物理扰动:

A. RP2

用了optimization-based approach

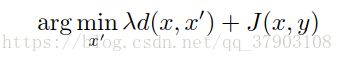

为了生成目标对抗样本,objective function 为:

在图像领域,对于二维扰动向量 δ=[δ(1,1),...,δ(H,W)] δ = [ δ ( 1 , 1 ) , . . . , δ ( H , W ) ] , the lp l p norm for p>0 为:

一般, l0 l 0 norm 是扰动像素的总数, l∞ l ∞ norm 是最大扰动的量级

J(⋅,⋅) J ( · , · ) 是损失函数

计算perturbation masks:

定义mask的形状是涂鸦或者抽象画(为了让扰动无意义)

mask是矩阵 MX M X ,无添加扰动的地方为0,有扰动的地方为1

优化 spatially-constrained perturbations:

用Adam optimizer来优化,优化后的objective

function为:

为了增加扰动的可打印性,增加了一项,用了Sharif提出的方法,计算对抗扰动的NPS值:

物理对抗样本类型:

subtle poster

camouflage sticker

四、评估:

evaluation components:

环境条件

空间限制

制造中产生的error

分辨率改变

看不到的物理限制

具体指标:距离、角度、分辨率

evaluation methodology:

step 1:lab tests( stationary tests)

step 2:field tests (drive-by tests)

stationary tests

在不同距离和角度下静止测试:

drive-by tests

讨论:

全覆盖下效果最好,但容易被察觉,最后采用涂鸦方式或贴图方式

白色打印后颜色不接近,最后用相机纸打印

在大角度和大距离下,白色容易被周围颜色影响,最后加大白色贴纸

future work:

解决容易被看到的问题

黑盒攻击是否有效

找到防御方法