1. 前言

因为FFmpeg是基于Linux开发的开源项目,如果在wins下编译FFmpeg,需要配置Linux相关环境,比较麻烦,而由于我本人的电脑系统是wins的,还不打算换成Linux系统的,安装虚拟机编译FFmpeg又比较慢,遂买了一个阿里云服务器(当然也不仅仅用在此处,我之后会将它作为服务器用),暂时作为Linux系统的电脑,用于FFmpeg的编译,如果你的电脑是Linux系统的,直接可以编译FFmpeg,则无需购买。

2. 购买阿里云主机

阿里云官网

选择ubuntu 16.04 64位

购买主机的过程中,要记住用户名、登录名、公网IP等,以待备用。我买的是最低配置,也就够用了,一个月大概60元。

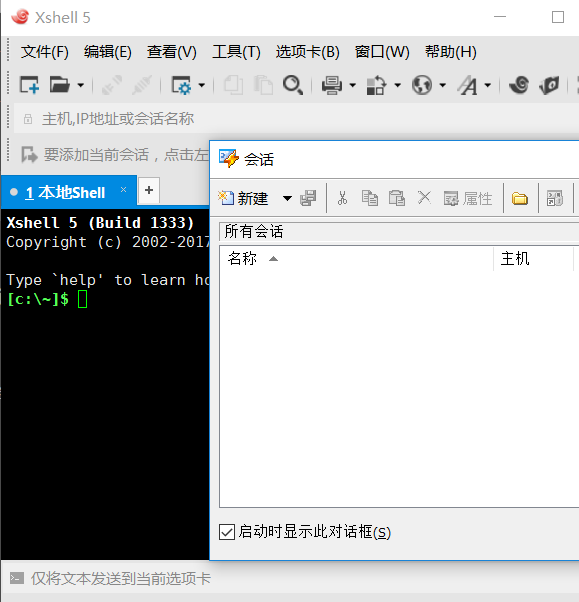

3. Xshell的安装---傻瓜式安装

点击新建:

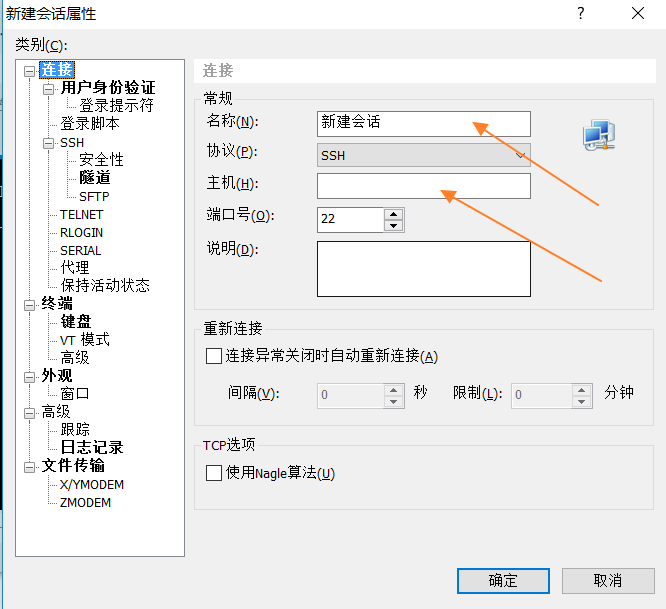

新建会话中输入自己会话的名称,随意起都行,我这里是zhangpan,主机填的是购买的阿里云提供的公网IP(一般通过短信会通知到,或者自行在阿里云的管理控制台查看),点击确定,连接,可能第一次连接不上,你只需重新连接,然后输出用户名和密码(对应的是阿里云你输入的用户名和密码),连接上之后,大致如图:

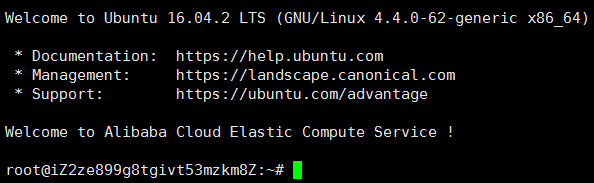

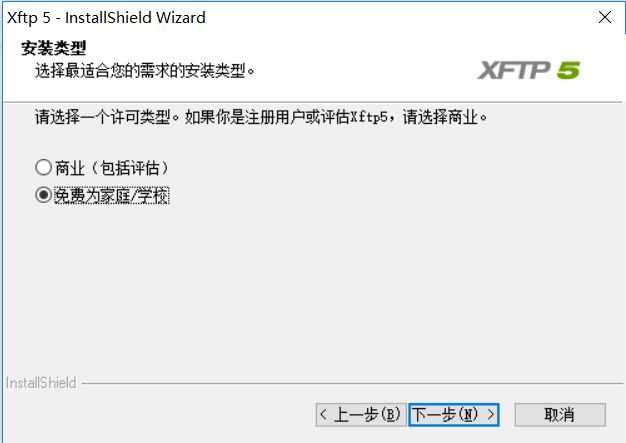

4. Xftp安装

也基本是傻瓜式安装,就是需要注意下面选择免费为家庭/学校,免费的大家都懂

安装完成之后,关闭Xftp客户端,在Xshell客户端中点击新建文件传输

需要输入密码,还是对应之前的密码,输入完成点击确定

表示已经登录完成,点击右侧的文件夹,找到usr目录

5. 上传ndk

首先在usr目录中创建ndk文件夹,

在Xshell命令行中输入

cd /usr

mkdir ndk

在Xftp中刷新就可以看见在usr目录下看见ndk文件夹,点击进去,里面现在是空的。

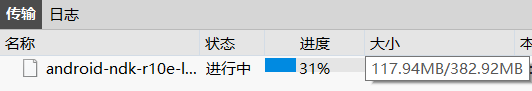

在Xftp中的左侧找到wins电脑的的ndk文件(Linux版本),我这里的版本是android-ndk-r10e-linux-x86_64.bin,右键点击传输,就可以在下方看到传输进度条了

6. 解压ndk

等ndk上传完成后,就可以解压ndk了,首先我们需要目录给权限

cd ../

chmod 777 -R ndk

cd ../ 回到usr目录下

给ndk增加权限

cd ndk

./android-ndk-r10e-linux-x86_64.bin

进行ndk解压过程,需要等待几分钟,解压完成命令行如图:

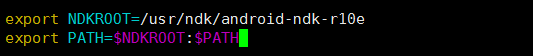

7. ndk环境变量的配置

cd ~

vim ~/.bashrc

~代表用户,点击i键进入编辑模式,在最后添加上下图所示配置:

ESC退出编辑模式,shift + z z 退出命令模式

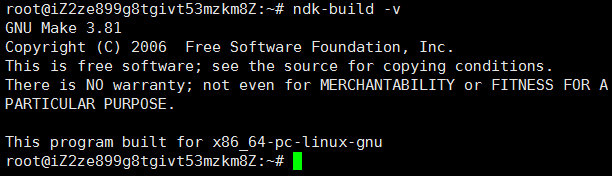

验证ndk是否配置成功

source ~/.bashrc

ndk-build -v

source ~/.bashrc:更新环境变量

出现下图所示,表示配置成功

8. 上传FFmpeg

新建一个zhangpan文件夹在usr目录下

mkdir zhangpan

mkdir zhangpan在usr目录下生成zhangpan文件夹,在Xftp客户端右侧刷新找到zhangpan文件夹,点击进去,然后在左侧找到fmpeg对应wins电脑中的位置(我这里的版本是ffmpeg-2.6.9.zip),右键选择传输,就可以看的ffmpeg传输进度条了。此处给上FFmpeg官网地址:http://ffmpeg.org/,直接Download ---> Download 就可以下载。

9. 解压FFmpeg

命令行进入zhangpan目录下,然后执行解压操作:

unzip ffmpeg-2.6.9.zip

发现没有解压工具,需要安装:

sudo apt-get install zip

如果一直提示不成功,可以先更新

sudo apt-get update

然后再安装,这时候就成功了,然后执行解压操作,解压过程很快就会成功。

10. 编译FFmpeg

编写shell脚本文件build_android.sh,这个脚本是用来执行ffmpeg下的configure配置的:

#!/bin/bash

make clean

export NDK=/usr/ndk/android-ndk-r10e

export SYSROOT=$NDK/platforms/android-9/arch-arm/

export TOOLCHAIN=$NDK/toolchains/arm-linux-androideabi-4.8/prebuilt/linux-x86_64

export CPU=arm

export PREFIX=$(pwd)/android/$CPU

export ADDI_CFLAGS="-marm"

./configure --target-os=linux \

--prefix=$PREFIX --arch=arm \

--disable-doc \

--enable-shared \

--disable-static \

--disable-yasm \

--disable-symver \

--enable-gpl \

--disable-ffmpeg \

--disable-ffplay \

--disable-ffprobe \

--disable-ffserver \

--disable-doc \

--disable-symver \

--cross-prefix=$TOOLCHAIN/bin/arm-linux-androideabi- \

--enable-cross-compile \

--sysroot=$SYSROOT \

--extra-cflags="-Os -fpic $ADDI_CFLAGS" \

--extra-ldflags="$ADDI_LDFLAGS" \

$ADDITIONAL_CONFIGURE_FLAG

make clean

make

make install

注意ndk的位置,我这里是/usr/ndk/android-ndk-r10e,大家可以更改这里,由于目前是生成arm的so库,所以这里配置的CPU=arm,如果要生成x86的so库,直接更改CPU=x86就行。

将build_android.sh脚本传输到ffmpeg的目录下,还是通过右键选择传输,如果该脚步文件是在win中编写的,再上传到Linux中,可能还需要用到dos2unix命令去转换。

先切换到zhangpan目录下,然后添加权限

chmod 777 -R ffmpeg-2.6.9

切换到ffmpeg目录下,执行脚步

./build_android.sh

脚本大概需要十分钟不到就能完成,结束之后,按照下图执行命令行,说明FFmpeg编译成功

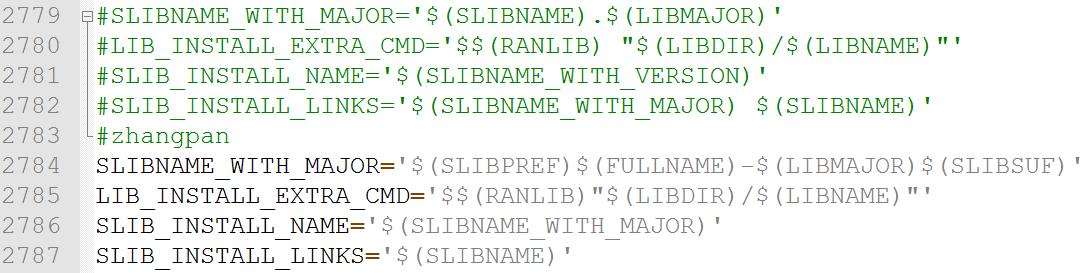

但是这样还是不够的,因为Android只能识别.so结尾的so库,上述中有比如libavcodec.so.56是不符合要求的,那我们应该怎么做呢?我们在wins下更改ffmpeg目录下的configure

SLIBNAME_WITH_MAJOR='$(SLIBNAME).$(LIBMAJOR)'

LIB_INSTALL_EXTRA_CMD='$$(RANLIB) "$(LIBDIR)/$(LIBNAME)"'

SLIB_INSTALL_NAME='$(SLIBNAME_WITH_VERSION)'

SLIB_INSTALL_LINKS='$(SLIBNAME_WITH_MAJOR) $(SLIBNAME)'

找到这段配置,改成如下配置:

SLIBNAME_WITH_MAJOR='$(SLIBPREF)$(FULLNAME)-$(LIBMAJOR)$(SLIBSUF)'

LIB_INSTALL_EXTRA_CMD='$$(RANLIB)"$(LIBDIR)/$(LIBNAME)"'

SLIB_INSTALL_NAME='$(SLIBNAME_WITH_MAJOR)'

SLIB_INSTALL_LINKS='$(SLIBNAME)'

最终更改后的配置如图:

还是一样,在Xftp客户端左侧找到改后的configure文件,右键选择传输(注意右侧应在ffmpeg目录下)

在重新编译之前,我们删除掉上次编译生成的android文件夹,在ffmpeg目录下:

rm -rf android

然后重新编译

./build_android.sh

这样符合要求的so库就生成了。大功告成!!!

现在我们来将android这个文件夹传输到wins下,为了传输速度较快,我首先将其压缩,cd到ffmpeg-2.6.9目录下,然后执行

zip -r android.zip android

压缩之后,在Xftp中将其右键传输到你wins所在的目录,然后解压,以待备用。

测试FFmpeg

创建一个Android Studio项目zpplayer,勾上C/C++ suport,将上面解压好的android目录下的include文件夹复制到cpp文件夹下,然后将arm/lib下的下列so库拷贝到项目中的libs目录下的armeabi文件夹下(armeabi文件夹自行创建)

libavutil-54.so

libavcodec-56.so

libavdevice-56.so

libswresample-1.so

libswscale-3.so

libavfilter-5.so

libavformat-56.so

libpostproc-53.so

在cpp目录下,新建zp_decode.c,CMakeLists配置:

cmake_minimum_required(VERSION 3.4.1)

set(path_project E:/AndroidStudio_WorkSpace/zpplayer)

add_library(zp_decode

SHARED

src/main/cpp/zp_decode.c)

add_library(avcodec SHARED IMPORTED)

set_target_properties(avcodec PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libavcodec-56.so)

add_library(avdevice SHARED IMPORTED)

set_target_properties(avdevice PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libavdevice-56.so)

add_library(avfilter SHARED IMPORTED)

set_target_properties(avfilter PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libavfilter-5.so)

add_library(avformat SHARED IMPORTED)

set_target_properties(avformat PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libavformat-56.so)

add_library(avutil SHARED IMPORTED)

set_target_properties(avutil PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libavutil-54.so)

add_library(postproc SHARED IMPORTED)

set_target_properties(postproc PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libpostproc-53.so)

add_library(swresample SHARED IMPORTED)

set_target_properties(swresample PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libswresample-1.so)

add_library(swscale SHARED IMPORTED)

set_target_properties(swscale PROPERTIES IMPORTED_LOCATION

${path_project}/app/libs/${ANDROID_ABI}/libswscale-3.so)

include_directories(src/main/cpp/include)

find_library(log-lib

log )

target_link_libraries(zp_decode

avutil

avcodec

avdevice

swresample

swscale

avfilter

avformat

postproc

${log-lib})

配置app.gradle,在cmake中添加

abiFilters "armeabi"

android中添加

sourceSets {

main {

jniLibs.srcDirs = ['libs']

}

}

因为只要在创建项目,就会自动创建CMakeList中对应的app.gradle配置,如果没有勾选,需要自己手动添加,下面是我项目中的app.gradle:

apply plugin: 'com.android.application'

android {

compileSdkVersion 26

defaultConfig {

applicationId "com.zhangpan.zpplayer"

minSdkVersion 15

targetSdkVersion 26

versionCode 1

versionName "1.0"

testInstrumentationRunner "android.support.test.runner.AndroidJUnitRunner"

externalNativeBuild {

cmake {

cppFlags ""

abiFilters "armeabi"

}

}

}

buildTypes {

release {

minifyEnabled false

proguardFiles getDefaultProguardFile('proguard-android.txt'), 'proguard-rules.pro'

}

}

externalNativeBuild {

cmake {

path "CMakeLists.txt"

}

}

sourceSets {

main {

jniLibs.srcDirs = ['libs']

}

}

}

dependencies {

implementation fileTree(dir: 'libs', include: ['*.jar'])

implementation 'com.android.support:appcompat-v7:26.1.0'

implementation 'com.android.support.constraint:constraint-layout:1.0.2'

testImplementation 'junit:junit:4.12'

androidTestImplementation 'com.android.support.test:runner:0.5'

androidTestImplementation 'com.android.support.test.espresso:espresso-core:3.0.1'

}

清单文件配置权限

创建VideoUtils

public class VideoUtils {

public native static void decode(String inputPath, String outputPath);

static {

System.loadLibrary("zp_decode");

}

}

这里不需要再加载FFmpeg中的so库了,因为CMakeList中的target_link_libraries已经配置,如果再加载,就会加载两次,大家切记切记!!这也是很多博客没有考虑到的。

zp_decode.c中JNI代码的编写:

//

// Created by zp on 2017/12/5.

//

#include

#include

//解码

#include "libavcodec/avcodec.h"

//封装格式

#include "libavformat/avformat.h"

//缩放

#include "libswscale/swscale.h"

#define LOGI(FORMAT, ...) __android_log_print(ANDROID_LOG_INFO, "zp", FORMAT, ##__VA_ARGS__);

#define LOGE(FORMAT, ...) __android_log_print(ANDROID_LOG_ERROR, "zp", FORMAT, ##__VA_ARGS__);

JNIEXPORT void JNICALL

Java_com_zhangpan_zpplayer_util_VideoUtils_decode(JNIEnv *env, jclass type, jstring input_jstr,

jstring output_jstr) {

const char* input_cstr = (*env) -> GetStringUTFChars(env, input_jstr, NULL);

const char* output_cstr = (*env) -> GetStringUTFChars(env, output_jstr, NULL);

//1. 注册所有组件

av_register_all();

//封装格式上下文

AVFormatContext* pFormatCtx = avformat_alloc_context();

//2. 打开输入视频文件,成功返回0,第三个参数为NULL,表示自动检测文件格式

if (avformat_open_input(&pFormatCtx, input_cstr, NULL, NULL) != 0) {

LOGE("%s", "打开输入视频文件失败");

return;

}

//3. 获取视频文件信息

if (avformat_find_stream_info(pFormatCtx, NULL) < 0) {

LOGE("%s", "获取视频文件信息失败");

return;

}

//查找视频流所在的位置

//遍历所有类型的流(视频流、音频流可能还有字幕流),找到视频流的位置

int video_stream_index = -1;

int i = 0;

for(; i < pFormatCtx -> nb_streams; i++) {

if (pFormatCtx->streams[i]->codec-> codec_type == AVMEDIA_TYPE_VIDEO) {

video_stream_index = i;

break;

}

}

//编解码上下文

AVCodecContext* pCodecCtx = pFormatCtx->streams[video_stream_index]->codec;

//4. 查找解码器 不能通过pCodecCtx->codec获得解码器

AVCodec* pCodec = avcodec_find_decoder(pCodecCtx->codec_id);

if (pCodec == NULL) {

LOGE("%s", "查找解码器失败");

return;

}

//5. 打开解码器

if (avcodec_open2(pCodecCtx, pCodec, NULL) < 0) {

LOGE("%s", "打开解码器失败");

return;

}

//编码数据

AVPacket* pPacket = (AVPacket*)av_malloc(sizeof(AVPacket));

//像素数据(解码数据)

AVFrame* pFrame = av_frame_alloc();

AVFrame* pYuvFrame = av_frame_alloc();

FILE* fp_yuv = fopen(output_cstr, "wb");

//只有指定了AVFrame的像素格式、画面大小才能真正分配内存

//缓冲区分配内存

uint8_t* out_buffer = (uint8_t*)av_malloc(avpicture_get_size(AV_PIX_FMT_YUV420P, pCodecCtx->width, pCodecCtx->height));

//初始化缓冲区

avpicture_fill((AVPicture*)pYuvFrame, out_buffer, AV_PIX_FMT_YUV420P, pCodecCtx->width, pCodecCtx->height);

//srcW:源图像的宽

//srcH:源图像的高

//srcFormat:源图像的像素格式

//dstW:目标图像的宽

//dstH:目标图像的高

//dstFormat:目标图像的像素格式

//flags:设定图像拉伸使用的算法

struct SwsContext* pSwsCtx = sws_getContext(

pCodecCtx->width, pCodecCtx->height, pCodecCtx->pix_fmt,

pCodecCtx->width, pCodecCtx->height, AV_PIX_FMT_YUV420P,

SWS_BILINEAR, NULL, NULL, NULL);

int got_frame, len, frameCount = 0;

//6. 从输入文件一帧一帧读取压缩的视频数据AVPacket

while(av_read_frame(pFormatCtx, pPacket) >= 0) {

if (pPacket->stream_index == video_stream_index) {

//7. 解码一帧压缩数据AVPacket ---> AVFrame,第3个参数为0时表示解码完成

len = avcodec_decode_video2(pCodecCtx, pFrame, &got_frame, pPacket);

if (len < 0) {

LOGE("%s", "解码失败");

return;

}

//AVFrame ---> YUV420P

//srcSlice[]、dst[] 输入、输出数据

//srcStride[]、dstStride[] 输入、输出画面一行的数据的大小 AVFrame 转换是一行一行转换的

//srcSliceY 输入数据第一列要转码的位置 从0开始

//srcSliceH 输入画面的高度

sws_scale(pSwsCtx,

pFrame->data, pFrame->linesize, 0, pFrame->height,

pYuvFrame->data, pYuvFrame->linesize);

//非0表示正在解码

if (got_frame) {

//图像宽高的乘积就是视频的总像素,而一个像素包含一个y,u对应1/4个y,v对应1/4个y

int yuv_size = pCodecCtx->width * pCodecCtx->height;

//写入y的数据

fwrite(pYuvFrame->data[0], 1, yuv_size, fp_yuv);

//写入u的数据

fwrite(pYuvFrame->data[1], 1, yuv_size/4, fp_yuv);

//写入v的数据

fwrite(pYuvFrame->data[2], 1, yuv_size/4, fp_yuv);

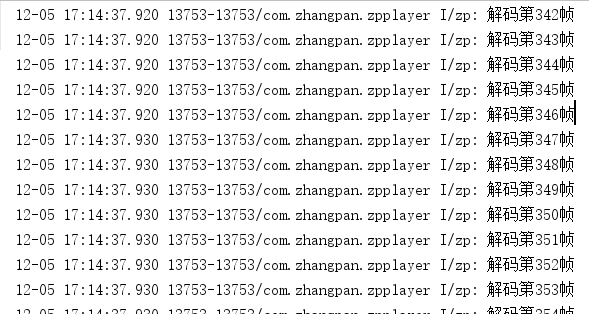

LOGI("解码第%d帧", frameCount++);

}

av_free_packet(pPacket);

}

}

fclose(fp_yuv);

av_frame_free(&pFrame);

av_frame_free(&pYuvFrame);

avcodec_free_context(&pCodecCtx);

avformat_free_context(pFormatCtx);

(*env) -> ReleaseStringUTFChars(env, input_jstr, input_cstr);

(*env) -> ReleaseStringUTFChars(env, output_jstr, output_cstr);

}

这里只为了测试,可不必追究细节,下篇博客将逐一介绍:Android Studio NDK开发(十三):FFmpeg视频解码

MainActivity的编写

public class MainActivity extends AppCompatActivity {

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

}

public void mDecode(View btn){

String input = new File(Environment.getExternalStorageDirectory(),"girls.mp4").getAbsolutePath();

String output = new File(Environment.getExternalStorageDirectory(),"output.avi").getAbsolutePath();

VideoUtils.decode(input, output);

}

}

布局文件很简单:

编译运行,Logcat输出为:

上图表示运行成功,也就是说我们编译FFmpeg成功!!OK!收工!!

最后我们介绍一下Vim编辑器:

Vim编辑器

Vim是一个功能强大、高度定制的文本编辑器。Vim强大的编辑能力中很大部分是来自于其普通模式命令。Vim的设计理念是命令的组合。

一般现在的版本都会自带Vim,这里如果没有的话,可以自己安装Vim,命令行输入

sudo apt-get install vim-gtk

验证是否成功安装,输入vim,如果成功,如下图

如果没成功,可先更新,再安装Vim

apt-get update

sudo apt-get install vim-gtk

Vim相关指令

强制退出:shift + : 然后输入q!

保存退出:shift + z z

由命令模式进入编辑模式:i

由编辑模式进入命令模式:Esc

命令模式中删除:x

命令模式中删除行:dd

Vim配置:

进入Vim配置信息中:

vim /etc/vim/vimrc

在配置信息最后加上下列配置:

set nu 显示行号

set cursorline 高亮显示当前行

set ruler 在右下角显示光标位置(具体的行、列)

展望

喜欢本篇博客的简友们,就请来一波点赞,您的每一次关注,将成为我前进的动力,谢谢!