一、elk简介

开源实时日志分析ELK平台能够完美的解决我们上述的问题,ELK由ElasticSearch、Logstash和Kiabana三个开源工具组成:

ElasticSearch是一个基于Lucene的开源分布式搜索服务器。它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。它提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口。Elasticsearch是用Java开发的,并作为Apache许可条款下的开放源码发布,是第二流行的企业搜索引擎。设计用于云计算中,能够达到实时搜索,稳定,可靠,快速,安装使用方便。

在elasticsearch中,所有节点的数据是均等的。

Logstash是一个完全开源的工具,他可以对你的日志进行收集、过滤、分析,并将其存储供以后使用(如,搜索),您可以使用它。说到搜索,logstash带有一个web界面,搜索和展示所有日志。

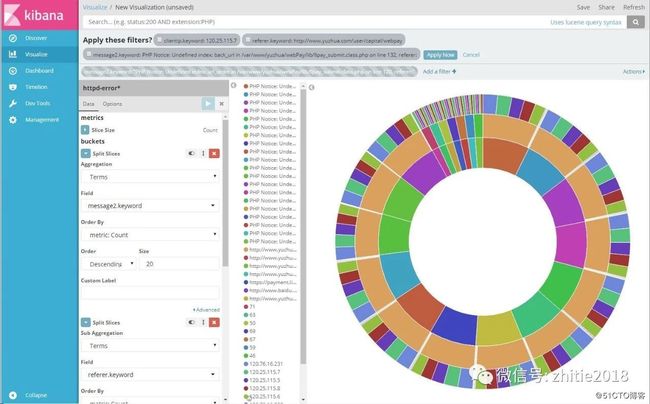

Kibana 是一个基于浏览器页面的Elasticsearch前端展示工具,也是一个开源和免费的工具,它Kibana可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助您汇总、分析和搜索重要数据日志。

二、部署

1、设备环境:

CentOS7,虚拟机内存6G,关闭防火墙和SELinux,分析日志较大时需要给tmp目录足够的空间

2、java环境

yum install -y java-1.8.0

3、组件安装

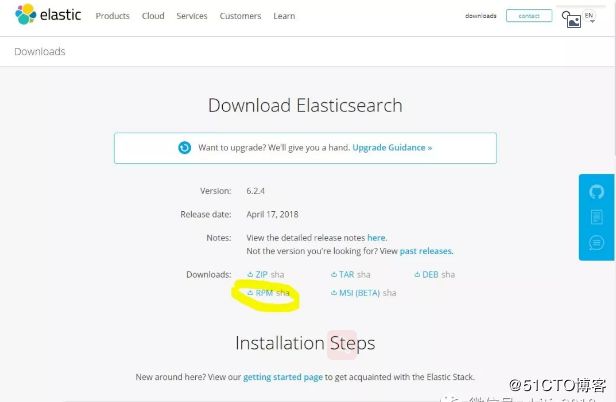

1)下载地址:https://www.elastic.co/downloads/,分别下载并安装ElasticSearch、Logstash和Kiabana的RPM安装包,需要注意保持版本一致;

2)安装elasticsearch及修改配置文件

yum install elasticsearch -y

systemctl daemon-reload

systemctl enable elasticsearch.service //添加开机自启

grep -v ^# /etc/elasticsearch/elasticsearch.yml

cluster.name: elk //集群名

node.name: elk-node-1 //节点名

network.host: 0.0.0.0 //监听地址

http.port: 9200 //监听端口

3)配置head插件

wget https://nodejs.org/dist/v6.9.5/node-v6.9.5-linux-x64.tar

tar -xvf node-v6.9.5-linux-x64.tar -C /usr/local/

ln -s node-v6.9.5-linux-x64/bin/node /usr/bin/node

ln -s node-v6.9.5-linux-x64/bin/npm /usr/bin/npm

npm install -g grunt-cli

ln -s node-v6.9.5-linux-x64/lib/node_modules/grunt-cli/bin/grunt /usr/bin/grunt

cd /var/lib/elasticsearch

yum install -y git

git clone git://github.com/mobz/elasticsearch-head.git

chown -R elasticsearch:elasticsearch elasticsearch-head/

cd /var/lib/elasticsearch/elasticsearch-head/

npm install

cd /var/lib/elasticsearch/elasticsearch-head/_site/

cp app.js app.js.bak

vim app.js

init: function(parent) {

this._super();

this.prefs = services.Preferences.instance();

this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://192.168.217.131:9200"; //修改4328行

cd /var/lib/elasticsearch/elasticsearch-head/

cp Gruntfile.js Gruntfile.js.bak

vim Gruntfile.js

connect: {

server: {

options: {

hostname: "0.0.0.0", //添加这一行

port: 9100,

base: '.',

keepalive: true

}

}

}

systemctl start elasticsearch.service

grunt server &

netstat -anplut //检查9200,9300,9100端口

打开浏览器,进行验证

访问http://192.168.217.131:9200/进行验证

访问http://192.168.217.131:9100/进行验证

没安装logstash和kibana时,划红线部分是空白。

4)安装kibana

grep -v ^# /etc/kibana/kibana.yml

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.url: "http://192.168.217.131:9200"

systemctl start kibana

浏览器访问验证

访问http://192.168.217.131:5601/

5)安装logstash

grep -v "#" /etc/logstash/logstash.yml

path.data: /var/lib/logstash

path.config: /etc/logstash/conf.d

path.logs: /var/log/logstash

6)编写logstash配置文件

Logstash 工作的三个阶段:

input 数据输入端,可以接收来自任何地方的源数据。

Filter 数据中转层,主要进行格式处理,数据类型转换、数据过滤、字段添加,修改等,常用的过滤器如下。

output 是logstash工作的最后一个阶段,负责将数据输出到指定位置,兼容大多数应用,常用的有:

可以通过网站测试匹配解析格式:https://grokdebug.herokuapp.com/和http://grokconstructor.appspot.com/do/match(需×××)

网站随机示例:

10.121.123.104 - - [01/Nov/2012:21:01:04 +0100] "GET /cluster HTTP/1.1" 200 1272

10.121.123.104 - - [01/Nov/2012:21:01:17 +0100] "GET /cpc/auth.do?loginsetup=true&targetPage=%2Fcpc%2F HTTP/1.1" 302 466

10.121.123.104 - - [01/Nov/2012:21:01:18 +0100] "GET /cpc?loginsetup=true&targetPage=%252Fcpc%252F HTTP/1.1" 302 -

10.121.123.104 - - [01/Nov/2012:21:01:18 +0100] "GET /cpc/auth.do?loginsetup=true&targetPage=%25252Fcpc%25252F&loginsetup=true HTTP/1.1" 302 494

^%{IPORHOST:clientip} (?:-|%{USER:ident}) (?:-|%{USER:auth}) \[%{HTTPDATE:timestamp}\] \"(?:%{WORD:verb} %{NOTSPACE:request}(?: HTTP/%{NUMBER:httpversion})?|-)\" %{NUMBER:response} (?:-|%{NUMBER:bytes})

快速测试用例(系统日志为例):

vim /etc/logstash/conf.d/messages.conf

input {

file {

path => "/var/log/messages"

}

}

output {

elasticsearch {

hosts => ["192.168.217.131:9200","192.168.217.132:9200"]

index => "messages-%{+YYYY.MM.dd}"

}

}

cd ..

chown -R logstash:logstash conf.d/

chmod 644 /var/log/messages

etc/logstash/bin/logstash -f messages.conf

访问http://192.168.217.131:9200/,查看是否有messages开头的索引产生

7)kibana添加数据

添加messages-*,然后点击Discover,如果不能显示图形,请把时间选择一小时或更长。

三、报错记录

(1)

WARNING: Could not find logstash.yml which is typically located in $LS_HOME/config or /etc/logstash. You can specify the path using --path.settings. Continuing using the defaults

Could not find log4j2 configuration at path /usr/share/logstash/config/log4j2.properties. Using default config which logs to console

logstash可以启动,但此种验证方式会有告警,可以提示方式处理,在“$LS_HOME”下建立“config”目录,并将”/etc/logstash/”下的文件建软链接到“config”目录,再次执行即可,如下:

mkdir -p /usr/share/logstash/config/

ln -s /etc/logstash/* /usr/share/logstash/config

chown -R logstash:logstash /usr/share/logstash/config/

bin/logstash -e 'input { stdin { } } output { stdout {} }'

(2)

Logstash could not be started because there is already another instance using the configured data directory. If you wish to run multiple instances, you must change the "path.data" setting

将原先的命令:

/bin/logstash -f 010.conf

改为:

/bin/logstash -f 010.conf --path.data=/root/