- 【iOS】MVC设计模式

Magnetic_h

iosmvc设计模式objective-c学习ui

MVC前言如何设计一个程序的结构,这是一门专门的学问,叫做"架构模式"(architecturalpattern),属于编程的方法论。MVC模式就是架构模式的一种。它是Apple官方推荐的App开发架构,也是一般开发者最先遇到、最经典的架构。MVC各层controller层Controller/ViewController/VC(控制器)负责协调Model和View,处理大部分逻辑它将数据从Mod

- UI学习——cell的复用和自定义cell

Magnetic_h

ui学习

目录cell的复用手动(非注册)自动(注册)自定义cellcell的复用在iOS开发中,单元格复用是一种提高表格(UITableView)和集合视图(UICollectionView)滚动性能的技术。当一个UITableViewCell或UICollectionViewCell首次需要显示时,如果没有可复用的单元格,则视图会创建一个新的单元格。一旦这个单元格滚动出屏幕,它就不会被销毁。相反,它被添

- c++ 的iostream 和 c++的stdio的区别和联系

黄卷青灯77

c++算法开发语言iostreamstdio

在C++中,iostream和C语言的stdio.h都是用于处理输入输出的库,但它们在设计、用法和功能上有许多不同。以下是两者的区别和联系:区别1.编程风格iostream(C++风格):C++标准库中的输入输出流类库,支持面向对象的输入输出操作。典型用法是cin(输入)和cout(输出),使用>操作符来处理数据。更加类型安全,支持用户自定义类型的输入输出。#includeintmain(){in

- ios GCD

_Waiting_

1.GCD任务和队列学习GCD之前,先来了解GCD中两个核心概念:任务和队列。任务:就是执行操作的意思,换句话说就是你在线程中执行的那段代码。在GCD中是放在block中的。执行任务有两种方式:同步执行(sync)和异步执行(async)。两者的主要区别是:是否等待队列的任务执行结束,以及是否具备开启新线程的能力。同步执行(sync):同步添加任务到指定的队列中,在添加的任务执行结束之前,会一直等

- iOS内存管理简单理解

烧烤有点辣

什么是引用计数引用计数(ReferenceCount)是一个简单而有效的管理对象生命周期的方式。当我们创建一个新对象的时候,它的引用计数为1,当有一个新的指针指向这个对象时,我们将其引用计数加1,当某个指针不再指向这个对象是,我们将其引用计数减1,当对象的引用计数变为0时,说明这个对象不再被任何指针指向了,这个时候我们就可以将对象销毁,回收内存。由于引用计数简单有效,除了Objective-C和S

- pyhon+ffmpeg 常用音视频处理命令

不再游移

ffmpeg音视频python

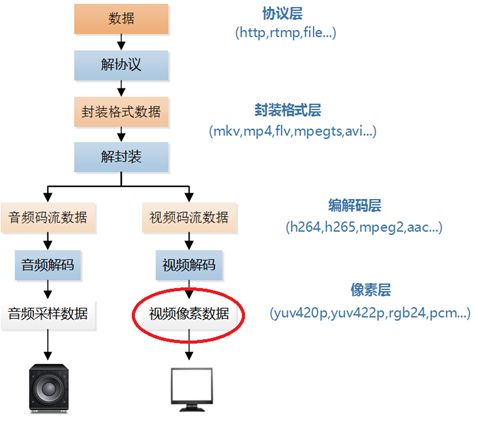

FFmpeg是多媒体领域的万能工具。只要涉及音视频领域的处理,基本上没有它做不了的事情!通俗点讲,从视频录制、视频编辑再到播放,它都能做!前段时间做了个短视频自动化脚本项目,需要自动处理音视频(包括一些合成、拼接、转场、调色等等),当时做的时候找各种命令还是很痛苦的,因此对用到的所有处理命令做了个汇总,方便以后使用。目录一、获取音频时长二、获取视频信息三、获取视频时长四、多个视频合并五、视频提取视

- Go语言基础总结

Alice_小哪吒

Go学习笔记golang开发语言后端

一、Go语言结构包声明引入包函数变量语句&表达式注释下面简单给出hello.go文件。packagesrc/*定义包名*/import"fmt"/*引入包*/funchello(){/*函数*/fmt.Println("Hello,World!")/*语句&表达式*/fmt.Println("菜鸟教程:runoob.com")}二、Go语言基础语法Go程序可以由多个标记构成。可以是关键字、标识符、

- Vue + Express实现一个表单提交

九旬大爷的梦

最近在折腾一个cms系统,用的vue+express,但是就一个表单提交就弄了好久,记录一下。环境:Node10+前端:Vue服务端:Express依赖包:vueexpressaxiosexpress-formidableelement-ui(可选)前言:axiosget请求参数是:paramsaxiospost请求参数是:dataexpressget接受参数是req.queryexpresspo

- iOS下拉放大效果

RobinZhao

好多下拉放大的实现方式是在tableView上面添加一个view,同时更改tableView.contentInset,下拉时改变view的frame来实现。今天用另外一种方式实现,效果如下:加油.gif具体实现方法:通过tableViewCell结合xib来实现,具体代码如下HomeViewController.m代码#import"HomeViewController.h"#import"He

- 音视频知识图谱 2022.04

关键帧Keyframe

前些时间,我在知识星球上创建了一个音视频技术社群:关键帧的音视频开发圈,在这里群友们会一起做一些打卡任务。比如:周期性地整理音视频相关的面试题,汇集一份音视频面试题集锦,你可以看看《音视频面试题集锦2022.04》。再比如:循序渐进地归纳总结音视频技术知识,绘制一幅音视频知识图谱。下面是2022.04月知识图谱新增的内容节选:1)图谱路径:**采集/音频采集/声音三要素/响度******主观计量响

- axios 请求封装

web Rookie

工作前端javascriptajax

文章目录1.前言2.axios下载3.代码实现4.实际使用1.前言本文是对于axios的二次封装处理,axios是一个基于Promise的网络请求库,作用于node.js和浏览器中;本文对于axios中的封装着重于直接使用,如果想要学习axios相关知识可以先行离开,后续在对其进行完善2.axios下载npminstallaxios3.代码实现//request.tsimportaxios,{Ax

- 函数可以返回数组吗?有哪3种返回方法呢?如代码种的func2、func3、func4都可以返回数组。func1为什么会报错呢?关于返回数组需要注意哪些呢?

神笔馬良

java算法数据结构

问题描述:根据下列代码回答下列问题。//Createdby黑马程序员.#include"iostream"usingnamespacestd;/**函数返回数组,就是返回指针,要注意:*-不可返回局部数组(在函数内创建的数组),如果要返回需要*-static修饰*-动态内存创建(new[]、delete[])*-返回全局(在函数外创建的对象)**不推荐函数返回数组,因为要么手动delete、要么s

- 【物联网技术大作业】设计一个智能家居的应用场景

Dream_Chaser~

期末复习智能家居物联网技术期末大作业

前言:本人的物联网技术的期末大作业,希望对你有帮助。目录大作业设计题(1)智能家居的概述。(2)介绍智能家居应用。要求至少5个方面的应用,包括每个应用所采用的设备,性能,功能。(3)画出智能家居应用图,并设计使用。大作业设计题设计一个智能家居的应用场景。要求:(1)智能家居的概述。答:智能家居,又称为智能住宅或家庭自动化,是指运用综合布线、网络通信、安全防范、自动控制及音视频等技术,将家居设施集成

- ios私钥证书(p12)导入失败,Windows OpenSSl 1.1.1 下载

书边事.

其他

ios私钥证书(p12)导入失败如果你用的OpenSSL版本是v3那么恭喜你V3必然报这个错,解决办法将OpenSSL3降低成v1。WindowsOpenSSl1.1.1下载阿里云网盘下载地址:OpenSSLV1

- 网上商城项目总结报告

WEB前端程序贵

前端

网上商城项目总结报告1:掌握的知识通过网上商城这个实战项目的开发,不仅了解到了一个项目的业务逻辑,而且掌握了实现相关业务功能的方法。通过这个实战项目,了解到了模块化开发项目的基础结构的搭建,以及项目文件的管理方式。通过这个实战项目,运用封装的接口api文档实现了客户端服务器之间的交互知识。通过封装的axios实例对象与方法,向服务器请求数据,然后渲染页面。通过运用localStorage本地储存的

- 抖音视频搬运如何才能不违规?抖音搬运视频违规有什么后果?

氧惠导师

在抖音平台中搬运短视频的人非常多,经常能看到一些视频,别的平台中也会出现,但是又会有所不一样,其实是进行了二次编辑,那么抖音搬运视频怎么做才不会违规呢?➤推荐网购薅羊毛app“氧惠”,一个领隐藏优惠券+现金返利的平台。氧惠只提供领券返利链接,下单全程都在淘宝、京东、拼多多等原平台,更支持抖音、快手电商、外卖红包返利等。(应用市场搜“氧惠”下载,邀请码:521521,全网优惠上氧惠!)➤由于信息差的

- Linux dmesg命令:显示开机信息

fafadsj666

linux数据库数据挖掘机器学习大数据

通过学习《Linux启动管理》一章可以知道,在系统启动过程中,内核还会进行一次系统检测(第一次是BIOS进行加测),但是检测的过程不是没有显示在屏幕上,就是会快速的在屏幕上一闪而过那么,如果开机时来不及查看相关信息,我们是否可以在开机后查看呢?答案是肯定的,使用dmesg命令就可以。无论是系统启动过程中,还是系统运行过程中,只要是内核产生的信息,都会被存储在系统缓冲区中,已经为大家精心准备了大数据

- (小白入门)Windows环境下搭建React Native Android开发环境

码农老黑

前端ReactNative移动开发Androidstudio

ReactNative(简称RN)是Facebook于2015年4月开源的跨平台移动应用开发框架,是Facebook早先开源的UI框架React在原生移动应用平台的衍生产物,目前支持iOS和Android两大平台。RN的环境搭建在RN的中文社区有所介绍,但是对于小白来说还是有些太过简略了。RN中文社区详见参考,本文不涉及的问题也许在其中能够有所解答。ReactNative思想底层引擎是JavaSc

- 招银网络&大疆&元象一面

Redstone Monstrosity

前端面试

1.请尽可能详细地说明,XHR、axios和fetch这三者的区别是什么?axios和fetch的底层实现是什么?axios拦截器是什么?axios提供了哪些配置或功能,是fetch和XHR中没有的?你的回答中不要写出示例代码。XHR、axios和fetch的区别XHR(XMLHttpRequest)历史:XHR是最早的AJAX技术,由微软在1999年引入,后来被标准化。兼容性:几乎所有现代浏览器

- 思科路由器交换机密码破解过程详解

zhane_hao

路由启动过程加电自检(POST)加载bootstrap代码检查配置寄存器寻找CiscoIOS加载CiscoIOS寻找配置文件加载配置文件若没有配置文件,进入Setup模式,进行初始化配置运行路由器操作系统查看命令•showversion:检查配置寄存器的值,硬件配置,IOS版本•showflash:检查Flash中的IOS,或是flash大小,使用情况(占用多少,剩下多少)•showstartup

- 定制优化Nextcloud镜像

攻城狮_正

Nextcloud是一款开源免费的私有云存储网盘项目,可以让你快速便捷地搭建一套属于自己或团队的云同步网盘,从而实现跨平台跨设备文件同步、共享、版本控制、团队协作等功能。它的客户端覆盖了Windows、Mac、Android、iOS、Linux等各种平台,也提供了网页端以及WebDAV接口,所以你几乎可以在各种设备上方便地访问你的云盘。Nextcloud基于PHP语言开发,可以使用Nginx+PH

- iOS使用SDWebview加载图片失败?

AnderQZ

今天调试遇到一个很无奈的问题,就是出现了image无法加载出来。最后才发现是图片使用了中文命名,真TM的坑!SDWebimage没办法识别中文,必须要encode才行!

- Dev-C++头文件小Bug

蒟蒻pzjdsg666

bugc语言c++

Dev-C++应该是大家最常用的C++软件了吧,但它有几个小Bug。1、“万能头”众所周知,“万能头”在官方比赛中不能使用(你要用没人拦着你~呵呵),但在Dev-C++可以使用。所以,我们可以省掉好多头文件!如下:#includeusingnamespacestd;2、C语言头文件在Dev-C++中,你竟然可以使用C语言头文件(惊不惊喜~意不意外~)如下:#include3、iostream竟然包

- vue axios跨域访问相关问题 | axios默认发送‘application/x-www-form-urlencoded‘格式数据 | Content-Type is not allowed b

就是爱吃肉ro

#Vue&uni-appaxiosajaxcors跨域vuex-www-form-url

文章目录概述报错1Content-TypeisnotallowedbyAccess-Control-Allow-Headersinpreflightrespon报错2返回状态码500好久没更博客了,最近一直搞框架搞项目,好多问题也都没有记录下来…好吧,那从今天起来,继续开始保持记录的好习惯,先写一下在axios上踩下了这么多坑.概述通过以下两个报错,来介绍解决使用axios来进行网络请求中的遇到的

- html ios 滚动条隐藏,CSS溢出滚动和隐藏滚动条(iOS)

社长从来不假装

htmlios滚动条隐藏

6个答案:答案0:(得分:5)我只是玩了这个codepen(https://codepen.io/devstreak/pen/dMYgeO),看来如果你为下面的所有三个属性设置background-color到transparent,滚动(在这个例子中)同时删除box-shadows),根本看不到滚动条:#style-1::-webkit-scrollbar-track{//-webkit-box

- vue axios 如何读取项目下的json文件

战族狼魂

前端vue.jsjsonjavascript

在Vue项目中,使用axios读取本地的JSON文件可以通过将JSON文件放置在public目录中,然后通过axios发起请求读取。步骤:将JSON文件放置在public目录下:Vue项目中的public目录是静态资源目录,项目编译后这些文件可以通过URL直接访问。将你的JSON文件,比如data.json,放在public目录中。使用axios读取JSON文件:在你的Vue组件中,通过axios

- WebRTC之LiveKit的基础入门使用(入门必看)

tabzzz

前端webrtcweb3typescript

LiveKit本文主要是讲解在Next13+中如何使用LiveKit来实现简单的音视频通话,想了解更多的还是要去官方文档去掌握更复杂、高级的使用方法。什么是LiveKitLiveKit是一个开源的实时通信平台,基于WebRTC,主要用于构建高质量的音视频通话、实时数据传输和互动应用。LiveKit除了方便以外的大优势就是它提供了丰富的API和SDK,支持多种平台,包括Web、iOS、Android

- 2K价位的手机还有这些神仙功能,绿厂ColorOS系统yyds

机测女孩

有一个有趣的现象,即使到了2021年,苹果手机在硬件技术上已经被安卓阵营大幅领先,但依然有大批的粉丝为了体验iOS趋之若鹜,可见用户对于手机系统的看重并不亚于参数配置。近年来,不少国产品牌的手机明显意识到了这一点,在堆砌参数的同时也非常重视系统的构建与优化,诸如华为、OPPO等手机品牌在整体系统体验大幅上升。就拿我手上的2k价位的OPPOA96来说,作为一款价格相当亲民的中端机型,其系统体验上却完

- Cocos2d、Cocos2dx、Cocos Creator、Cocos Studio的区别

Thomas游戏圈

一、Cocos2d和Cocos2dx的区别【开发语言】:Cocos2d是Object-C写的,Cocos2dx是C++写的,支持使用C++、Lua或Java进行开发。【运行平台】:Cocos2d只能在IOS下运行,Cocos2dx是跨平台的,适配iOS、Android、HTML5、Windows和Mac系统,功能侧重于原生移动平台。点击链接加入群聊【Unity/Cocos交流群】【国籍】:Coco

- iOS GCD底层分析(2)--同步异步函数、死锁、GCD单例

冼同学

前言上一篇文章iOSGCD底层分析(1)留下了四个问题,分别是:死锁底层是怎么样子产生的?如果是异步函数,线程是怎样子创建的?底层通过_dispatch_worker_thread2方法完成任务的回调执行,那么触发调用的位置在哪?单例的底层原理是什么?准备工作libdispatch.dylibiOSGCD底层分析(1)1.同步函数上一篇文章中分系同步函数时进入了_dispatch_sync_f_i

- 解线性方程组

qiuwanchi

package gaodai.matrix;

import java.util.ArrayList;

import java.util.List;

import java.util.Scanner;

public class Test {

public static void main(String[] args) {

Scanner scanner = new Sc

- 在mysql内部存储代码

annan211

性能mysql存储过程触发器

在mysql内部存储代码

在mysql内部存储代码,既有优点也有缺点,而且有人倡导有人反对。

先看优点:

1 她在服务器内部执行,离数据最近,另外在服务器上执行还可以节省带宽和网络延迟。

2 这是一种代码重用。可以方便的统一业务规则,保证某些行为的一致性,所以也可以提供一定的安全性。

3 可以简化代码的维护和版本更新。

4 可以帮助提升安全,比如提供更细

- Android使用Asynchronous Http Client完成登录保存cookie的问题

hotsunshine

android

Asynchronous Http Client是android中非常好的异步请求工具

除了异步之外还有很多封装比如json的处理,cookie的处理

引用

Persistent Cookie Storage with PersistentCookieStore

This library also includes a PersistentCookieStore whi

- java面试题

Array_06

java面试

java面试题

第一,谈谈final, finally, finalize的区别。

final-修饰符(关键字)如果一个类被声明为final,意味着它不能再派生出新的子类,不能作为父类被继承。因此一个类不能既被声明为 abstract的,又被声明为final的。将变量或方法声明为final,可以保证它们在使用中不被改变。被声明为final的变量必须在声明时给定初值,而在以后的引用中只能

- 网站加速

oloz

网站加速

前序:本人菜鸟,此文研究总结来源于互联网上的资料,大牛请勿喷!本人虚心学习,多指教.

1、减小网页体积的大小,尽量采用div+css模式,尽量避免复杂的页面结构,能简约就简约。

2、采用Gzip对网页进行压缩;

GZIP最早由Jean-loup Gailly和Mark Adler创建,用于UNⅨ系统的文件压缩。我们在Linux中经常会用到后缀为.gz

- 正确书写单例模式

随意而生

java 设计模式 单例

单例模式算是设计模式中最容易理解,也是最容易手写代码的模式了吧。但是其中的坑却不少,所以也常作为面试题来考。本文主要对几种单例写法的整理,并分析其优缺点。很多都是一些老生常谈的问题,但如果你不知道如何创建一个线程安全的单例,不知道什么是双检锁,那这篇文章可能会帮助到你。

懒汉式,线程不安全

当被问到要实现一个单例模式时,很多人的第一反应是写出如下的代码,包括教科书上也是这样

- 单例模式

香水浓

java

懒汉 调用getInstance方法时实例化

public class Singleton {

private static Singleton instance;

private Singleton() {}

public static synchronized Singleton getInstance() {

if(null == ins

- 安装Apache问题:系统找不到指定的文件 No installed service named "Apache2"

AdyZhang

apachehttp server

安装Apache问题:系统找不到指定的文件 No installed service named "Apache2"

每次到这一步都很小心防它的端口冲突问题,结果,特意留出来的80端口就是不能用,烦。

解决方法确保几处:

1、停止IIS启动

2、把端口80改成其它 (譬如90,800,,,什么数字都好)

3、防火墙(关掉试试)

在运行处输入 cmd 回车,转到apa

- 如何在android 文件选择器中选择多个图片或者视频?

aijuans

android

我的android app有这样的需求,在进行照片和视频上传的时候,需要一次性的从照片/视频库选择多条进行上传

但是android原生态的sdk中,只能一个一个的进行选择和上传。

我想知道是否有其他的android上传库可以解决这个问题,提供一个多选的功能,可以使checkbox之类的,一次选择多个 处理方法

官方的图片选择器(但是不支持所有版本的androi,只支持API Level

- mysql中查询生日提醒的日期相关的sql

baalwolf

mysql

SELECT sysid,user_name,birthday,listid,userhead_50,CONCAT(YEAR(CURDATE()),DATE_FORMAT(birthday,'-%m-%d')),CURDATE(), dayofyear( CONCAT(YEAR(CURDATE()),DATE_FORMAT(birthday,'-%m-%d')))-dayofyear(

- MongoDB索引文件破坏后导致查询错误的问题

BigBird2012

mongodb

问题描述:

MongoDB在非正常情况下关闭时,可能会导致索引文件破坏,造成数据在更新时没有反映到索引上。

解决方案:

使用脚本,重建MongoDB所有表的索引。

var names = db.getCollectionNames();

for( var i in names ){

var name = names[i];

print(name);

- Javascript Promise

bijian1013

JavaScriptPromise

Parse JavaScript SDK现在提供了支持大多数异步方法的兼容jquery的Promises模式,那么这意味着什么呢,读完下文你就了解了。

一.认识Promises

“Promises”代表着在javascript程序里下一个伟大的范式,但是理解他们为什么如此伟大不是件简

- [Zookeeper学习笔记九]Zookeeper源代码分析之Zookeeper构造过程

bit1129

zookeeper

Zookeeper重载了几个构造函数,其中构造者可以提供参数最多,可定制性最多的构造函数是

public ZooKeeper(String connectString, int sessionTimeout, Watcher watcher, long sessionId, byte[] sessionPasswd, boolea

- 【Java命令三】jstack

bit1129

jstack

jstack是用于获得当前运行的Java程序所有的线程的运行情况(thread dump),不同于jmap用于获得memory dump

[hadoop@hadoop sbin]$ jstack

Usage:

jstack [-l] <pid>

(to connect to running process)

jstack -F

- jboss 5.1启停脚本 动静分离部署

ronin47

以前启动jboss,往各种xml配置文件,现只要运行一句脚本即可。start nohup sh /**/run.sh -c servicename -b ip -g clustername -u broatcast jboss.messaging.ServerPeerID=int -Djboss.service.binding.set=p

- UI之如何打磨设计能力?

brotherlamp

UIui教程ui自学ui资料ui视频

在越来越拥挤的初创企业世界里,视觉设计的重要性往往可以与杀手级用户体验比肩。在许多情况下,尤其对于 Web 初创企业而言,这两者都是不可或缺的。前不久我们在《右脑革命:别学编程了,学艺术吧》中也曾发出过重视设计的呼吁。如何才能提高初创企业的设计能力呢?以下是 9 位创始人的体会。

1.找到自己的方式

如果你是设计师,要想提高技能可以去设计博客和展示好设计的网站如D-lists或

- 三色旗算法

bylijinnan

java算法

import java.util.Arrays;

/**

问题:

假设有一条绳子,上面有红、白、蓝三种颜色的旗子,起初绳子上的旗子颜色并没有顺序,

您希望将之分类,并排列为蓝、白、红的顺序,要如何移动次数才会最少,注意您只能在绳

子上进行这个动作,而且一次只能调换两个旗子。

网上的解法大多类似:

在一条绳子上移动,在程式中也就意味只能使用一个阵列,而不使用其它的阵列来

- 警告:No configuration found for the specified action: \'s

chiangfai

configuration

1.index.jsp页面form标签未指定namespace属性。

<!--index.jsp代码-->

<%@taglib prefix="s" uri="/struts-tags"%>

...

<s:form action="submit" method="post"&g

- redis -- hash_max_zipmap_entries设置过大有问题

chenchao051

redishash

使用redis时为了使用hash追求更高的内存使用率,我们一般都用hash结构,并且有时候会把hash_max_zipmap_entries这个值设置的很大,很多资料也推荐设置到1000,默认设置为了512,但是这里有个坑

#define ZIPMAP_BIGLEN 254

#define ZIPMAP_END 255

/* Return th

- select into outfile access deny问题

daizj

mysqltxt导出数据到文件

本文转自:http://hatemysql.com/2010/06/29/select-into-outfile-access-deny%E9%97%AE%E9%A2%98/

为应用建立了rnd的帐号,专门为他们查询线上数据库用的,当然,只有他们上了生产网络以后才能连上数据库,安全方面我们还是很注意的,呵呵。

授权的语句如下:

grant select on armory.* to rn

- phpexcel导出excel表简单入门示例

dcj3sjt126com

PHPExcelphpexcel

<?php

error_reporting(E_ALL);

ini_set('display_errors', TRUE);

ini_set('display_startup_errors', TRUE);

if (PHP_SAPI == 'cli')

die('This example should only be run from a Web Brows

- 美国电影超短200句

dcj3sjt126com

电影

1. I see. 我明白了。2. I quit! 我不干了!3. Let go! 放手!4. Me too. 我也是。5. My god! 天哪!6. No way! 不行!7. Come on. 来吧(赶快)8. Hold on. 等一等。9. I agree。 我同意。10. Not bad. 还不错。11. Not yet. 还没。12. See you. 再见。13. Shut up!

- Java访问远程服务

dyy_gusi

httpclientwebservicegetpost

随着webService的崛起,我们开始中会越来越多的使用到访问远程webService服务。当然对于不同的webService框架一般都有自己的client包供使用,但是如果使用webService框架自己的client包,那么必然需要在自己的代码中引入它的包,如果同时调运了多个不同框架的webService,那么就需要同时引入多个不同的clien

- Maven的settings.xml配置

geeksun

settings.xml

settings.xml是Maven的配置文件,下面解释一下其中的配置含义:

settings.xml存在于两个地方:

1.安装的地方:$M2_HOME/conf/settings.xml

2.用户的目录:${user.home}/.m2/settings.xml

前者又被叫做全局配置,后者被称为用户配置。如果两者都存在,它们的内容将被合并,并且用户范围的settings.xml优先。

- ubuntu的init与系统服务设置

hongtoushizi

ubuntu

转载自:

http://iysm.net/?p=178 init

Init是位于/sbin/init的一个程序,它是在linux下,在系统启动过程中,初始化所有的设备驱动程序和数据结构等之后,由内核启动的一个用户级程序,并由此init程序进而完成系统的启动过程。

ubuntu与传统的linux略有不同,使用upstart完成系统的启动,但表面上仍维持init程序的形式。

运行

- 跟我学Nginx+Lua开发目录贴

jinnianshilongnian

nginxlua

使用Nginx+Lua开发近一年的时间,学习和实践了一些Nginx+Lua开发的架构,为了让更多人使用Nginx+Lua架构开发,利用春节期间总结了一份基本的学习教程,希望对大家有用。也欢迎谈探讨学习一些经验。

目录

第一章 安装Nginx+Lua开发环境

第二章 Nginx+Lua开发入门

第三章 Redis/SSDB+Twemproxy安装与使用

第四章 L

- php位运算符注意事项

home198979

位运算PHP&

$a = $b = $c = 0;

$a & $b = 1;

$b | $c = 1

问a,b,c最终为多少?

当看到这题时,我犯了一个低级错误,误 以为位运算符会改变变量的值。所以得出结果是1 1 0

但是位运算符是不会改变变量的值的,例如:

$a=1;$b=2;

$a&$b;

这样a,b的值不会有任何改变

- Linux shell数组建立和使用技巧

pda158

linux

1.数组定义 [chengmo@centos5 ~]$ a=(1 2 3 4 5) [chengmo@centos5 ~]$ echo $a 1 一对括号表示是数组,数组元素用“空格”符号分割开。

2.数组读取与赋值 得到长度: [chengmo@centos5 ~]$ echo ${#a[@]} 5 用${#数组名[@或

- hotspot源码(JDK7)

ol_beta

javaHotSpotjvm

源码结构图,方便理解:

├─agent Serviceab

- Oracle基本事务和ForAll执行批量DML练习

vipbooks

oraclesql

基本事务的使用:

从账户一的余额中转100到账户二的余额中去,如果账户二不存在或账户一中的余额不足100则整笔交易回滚

select * from account;

-- 创建一张账户表

create table account(

-- 账户ID

id number(3) not null,

-- 账户名称

nam