四、SMO算法

4.1 坐标上升法

SMO算法的两步是从坐标上升法引申出来的,所以这里先介绍一下坐标上升法。

假设要求解下面的优化问题:

这里W是 α 向量的函数。之前我们在回归中提到过两种求最优解的方法,一种是梯度下降法,另外一种是牛顿法。现在我们再讲一种方法称为坐标上升法(求解最小值问题时,称作坐标下降法,原理一样)。

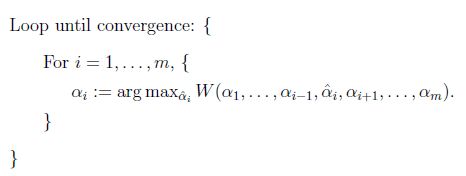

方法过程:

一、最里面语句的意思是固定除 αi 以外的所有 αj(j≠i),此时 ,W可看做只是关于αi的函数,所以直接对αi进行求导优化即可。

二、这里,我们进行最大化求导的顺序i是从1到m,可以通过更改优化顺序来使W能够更快地增加并收敛。如果W在内循环中能够很快地达到最优,那么坐标上升法会是一个很高效的求极值方法。

这里通过一个二维向量进行展示。

椭圆代表了二次函数的各个等高线,变量数为2,起始坐标是(2,-2)。图中的直线式迭代优化的路径,可以看到每一步都会向最优值前进一步,而且前进路线是平行于坐标轴的,因为每一步只优化一个变量。

4.2 SMO算法

SMO算法是很快的二次规划优化算法。

和上面的坐标上升法的两点是能够对应起来的:

一、在SMO算法中,因为受等式αi yi =0的约束,如果只固定一个αi,那这个αi就不会是变量了。所以,我们选取两个参数假设为:α1和α2 ,固定其余参数。此时,α2 可以由α1 和其他参数表示出来,这样会带到W中,W就只是关于α1 的函数了。直接对α1 进行求导优化即可。

二、坐标上升法中可以通过更改优化顺序来使W能够更快地增加并收敛。同样,SMO算法中,通过挑选参数,确定参数的优化顺序,也能够使W来更快的收敛。这就是下面要讲的“启发式搜索了”。

这里也是按照上面这两个步骤讲解SMO算法

- 1、先讲解怎样更新αi(求导优化的过程)

- 2、再讲解怎么挑选参数αi(启发式搜索)

现在,终于可以求出 αi 了。回到上面的软间隔的最后的优化问题:

等价于求解:

1998 年,Microsoft Research 的John C. Platt 在论文《Sequential Minimal Optimization:A Fast Algorithm for Training Support Vector Machines》中提出针对上述问题的解法:SMO 算法,它很快便成为最快的二次规划优化算法,特别是在针对线性SVM 和数据稀疏时性能更优。

4.3 SMO算法的推导1,求解参数

咱们首先来定义特征到结果的输出函数:

注意,这个u 与我们之前定义的f(x) = wTx + b 的实质是一样的。

-----------------------------------------------------------------------------------------------------

为什么是选择两个参数,而不是想坐标上升法那样只选择一个参数,一次更新一个参数呢?

理由如下:

-----------------------------------------------------------------------------------------------------

因为此时,α1和α2是参数,其余的参数是固定住被看成常数的,所以上面式(3.29)可以表示为:

为了解决这个子问题,首要问题便是每次如何选取�1 和�2。实际上,其中一个乘子是违法KKT 条件最严重的,另外一个乘子则由另一个约束条件选取。

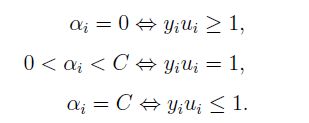

由上一篇(支持向量机2)文章可知,最后求得的最优解 α 向量一定是满足KKT条件的。即 :

但是,问题刚开始解,所以此时的 α 向量不是最优解,所以 α 向量里的一些参数,一定是不满足KKT条件的。比如下面这类 αi 就是不满足KKT条件的:

---------------------------------------------------------------------------------------------------------------------

假设,我们不断地挑出这些不满足条件的参数 αi 并更新他们,直到最后,α 向量里的所有参数都满足了KKT条件,那么不就意味着此时α 向量就是最优解了吗?

-------------------------------------------------------------------------------------------------------------------

------------------------------这算是挑选参数的一个标准了。-------------------------------

此外,更新的同时还要受到第二个约束条件的限制,即:

因为两个因子不好同时求解,所以可以先求的第二个乘子 α2 的解,得到一个新的参数αnew。再用 α2 的解(αnew)表示α1 的解。

但是,又有一个新的问题出现了:

原来,在一开始更改传统的拉格朗日公式时,添加了一个变化: αi ≥0

。后来,为了适应实际情况,变成了软间隔,αi 的取值范围有了变化,此时有0 ≤ αi ≤ C。也就是此时:

0 ≤ α1 ≤ C,0 ≤ α2 ≤ C

但是,现在又加入了一个约束条件:

所以此时,αi 的取值范围还是会有变化。因为说到先求α2,所以这里也是先假设 L ≤ α2new ≤ H.

也就是说,新的参数α2new 要同时满足上面两种约束条件。

此时因为截距的不同,这条直线有两种情况,

蓝线的情况下,L=0,H=C-ξ

红线的情况下,L=-ξ,H=C

当y1和y2同号时,是这两种情况:

综上,根据标签y1和y2同号或者异号,可得出新的参数α2new 上下界分别为:

s = y1y2

因此�1 可以用�2 表示,α1 = ω - sα2 ,于是可以把式(3.30)转换为只含有α2的的问题:

于是,可以求解α2了。

考虑到前面求得的新的参数α2new 上下界,这里求出的α2new也需要满足这个上下界才行:

求得了α2new ,便可求得α1new :

α1 = ω - sα2

4.4 SMO算法的推导2,选择参数

且每次更新完两个乘子的优化后,都需要再重新计算b,及对应的Ei 值。从而进行下次循环。

-----------------------------------------------------------------------------------------------

解目标函数时,这个目标函数,是需要计算m个样例的。

也就是说,有m个α,m个样例x(i),m个样例标签y(i)。

-----------------------------------------------------------------------------------------------

4.4 贴一下SMO算法的总结。

大致步骤: