此文主要介绍mac环境下,在eclipse中搭建hadoop2的开发环境,以编写mapreduce程序。

开发环境:

- mac os x 10.10

- eclipse

- hadoop2.6.0

- hadoop2x-eclipse-plugin

主要流程是先搭建hadoop的伪分布集群,当然也可以搭建真的集群环境。然后编译hadoop eclipse插件。最后配置eclipse并编写map reduce.

- hadoop2安装,这个网上资料挺多,分分钟可以在本机上搭个standlone的伪分布集群。

- 安装eclipse,自己可以到官网下载最新版的eclipse. 然后解压即安装。

- github上下载hadoop2x-eclipse-plugin. 并编译,拷贝到eclipse下面。注意,这里mac的eclipse home为.

/XXX/Eclipse.app/Contents/Eclipse.

mac下面app是一个文件夹。比如我的就是:

$ pwd

/Users/luke/dev/Eclipse.app/Contents/Eclipse

- 配置eclipse并编写mapreduce程序。着重介绍下这个。

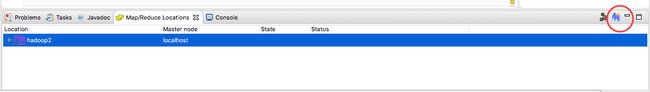

完成上面三步,装好插件后,打开eclipse. 现在你可以看到这个hadoop的console了。

现在,你需要创建一个location, 到时候你的程序就可以在上面跑了。点击小象图标。

map/reduce(V2) Master得和你mapred-site.xml里的配置相同,一般默认9001.

DFS Master得和你defaust fs配置相同,一般默认9000.

其他可以随意配置。

配置好后启动hadoop(start-all.sh),即可在eclipse里面refresh看到如下内容;

接下来创建一个mapreduce项目。并添加代码。

import java.io.IOException;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser;

public class FirstOne {

//map将输入中的value复制到输出数据的key上,并直接输出

public static class Map extends Mapper{

private static Text line=new Text();//每行数据

//实现map函数

public void map(Object key,Text value,Context context)

throws IOException,InterruptedException{

line=value;

context.write(line, new Text(""));

}

}

//reduce将输入中的key复制到输出数据的key上,并直接输出

public static class Reduce extends Reducer{

//实现reduce函数

public void reduce(Text key,Iterable values,Context context)

throws IOException,InterruptedException{

context.write(key, new Text(""));

}

}

public static void main(String[] args) throws Exception{

Configuration conf = new Configuration();

//这句话很关键,hdfs设置不成功默认用本地输入、输出

//conf.set("mapred.job.tracker", "localhost:9001");

conf.set("fs.default.name", "hdfs://localhost:9000");

String[] ioArgs=new String[]{"/input","/output"};

String[] otherArgs = new GenericOptionsParser(conf, ioArgs).getRemainingArgs();

if (otherArgs.length != 2) {

System.err.println("Usage: Data Deduplication ");

System.exit(2);

}

Job job = new Job(conf, "Data Deduplication");

job.setJarByClass(FirstOne.class);

//设置Map、Combine和Reduce处理类

job.setMapperClass(Map.class);

job.setCombinerClass(Reduce.class);

job.setReducerClass(Reduce.class);

//设置输出类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class);

//设置输入和输出目录

FileInputFormat.addInputPath(job, new Path(otherArgs[0]));

FileOutputFormat.setOutputPath(job, new Path(otherArgs[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

导入hadoop相关的jar文件。

这里请注意,导入以下目录下的所有库,不然可能程序里面没错了,但run的时候一堆依赖包找不到。

- $HADOOP_HOME/share/hadoop/common

- $HADOOP_HOME/share/hadoop/common/lib

- $HADOOP_HOME/share/hadoop/hdfs

- $HADOOP_HOME/share/hadoop/mapred

- $HADOOP_HOME/share/hadoop/yarn

你可以发现除common外其他目录下也有XX/lib,但他们都是从common/lib拷贝过去的,所以common/lib是必须的。

比如这种类型的错误就是库没导入完全造成的。

Exception in thread "main" java.lang.NoClassDefFoundError: org/apache/commons/logging/LogFactory

at org.apache.hadoop.conf.Configuration.(Configuration.java:173)

at FirstOne.main(FirstOne.java:40)

Caused by: java.lang.ClassNotFoundException: org.apache.commons.logging.LogFactory

at java.net.URLClassLoader.findClass(URLClassLoader.java:381)

at java.lang.ClassLoader.loadClass(ClassLoader.java:424)

at sun.misc.Launcher$AppClassLoader.loadClass(Launcher.java:331)

at java.lang.ClassLoader.loadClass(ClassLoader.java:357)

... 2 more

好了,接下来你可以run on hadoop了。选择你项目的那个application.

这里附上测试文件内容。

file1.txt

2012-3-1 a

2012-3-2 b

2012-3-3 c

2012-3-4 d

2012-3-5 a

2012-3-6 b

2012-3-7 c

2012-3-3 c

file2

2012-3-1 b

2012-3-2 a

2012-3-3 b

2012-3-4 d

2012-3-5 a

2012-3-6 c

2012-3-7 d

2012-3-3 c