- PySpark安装及WordCount实现(基于Ubuntu)

uui1885478445

ubuntulinux运维

在Ubuntu上安装PySpark并实现WordCount,需要以下步骤:安装PySpark:安装Java:PySpark需要Java运行环境。你可以使用以下命令安装OpenJDK:sudoaptupdatesudoaptinstalldefault-jredefault-jdk安装Scala:PySpark还需要Scala,可以使用以下命令安装:sudoaptinstallscala安装Pyth

- Redis 安装详细教程(小白版)

小小鸭程序员

springjavaAI编程springcloudredis

一、Windows系统安装Redis方法1:直接安装(推荐新手)下载RedisforWindows访问微软维护的Redis版本:https://github.com/microsoftarchive/redis/releases下载Redis-x64-3.2.100.msi(或最新版本)安装包。安装Redis双击下载的.msi文件点击下一步,勾选“AddRedisinstallationfolde

- Hive SQL 精进系列:REGEXP_REPLACE 函数的用法

进一步有进一步的欢喜

HiveSQL精进系列hivesqlhadoop

目录一、引言二、REGEXP_REPLACE函数基础2.1基本语法参数详解2.2简单示例三、REGEXP_REPLACE函数的应用场景3.1去除特殊字符3.2统一字符串格式四、REGEXP_REPLACE与REPLACE函数的对比4.1功能差异4.2适用场景五、REGEXP_REPLACE与REGEXP函数的对比5.1功能差异5.2适用场景六、总结一、引言字符串处理是数据处理中的常见需求,Hive

- Hive SQL 精进系列:SUBSTR 函数的多样用法

进一步有进一步的欢喜

HiveSQL精进系列hivesqlhadoop

目录一、引言二、SUBSTR函数基础介绍2.1基本语法2.2参数详解2.3简单示例三、SUBSTR函数常见应用场景3.1提取日期中的年份、月份或日期3.2隐藏部分敏感信息四、SUBSTR函数高级用法4.1结合条件判断动态截取4.2处理复杂字符串模式五、总结一、引言SUBSTR函数是HiveSQL中一个用于字符串截取的重要函数,在处理文本数据时发挥着关键作用。本文将全面且深入地介绍HiveSQL中S

- Hive----Hive进阶操作(三) HIVE 特殊分隔符处理

XiaodunLP

Hive

HIVE特殊分隔符处理补充:hive读取数据的机制:1、首先用InputFormat的一个具体实现类读入文件数据,返回一条一条的记录(可以是行,或者是你逻辑中的“行”)2、然后利用SerDe的一个具体实现类,对上面返回的一条一条的记录进行字段切割Hive对文件中字段的分隔符默认情况下只支持单字节分隔符,如果数据文件中的分隔符是多字符的,如下所示:01||huangbo02||xuzheng03||

- hive-进阶版-1

数据牧马人

hivehadoop数据仓库

第6章hive内部表与外部表的区别Hive是一个基于Hadoop的数据仓库工具,用于对大规模数据集进行数据存储、查询和分析。Hive支持内部表(ManagedTable)和外部表(ExternalTable)两种表类型,它们在数据存储、管理方式和生命周期等方面存在显著区别。以下是内部表和外部表的主要区别:1.数据存储位置内部表:数据存储在Hive的默认存储目录下,通常位于HDFS(HadoopDi

- NVIDIA下载老版本驱动/CUDA/Video Codec SDK的链接,以及一些解码参数说明

landihao

linux

NVIDIA下载老版本驱动/CUDA/VideoCodecSDK的链接从别的网站抄过来的CUDA:https://developer.nvidia.com/cuda-toolkit-archive老驱动:https://www.nvidia.cn/geforce/drivers/VideoCodecSDKhttps://developer.nvidia.com/video-codec-sdk-ar

- hive split 函数转义问题

进一步有进一步的欢喜

HiveSQL精进系列大数据

语法split(strstring,regexstring)--使用regex分割字符串str基本用法selectsplit('a,b,c,d',',')fromtemp_cwh_test;--分割--结果为数组>["a","b","c","d"]截取字符串中某个值selectsplit('a,b,c,d',',')[0]fromtemp_cwh_test;--提取第1个值>a特殊字符的处理针对特

- Hive SQL 精进系列:解锁 Hive SQL 中 KeyValue 函数的强大功能

进一步有进一步的欢喜

HiveSQL精进系列hivesqlhadoop

目录一、引言二、KeyValue函数基础2.1语法结构详解形式一:`keyvalue(string,[string,string,]string)`形式二:`keyvalue(string,string)`2.2参数详解2.3返回值规则三、丰富的应用场景3.1解析学生成绩信息3.2处理员工考勤数据3.3分析网站访问参数3.4提取设备配置信息四、使用注意事项4.1分隔符的准确性4.2空值处理4.3多

- 校招C++编程题练习

橙叔

学习c++数据结构算法

校招C++编程题练习1.基础准备2.基础数据结构概念,基本操作,以及优缺点等2.1[字符串操作(标准库,解析,匹配等)](https://leetcode-cn.com/explore/learn/card/array-and-string/)2.2[线性表(含数组,动态数组等)](https://leetcode-cn.com/explore/learn/card/array-and-strin

- 大数据手册(Spark)--Spark安装配置

WilenWu

数据分析(DataAnalysis)大数据spark分布式

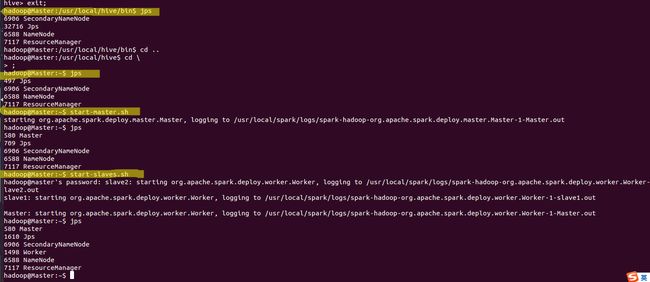

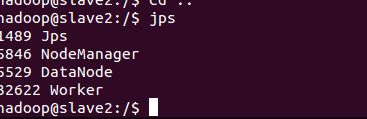

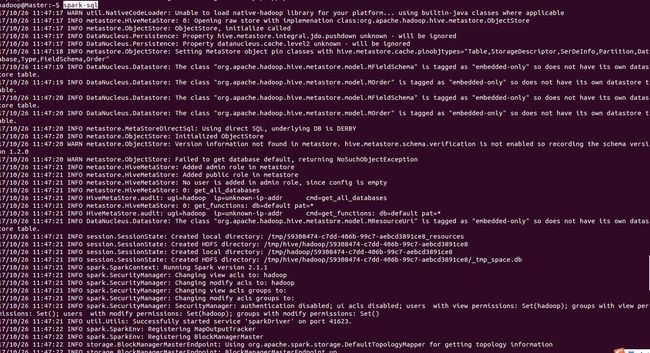

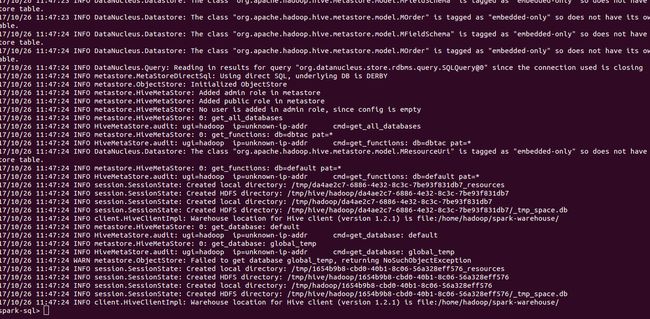

本文默认在zsh终端安装配置,若使用bash终端,环境变量的配置文件相应变化。若安装包下载缓慢,可复制链接到迅雷下载,亲测极速~准备工作Spark的安装过程较为简单,在已安装好Hadoop的前提下,经过简单配置即可使用。假设已经安装好了hadoop(伪分布式)和hive,环境变量如下JAVA_HOME=/usr/opt/jdkHADOOP_HOME=/usr/local/hadoopHIVE_HO

- 关于stable diffusion的lora训练在linux远程工作站的部署

回天一梦

stablediffusionpython经验分享

在学校Arc中部署loratraining,一大问题就是依赖缺失和冲突。可以利用miniconda或者anaconda建立虚拟环境来解决。安装anaconda或者miniconda(官网上也有教程):wgethttps://repo.anaconda.com/archive/Anaconda3-5.3.0-Linux-x86_64.shchmod+xAnaconda3-5.3.0-Linux-x8

- Hive SQL 精进系列:一行变多行的 LATERAL VIEW EXPLODE

进一步有进一步的欢喜

HiveSQL精进系列hivesqlhadoop

目录一、引言二、`LATERALVIEWEXPLODE`概述2.1基本概念2.2单词解析2.2.1`LATERAL`2.2.2`VIEW`2.2.3`EXPLODE`三、语法详解3.1基本语法结构3.2完整语法示例(针对映射情况)四、使用场景4.1数组数据展开4.2映射数据展开五、案例分析5.1展开数组示例5.1.1数据准备5.1.2使用`LATERALVIEWEXPLODE`展开数组5.1.3结

- YOLO11 环境安装

你喜欢喝可乐吗?

condadeeplearning人工智能conda

1.安装Anaconda/Miniconda在Ubuntu中安装MinicondaAnaconda/Minicondapip配置清华镜像源Anaconda/Miniconda基本操作命令2.创建python虚拟环境#创建condacreate-nyolo11_envpython=3.12#激活condaactivateyolo11_env3.安装pytorch#Pytorchhttps://pyt

- OpenCV | 图像读取与显示

ToBeCertain

OpenCVopencv人工智能计算机视觉

OpenCV对图像进行处理时,常用API如下:API描述cv.imread根据给定的磁盘路径加载对应的图像,默认使用BGR方式加载cv.imshow展示图像cv.imwrite将图像保存到磁盘中cv.waitKey暂停一段时间,接受键盘输出后,继续执行程序cv.destroyAllWindows释放所有资源目录一.OpenCV基本操作函数1.cv.imread()图像读取2.cv.imshow()

- 国内外AI搜索产品盘点

Suee2020

人工智能

序号AISearch产品名简介网站开发者1Perplexity强大的对话式AI搜索引擎https://www.perplexity.aiPerplexity2GensparkAIAgent搜索引擎https://www.genspark.aiMainFunc(景鲲、朱凯华)3Kimi.ai智能助手https://kimi.moonshot.cn/月之暗面(杨植麟)4秘塔AI搜索AI搜索引擎http

- python 人工智能实战案例

2401_86114612

pygamepythonjava

大家好,今天我们要分享,python编程人工智能小例子python人工智能100例子,一起探索吧!1.背景介绍概述在这个世纪,人类已经处于数字化的时代,而这也让很多其他行业都进入了数字化领域python列表有哪些基本操作,python列表功能很重要吗。其中包括游戏行业。游戏行业的蓬勃发展促使机器学习的产生,通过计算机能够进行高效率地模拟人类的学习、决策过程,不断升级提升人类的能力。游戏领域中的AI

- sql获取某列出现频次最多的值_业务硬核SQL集锦

金渡江

sql获取某列出现频次最多的值

戳上方蓝字关注我这两年学会了跑sql,当时有很多同学帮助我精进了这个技能,现在也写成一个小教程,反馈给大家。适用对象:工作中能接触到sql查询平台的业务同学(例如有数据查询权限的产品与运营同学)适用场景:查询hive&mysql上的数据文档优势:比起各类从零起步的教程教材,理解门槛低,有效信息密度大,可以覆盖高频业务场景。文末有一些常见的小技巧,希望帮助同学们提升工作效率。SQL的基础结构:做一个

- Hive SQL 精进系列: JSON_TUPLE 快速提取多键值

进一步有进一步的欢喜

HiveSQL精进系列hivesqlhadoop

目录一、引言二、json_tuple函数基础2.1基本语法参数解释返回值简单示例三、应用场景3.1数据提取与分析3.2数据集成与转换3.3复杂JSON数据处理四、json_tuple、get_json_object和from_json的对比4.1功能特点4.2语法和使用复杂度4.3性能表现4.4示例对比使用json_tuple使用get_json_object使用from_json五、使用注意事项

- hive sql报错

进一步有进一步的欢喜

大数据HiveSQL精进系列

1.hivesql报错FAILED:ParseExceptionline22:0cannotrecognizeinputnear''''''insubquerysource2.解决select*from(select...fromtable_1where...)table_outer嵌套的内层的表一定要有别名,也就是示例代码中的表名table_outer。

- HIVE开窗函数

Cciccd

sqlhive

ETL,SQL面试高频考点——HIVE开窗函数(基础篇)目录标题ETL,SQL面试高频考点——HIVE开窗函数(基础篇)一,窗口函数介绍二,开窗函数三,分析函数分类1,排序分析函数:实列解析对比总结2.聚合分析函数3.用spark自定义HIVE用户自定义函数后续更新中~一,窗口函数介绍窗口函数,也叫OLAP函数(OnlineAnallyticalProcessing,联机分析处理),可以对数据库数

- hive开窗函数总结

weixin_46134848

大数据hivemysql

文章目录概要整体架构流程示例1示例2小结概要hive开窗函数总结整体架构流程1.窗口函数的基本用法函数名()over()over关键字来指定函数执行的范围,包含三个分析子句:分组(partitionby)子句,排序(orderby)子句,窗口(rows)子句函数名(字段名)over(partitionbyorderbyrowsbetween)窗口大小可以通过rowsbetween…and…来限定,

- Hive MR & Spark & Yarn参数优化总结

大数据侠客

hive相关问题汇总及解决hivesparkmryarn参数优化

一、hivemr参数调优:sethive.optimize.ppd=true;--开启谓词下推。--动态分区参数sethive.exec.mode.local.auto=true;sethive.exec.dynamic.partition.mode=nonstrict;--默认是strict,表示至少有一个静态分区,nonstri

- hive 中优化性能的一些方法

闯闯桑

hivehadoop数据仓库

在ApacheHive中,性能优化是一个重要的课题,尤其是在处理大规模数据时。通过合理的优化方法,可以显著提升查询速度和资源利用率。以下是一些常见的Hive性能优化方法:1.数据存储优化1.1使用列式存储格式推荐格式:ORC和Parquet。优点:列式存储格式具有更高的压缩率和查询性能。支持谓词下推(PredicatePushdown)和列裁剪(ColumnPruning)。示例:CREATETA

- Go语言对于MySQL的基本操作

yz1.

Gogolangmysql开发语言

一.下载依赖终端中输入:goget-ugithub.com/go-sql-driver/mysql导入包import("database/sql"_"github.com/go-sql-driver/mysql")二.案例packagemain//goget-ugithub.com/go-sql-driver/mysql获取驱动import("database/sql""fmt"_"github.

- 虚拟机中Hadoop集群NameNode进程缺失问题解析与解决

申朝先生

hadoop大数据分布式linux

目录问题概述问题分析解决办法总结问题概述在虚拟机中运行Hadoop集群时,通过执行jps命令检查进程时,发现NameNode进程缺失。这通常会导致Hadoop集群无法正常运行,影响数据的存储和访问。问题分析导致NameNode进程缺失的原因可能有以下几点:集群未正确停止:在关闭虚拟机或重启Hadoop集群之前,未执行stop-all.sh命令正确停止集群,导致Hadoop服务异常退出,留下残留数据

- TDengine 使用教程:从入门到实践

遇见伯灵说

tdengine大数据时序数据库

TDengine是一款专为物联网(IoT)和大数据实时分析设计的时序数据库。它能够高效地处理海量的时序数据,并提供低延迟、高吞吐量的性能表现。在本文中,我们将带领大家从TDengine的安装、基本操作到一些高级功能,帮助你快速上手。1.TDengine简介TDengine是一个高效的时序数据存储解决方案,支持高并发写入和快速的实时分析。它适用于各种物联网应用场景,如传感器数据监控、日志数据处理等。

- Spark 中创建 DataFrame 的2种方式对比

闯闯桑

spark大数据分布式scala

spark.createDataFrame(data).toDF("name","age")和spark.createDataFrame(spark.sparkContext.parallelize(data),schema)创建df的方式有什么区别?在Spark中,创建DataFrame的方式有多种,其中两种常见的方式是:spark.createDataFrame(data).toDF("nam

- 【头歌C语言程序与设计】数据类型与基本操作

畅游星辰大海

#头歌C语言程序设计c语言

目录写在前面正文第1关:数值与字符的通用性实验第2关:转义字符实验第3关:浮点数实验第4关:数值类型综合实验写在最后写在前面本文代码是我自己所作,本人水平有限,可能部分代码看着不够简练,运行效率不高,但都能运行成功。另外,如果想了解更多,请订阅专栏头歌C语言程序与设计正文第1关:数值与字符的通用性实验本关任务:了解C语言中字符型和整型的通用性,根据提示,输出字母p-Q的数值大小,理解英文姓名排序方

- 数据结构---顺序表的基本操作代码块

偷吃鱼骨的猫

数据结构代码笔记数据结构

顺序表的基本操作//定义typedefstruct{ElemType*Elem;//动态数组,存储空间基地址intlength=0;//当前长度}SqList;//顺序表结构类型//初始化StatusInitList(SqList&L){//构造一个空的顺序表L.Elem=newElemType[MaxSize];//为顺序分配一个MAxSize大小的空间if(!L.Elem)//判断是否成功分配

- 关于旗正规则引擎下载页面需要弹窗保存到本地目录的问题

何必如此

jsp超链接文件下载窗口

生成下载页面是需要选择“录入提交页面”,生成之后默认的下载页面<a>标签超链接为:<a href="<%=root_stimage%>stimage/image.jsp?filename=<%=strfile234%>&attachname=<%=java.net.URLEncoder.encode(file234filesourc

- 【Spark九十八】Standalone Cluster Mode下的资源调度源代码分析

bit1129

cluster

在分析源代码之前,首先对Standalone Cluster Mode的资源调度有一个基本的认识:

首先,运行一个Application需要Driver进程和一组Executor进程。在Standalone Cluster Mode下,Driver和Executor都是在Master的监护下给Worker发消息创建(Driver进程和Executor进程都需要分配内存和CPU,这就需要Maste

- linux上独立安装部署spark

daizj

linux安装spark1.4部署

下面讲一下linux上安装spark,以 Standalone Mode 安装

1)首先安装JDK

下载JDK:jdk-7u79-linux-x64.tar.gz ,版本是1.7以上都行,解压 tar -zxvf jdk-7u79-linux-x64.tar.gz

然后配置 ~/.bashrc&nb

- Java 字节码之解析一

周凡杨

java字节码javap

一: Java 字节代码的组织形式

类文件 {

OxCAFEBABE ,小版本号,大版本号,常量池大小,常量池数组,访问控制标记,当前类信息,父类信息,实现的接口个数,实现的接口信息数组,域个数,域信息数组,方法个数,方法信息数组,属性个数,属性信息数组

}

&nbs

- java各种小工具代码

g21121

java

1.数组转换成List

import java.util.Arrays;

Arrays.asList(Object[] obj); 2.判断一个String型是否有值

import org.springframework.util.StringUtils;

if (StringUtils.hasText(str)) 3.判断一个List是否有值

import org.spring

- 加快FineReport报表设计的几个心得体会

老A不折腾

finereport

一、从远程服务器大批量取数进行表样设计时,最好按“列顺序”取一个“空的SQL语句”,这样可提高设计速度。否则每次设计时模板均要从远程读取数据,速度相当慢!!

二、找一个富文本编辑软件(如NOTEPAD+)编辑SQL语句,这样会很好地检查语法。有时候带参数较多检查语法复杂时,结合FineReport中生成的日志,再找一个第三方数据库访问软件(如PL/SQL)进行数据检索,可以很快定位语法错误。

- mysql linux启动与停止

墙头上一根草

如何启动/停止/重启MySQL一、启动方式1、使用 service 启动:service mysqld start2、使用 mysqld 脚本启动:/etc/inint.d/mysqld start3、使用 safe_mysqld 启动:safe_mysqld&二、停止1、使用 service 启动:service mysqld stop2、使用 mysqld 脚本启动:/etc/inin

- Spring中事务管理浅谈

aijuans

spring事务管理

Spring中事务管理浅谈

By Tony Jiang@2012-1-20 Spring中对事务的声明式管理

拿一个XML举例

[html]

view plain

copy

print

?

<?xml version="1.0" encoding="UTF-8"?>&nb

- php中隐形字符65279(utf-8的BOM头)问题

alxw4616

php中隐形字符65279(utf-8的BOM头)问题

今天遇到一个问题. php输出JSON 前端在解析时发生问题:parsererror.

调试:

1.仔细对比字符串发现字符串拼写正确.怀疑是 非打印字符的问题.

2.逐一将字符串还原为unicode编码. 发现在字符串头的位置出现了一个 65279的非打印字符.

- 调用对象是否需要传递对象(初学者一定要注意这个问题)

百合不是茶

对象的传递与调用技巧

类和对象的简单的复习,在做项目的过程中有时候不知道怎样来调用类创建的对象,简单的几个类可以看清楚,一般在项目中创建十几个类往往就不知道怎么来看

为了以后能够看清楚,现在来回顾一下类和对象的创建,对象的调用和传递(前面写过一篇)

类和对象的基础概念:

JAVA中万事万物都是类 类有字段(属性),方法,嵌套类和嵌套接

- JDK1.5 AtomicLong实例

bijian1013

javathreadjava多线程AtomicLong

JDK1.5 AtomicLong实例

类 AtomicLong

可以用原子方式更新的 long 值。有关原子变量属性的描述,请参阅 java.util.concurrent.atomic 包规范。AtomicLong 可用在应用程序中(如以原子方式增加的序列号),并且不能用于替换 Long。但是,此类确实扩展了 Number,允许那些处理基于数字类的工具和实用工具进行统一访问。

- 自定义的RPC的Java实现

bijian1013

javarpc

网上看到纯java实现的RPC,很不错。

RPC的全名Remote Process Call,即远程过程调用。使用RPC,可以像使用本地的程序一样使用远程服务器上的程序。下面是一个简单的RPC 调用实例,从中可以看到RPC如何

- 【RPC框架Hessian一】Hessian RPC Hello World

bit1129

Hello world

什么是Hessian

The Hessian binary web service protocol makes web services usable without requiring a large framework, and without learning yet another alphabet soup of protocols. Because it is a binary p

- 【Spark九十五】Spark Shell操作Spark SQL

bit1129

shell

在Spark Shell上,通过创建HiveContext可以直接进行Hive操作

1. 操作Hive中已存在的表

[hadoop@hadoop bin]$ ./spark-shell

Spark assembly has been built with Hive, including Datanucleus jars on classpath

Welcom

- F5 往header加入客户端的ip

ronin47

when HTTP_RESPONSE {if {[HTTP::is_redirect]}{ HTTP::header replace Location [string map {:port/ /} [HTTP::header value Location]]HTTP::header replace Lo

- java-61-在数组中,数字减去它右边(注意是右边)的数字得到一个数对之差. 求所有数对之差的最大值。例如在数组{2, 4, 1, 16, 7, 5,

bylijinnan

java

思路来自:

http://zhedahht.blog.163.com/blog/static/2541117420116135376632/

写了个java版的

public class GreatestLeftRightDiff {

/**

* Q61.在数组中,数字减去它右边(注意是右边)的数字得到一个数对之差。

* 求所有数对之差的最大值。例如在数组

- mongoDB 索引

开窍的石头

mongoDB索引

在这一节中我们讲讲在mongo中如何创建索引

得到当前查询的索引信息

db.user.find(_id:12).explain();

cursor: basicCoursor 指的是没有索引

&

- [硬件和系统]迎峰度夏

comsci

系统

从这几天的气温来看,今年夏天的高温天气可能会维持在一个比较长的时间内

所以,从现在开始准备渡过炎热的夏天。。。。

每间房屋要有一个落地电风扇,一个空调(空调的功率和房间的面积有密切的关系)

坐的,躺的地方要有凉垫,床上要有凉席

电脑的机箱

- 基于ThinkPHP开发的公司官网

cuiyadll

行业系统

后端基于ThinkPHP,前端基于jQuery和BootstrapCo.MZ 企业系统

轻量级企业网站管理系统

运行环境:PHP5.3+, MySQL5.0

系统预览

系统下载:http://www.tecmz.com

预览地址:http://co.tecmz.com

各种设备自适应

响应式的网站设计能够对用户产生友好度,并且对于

- Transaction and redelivery in JMS (JMS的事务和失败消息重发机制)

darrenzhu

jms事务承认MQacknowledge

JMS Message Delivery Reliability and Acknowledgement Patterns

http://wso2.com/library/articles/2013/01/jms-message-delivery-reliability-acknowledgement-patterns/

Transaction and redelivery in

- Centos添加硬盘完全教程

dcj3sjt126com

linuxcentoshardware

Linux的硬盘识别:

sda 表示第1块SCSI硬盘

hda 表示第1块IDE硬盘

scd0 表示第1个USB光驱

一般使用“fdisk -l”命

- yii2 restful web服务路由

dcj3sjt126com

PHPyii2

路由

随着资源和控制器类准备,您可以使用URL如 http://localhost/index.php?r=user/create访问资源,类似于你可以用正常的Web应用程序做法。

在实践中,你通常要用美观的URL并采取有优势的HTTP动词。 例如,请求POST /users意味着访问user/create动作。 这可以很容易地通过配置urlManager应用程序组件来完成 如下所示

- MongoDB查询(4)——游标和分页[八]

eksliang

mongodbMongoDB游标MongoDB深分页

转载请出自出处:http://eksliang.iteye.com/blog/2177567 一、游标

数据库使用游标返回find的执行结果。客户端对游标的实现通常能够对最终结果进行有效控制,从shell中定义一个游标非常简单,就是将查询结果分配给一个变量(用var声明的变量就是局部变量),便创建了一个游标,如下所示:

> var

- Activity的四种启动模式和onNewIntent()

gundumw100

android

Android中Activity启动模式详解

在Android中每个界面都是一个Activity,切换界面操作其实是多个不同Activity之间的实例化操作。在Android中Activity的启动模式决定了Activity的启动运行方式。

Android总Activity的启动模式分为四种:

Activity启动模式设置:

<acti

- 攻城狮送女友的CSS3生日蛋糕

ini

htmlWebhtml5csscss3

在线预览:http://keleyi.com/keleyi/phtml/html5/29.htm

代码如下:

<!DOCTYPE html>

<html>

<head>

<meta charset="UTF-8">

<title>攻城狮送女友的CSS3生日蛋糕-柯乐义<

- 读源码学Servlet(1)GenericServlet 源码分析

jzinfo

tomcatWebservlet网络应用网络协议

Servlet API的核心就是javax.servlet.Servlet接口,所有的Servlet 类(抽象的或者自己写的)都必须实现这个接口。在Servlet接口中定义了5个方法,其中有3个方法是由Servlet 容器在Servlet的生命周期的不同阶段来调用的特定方法。

先看javax.servlet.servlet接口源码:

package

- JAVA进阶:VO(DTO)与PO(DAO)之间的转换

snoopy7713

javaVOHibernatepo

PO即 Persistence Object VO即 Value Object

VO和PO的主要区别在于: VO是独立的Java Object。 PO是由Hibernate纳入其实体容器(Entity Map)的对象,它代表了与数据库中某条记录对应的Hibernate实体,PO的变化在事务提交时将反应到实际数据库中。

实际上,这个VO被用作Data Transfer

- mongodb group by date 聚合查询日期 统计每天数据(信息量)

qiaolevip

每天进步一点点学习永无止境mongodb纵观千象

/* 1 */

{

"_id" : ObjectId("557ac1e2153c43c320393d9d"),

"msgType" : "text",

"sendTime" : ISODate("2015-06-12T11:26:26.000Z")

- java之18天 常用的类(一)

Luob.

MathDateSystemRuntimeRundom

System类

import java.util.Properties;

/**

* System:

* out:标准输出,默认是控制台

* in:标准输入,默认是键盘

*

* 描述系统的一些信息

* 获取系统的属性信息:Properties getProperties();

*

*

*

*/

public class Sy

- maven

wuai

maven

1、安装maven:解压缩、添加M2_HOME、添加环境变量path

2、创建maven_home文件夹,创建项目mvn_ch01,在其下面建立src、pom.xml,在src下面简历main、test、main下面建立java文件夹

3、编写类,在java文件夹下面依照类的包逐层创建文件夹,将此类放入最后一级文件夹

4、进入mvn_ch01

4.1、mvn compile ,执行后会在