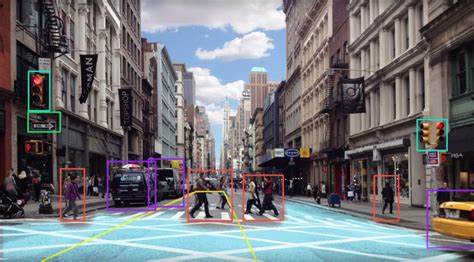

其实一切都是从简单开始,当然无人驾驶需要人工智能对周围环境了如指掌。一切尽在掌握,需要尽可能将周围的所有物体都识别出来,今天的人工智能对周围感知通过雷达,或是通过激光扫描周围的环境来尽可能多获取信息。

import cv2 as cv

import numpy as np

from matplotlib import pyplot as plt

cap = cv.VideoCapture('vtest.avi')

while cap.isOpened():

ret, frame = cap.read()

cv.imshow('inter',frame)

if cv.waitKey(40) == 27:

break

cv.destroyAllWindows()

cap.release()

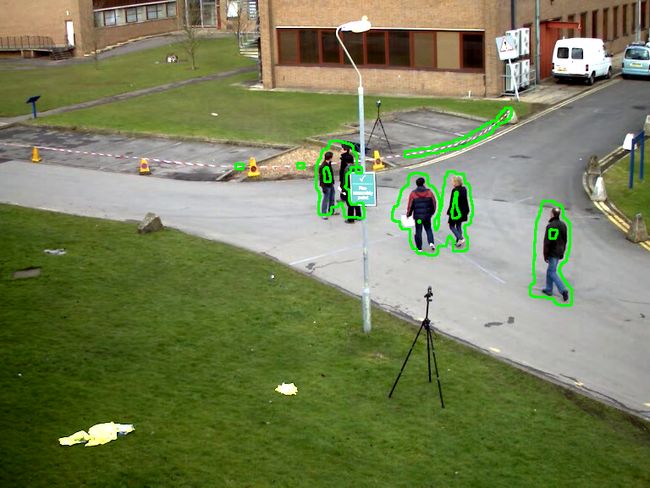

测试的影响资料是从 opencv 官网获取的。影响资料上有人运行,我们要做的就是将这些运动的人识别出来,通过绿色的框表示出来。当先判断运动的人,并没有使用深度学习来识别运动的是人。只是识别出是运动。

如果我们需要判断移动物体,就需要通过两个帧画面的差值来找到移动的物体。这里通过 absdiff 通过对比帧(frame1,frame2)来识别两帧图像不同来识别运动。

diff = cv.absdiff(frame1,frame2)

gray = cv.cvtColor(diff,cv.COLOR_BGR2GRAY)

diff = cv.absdiff(frame1,frame2)

cv.imshow('diff',diff)

图中为 absdiff 通过对别 frame1 和 frame2 的导出输出。

while cap.isOpened():

# ret, frame = cap.read()

diff = cv.absdiff(frame1,frame2)

gray = cv.cvtColor(diff,cv.COLOR_BGR2GRAY)

blur = cv.GaussianBlur(gray,(5,5),0)

_, thresh = cv.threshold(blur,20,255,cv.THRESH_BINARY)

dilated = cv.dilate(thresh, None, iterations=3)

contours, _ = cv.findContours(dilated,cv.RETR_TREE,cv.CHAIN_APPROX_SIMPLE)

cv.drawContours(frame1, contours, -1, (0,255,0),2)

因为我们要进行高斯模糊,颜色值对我们分析和识别运动问题没有任何帮助。所以将图片进行灰度处理。有关高斯模糊我们以后从理论进行分析,现在我们知道就是高斯模糊是进行去掉噪点来进行平滑和降噪,

blur = cv.GaussianBlur(gray,(5,5),0)

cv.imshow('blur',blur)

识别出来运动人物,dilate()函数可以对输入图像用特定结构元素进行膨胀(就是扩展像素范围)操作,该结构元素确定膨胀操作过程中的邻域的形状,各点像素值将被替换为对应邻域上的最大值。通过 dilate 来扩大显示范围,然后用 findContours查找轮廓,接下来调用 drawContours 来绘制出轮廓

cap = cv.VideoCapture('vtest.avi')

ret, frame1 = cap.read()

ret, frame2 = cap.read()

while cap.isOpened():

# ret, frame = cap.read()

diff = cv.absdiff(frame1,frame2)

gray = cv.cvtColor(diff,cv.COLOR_BGR2GRAY)

blur = cv.GaussianBlur(gray,(5,5),0)

_, thresh = cv.threshold(blur,20,255,cv.THRESH_BINARY)

dilated = cv.dilate(thresh, None, iterations=3)

contours, _ = cv.findContours(dilated,cv.RETR_TREE,cv.CHAIN_APPROX_SIMPLE)

cv.drawContours(frame1, contours, -1, (0,255,0),2)

cv.imshow('feed',frame1)

frame1 = frame2

ret, frame2 = cap.read()

if cv.waitKey(40) == 27:

break

cv.destroyAllWindows()

cap.release()

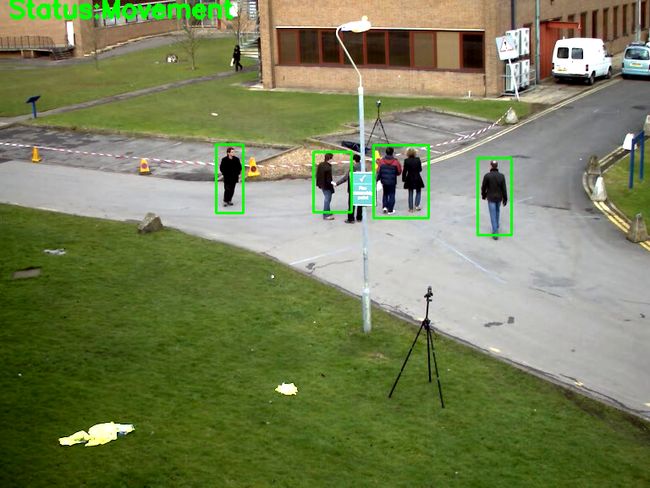

for contour in contours:

(x, y, w, h) = cv.boundingRect(contour)

if cv.contourArea(contour) < 700:

continue

cv.rectangle(frame1,(x,y),(x+w,y+h),(0,255,0),2)

cv.putText(frame1,"Status:{}".format("Movement"),(10,20),cv.FONT_HERSHEY_SIMPLEX,1,(0,0,255),3)

我们通过 boundingRect 读取轮廓来识别为矩形(也就是 bounding box)通过矩形绘制出识别的运行人的范围。然后再用 putText 为影响添加文字。

frame1 = frame2

ret, frame2 = cap.read()

if cv.waitKey(40) == 27:

break

将 frame2 赋值给 frame1 也就是表示记录下 frame1 也就是记录下上一次帧。然后重新 对 frame2 进行赋值。