HashMap使用一个的数组来保存不同散列值的key以及相应的value。在jkd1.8中,对于相同hashcode形成的bucket,不再按照唯一的链表存储,而是根据bucket的大小,超过一定限制之后将链表转换为红黑树来存储Map.Entry

*jkd源码的版本为1.8.0_05

类的结构:

public class HashMap extends AbstractMap implements Map, Cloneable, Serializable

一个不明白的地方:AbstractMap已经实现了Map接口,为什么HashMap还要继承AvstractMap之后实现Map。

构造函数

HashMap的构造函数有多种重载的方式,这里只详细说明最重要,最复杂的一种:

public HashMap(int initialCapacity, float loadFactor) {

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

this.loadFactor = loadFactor;

this.threshold = tableSizeFor(initialCapacity);

}

static final int tableSizeFor(int cap) {

int n = cap - 1;

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

这里有一个tableSizeFor()方法,就是取大于cap的最小2的整数幂。实现思路是由"1....."计算得到"1111111+1"。使用将第一位不断的向后移,然后做“或”运算的方法。Doug Lea大神脑路之奇特,让人佩服。

成员字段

//HashMap的默认初始容量

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; // aka 16

//HashMap的最大容量

static final int MAXIMUM_CAPACITY = 1 << 30;

//默认负载系数

static final float DEFAULT_LOAD_FACTOR = 0.75f;

//一个bucket的节点数大于这个数字的时候,使用红黑树来存储

static final int TREEIFY_THRESHOLD = 8;

//一个bucket的节点数小于这个数字的时候,使用链表来存储

static final int UNTREEIFY_THRESHOLD = 6;

//红黑树的最小容量

static final int MIN_TREEIFY_CAPACITY = 64;

//用来散列的数组

transient Node[] table;

//键值对的数量

transient int size;

//HashMap的结构修改的次数

transient int modCount;

//阈值,下一次分配容量的阈值(capacity*loadFactor)

int threshold;

//负载系数

final float loadFactor;

关键方法

计算哈希值

static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

这里有一个无符号右移,当h的值小于16位的时候,h^(h>>>16)与h是相等的。当h高于16位的时候,为了防止key的hashcode值的变化只在开头几位,末尾相同,这样导致在与cap-1做&运算的时候,发生大量的哈希冲突,所以使用一些高位来spread(这里怎么翻译?)一下低位。让其低位变得不同。为什么使用异或运算,因为异或运算非常的快。

在HashMap中增加一个键值对

大概经历了下面几个过程:

- 处理HashMap为空的情况

- 进行Hash运算,然后查看数组中相应的位置

- 如果是空的,说明没有Hash冲突,放在这里就好

- 如果有值,先判断是不是和第一个值的key相同

- 然后处理是红黑树的情况

- 最后处理数组的情况

/**

*@param onlyIfAbsent:如果是true,在有相同key的情况下,不要改变现有的value

*@param evict:如果是false,是在构造函数中调用

*/

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,boolean evict) {

Node[] tab; Node p; int n, i;

//如果数组是空的,做一次扩容。

if ((tab = table) == null || (n = tab.length) == 0)

//n是当前数组的容量

n = (tab = resize()).length;

//p取到当前hash散列到的节点。n是2的整数幂,(n-1)&hash做一次哈希值的截取

if ((p = tab[i = (n - 1) & hash]) == null)

//如果这个节点是空的,说明之前没有相同的哈希值,新建一个节点放在这里。

tab[i] = newNode(hash, key, value, null);

else {

//下面处理哈希冲突的情况

Node e; K k;

//如果这个bucket里的第一个节点的key与我们正在添加的key相同。(使用equals做判断,所以推荐重写equals)

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

//e就是key相同的节点

e = p;

//如果这个bucket是一个红黑树

else if (p instanceof TreeNode)

//用红黑树的方式添加一个节点

e = ((TreeNode)p).putTreeVal(this, tab, hash, key, value);

else {

//还剩下的情况就是链表了,遍历这个链表。

for (int binCount = 0; ; ++binCount) {

//到了链表的结尾,说明没有key相同的,需要在这里插入一个节点。

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

//如果当前bucket的数量超过的查找树阈值,转换为查找树的方式,然后跳出。

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

//如果查找到了相同的key,也跳出。已经把e的信息保存下来了。

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

//现在说明已经存在了相同的key,要进行value的替换

if (e != null) { // existing mapping for key

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

//这里的afterNodeAccess应该是钩子方法,方便LinkedHashMap继承HashMap的时候可以调用,起到子类影响父类的效果。

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

//如果容量超过阈值,进行扩容

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

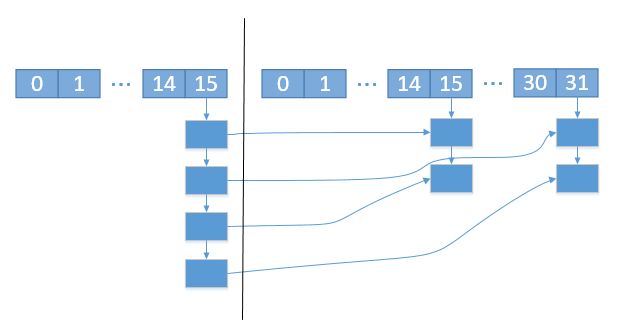

扩容

所谓扩容,就是当键值对的数量超过阈值的时候,让当前数组的的容量扩大为当前的两倍,然后进行一次hash再散列的过程。

final Node[] resize() {

Node[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

if (oldCap > 0) {

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

//因为数组的容量总是2的整数幂,所以可以使用左移一位的方式达到乘以二的效果,效率更优。

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold

}

//这里处理的情况是旧的容量是0,但是阈值不为零。那么就扩容到阈值。

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

//容量是0,阈值也是0,全部使用默认的值。

else { // zero initial threshold signifies using defaults

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

//按照上面的逻辑,这里处理的是oldCap==0,oldThr>0的情况,不太理解这里。

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

//新建一个新的数组,完成容量扩大成为之前二倍的操作。

@SuppressWarnings({"rawtypes","unchecked"})

Node[] newTab = (Node[])new Node[newCap];

table = newTab;

//下面进行把老的数组里面的值放到新的数组里

if (oldTab != null) {

for (int j = 0; j < oldCap; ++j) {

Node e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

//如果老的数组里,bucket只有一个节点,那么进行重新散列,放到新的位置。

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

//如果是一颗红黑树,使用TreeNode中的slit方法,将这棵树分成两个小树。

else if (e instanceof TreeNode)

((TreeNode)e).split(this, newTab, j, oldCap);

//下面处理将一个链表分成两个链表。

else { // preserve order

Node loHead = null, loTail = null;

Node hiHead = null, hiTail = null;

Node next;

do {

next = e.next;

//oldCap应该是二进制“100000……”的形式,那么做&运算之后,刚好可以得到扩容之后哈希值多出来的那一位。我们根据多出来的那一位是1还是0,选择是放在原来的bucket上,还是放在新的bucket上。

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

//把两个链表头放在数组里对应的位置,“低位”放在原处,“高位”放在原处+老容量值

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}