NIPS2018深度学习(18)|亮点: 贝叶斯深度学习;图卷积(论文及代码)

[1] SLANG: Fast Structured Covariance Approximations for Bayesian Deep Learning with Natural Gradient

Aaron Mishkin,Frederik Kunstner,Didrik Nielsen,Mark Schmidt,Mohammad Emtiyaz Khan

University of British Columbia,Ecole Polytechnique Fédérale de Lausanne,RIKEN Center for AI Project

https://papers.nips.cc/paper/7862-slang-fast-structured-covariance-approximations-for-bayesian-deep-learning-with-natural-gradient.pdf

在深度学习模型中,不确定性估计计算非常复杂,即时对后验分布进行高斯逼近也非常困难。虽然利用协方差矩阵会得到比较差的不确定性估计,但是现有方法通常利用对协方差矩阵进行对角逼近来得到不确定性估计。

这篇文章针对上述问题,提出了一种解决方案,提出了一种新的随机低秩近似自然梯度(SLANG,stochastic, low-rank, approximate natural-gradient)方法,进而解决大型深层模型中的变分推理问题。这种方法利用对数似然度并且基于网络中的梯度反向传播来估计对角并且低秩的结构。这就减少了梯度的计算量,而不像计算整个变分目标函数中的梯度那样需要很多计算量。

本文所提出的方法不仅速度较快,而且不确定估计比平均场方法更加准确。

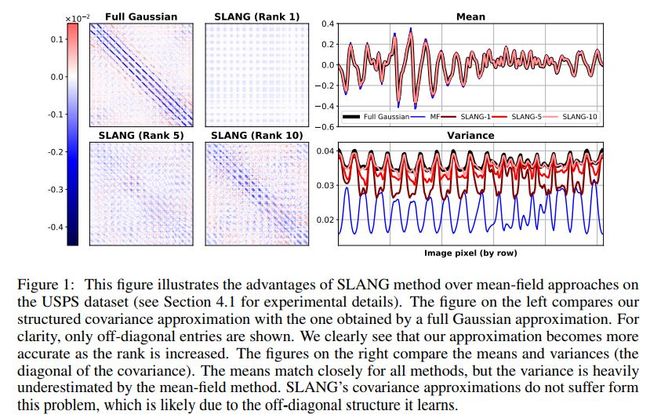

几种方法在数据集USPS上的效果对比如下

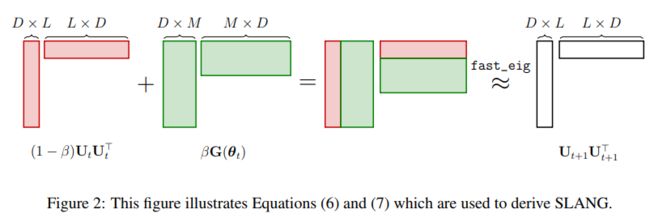

SLANG的推导图示如下

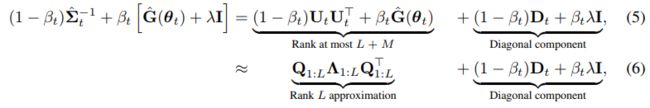

其中(6)式为

(7)式为

M为每一个微小批的样本数

L是最重要特征值的前L个

D表示特征数

关键算法伪代码如下

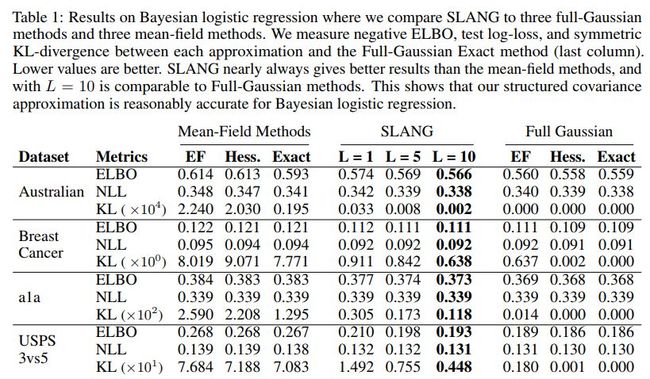

在贝叶斯逻辑回归算法中几种方法在多个数据集上的效果对比如下

EF全称为Empirical Fisher

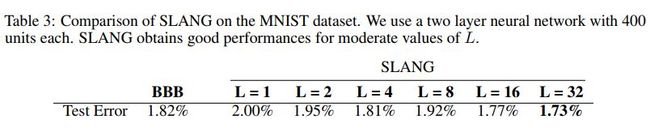

在贝叶斯神经网络算法中几种方法在多个数据集上的效果对比如下

其中BBB全称为Bayes By Backprop

对应的论文为

Weight uncertainty in neural networks. 2015.

代码地址

https://github.com/nitarshan/bayes-by-backprop/blob/master/Weight%20Uncertainty%20in%20Neural%20Networks.ipynb

dropout对应的论文为

Dropout as a bayesian approximation: Representing model uncertainty in deep learning. ICML, 2016.

代码地址

https://github.com/yaringal/DropoutUncertaintyExps

参数L的影响示例如下

代码地址

https://github.com/aaronpmishkin/SLANG

![]() 我是分割线

我是分割线![]()

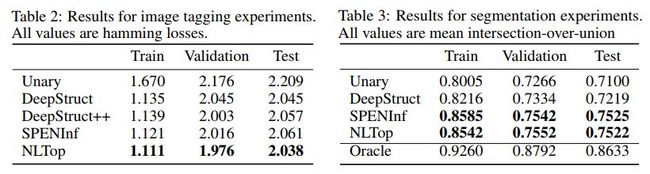

[2] Deep Structured Prediction with Nonlinear Output Transformations

Colin Graber, Ofer Meshi, Alexander Schwing

University of Illinois at Urbana-Champaign, Google

https://papers.nips.cc/paper/7869-deep-structured-prediction-with-nonlinear-output-transformations.pdf

深层结构化模型在语义分割等任务中广泛应用,在深层结构化模型中,变量之间的相关性暗含着重要的先验信息,这种信息通常可以使得深层网络所需要的数据量。

然而,现有的深层结构化模型通常受限于局部邻近的结构,考虑到计算复杂度,这种局部邻近结构不宜过多,否则会带来太大的计算量。现有深层结构化模型还受限于输出的配置或者说输出的表示,不能进一步转换。

为了解决上述问题,最近学者们提出深层网络中的图模型推理,如此一来可以得到输出空间中的非线性变换。但是,这种形式下,优化方法具有一定的挑战性,也不易于理解。

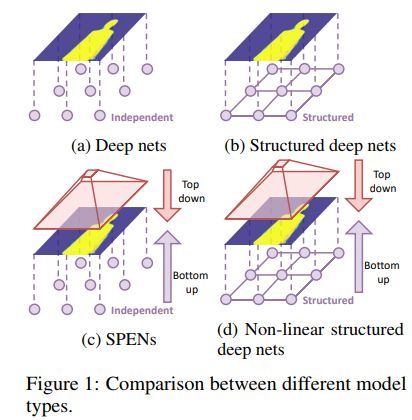

这篇文章提出一种新的模型,这种模型是对现有方法结构化预测能量网络的一种泛化。

几种模型的对比如下

其中SPENs全称为structured prediction energy networks,对应的论文为

Structured Prediction Energy Networks. ICML, 2016

End-to-end learning for structured prediction energy networks. ICML, 2017.

代码地址

https://github.com/davidBelanger/SPEN

本文所提出的网络模型图示如下

推理过程伪代码如下

更新权重算法的伪代码如下

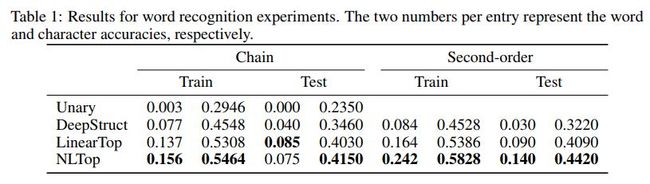

几种方法在单词识别中的效果对比如下

几种方法在图像标注和分割中的效果对比如下

代码地址

https://github.com/cgraber/NLStruct

![]() 我是分割线

我是分割线![]()

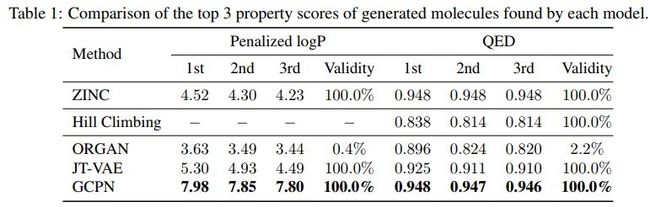

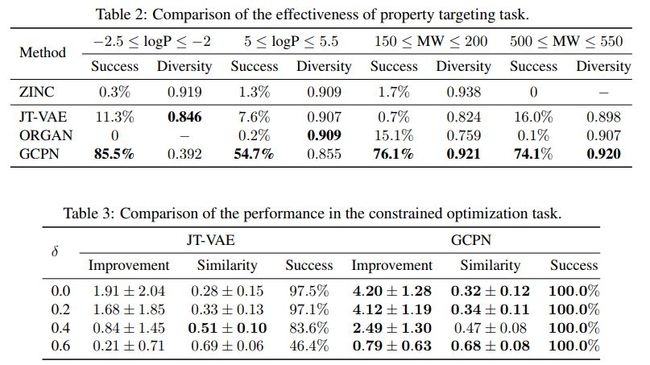

[3] Graph Convolutional Policy Network for Goal-Directed Molecular Graph Generation

Jiaxuan You, Bowen Liu, Rex Ying, Vijay Pande, Jure Leskovec

Stanford University

https://papers.nips.cc/paper/7877-graph-convolutional-policy-network-for-goal-directed-molecular-graph-generation.pdf

在遵循一些特定规则的前提下,通过生成新的图结构来优化给定的目标函数在化学、生物以及社会科学中非常重要。在生成分子图时,上述做法更加重要,因为生成分子图是为了发现具有期望属性(比如类药性和综合可达性)的新分子,同时需要遵守比如化合价这种物理定律。

但是,如何设计模型来寻找能够优化期望属性的分子,同时融合高复杂度和非可微的规则,具有一定的挑战性。作者们提出图卷积策略网络(GCPN),这是一种基于通用的图卷积网络的模型,用于目标导向的图生成,同时还借助了增强学习。该模型利用策略梯度优化特定领域的回报函数和对抗损失,还可以融合特定领域的规则来优化环境中的行动。

本文提出的图生成过程如下

几种方法的效果对比如下

其中ORGAN对应的论文为

Objective-Reinforced Generative Adversarial Networks (ORGAN) for Sequence Generation Models.

代码地址

https://github.com/gablg1/ORGAN

JT-VAE对应的论文为

Junction tree variational autoencoder for molecular graph generation

代码地址

https://github.com/wengong-jin/icml18-jtnn

几种方法在不同任务中的效果对比如下

代码地址

https://github.com/bowenliu16/rl_graph_generation

![]() 我是分割线

我是分割线![]()

您可能感兴趣