机器学习数学基础——概率论篇

文章目录

- 概率论篇

- 前言

- 算法对应的数学知识

- 概率

- 概率公式

- 基本公式

- 全概率公式

- 贝叶斯公式

- 概率分布

- 两点分布

- 二项分布

- 泊松分布

- 均匀分布

- 指数分布

- 正态分布

- 总结

- 统计

- 期望

- 方差

- 标准差

- 协方差

- 大数定理

- 中心极限定理

- 矩

- 参数估计

- 矩估计法

- 最大似然估计法

- 似然函数的构造

- 求解步骤

- 参考资料

概率论篇

前言

最近在尝试自学入门机器学习,有一点找不到方向,看了一点吴恩达的机器学习视频和周志华的西瓜书,但是对于里面的一些数学运算实在是很头疼,虽然当时数学学得不差,但是基本上也都还给老师了,所以趁着大四上有空闲时间打算整理一下机器学习中一些基础必须知道的本科数学知识,希望自己在研究生阶段有遗忘可以参考,也希望可以对有需要的人有所帮助。由于笔者只是为了快速入门,所以很多知识都是现补,不一定正确,如有错误希望大家可以提出改正!

算法对应的数学知识

概率

概率公式

基本公式

对于任意事件A和B:

1) P ( A ) = 1 − P ( A ˉ ) P(A) = 1 - P(\bar{A}) P(A)=1−P(Aˉ)

2) P ( A − B ) = P ( A ) − P ( A B ) ( B ⊆ A ) P(A-B) = P(A) - P(AB) (B \subseteq A) P(A−B)=P(A)−P(AB)(B⊆A)

3) P ( A + B ) = P ( A ) + P ( B ) − P ( A B ) P(A + B) = P(A) + P(B) - P(AB) P(A+B)=P(A)+P(B)−P(AB)

4)对于互斥事件, P ( ∪ i = 1 n A i ) = ∑ i = 1 n P ( A i ) P(\cup_{i=1}^n A_i) = \sum_{i=1}^nP(A_i) P(∪i=1nAi)=∑i=1nP(Ai)

5)对于独立事件, P ( ∩ i = 1 n A i = ∏ i = 1 n P ( A i ) ) P(\cap_{i=1}^nA_i=\prod_{i=1}^nP(A_i)) P(∩i=1nAi=∏i=1nP(Ai))

P ( ∪ i = 1 n A i ) = 1 − ∏ i = 1 n ( 1 − P ( A i ) ) P(\cup_{i=1}^nA_i)=1-\prod_{i=1}^n(1-P(A_i)) P(∪i=1nAi)=1−∏i=1n(1−P(Ai))

6)条件概率: P ( B ∣ A ) = P ( A B ) P ( A ) P(B|A)=\frac{P(AB)}{P(A)} P(B∣A)=P(A)P(AB)

P ( A B ) = P ( A ) P ( B ∣ A ) P(AB)=P(A)P(B|A) P(AB)=P(A)P(B∣A)

全概率公式

P ( A ) = ∑ i P ( A ∣ B i ) P ( B i ) P(A)=\sum_iP(A|B_i)P(B_i) P(A)=i∑P(A∣Bi)P(Bi)

意思就是说,我们直接求解A的概率有难度,那么我们可以通过对样本空间 Ω \Omega Ω的划分来求解

求解A在 Ω \Omega Ω上的样本数目,可以求解(A∩ B 1 B_1 B1的样本数)+(A∩ B 2 B_2 B2的样本数)+····+(A∩ B n B_n Bn)的样本数

贝叶斯公式

P ( B i ∣ A ) = P ( A ∣ B i ) P ( B i ) ∑ j P ( A ∣ B j ) P ( B j ) P(B_i|A)=\frac{P(A|B_i)P(B_i)}{\sum_jP(A|B_j)P(B_j)} P(Bi∣A)=∑jP(A∣Bj)P(Bj)P(A∣Bi)P(Bi)

贝叶斯公式是建立在条件概率的基础上寻找事件发生的原因,即大事件A已经发生的条件下,分割中的小事件Bi的概率

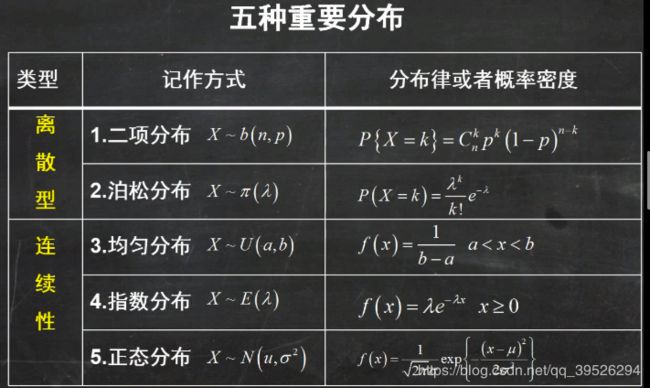

概率分布

| 分布 | 参数 | 数学期望 | 方差 |

|---|---|---|---|

| 两点分布 | 0 < p < 1 0 < p < 1 0<p<1 | p p p | p ( 1 − p ) p ( 1 - p ) p(1−p) |

| 二项分布 | n ≥ 1 , 0 < p < 1 n\geq 1,0 < p < 1 n≥1,0<p<1 | n p np np | n p ( 1 − p ) np (1-p) np(1−p) |

| 泊松分布 | λ > 0 \lambda > 0 λ>0 | λ \lambda λ | λ \lambda λ |

| 均匀分布 | a < b a < b a<b | ( a + b ) 2 \frac{(a+b)}{2} 2(a+b) | ( b − a ) 2 12 \frac{(b-a)^2}{12} 12(b−a)2 |

| 指数分布 | θ > 0 \theta > 0 θ>0 | θ \theta θ | θ 2 \theta^2 θ2 |

| 正态分布 | μ , σ > 0 \mu,\sigma > 0 μ,σ>0 | μ \mu μ | σ \sigma σ |

*对于数学期望和方差的知识我们会在后面提到

两点分布

两点分布又名伯努利分布、0-1分布 ,它指进行一次伯努利实验,成功 ( X = 1 ) (X=1) (X=1)的概率为p ( 0 ≤ p ≤ 1 ) (0\leq p \leq 1) (0≤p≤1),失败 ( X = 0 ) (X=0) (X=0)的概率为1-p,则称随机变量X服从伯努利分布。

二项分布

二项分布是n重伯努利实验成功次数的离散概率分布。如果试验E是一个n重伯努利试验,每次伯努利试验的成功概率为p,X代表成功的次数,则X的概率分布是二项分布,记为X~B(n,p),分布规律: P ( X = k ) = C n k p k ( 1 − p ) n − k P(X=k)=C_n^kp^k(1-p)^{n-k} P(X=k)=Cnkpk(1−p)n−k

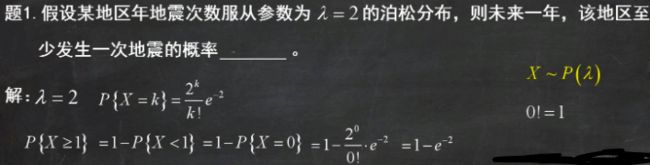

泊松分布

当二项分布的n趋于无穷大,p趋于0时,此时事件发生的概率服从泊松分布,函数定义为:

P ( X = k ) = λ k ∗ e − λ k ! P(X = k) = \frac{\lambda^k * e ^{-\lambda}}{k!} P(X=k)=k!λk∗e−λ,记作 X X X~ π ( λ ) \pi(\lambda) π(λ)

泊松分布描述某时间段内,时间具体的发生概率,一个事件服从泊松分布的条件为:

(1)将该时间段无限分隔成很多个小的时间段,在这个小的时间段内,事件发生的概率非常小,不发生的概率非常大。

(2)在每个小的时间段内,事件发生的概率是稳定的,且与小的时间段的长度成正比。

(3)该事件在不同的小时间段里,发生与否相互独立。

均匀分布

均匀分布是一种连续型分布,涉及到概率密度函数。记作 X X X~ U ( a , b ) U(a,b) U(a,b),概率密度为:

f ( x ) { 1 b − a a < x < b 0 其 他 f(x)\left\{ \begin{array}{rcl} \frac{1}{b-a} & & {a< x< b }\\ 0 & & {其他} \end{array} \right. f(x){b−a10a<x<b其他

指数分布

记作 X X X~ E ( λ ) E(\lambda) E(λ),概率密度为:

f ( x ) { λ e − λ x x > 0 0 其 他 f(x)\left\{ \begin{array}{rcl} \lambda e^{-\lambda x} & & {x > 0}\\ 0 & & {其他} \end{array} \right. f(x){λe−λx0x>0其他

指数分布有一个性质: P { X > s + t ∣ X > s } = P { X > t } P\{X > s+t|X > s\} = P\{X > t\} P{X>s+t∣X>s}=P{X>t}

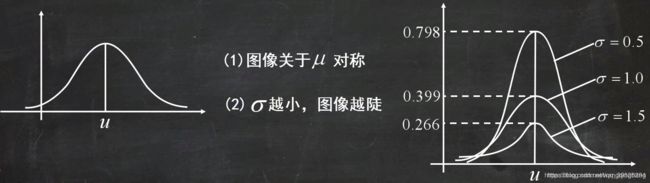

正态分布

正态分布又称为高斯分布或常态分布,若随机变量X服从一个数学期望为μ、标准方差为为σ2的高斯分布,记为:X∼N(μ,σ2),概率密度函数为: f ( x ) = 1 2 π σ e − ( x − μ ) 2 2 σ 2 f(x)=\frac{1}{\sqrt{2\pi}\sigma}e^{-\frac{(x-\mu)^2}{2\sigma^2}} f(x)=2πσ1e−2σ2(x−μ)2

常用性质:

总结

统计

期望

表示随机变量平均取值的大小,可以预测一个随机事件的平均预期情况

离散型: E ( X ) = ∑ i x i p i E(X) = \sum_ix_ip_i E(X)=∑ixipi

连续型: E ( X ) = ∫ − ∞ + ∞ x f ( x ) d x E(X) = \int_{-\infty}^{+\infty}xf(x)dx E(X)=∫−∞+∞xf(x)dx

性质:1) E ( k X + c ) = k E ( X ) + c E(kX+c)=kE(X)+c E(kX+c)=kE(X)+c

2) E ( X + Y ) = E ( X ) + E ( Y ) E(X+Y) = E(X)+E(Y) E(X+Y)=E(X)+E(Y)

3)X,Y独立, E ( X Y ) = E ( X ) E ( Y ) E(XY)=E(X)E(Y) E(XY)=E(X)E(Y)

注意:平均值默认每一个变量出现的概率p相同,期望是以实际概率进行的加权平均

方差

衡量随机变量或一组数据的离散程度,通过方差可以知道一组数据的分散程度

定义: V a r ( X ) = E { [ X − E ( X ) ] 2 } = E ( X 2 ) − E 2 ( X ) Var(X)=E\{[X-E(X)]^2\}=E(X^2)-E^2(X) Var(X)=E{[X−E(X)]2}=E(X2)−E2(X)

公式: S 2 = ∑ i = 1 N ( X i − μ ) 2 n − 1 S^2=\frac{\sum_{i=1}^{N}(X_i-\mu)^2}{n-1} S2=n−1∑i=1N(Xi−μ)2

性质:1) V a r ( c ) = 0 Var(c) = 0 Var(c)=0

2) V a r ( X + c ) = V a r ( X ) Var(X+c)=Var(X) Var(X+c)=Var(X)

3) V a r ( k X ) = k 2 V a r ( X ) Var(kX)=k^2Var(X) Var(kX)=k2Var(X)

4)X,Y独立, V a r ( X + Y ) = V a r ( X ) + V a r ( Y ) Var(X+Y)=Var(X)+Var(Y) Var(X+Y)=Var(X)+Var(Y),

V a r ( X Y ) = V a r ( X ) V a r ( Y ) + V a r ( X ) E 2 ( Y ) + V a r ( Y ) E 2 ( X ) Var(XY)=Var(X)Var(Y)+Var(X)E^2(Y)+Var(Y)E^2(X) Var(XY)=Var(X)Var(Y)+Var(X)E2(Y)+Var(Y)E2(X)

标准差

标准差又叫均方差,反应一个数据集的离散程度

公式: σ = 方 差 = ∑ i = 1 N ( X − μ ) 2 N \sigma=\sqrt{方差}=\sqrt{\frac{\sum_{i=1}^{N}(X-\mu)^2}{N}} σ=方差=N∑i=1N(X−μ)2

注意:标准差虽然可以与方差一样反应一组数据的离散程度,但是两者是有区别的。方差与样本的量纲不一样,从公式来看方差是样本与均值的差的平方和的平均,有一个平方运算所以导致量纲不在一个层面上;而标准差和均值的量纲是一致的。

协方差

均值、期望、方差和标准差都是针对同一组数据而言,协方差是用来体现两组数据之间的相关程度的,或者说可以看一组数据的各个属性(特征)之间的相关程度的。

定义: C o v ( X , Y ) = E { [ X − E ( X ) ] [ Y − E ( Y ) ] } = E ( X Y ) − E ( X ) E ( Y ) Cov(X,Y)=E\{[X-E(X)][Y-E(Y)]\}=E(XY)-E(X)E(Y) Cov(X,Y)=E{[X−E(X)][Y−E(Y)]}=E(XY)−E(X)E(Y)

性质:1) C o v ( X , Y ) = C o v ( Y , X ) Cov(X,Y)=Cov(Y,X) Cov(X,Y)=Cov(Y,X)

2) C o v ( X , X ) = V a r ( X ) Cov(X,X)=Var(X) Cov(X,X)=Var(X)

3) C o v ( a X + b , c Y + d ) = a c C o v ( X , Y ) Cov(aX+b,cY+d)=acCov(X,Y) Cov(aX+b,cY+d)=acCov(X,Y)

4) C o v ( X 1 + X 2 , Y ) = C o v ( X 1 , Y ) + C o v ( X 2 , Y ) Cov(X1+X2,Y)=Cov(X1,Y)+Cov(X2,Y) Cov(X1+X2,Y)=Cov(X1,Y)+Cov(X2,Y)

5)若 C o v ( X , Y ) = 0 Cov(X,Y)=0 Cov(X,Y)=0则X与Y不相关,协方差是两个随机变量具有相同方向变化趋势的度量

相关系数: ρ X Y = C o v ( X , Y ) V a r ( X ) V a r ( Y ) \rho_{XY}=\frac{Cov(X,Y)}{\sqrt{Var(X)Var(Y)}} ρXY=Var(X)Var(Y)Cov(X,Y)

相关系数性质: 1)相关性是一个衡量线性独立的无量纲数, 其取值在[ -1, 1] 之间。

2)相关性 corr = 1 时称完全线性相关。

3)相关性 corr = -1 时称完全线性负相关。

4)相关性 corr = 0 时称不相关。

大数定理

设随机变量 X 1 , X 2 , . . . , X n X_1,X_2,...,X_n X1,X2,...,Xn相互独立并有相同期望 μ \mu μ 和方差 σ 2 \sigma^2 σ2,取前n个变量均值 Y n = 1 n ∑ i = 1 n X i Y_n=\frac{1}{n}\sum_{i=1}^nX_i Yn=n1∑i=1nXi,对任意正数 ϵ \epsilon ϵ有 lim n → ∞ P { ∣ Y n − μ ∣ < ϵ } = 1 \lim_{n \to \infty}P\{|Y_n-\mu|<\epsilon\} = 1 limn→∞P{∣Yn−μ∣<ϵ}=1,意思就是说当我们的样本数量足够多的时候我们取出的样本的均值与我们总体数据的期望是等同的。有什么用呢?我们机器学习的数据量足够大的时候,我们就可以认为我们认为我们对样本数据的预测就等同于现实的真实情况,样本中事物出现的频率就能无限接近于它真实的期望值。

大数定理从理论上解决了用频率近似替代概率的问题

拓展:伯努利定理 一次试验中事件A发生的概率为p,重复n次独立试验中,事件A发生 n A n_A nA次,则对于任意正数 ϵ \epsilon ϵ, lim n → ∞ P { ∣ n A n − p ∣ < ϵ } = 1 \lim_{n \to \infty}P\{|\frac{n_A}{n}-p|<\epsilon\} = 1 limn→∞P{∣nnA−p∣<ϵ}=1

中心极限定理

设随机变量 X 1 , X 2 , . . . , X n X_1,X_2,...,X_n X1,X2,...,Xn互相独立,服从同一分布并具有相同期望 μ \mu μ和方差 σ 2 \sigma^2 σ2,则随机变量 Y n = ∑ i = 1 n x i − μ n ϵ Y_n=\frac{\sum_{i=1}^{n}x_i-\mu}{\sqrt{n}\epsilon} Yn=nϵ∑i=1nxi−μ的分布收敛到标准正态分布,意思就是说无论原本数据是什么样的分布,当n足够大的时候,其抽样样本的均值的频数分布都随着抽样数的增多而趋于正态分布

大数定理与中心极限定理的区别:大数定理在说n足够大时样本均值几乎等于均值;中心极限定理在说n足够大时样本均值越来越趋近于正态分布

矩

k阶样本原点矩: A k = 1 n ∑ i = 1 n X i k A_k=\frac{1}{n}\sum_{i=1}^nX_i^k Ak=n1∑i=1nXik

k阶样本中心矩: A k = 1 n ∑ i = 1 n ( X i − X ˉ ) k A_k=\frac{1}{n}\sum_{i=1}^n(X_i-\bar X)^k Ak=n1∑i=1n(Xi−Xˉ)k

一阶矩表示的是随机变量的期望

二阶矩表示的是随机变量的方差

三阶矩表示的是随机变量的偏度

四阶矩表示的是随机变量的峰度

- 偏度:衡量分布不对称性,定义为其三阶中心矩 S ( x ) = ∫ − ∞ ∞ [ x − E ( x ) ] 3 f ( x ) d x S(x)=\int_{-\infty}^{\infty}[x-E(x)]^3f(x)dx S(x)=∫−∞∞[x−E(x)]3f(x)dx,任何对称分布偏度为0;向左偏斜具有负偏度(例如失效率,极少量的物品会损坏);向右偏斜具有正偏度(例如工资,大多数人工资少)

- 峰度:定义为其四阶中心矩与方差平方的比值再减3,减3是为了让正态分布峰度为0,这也被称为超值峰度: K ( x ) = ∫ − ∞ ∞ [ x − E ( x ) ] 4 f ( x ) d x σ 2 − 3 K(x)=\frac{\int_{-\infty}^\infty[x-E(x)]^4f(x)dx}{\sigma^2}-3 K(x)=σ2∫−∞∞[x−E(x)]4f(x)dx−3

参数估计

根据从总体中抽取的样本估计总体分布中包含的未知参数的方法

矩估计法

依据大数定律,用样本矩估计总体矩

思想:样本k阶原点矩: A k = 1 n ∑ i = 1 n X i k A_k=\frac{1}{n}\sum_{i=1}^nX_i^k Ak=n1∑i=1nXik ⇒ \Rightarrow ⇒ 总体k阶原点矩: μ k = E ( X k ) \mu_k=E(X^k) μk=E(Xk)

样本k阶中心矩: B k = 1 n ∑ i = 1 n ( X i − X ˉ ) k B_k=\frac{1}{n}\sum_{i=1}^{n}(X_i-\bar X)^k Bk=n1∑i=1n(Xi−Xˉ)k ⇒ \Rightarrow ⇒ 总体k阶中心矩: m k = E { [ X − E ( X ) ] k } m_k=E\{[X-E(X)]^k\} mk=E{[X−E(X)]k}

设总体期望为 μ \mu μ方差为 σ 2 \sigma^2 σ2( μ , σ \mu,\sigma μ,σ待求),则有: E ( X ) = μ , E ( X 2 ) = σ 2 + E 2 ( X ) = σ 2 + μ 2 E(X)=\mu,E(X^2)=\sigma^2+E^2(X)=\sigma^2+\mu^2 E(X)=μ,E(X2)=σ2+E2(X)=σ2+μ2,由我们矩可知: A 1 = 1 n ∑ i = 1 n X i , A n = 1 n ∑ i = 1 n X i 2 A_1=\frac{1}{n}\sum_{i=1}^nX_i,A_n=\frac{1}{n}\sum_{i=1}^{n}X_i^2 A1=n1∑i=1nXi,An=n1∑i=1nXi2,所以带入我们的式子中可知: μ = X ˉ , σ 2 = 1 n ∑ i = 1 n ( X i − X ˉ ) 2 \mu=\bar X,\sigma^2=\frac{1}{n}\sum_{i=1}^n(X_i-\bar X)^2 μ=Xˉ,σ2=n1∑i=1n(Xi−Xˉ)2

最大似然估计法

设总体分布为 f ( x , θ ) f(x,\theta) f(x,θ), X 1 , X 2 , . . . , X n X_1,X_2,...,X_n X1,X2,...,Xn为该总体采样得的样本,因 X 1 , X 2 , . . . , X n X_1,X_2,...,X_n X1,X2,...,Xn独立同分布,则它们的联合概率密度: L ( X 1 , X 2 , . . . , X n ; θ 1 , θ 2 , . . . , θ n ) = ∏ i = 1 n f ( X i ; θ 1 , . . . , θ n ) L(X_1,X_2,...,X_n;\theta_1,\theta_2,...,\theta_n)=\prod_{i=1}^nf(X_i;\theta_1,...,\theta_n) L(X1,X2,...,Xn;θ1,θ2,...,θn)=∏i=1nf(Xi;θ1,...,θn)

最大似然估计法是在总体分布类型已知条件下所使用的一种参数估计方法,基础是极大似然原理:概率大的事件在一次观测中更容易发生。因此最大似然估计发所选取的未知参数 θ \theta θ的依据是:当选取的 θ \theta θ作为估计值时,使样本出现的可能性最大,即概率最大

似然函数的构造

离散型: L ( θ ) = ∏ i = 1 n p ( x i ; θ ) = p ( x 1 , θ ) p ( x 2 , θ ) . . . p ( x n , θ ) L(\theta)=\prod_{i=1}^np(x_i;\theta)=p(x_1,\theta)p(x_2,\theta)...p(x_n,\theta) L(θ)=∏i=1np(xi;θ)=p(x1,θ)p(x2,θ)...p(xn,θ)

连续型: L ( θ ) = ∏ i = 1 n f ( x i ; θ ) = f ( x 1 , θ ) . . . f ( x n , θ ) L(\theta)=\prod_{i=1}^nf(x_i;\theta)=f(x_1,\theta)...f(x_n,\theta) L(θ)=∏i=1nf(xi;θ)=f(x1,θ)...f(xn,θ)

求解步骤

(1)构造似然函数 L ( θ ) L(\theta) L(θ)

(2)取对数: ln L ( θ ) \ln L(\theta) lnL(θ)

(3)令 ∂ ln L ( θ ) ∂ θ = 0 \frac{\partial \ln L(\theta)}{\partial \theta}=0 ∂θ∂lnL(θ)=0

(4)解方程 ∂ ln L ( θ ) ∂ θ = 0 \frac{\partial \ln L(\theta)}{\partial \theta}=0 ∂θ∂lnL(θ)=0,求得 θ \theta θ的最大似然估计量

参考资料

[1]概率论基础(4)五种重要的分布(二项、泊松、均匀、指数、正态分布)https://blog.csdn.net/wangqingbang/article/details/91869130

[2]二项分布、伯努利分布、泊松分布等 https://blog.csdn.net/u011947630/article/details/81508829

[3]期望, 方差, 协方差,标准差 https://blog.csdn.net/siyue0211/article/details/80309799