第2章 Kylin环境搭建

上篇:第1章 大数据Kylin之术语

1、安装地址

(1)官网地址

http://kylin.apache.org/cn/

(2)官方文档

http://kylin.apache.org/cn/docs/

(3)下载地址

http://kylin.apache.org/cn/download/

2、安装部署

(1)将apache-kylin-2.5.1-bin-hbase1x.tar.gz上传到Linux

(2)解压apache-kylin-2.5.1-bin-hbase1x.tar.gz到/opt/module

[root@hadoop105 hadoop]$ tar -zxvf apache-kylin-2.5.1-bin-hbase1x.tar.gz -C module/

注意:需要在/etc/profile文件中配置HADOOP_HOME,HIVE_HOME,HBASE_HOME并source使其生效。

kylin安装遇到的问题及解决方案

前提准备好进程环境:

启动Kylin之前要保证HDFS,YARN,ZK,HBASE相关进程是正常运行的。

查看进程:

[root@hadoop105 ~]# jps -l

78017 org.apache.hadoop.hbase.regionserver.HRegionServer

125808 org.apache.hadoop.util.RunJar

9393 -- process information unavailable

10260 org.apache.hadoop.hdfs.server.namenode.NameNode

10533 org.apache.hadoop.hdfs.server.namenode.SecondaryNameNode

10837 org.apache.hadoop.yarn.server.nodemanager.NodeManager

10713 org.apache.hadoop.yarn.server.resourcemanager.ResourceManager

11739 org.apache.zookeeper.server.quorum.QuorumPeerMain

77834 org.apache.hadoop.hbase.master.HMaster

126682 sun.tools.jps.Jps

11503 org.apache.hadoop.util.RunJar

kylin安装遇到的问题

报错问题一:

错误:

ERROR [main] curator.ConnectionState:200 : Connection timed out for connection string (hdp-01:2181:2181) and timeout (15000) / elapsed (89115)

原因:没有解析到zk的集群地址

解决方案:添加配置kylin.properties

[root@hadoop105 ~]# cd /usr/local/hadoop/module/kylin-2.5.0/conf/

[root@hadoop105 conf]# vim kylin.properties

//添加到文件配置参数:

kylin.env.zookeeper-connect-string=hdp-01:2181

报错问题二:

错误:

Web UI is at http://hdp-01.localdomain:7070/kylin

原因:没有配置hosts,默认使用127.0.0.1

解决方案:修改hosts映射

//添加到文件: vim /etc/hosts

192.168.xxx.xx hadoop105

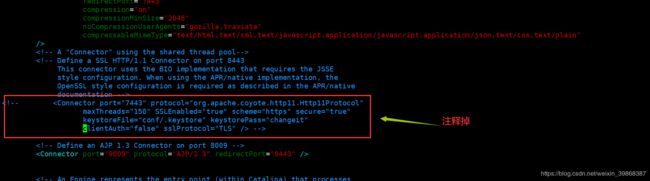

报错问题三:

报错信息

Failed to load keystore type JKS with pathconf/.keystore due to /home/hadoop/apache-kylin-2.0.0-bin/tomcat/conf/.keystore(没有那个文件或目录)

java.io.FileNotFoundException: /home/hadoop/apache-kylin-2.0.0-bin/tomcat/conf/.keystore(没有那个文件或目录)

at java.io.FileInputStream.open(Native Method)

原因:修改tomcat下的文件

解决方案:

修改tomcat下的https 在kylin内置tomcat的server.xml中里边有个对https的支持注释掉(84-87行)

报错问题四:

报错信息

java.io.FileNotFoundException: File does not exist: hdfs://hadoop105:9000/usr/local/hive/lib/hive-metastore-1.2.2.jar

在构建cube的时候,step3报错

看报错信息知道,我们希望是去本地安装目录下寻找jar包,但是默认去了hdfs上找,应该是配置的问题

解决方案:

将 $HADOOP_HOME下的/etc/hadoop/core-site.xml 复制一份到 $HBASE_HOME,并且把fs.defaultFS配置注释或者删掉

再重新构建,发现ok了

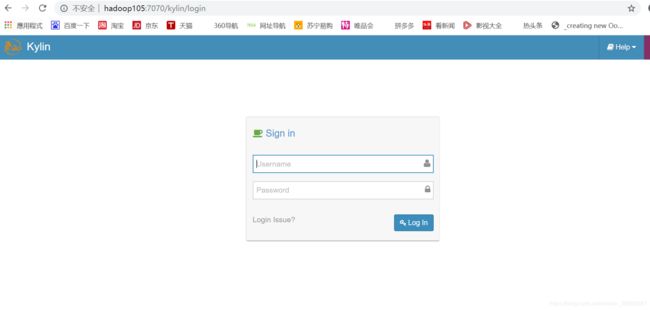

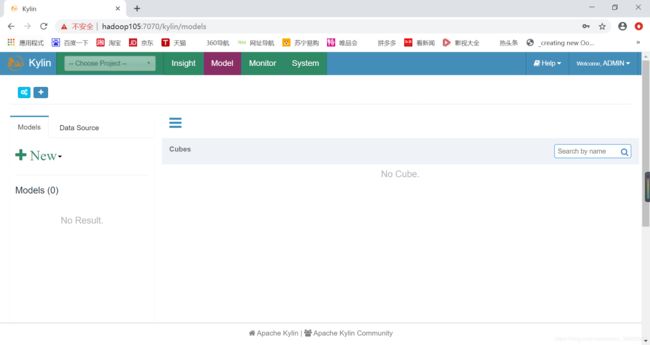

当问题解决后,进程也启动了,我们可以对其进行访问:

Web页面访问:http://hadoop105:7070/kylin