ELK日志分析平台-----实战(一)-----ES搜索引擎

ELK日志分析平台-----实战(一)-----ES搜索引擎

学习目标:

ELK主要由三个重要组件:

- elasticsearch搜索分析引擎

- logstash数据采集

- kibana可视化

##########elasticsearch实战#############

1.elasticsearch的简介

Elasticsearch 是一个开源的分布式搜索分析引擎,建立在一个全文搜索引擎库 Apache Lucene基础之上。

Elasticsearch 不仅仅是 Lucene,并且也不仅仅只是一个全文搜索引擎:

- 一个分布式的实时文档存储,每个字段 可以被索引与搜索

- 一个分布式实时分析搜索引擎

- 能胜任上百个服务节点的扩展,并支持 PB 级别的结构化或者非结构化数据

模块介绍

基础模块 功能

cluster: 管理集群状态,维护集群层面的配置信息。

alloction: 封装了分片分配相关的功能和策略。

discovery: 发现集群中的节点,以及选举主节点。

gateway: 对收到master广播下来的集群状态数据的持久化存储。

indices: 管理全局级的索引设置。

http: 允许通过JSON over HTTP的方式访问ES的API。

transport: 用于集群内节点之间的内部通信。

engine: 封装了对Lucene的操作及translog的调用。

elasticsearch应用场景:

-

信息检索

-

日志分析

-

业务数据分析

-

数据库加速

-

运维指标监控

官网:https://www.elastic.co/cn/

注意:我们下载软件时可以去这个网站下载,https://elasticsearch.cn/download/ 这个网站的速度快。

2.elasticsearch安装与配置

软件下载:

https://elasticsearch.cn/download/

安装软件:

#rpm -ivh jdk-8u171-linux-x64.rpm

#rpm -ivh elasticsearch-7.6.1.rpm //7.6版本自带jdk

[root@server4 ~]# rpm -ivh elasticsearch-7.6.1.rpm # 安装ES

修改配置文件:

# vim /etc/elasticsearch/elasticsearch.yml

cluster.name: my-es #集群名称

node.name: server4 #主机名需要解析

path.data: /var/lib/elasticsearch #数据目录

path.logs: /var/log/elasticsearch #日志目录

bootstrap.memory_lock: true #锁定内存分配

network.host: 192.168.43.74 #主机ip

http.port: 9200 #http服务端口

cluster.initial_master_nodes: ["server4"]

对配置文件进行修改之后,我们的服务是不能启动的,因为我们还需修改系统的限制

修改系统限制

# vim /etc/security/limits.conf 在最后添加以下内容:

elasticsearch soft memlock unlimited

elasticsearch hard memlock unlimited

elasticsearch - nofile 65536 #限定文件数量,不得大于内核限制(sysctl -a | grep file)

elasticsearch - nproc 4096 # 进程数

由于服务有systemd 启用,所以我们去指定systemd的系统限制:

vim /usr/lib/systemd/system/elasticsearch.service

## 在service语句块下添加以下内容###

LimitNOFILE=65535

LimitMEMLOCK=infinity

修改java虚拟机限制:

[root@server4 elasticsearch]# vim /etc/elasticsearch/jvm.options

-Xms1g

-Xmx1g

Xmx设置不超过物理RAM的50%,以确保有足够的物理RAM留给内核文件系统缓存。但不要超过32G。

这里我们应该给这台虚拟机2G的内存。

我们还需要去禁用交换分区,会影响数据的交互:

[root@server4 elasticsearch]# echo 0 > /proc/sys/vm/swappiness #数值越大越倾向于使用swap分区

[root@server4 elasticsearch]# cat /proc/sys/vm/swappiness

0

[root@server4 elasticsearch]# swapoff -a

[root@server4 elasticsearch]# vim /etc/fstab # 禁用掉开机自启

#/dev/mapper/rhel-swap swap swap defaults 0 0

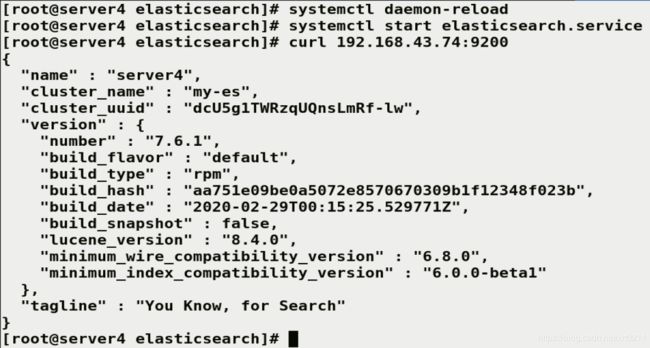

配置完以上步骤后,现在就可以启动了:

[root@server4 elasticsearch]# systemctl daemon-reload

[root@server4 elasticsearch]# systemctl start elasticsearch.service

[root@server4 elasticsearch]# curl 192.168.43.74:9200

{

"name" : "server4",

"cluster_name" : "my-es",

"cluster_uuid" : "dcU5g1TWRzqUQnsLmRf-lw",

"version" : {

"number" : "7.6.1",

"build_flavor" : "default",

"build_type" : "rpm",

"build_hash" : "aa751e09be0a5072e8570670309b1f12348f023b",

"build_date" : "2020-02-29T00:15:25.529771Z",

"build_snapshot" : false,

"lucene_version" : "8.4.0",

"minimum_wire_compatibility_version" : "6.8.0",

"minimum_index_compatibility_version" : "6.0.0-beta1"

},

"tagline" : "You Know, for Search"

}

但是,我们发现这样显然还不够刺激,我们想要给它加一个图形界面:

我们需要去下载插件:下载elasticsearch-head插件

wget https://github.com/mobz/elasticsearch-head/archive/master.zip

head插件本质上是一个nodejs的工程,因此需要安装node:

wget https://mirrors.tuna.tsinghua.edu.cn/nodesource/rpm_9.x/el/7/x86_64/nodejs9.11.2-1nodesource.x86_64.rpm

[root@server4 ~]# ls

master.zip # 需要这个插件

[root@server4 ~]# unzip master.zip

[root@server4 ~]# ls

elasticsearch-head-master master.zip

然后我们需要进入这个目录里面执行 npm 这个命令,这时我们安装node包

[root@server4 ~]# rpm -ivh nodejs-9.11.2-1nodesource.x86_64.rpm

warning: nodejs-9.11.2-1nodesource.x86_64.rpm: Header V4 RSA/SHA256 Signature, key ID 34fa74dd: NOKEY

Preparing... ################################# [100%]

Updating / installing...

1:nodejs-2:9.11.2-1nodesource ################################# [100%]

然后我们进入目录,由于npm install 很慢,所以我们更换一个仓库下载

[root@server4 ~]# cd elasticsearch-head-master/

[root@server4 elasticsearch-head-master]# npm install --registry=https://registry.npm.taobao.org

PhantomJS not found on PATH # 发现环境变量少了一个东西,

Downloading https://github.com/Medium/phantomjs/releases/download/v2.1.1/phantomjs-2.1.1-linux-x86_64.tar.bz2

Saving to /tmp/phantomjs/phantomjs-2.1.1-linux-x86_64.tar.bz2

# 让去这里下载

[root@server4 ~]# ls

phantomjs-2.1.1-linux-x86_64.tar.bz2 #下载好了

[root@server4 ~]# tar jxf phantomjs-2.1.1-linux-x86_64.tar.bz2

[root@server4 ~]# cd phantomjs-2.1.1-linux-x86_64/

[root@server4 phantomjs-2.1.1-linux-x86_64]# ls

bin ChangeLog examples LICENSE.BSD README.md third-party.txt

[root@server4 phantomjs-2.1.1-linux-x86_64]# cd bin/

[root@server4 bin]# ls

phantomjs

[root@server4 bin]# cp phantomjs /usr/local/bin/ # 复制这个二进制文件到环境变量就可以使用这个命令了

[root@server4 ~]# phantomjs

phantomjs: error while loading shared libraries: libfontconfig.so.1: #又缺少了一个库文件

[root@server4 ~]# yum install fontconfig-2.13.0-4.3.el7.x86_64 -y

[root@server4 ~]# phantomjs

phantomjs>

phantomjs>

# 就代表成功了

在重新npm install

[root@server4 elasticsearch-head-master]# npm install --registry=https://registry.npm.taobao.org

我们还要修改ES主机ip和端口:

[root@server4 elasticsearch-head-master]# cd _site/

[root@server4 _site]# ls

app.css app.js background.js base fonts i18n.js index.html lang manifest.json vendor.css vendor.js

[root@server4 _site]#

[root@server4 _site]# npm run start & # 启动head插件

[1] 17355

[root@server4 _site]#

> elasticsearch-head@0.0.0 start /root/elasticsearch-head-master

> grunt server

(node:17365) ExperimentalWarning: The http2 module is an experimental API.

Running "connect:server" (connect) task

Waiting forever...

Started connect web server on http://localhost:9100

^C

[root@server4 _site]# netstat -antlp |grep 9100

tcp 0 0 0.0.0.0:9100 0.0.0.0:* LISTEN 17365/grunt

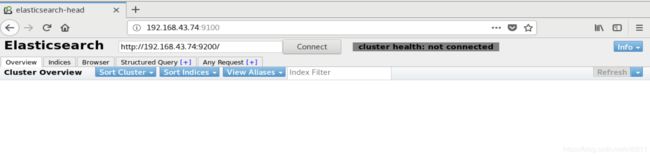

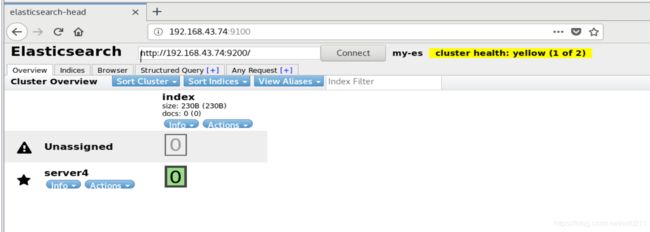

在浏览器访问是这样的,但是连接不成功,因为不允许跨域访问,所以我们应该修改ES跨域主持

[root@server4 _site]# vim /etc/elasticsearch/elasticsearch.yml

# Set a custom port for HTTP: #在下面添加两行内容

#

http.port: 9200

http.cors.enabled: true # 是否支持跨域

http.cors.allow-origin: "*" # *表示支持所有域名

systemctl restart elasticsearch.service # 重启服务

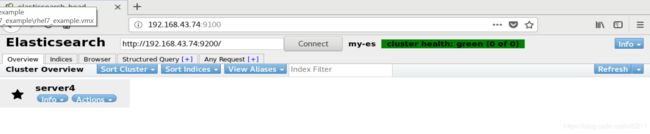

刷新一下:

加粗的是主分片,细的是辅分片,健康状态变成了黄色,代表主分片存在,辅分片丢失。如过变成了红色,就代表没有可用分片了。

3.elasticsearch分布式部署

以相同的方法再安装两个ES节点,配置如下:

[root@server4 _site]# ssh-keygen

[root@server4 _site]# ssh-copy-id server1

[root@server4 _site]# ssh-copy-id server2 # 做免密,然后将配置的文件全部复制过去

[root@server4 ~]# scp elasticsearch-7.6.1-x86_64.rpm server1:

[root@server4 ~]# scp elasticsearch-7.6.1-x86_64.rpm server2:

[root@server4 elasticsearch]# scp -p /etc/elasticsearch/elasticsearch.yml server1:/etc/elasticsearch/

[root@server4 elasticsearch]# scp -p /etc/elasticsearch/elasticsearch.yml server2:/etc/elasticsearch/

[root@server4 security]# scp /etc/security/limits.conf server1:/etc/security/

[root@server4 security]# scp /etc/security/limits.conf server2:/etc/security/

[root@server4 system]# scp /usr/lib/systemd/system/elasticsearch.service server1:/usr/lib/systemd/system/

[root@server4 system]# scp /usr/lib/systemd/system/elasticsearch.service server2:/usr/lib/systemd/system/

然后更改他们的配置文件:

vim /etc/elasticsearch/elasticsearch.yml

server4:

discovery.seed_hosts: ["server4", "server1", "server2"] # 改这里,其它不变

cluster.initial_master_nodes: ["server4","server1","server2"] # 需要多个master结点进行切换

server1:

node.name: server1

network.host: 192.168.43.71

discovery.seed_hosts: ["server4", "server1", "server2"]

cluster.initial_master_nodes: ["server4","server1","server2"]

server2:

node.name: server2

network.host: 192.168.43.72

discovery.seed_hosts: ["server4", "server2", "server1"]

cluster.initial_master_nodes: ["server4","server1","server2"]

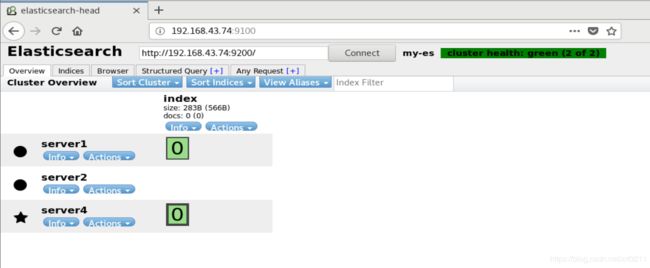

然后在三个结点都

systemctl daemon-reload

systemctl start elasticsearch.service # server1是restart

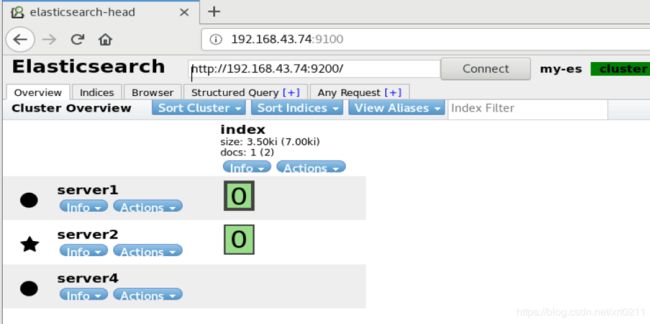

然后我们查看查看ES集群状态

当前server4 是master结点,其他两个是worker结点

elasticsearch节点角色

Master:

主要负责集群中索引的创建、删除以及数据的Rebalance等操作。Master不负责数据的索引和检索,所以负载较轻。当Master节点失联或者挂掉的时候,ES集群会自动从其他Master节点选举出一个Leader。

Data Node:

主要负责集群中数据的索引和检索,一般压力比较大。

Coordinating Node:

原来的Client node的,主要功能是来分发请求和合并结果的。所有节点默认就是Coordinating node,且不能关闭该属性。

Ingest Node:

专门对索引的文档做预处理

elasticsearch节点优化

在生产环境下,如果不修改elasticsearch节点的角色信息,在高数据量,高并发的场景下集群容易出现脑裂等问题。

默认情况下,elasticsearch集群中每个节点都有成为主节点的资格,也都存储数据,还可以提供查询服务。

节点角色是由以下属性控制:

- node.master: false|true

- node.data: true|false

- node.ingest: true|false

- search.remote.connect: true|false

默认情况下这些属性的值都是true。

node.master:这个属性表示节点是否具有成为主节点的资格

注意:此属性的值为true,并不意味着这个节点就是主节点。

因为真正的主节点,是由多个具有主节点资格的节点进行选

举产生的。

node.data:这个属性表示节点是否存储数据。

node.ingest: 是否对文档进行预处理。

search.remote.connect:是否禁用跨集群查询

我们现在就有五种组合:

第一种组合:(默认)

node.master: true

node.data: true

node.ingest: true

search.remote.connect: true

这种组合表示这个节点即有成为主节点的资格,又存储数据。

如果某个节点被选举成为了真正的主节点,那么他还要存储数据,这样对于这个节点的压力就比较大了。

测试环境下这样做没问题,但实际工作中不建议这样设置。

第二种组合:(Data node)

node.master: false

node.data: true

node.ingest: false

search.remote.connect: false

这种组合表示这个节点没有成为主节点的资格,也就不参与选举,只会存储数据。

这个节点称为data(数据)节点。在集群中需要单独设置几个这样的节点负责存储数据。后期提供存储和查询服务。

第三种组合:(master node)

node.master: true

node.data: false

node.ingest: false

search.remote.connect: false

这种组合表示这个节点不会存储数据,有成为主节点的资格,可以参与选举,有可能成为真正的主节点。

这个节点我们称为master节点。

第四种组合:(Coordinating Node)

node.master: false

node.data: false

node.ingest: false

search.remote.connect: false

这种组合表示这个节点即不会成为主节点,也不会存储数据,

这个节点的意义是作为一个协调节点,主要是针对海量请求的时候可以进行负载均衡。

第五种组合:(Ingest Node)

node.master: false

node.data: false

node.ingest: true

search.remote.connect: false

这种组合表示这个节点即不会成为主节点,也不会存储数据,

这个节点的意义是ingest节点,对索引的文档做预处理。

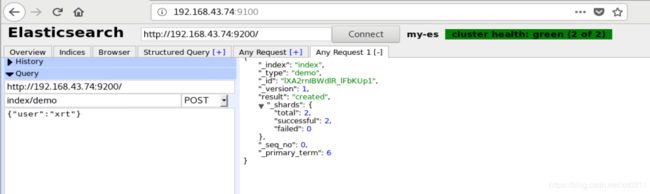

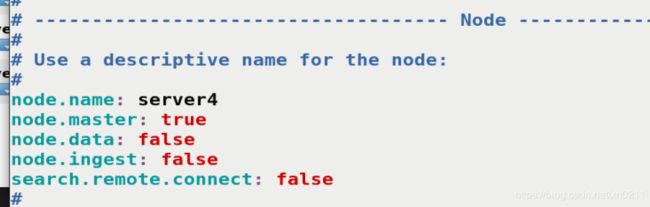

所以我们进行设置,来调整我们的集群:

在server4中:

vim /etc/elasticsearch/elasticsearch.yml

# ------------------------------------ Node ------------------------------------

#

# Use a descriptive name for the node:

#

node.name: server4

node.master: true

node.data: false

node.ingest: false

search.remote.connect: false

# 让他成为master节点

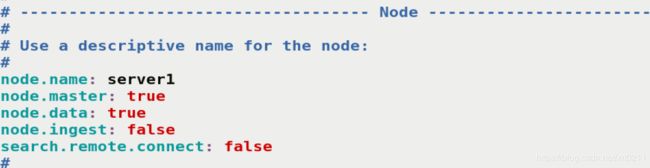

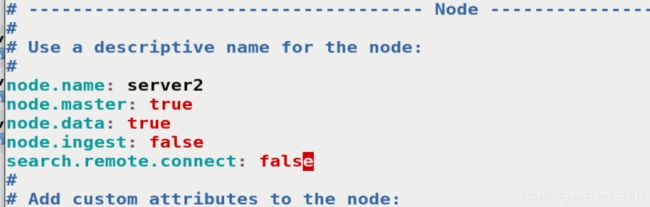

vim /etc/elasticsearch/elasticsearch.yml

# Use a descriptive name for the node:

#

node.name: server1

node.master: true

node.data: true

node.ingest: false

search.remote.connect: false

让他可以接管master,也存储数据

vim /etc/elasticsearch/elasticsearch.yml

# Use a descriptive name for the node:

#

node.name: server1

node.master: true

node.data: true

node.ingest: false

search.remote.connect: false

让他可以接管master,也存储数据,这里我们先不做预处理结点

然后重启三台服务,这时serve4是起不来的,是因为我们设置 不做存储结点,但是之前已经有数据了,所以我们要进行清理

[root@server4 bin]# pwd

/usr/share/elasticsearch/bin

[root@server4 bin]# ./elasticsearch-node repurpose

------------------------------------------------------------------------

WARNING: Elasticsearch MUST be stopped before running this tool.

23:38:49.741 [main] WARN org.elasticsearch.cluster.metadata.MetaData - Adding unknown custom object with type index_lifecycle

23:38:49.744 [main] WARN org.elasticsearch.cluster.metadata.MetaData - Adding unknown custom object with type licenses

Found 1 shards in 1 indices to clean up

Use -v to see list of paths and indices affected

Node is being re-purposed as master and no-data. Clean-up of shard data will be performed.

Do you want to proceed?

Confirm [y/N] y

Node successfully repurposed to master and no-data.

这时候,我们在刷新页面:

生产集群中可以对这些节点的职责进行划分

- 建议集群中设置3台以上的节点作为master节点,这些节点只负责成为主节点,维护整个集群的状态。

- 再根据数据量设置一批data节点,这些节点只负责存储数据,后期提供建立索引和查询索引的服务,这样的话如果用户请求比较频繁,这些节点的压力也会比较大。

- 所以在集群中建议再设置一批协调节点,这些节点只负责处理用户请求,实现请求转发,负载均衡等功能。

节点需求

- master节点:普通服务器即可(CPU、内存 消耗一般)

- data节点:主要消耗磁盘、内存。

path.data: data1,data2,data3

这样的配置可能会导致数据写入不均匀,建议只指定一个数据路径,磁盘可以使用raid0阵列,而不需要成本高的ssd。 - Coordinating节点:对cpu、memory要求较高。