C++ 实现决策树 ID3 算法

Reference

一步一步详解ID3和C4.5的C++实现

决策树之ID3算法

Notes

- ID3只能处理离散性的属性,属性的每一种取值就刚好对应于树上结点的一个分枝;

- 样本空间是字符串形式的,为了处理方便,对每个属性(包括 label)分别将它们的各种取值都映射为一个整数(离散化,数字化),主要是我是用

vector套vector的方式存样本空间,这样属性的取值又刚好与下标对应; - 也是为了方便,程序要求先输入样本个数、属性个数,还有每个属性的名字,在输出决策树时用;

Rendering

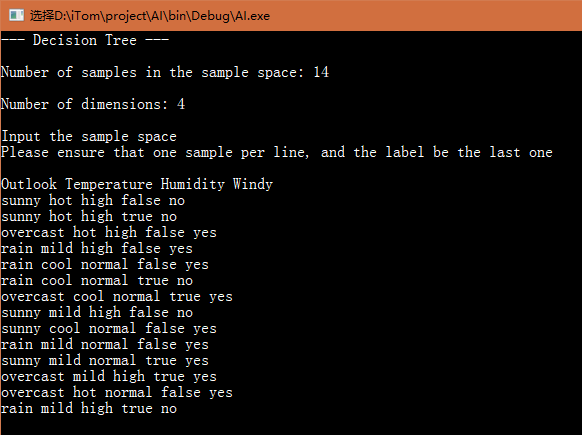

- 输入样本空间

其中,样本空间上面的那一行是属性名字,但没有 label 的名字

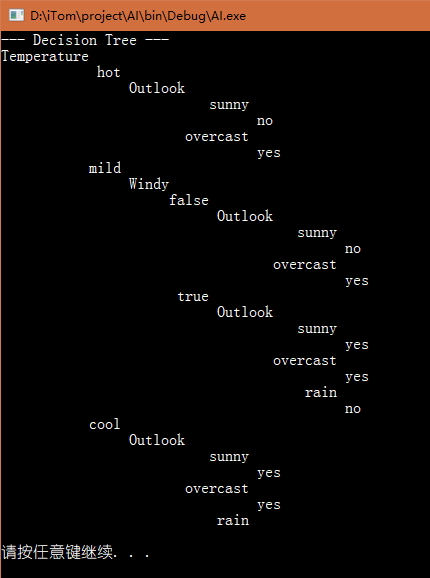

- 打印决策树

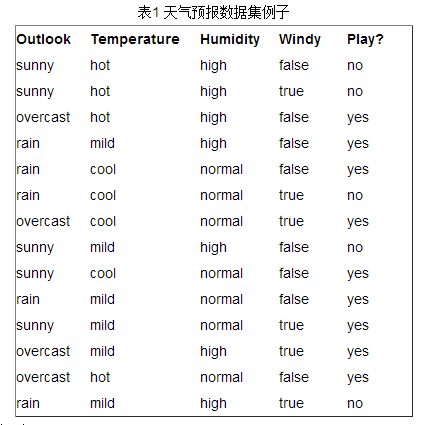

Sample Space

14 4

Outlook Temperature Humidity Windy

sunny hot high false no

sunny hot high true no

overcast hot high false yes

rain mild high false yes

rain cool normal false yes

rain cool normal true no

overcast cool normal true yes

sunny mild high false no

sunny cool normal false yes

rain mild normal false yes

sunny mild normal true yes

overcast mild high true yes

overcast hot normal false yes

rain mild high true noCode

决策树结点

struct dtNode

{

int n_child;

int attr_id;

int label;

vector决策树类

typedef vector<vector<int> > SampleSpace;

class DecisionTree

{

int n_dim;

int n_sample;

vector<string> attribute;

SampleSpace samspc;

vector<map<string,int> > dsc;

vector<map<int,string> > rev;

dtNode *root;

private:

void _formatting(const vector<vector<string> > &in_sample_space);

void _build(SampleSpace, dtNode *&);

bool _same_class(const SampleSpace &);

int _most_label(const SampleSpace &);

int _max_gain_attr(const SampleSpace &);

double _info_gain(const SampleSpace &, int attr);

SampleSpace _drop_attr(SampleSpace, int attr);

void _clear(dtNode *&);

void _print_tree(dtNode *, int indent);

public:

DecisionTree(int n_dimension, int n_sample);

~DecisionTree();

void input();

void build();

void display();

};完整代码

#include