gstreamer插件调用ffmpeg 详解

Gstreamer调用FFMPEG解析

----Gstreamer 是如何操作ffmpeg的,以及ffmpeg是如何demux的(AVI 容器格式为例)

AVI容器格式较为简单,所以这里用AVI为例,分析gstreamer如何通过ffmpeg来对多媒体文件demux,获得原始数据流。

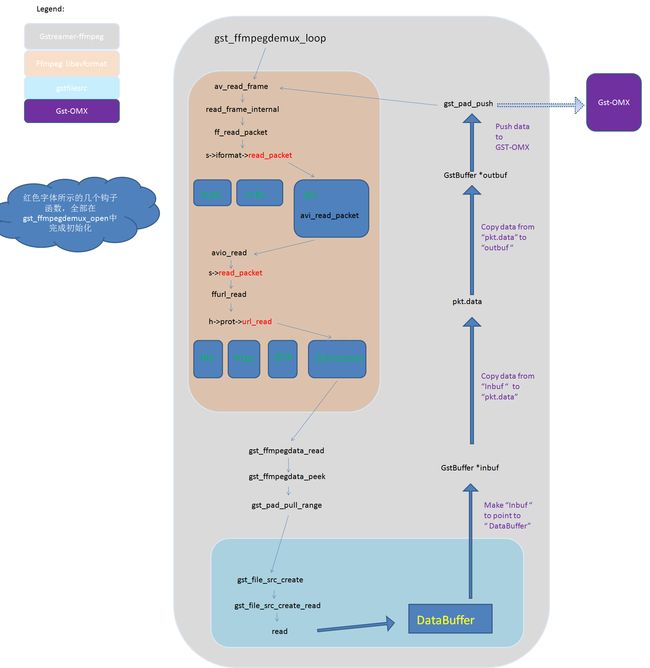

图一,框架

Gstreamer通过gst-ffmpeg插件,来管理文件container的demux,gst-ffmpeg通过ffmpeg的libavformat来具体实现对各种文件容器的demux。

1, 主循环建立在gst-ffmpeg插件中, gst_ffmpegdemux_loop

2,gst-ffmpeg调用ffmpeg的API av_read_frame , 来读取一个完整的帧数据

3,ffmpeg 在av_read_frame内部,完成demux工作

4,文件系统的读操作,由ffmpeg调用gstfilesrc插件的read来实现

5,一帧数据读出以后,由gst-ffmpeg利用gstreamer的pad push 机制,送到gst-OMX

6, pad push 到GST-OMX后,立即返回。OMX实质上采用异步的方式,送到解码器

2. Gstreamer调用Ffmpeg的调用链

下面图二在图一的基础上展示了各插件各模块之间的具体调用关系,就不用语言叙述了,对着代码看吧。。。

AVI格式是音频视频交错(Audio Video Interleaved)的英文缩写,它是Microsoft公司开发的一种符合RIFF文件规范的数字音频与视频文件格式,原先用于Microsoft Video for Windows (简称VFW)环境,现在已被Windows 95/98、OS/2等多数操作系统直接支持。AVI格式允许视频和音频交错在一起同步播放,支持256色和RLE压缩,但AVI文件并未限定压缩标准,因此,AVI文件格式只是作为控制界面上的标准,不具有兼容性,用不同压缩算法生成的AVI文件,必须使用相应的解压缩算法才能播放出来。常用的AVI播放驱动程序,主要是Microsoft Video for Windows或Windows 95/98中的Video 1,以及Intel公司的Indeo Video。

在介绍AVI文件前,我们要先来看看RIFF文件结构。AVI文件采用的是RIFF文件结构方式,RIFF(Resource Interchange File Format,资源互换文件格式)是微软公司定义的一种用于管理windows环境中多媒体数据的文件格式,波形音频wave,MIDI和数字视频AVI都采用这种格式存储。构造RIFF文件的基本单元叫做数据块(Chunk),每个数据块包含3个部分,

1、4字节的数据块标记(或者叫做数据块的ID)

2、数据块的大小

3、数据

整个RIFF文件可以看成一个数据块,其数据块ID为RIFF,称为RIFF块。一个RIFF文件中只允许存在一个RIFF块。RIFF块中包含一系列的子块,其中有一种字块的ID为"LIST",称为LIST,LIST块中可以再包含一系列的子块,但除了LIST块外的其他所有的子块都不能再包含子块。

RIFF和LIST块分别比普通的数据块多一个被称为形式类型(Form Type)和列表类型(List Type)的数据域,其组成如下:

1、4字节的数据块标记(Chunk ID)

2、数据块的大小

3、4字节的形式类型或者列表类型

4、数据

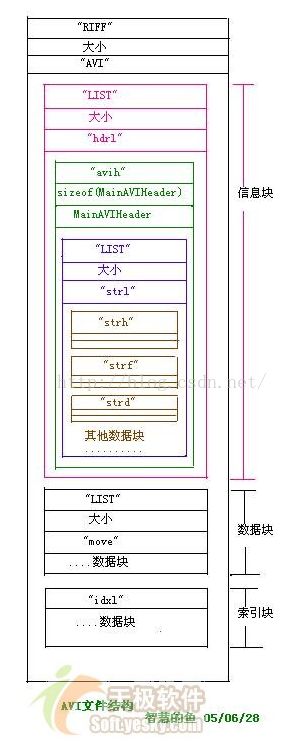

下面我们看看AVI文件的结构。AVI文件是目前使用的最复杂的RIFF文件,它能同时存储同步表现的音频视频数据。AVI的RIFF块的形式类型是AVI,它包含3个子块,如下所述:

1、信息块,一个ID为"hdrl"的LIST块,定义AVI文件的数据格式。

2、数据块,一个ID为 "movi"的LIST块,包含AVI的音视频序列数据。

3、索引块,ID为 "idxl"的子块,定义 "movi"LIST块的索引数据,是可选块。

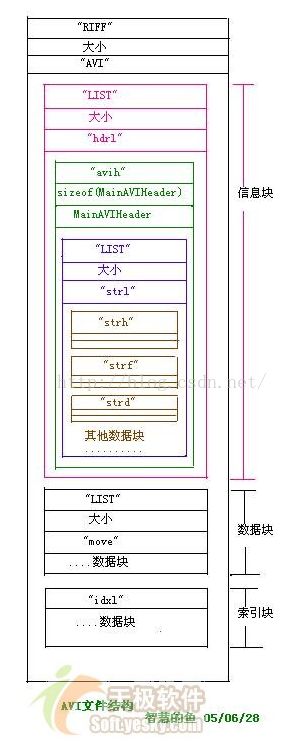

AVI文件的结构如下图所示,下面将具体介绍AVI文件的各子块构造。

1、信息块,信息块包含两个子块,即一个ID为 avih 的子块和一个ID 为 strl 的LIST块。

0 && image.height<0){if(image.width<=510){this.width=510;this.height=image.height*510/image.width;}}" border=0<

avih"子块的内容可由如下的结构定义:

"strl" LIST块用于记录AVI数据流,每一种数据流都在该LIST块中占有3个子块,他们的ID分别是"strh","strf", "strd";

"strh"子块由如下结构定义。

"strf"子块紧跟在"strh"子块之后,其结构视"strh"子块的类型而定,如下所述;如果 strh子块是视频数据流,则 strf子块的内容是一个与windows设备无关位图的BIMAPINFO结构,如下:

如果 strh子块是音频数据流,则strf子块的内容是一个WAVEFORMAT结构,如下:

"strd"子块紧跟在strf子块后,存储供压缩驱动程序使用的参数,不一定存在,也没有固定的结构。

"strl" LIST块定义的AVI数据流依次将 "hdrl " LIST 块中的数据流头结构与"movi" LIST块中的数据联系在一起,第一个数据流头结构用于数据流0,第二个用于数据流1,依次类推。

数据块中存储视频和音频数据流,数据可直接存于 "movi" LIST块中。数据块中音视频数据按不同的字块存放,其结构如下所述,

音频字块

"##wb"

Wave 数据流

视频子块中存储DIB数据,又分为压缩或者未压缩DIB,

"##db"

RGB数据流

"##dc"

压缩的图像数据流

看到了吧,avi文件的图像数据可以是压缩的,和非压缩格式的。对于压缩格式来说,也可采用不同的编码,也许你曾经遇到有些avi没法识别,就是因为编码方式不一样,如果没有相应的解码,你就没法识别视频数据。AVI的编码方式有很多种,比较常见的有 mpeg2,mpeg4,divx等。

索引块,索引快包含数据块在文件中的位置索引,能提高avi文件的读写速度,其中存放着一组AVIINDEXENTRY结构数据。如下,这个块并不是必需的,也许不存在。

(以上AVI介绍的文字来自网络)

下面图片是用AVI-mux GUI 工具得来的。可以比对上面文字了解AVI的具体格式。

4. Ffmpeg是如何demux AVI的

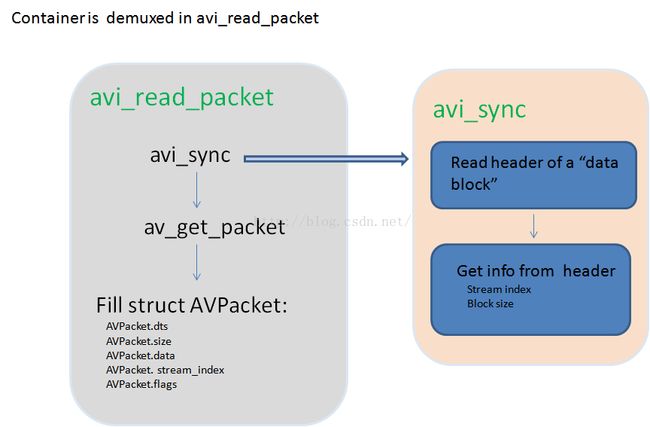

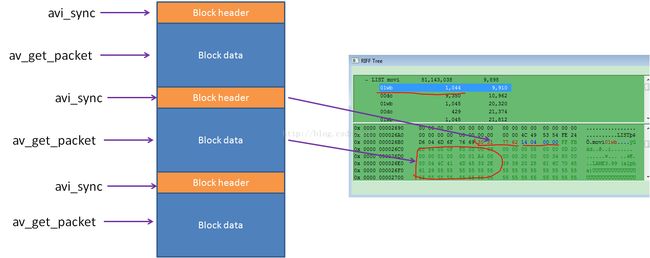

图三对图二中的函数avi_read_packet如何demux AVI 文件进行了具体描述。

我们知道,流数据存在于AVI 容器的"movi" LIST块中,每个块有个header,其中存储了这个块的流编号,流类型,块大小。Avi_sync通过读取并分析这个header,就能得到有效数据的位置和size。

然后由av_get_packet 来负责完成实际数据的读取,读取的数据存在AVPacket.data中。

读取完之后,就可以填充AVPacket结构体的成员。该结构体被带到上层后,上层程序就知道读到的数据的属性。

需要注意的是,avi_sync是avi 容器特有的函数,专门针对avi格式的demux工作。

av_get_packet则是ffmpeg读取有效数据时的通用函数。适用于多种容器格式。

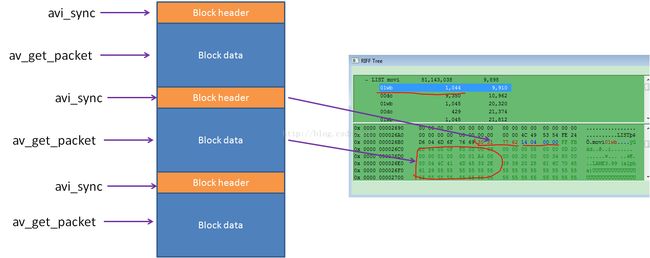

图四,avi_sync于av_get_packet

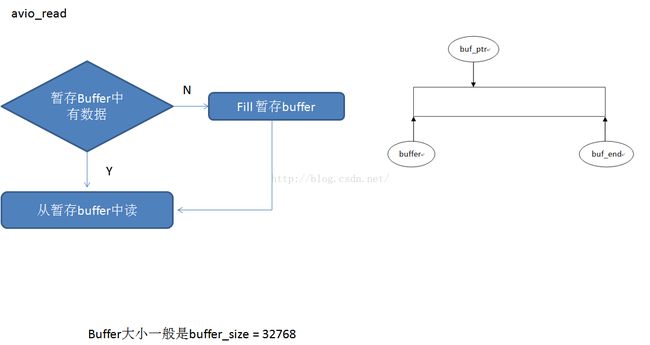

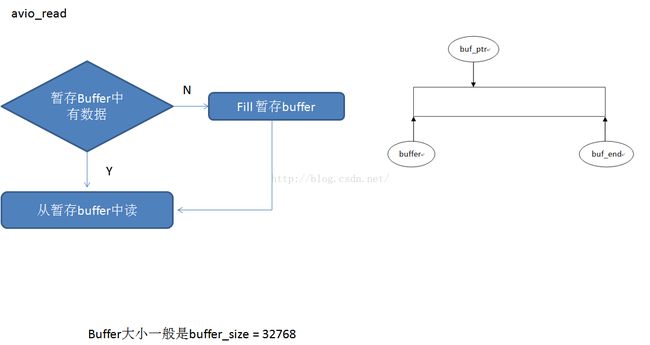

Ffmpeg在读取文件数据时,调用的是avio_read函数。为了提高对文件的读速度,avio_read做了优化。如图五所示。Avio_read读的数据始终是一个buffer中的数据,如果buffer中有数据,就直接读取,如果buffer中没数据,就调用read函数从文件系统中一次性读取若干字节,暂存到buffer中。然后再从buffer中读。这样避免了频繁小批量的读文件系统,提高了读速度。

图五,avio_read 优化

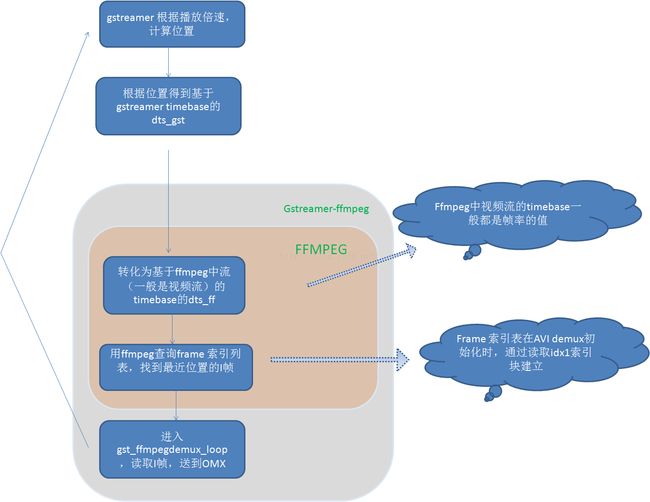

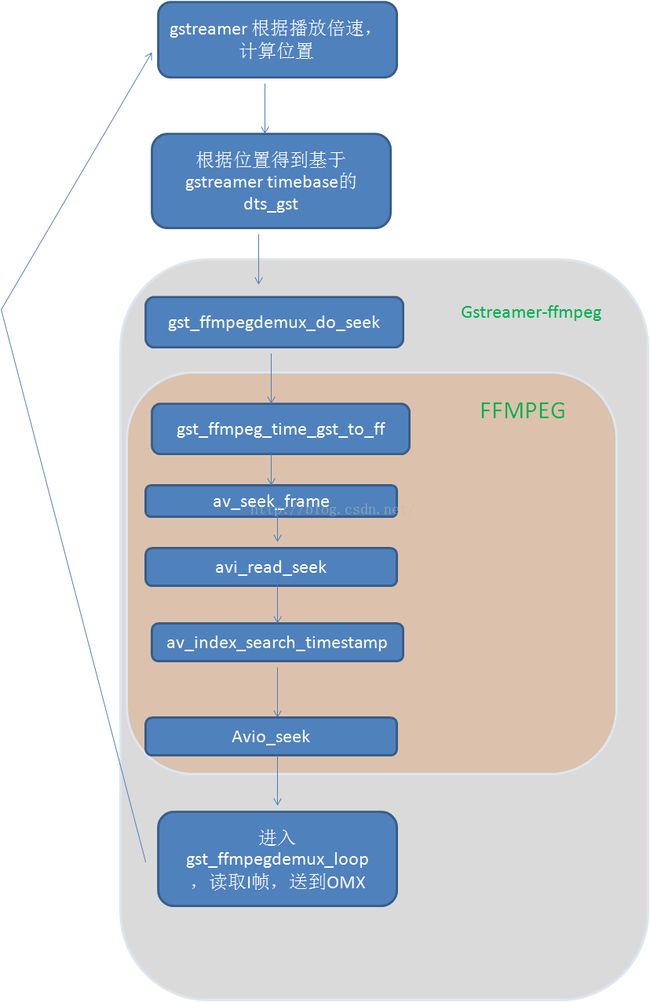

5. 快进快放功能是如何实现的

AVI容器如何实现快进快放功能也需要着重讲一下。

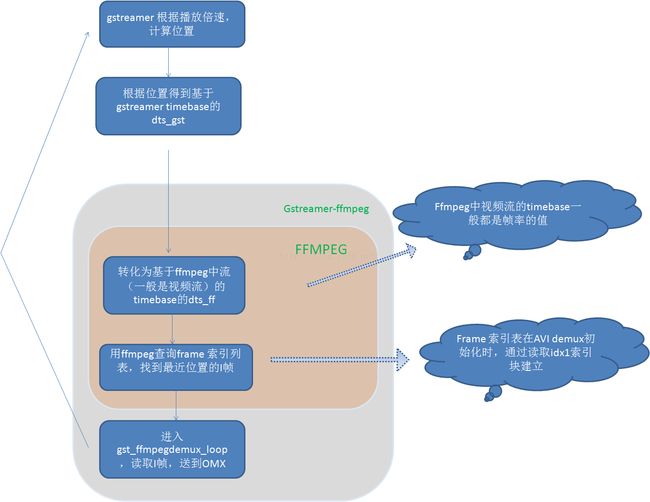

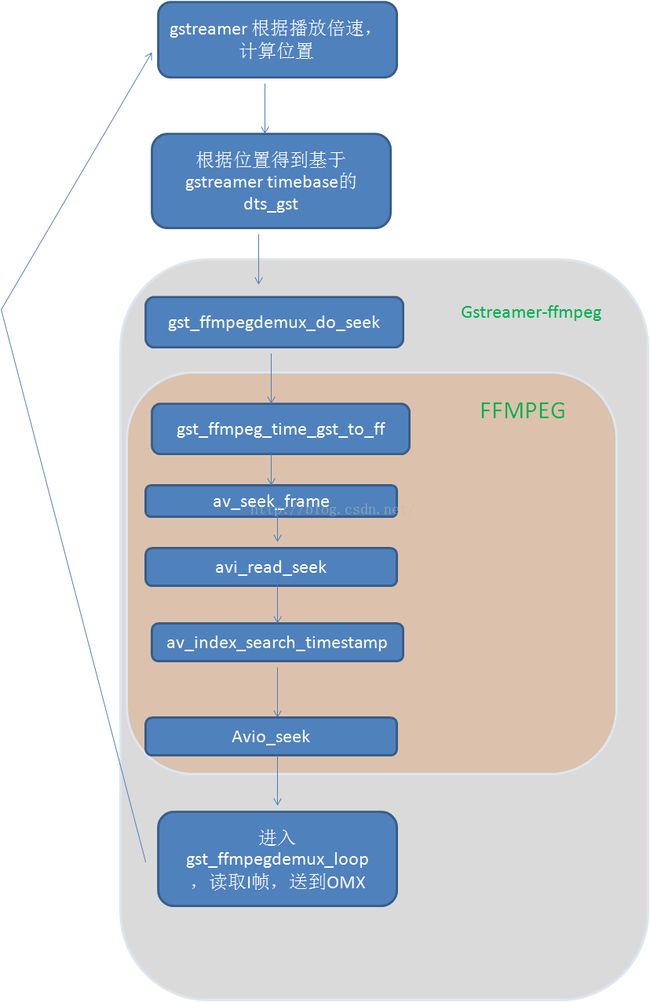

Gstreamer在快进的时候,计算偏移量和dts,使用的是自己的gstreamer time base,得到的dts是基于gstreamer time base的值。在交给ffmpeg的时候,需要转化成基于ffmpeg 中流自身timebase的dts,然后用这个dts查索引表,得到离这个dts最近的I帧位置,取得I帧,送给OMX。

对AVI文件来说,索引表的建立是在ffmpeg初始化读取AVI容器头的时候,通过读取idxl索引块来建立的。

图六,快进快放实现流程

图七, seek操作时调用链

6. 初始化时钩子的挂接

图二中,红色字体标示出了三处钩子函数。

(1) s->iformat->read_packet 取决于容器类型,对MVC, AVI,MP4等不同容器类型来说,这里的挂接函数不一样。这里以AVI文件类型为例,所以挂接了avi_read_packet 。

(2)s->read_packet 在ffmpeg中固定挂接成ffurl_read函数

len = s->read_packet(s->opaque, buf, size) ---》 ffurl_read

(此钩子在gst_ffmpegdemux_open--》av_open_input_file---》avformat_open_input---》init_input---》avio_open2---》ffio_fdopen--》avio_alloc_context--》ffio_init_context--》挂上)

(3)h->prot->url_read 取决于数据来源。对于分别有file,HTTP,RTSP,gstreamer,等不同来源。这里由于使用gstreamer的filesrc插件来读数据,所以选择了gstreamer源。挂接了gst_ffmpegdata_read函数。

h->prot->url_read ---》 gst_ffmpegdata_read

(次钩子在gst_ffmpegdemux_open--》av_open_input_file---》avformat_open_input---》init_input---》avio_open2---》ffurl_open---》ffurl_alloc---》url_alloc_for_protocol挂上)

这些钩子都是在gst_ffmpegdemux_open中完成挂接的。

----Gstreamer 是如何操作ffmpeg的,以及ffmpeg是如何demux的(AVI 容器格式为例)

AVI容器格式较为简单,所以这里用AVI为例,分析gstreamer如何通过ffmpeg来对多媒体文件demux,获得原始数据流。

1. Gstreamer,ffmpeg, OMX框架关系

图一,框架

Gstreamer通过gst-ffmpeg插件,来管理文件container的demux,gst-ffmpeg通过ffmpeg的libavformat来具体实现对各种文件容器的demux。

1, 主循环建立在gst-ffmpeg插件中, gst_ffmpegdemux_loop

2,gst-ffmpeg调用ffmpeg的API av_read_frame , 来读取一个完整的帧数据

3,ffmpeg 在av_read_frame内部,完成demux工作

4,文件系统的读操作,由ffmpeg调用gstfilesrc插件的read来实现

5,一帧数据读出以后,由gst-ffmpeg利用gstreamer的pad push 机制,送到gst-OMX

6, pad push 到GST-OMX后,立即返回。OMX实质上采用异步的方式,送到解码器

2. Gstreamer调用Ffmpeg的调用链

下面图二在图一的基础上展示了各插件各模块之间的具体调用关系,就不用语言叙述了,对着代码看吧。。。

图二,各模块调用链

AVI格式是音频视频交错(Audio Video Interleaved)的英文缩写,它是Microsoft公司开发的一种符合RIFF文件规范的数字音频与视频文件格式,原先用于Microsoft Video for Windows (简称VFW)环境,现在已被Windows 95/98、OS/2等多数操作系统直接支持。AVI格式允许视频和音频交错在一起同步播放,支持256色和RLE压缩,但AVI文件并未限定压缩标准,因此,AVI文件格式只是作为控制界面上的标准,不具有兼容性,用不同压缩算法生成的AVI文件,必须使用相应的解压缩算法才能播放出来。常用的AVI播放驱动程序,主要是Microsoft Video for Windows或Windows 95/98中的Video 1,以及Intel公司的Indeo Video。

在介绍AVI文件前,我们要先来看看RIFF文件结构。AVI文件采用的是RIFF文件结构方式,RIFF(Resource Interchange File Format,资源互换文件格式)是微软公司定义的一种用于管理windows环境中多媒体数据的文件格式,波形音频wave,MIDI和数字视频AVI都采用这种格式存储。构造RIFF文件的基本单元叫做数据块(Chunk),每个数据块包含3个部分,

1、4字节的数据块标记(或者叫做数据块的ID)

2、数据块的大小

3、数据

整个RIFF文件可以看成一个数据块,其数据块ID为RIFF,称为RIFF块。一个RIFF文件中只允许存在一个RIFF块。RIFF块中包含一系列的子块,其中有一种字块的ID为"LIST",称为LIST,LIST块中可以再包含一系列的子块,但除了LIST块外的其他所有的子块都不能再包含子块。

RIFF和LIST块分别比普通的数据块多一个被称为形式类型(Form Type)和列表类型(List Type)的数据域,其组成如下:

1、4字节的数据块标记(Chunk ID)

2、数据块的大小

3、4字节的形式类型或者列表类型

4、数据

下面我们看看AVI文件的结构。AVI文件是目前使用的最复杂的RIFF文件,它能同时存储同步表现的音频视频数据。AVI的RIFF块的形式类型是AVI,它包含3个子块,如下所述:

1、信息块,一个ID为"hdrl"的LIST块,定义AVI文件的数据格式。

2、数据块,一个ID为 "movi"的LIST块,包含AVI的音视频序列数据。

3、索引块,ID为 "idxl"的子块,定义 "movi"LIST块的索引数据,是可选块。

AVI文件的结构如下图所示,下面将具体介绍AVI文件的各子块构造。

1、信息块,信息块包含两个子块,即一个ID为 avih 的子块和一个ID 为 strl 的LIST块。

0 && image.height<0){if(image.width<=510){this.width=510;this.height=image.height*510/image.width;}}" border=0<

avih"子块的内容可由如下的结构定义:

typedef struct

{

DWORD dwMicroSecPerFrame ; //显示每桢所需的时间ns,定义avi的显示速率

DWORD dwMaxBytesPerSec; // 最大的数据传输率

DWORD dwPaddingGranularity; //记录块的长度需为此值的倍数,通常是2048

DWORD dwFlages; //AVI文件的特殊属性,如是否包含索引块,音视频数据是否交叉存储

DWORD dwTotalFrame; //文件中的总桢数

DWORD dwInitialFrames; //说明在开始播放前需要多少桢

DWORD dwStreams; //文件中包含的数据流种类

DWORD dwSuggestedBufferSize; //建议使用的缓冲区的大小,

//通常为存储一桢图像以及同步声音所需要的数据之和

DWORD dwWidth; //图像宽

DWORD dwHeight; //图像高

DWORD dwReserved[4]; //保留值

}MainAVIHeader;"strl" LIST块用于记录AVI数据流,每一种数据流都在该LIST块中占有3个子块,他们的ID分别是"strh","strf", "strd";

"strh"子块由如下结构定义。

typedef struct

{

FOURCC fccType; //4字节,表示数据流的种类 vids 表示视频数据流

//auds 音频数据流

FOURCC fccHandler;//4字节 ,表示数据流解压缩的驱动程序代号

DWORD dwFlags; //数据流属性

WORD wPriority; //此数据流的播放优先级

WORD wLanguage; //音频的语言代号

DWORD dwInitalFrames;//说明在开始播放前需要多少桢

DWORD dwScale; //数据量,视频每桢的大小或者音频的采样大小

DWORD dwRate; //dwScale /dwRate = 每秒的采样数

DWORD dwStart; //数据流开始播放的位置,以dwScale为单位

DWORD dwLength; //数据流的数据量,以dwScale为单位

DWORD dwSuggestedBufferSize; //建议缓冲区的大小

DWORD dwQuality; //解压缩质量参数,值越大,质量越好

DWORD dwSampleSize; //音频的采样大小

RECT rcFrame; //视频图像所占的矩形

}AVIStreamHeader;

"strf"子块紧跟在"strh"子块之后,其结构视"strh"子块的类型而定,如下所述;如果 strh子块是视频数据流,则 strf子块的内容是一个与windows设备无关位图的BIMAPINFO结构,如下:

typedef struct tagBITMAPINFO

{

BITMAPINFOHEADER bmiHeader;

RGBQUAD bmiColors[1]; //颜色表

}BITMAPINFO;

typedef struct tagBITMAPINFOHEADER

{

DWORD biSize;

LONG biWidth;

LONG biHeight;

WORD biPlanes;

WORD biBitCount;

DWORD biCompression;

DWORD biSizeImage;

LONG biXPelsPerMeter;

LONG biYPelsPerMeter;

DWORD biClrUsed;

DWORD biClrImportant;

}BITMAPINFOHEADER;如果 strh子块是音频数据流,则strf子块的内容是一个WAVEFORMAT结构,如下:

typedef struct

{

WORD wFormatTag;

WORD nChannels; //声道数

DWORD nSamplesPerSec; //采样率

DWORD nAvgBytesPerSec; //WAVE声音中每秒的数据量

WORD nBlockAlign; //数据块的对齐标志

WORD biSize; //此结构的大小

}WAVEFORMAT"strd"子块紧跟在strf子块后,存储供压缩驱动程序使用的参数,不一定存在,也没有固定的结构。

"strl" LIST块定义的AVI数据流依次将 "hdrl " LIST 块中的数据流头结构与"movi" LIST块中的数据联系在一起,第一个数据流头结构用于数据流0,第二个用于数据流1,依次类推。

数据块中存储视频和音频数据流,数据可直接存于 "movi" LIST块中。数据块中音视频数据按不同的字块存放,其结构如下所述,

音频字块

"##wb"

Wave 数据流

视频子块中存储DIB数据,又分为压缩或者未压缩DIB,

"##db"

RGB数据流

"##dc"

压缩的图像数据流

看到了吧,avi文件的图像数据可以是压缩的,和非压缩格式的。对于压缩格式来说,也可采用不同的编码,也许你曾经遇到有些avi没法识别,就是因为编码方式不一样,如果没有相应的解码,你就没法识别视频数据。AVI的编码方式有很多种,比较常见的有 mpeg2,mpeg4,divx等。

索引块,索引快包含数据块在文件中的位置索引,能提高avi文件的读写速度,其中存放着一组AVIINDEXENTRY结构数据。如下,这个块并不是必需的,也许不存在。

typedef struct

{

DWORD ckid; //记录数据块中子块的标记

DWORD dwFlags; //表示chid所指子块的属性

DWORD dwChunkOffset; //子块的相对位置

DWORD dwChunkLength; //子块长度

};

(以上AVI介绍的文字来自网络)

下面图片是用AVI-mux GUI 工具得来的。可以比对上面文字了解AVI的具体格式。

4. Ffmpeg是如何demux AVI的

图三对图二中的函数avi_read_packet如何demux AVI 文件进行了具体描述。

图三,ffmpeg demux AVI文件的流程。

我们知道,流数据存在于AVI 容器的"movi" LIST块中,每个块有个header,其中存储了这个块的流编号,流类型,块大小。Avi_sync通过读取并分析这个header,就能得到有效数据的位置和size。

然后由av_get_packet 来负责完成实际数据的读取,读取的数据存在AVPacket.data中。

读取完之后,就可以填充AVPacket结构体的成员。该结构体被带到上层后,上层程序就知道读到的数据的属性。

需要注意的是,avi_sync是avi 容器特有的函数,专门针对avi格式的demux工作。

av_get_packet则是ffmpeg读取有效数据时的通用函数。适用于多种容器格式。

图四,avi_sync于av_get_packet

Ffmpeg在读取文件数据时,调用的是avio_read函数。为了提高对文件的读速度,avio_read做了优化。如图五所示。Avio_read读的数据始终是一个buffer中的数据,如果buffer中有数据,就直接读取,如果buffer中没数据,就调用read函数从文件系统中一次性读取若干字节,暂存到buffer中。然后再从buffer中读。这样避免了频繁小批量的读文件系统,提高了读速度。

图五,avio_read 优化

5. 快进快放功能是如何实现的

AVI容器如何实现快进快放功能也需要着重讲一下。

Gstreamer在快进的时候,计算偏移量和dts,使用的是自己的gstreamer time base,得到的dts是基于gstreamer time base的值。在交给ffmpeg的时候,需要转化成基于ffmpeg 中流自身timebase的dts,然后用这个dts查索引表,得到离这个dts最近的I帧位置,取得I帧,送给OMX。

对AVI文件来说,索引表的建立是在ffmpeg初始化读取AVI容器头的时候,通过读取idxl索引块来建立的。

图六,快进快放实现流程

图七, seek操作时调用链

6. 初始化时钩子的挂接

图二中,红色字体标示出了三处钩子函数。

(1) s->iformat->read_packet 取决于容器类型,对MVC, AVI,MP4等不同容器类型来说,这里的挂接函数不一样。这里以AVI文件类型为例,所以挂接了avi_read_packet 。

s->iformat->read_packet(s, pkt) ----》 avi_read_packet

(此钩子在gst_ffmpegdemux_open--》av_open_input_file---》avformat_open_input挂上)(2)s->read_packet 在ffmpeg中固定挂接成ffurl_read函数

len = s->read_packet(s->opaque, buf, size) ---》 ffurl_read

(此钩子在gst_ffmpegdemux_open--》av_open_input_file---》avformat_open_input---》init_input---》avio_open2---》ffio_fdopen--》avio_alloc_context--》ffio_init_context--》挂上)

(3)h->prot->url_read 取决于数据来源。对于分别有file,HTTP,RTSP,gstreamer,等不同来源。这里由于使用gstreamer的filesrc插件来读数据,所以选择了gstreamer源。挂接了gst_ffmpegdata_read函数。

h->prot->url_read ---》 gst_ffmpegdata_read

(次钩子在gst_ffmpegdemux_open--》av_open_input_file---》avformat_open_input---》init_input---》avio_open2---》ffurl_open---》ffurl_alloc---》url_alloc_for_protocol挂上)

这些钩子都是在gst_ffmpegdemux_open中完成挂接的。