Facial Expression Recognition by De-expression Residue Learning

面部残余表情学习表情识别方法

摘要:

一个人的人脸表情是由表情和中性脸组成。在这篇文章中,我们提出通过识别面部表情通过提取表情组成部分的信息通过表情元素滤除的残余表情识别算法(DERL)。首先,通过cGAN训练一个生成模型。这个模型对于任何输入的人脸图片生成大致相当的中性脸。我们把它叫做de-expression是因为这个表情被这个生成模型筛选;然而,表情信息依旧在中间层记录。给定中性脸,不像以前使用像素级或者特征级的不同去识别表情,我们的新方法学习生成模型的中间层残留的残余表情。这个样的残留表情是重要的,因为它包含任何输入表情图片沉淀在生成模型的表情成分。七种公开的面部表情数据集在我们的试验中使用。两个数据集作为预训练,在CK+, Oulu-CASIA, MMI, BU-3DFE, and BP4D+.五个数据集上进行了评估。实验结果阐述了我们提出方法的优越性。

引言:

人脸表情识别的研究进行在各种变化的图片条件下,包括各种各样的头部姿势,光照条件,分辨率和隐藏。尽管在提高表情分类上取得了重大意义的突破,当前的主要挑战来自个体差异的巨大变化,例如:年龄,性别,种族背景和个人差异。不同的人由于不同的风格和不同的表情表达方式会展现出不同的表情。只有最近的论文工作开始着手这个方面的工作,把个人性格种族年龄等考虑在人脸表情分析中。 研究表明,人类有能力去识别面部表情通过比较表情脸和中性脸。换句话说,一个人脸表情可以用表情和中性脸组成。到现在,许多现存的工作利用图片差异和特征差异对于识别图片和中性图片去识别面部表情。然而,这个假定是中性脸是获得的。事实是,中性脸可能不能经常获得。为了减缓这个问题,这是一个要求取获得一个中性表情生成器在给定的表情输入上。生成对抗模型有能力取解决这个问题。为了训练一个生成模型,一个生成对抗框架利用其他的深度模型去(辨别器)和生成模型对抗而不是为这个生成器定义一个常用的损失函数。这个辨别器被设计用来区分采样来自生成的的训练数据;而发生器学会输出最大程度混淆鉴别器的样本。一个基础的GAN扩展是条件GAN,它能够通过额外的条件变化来学习不同的上下文信息。现有的工作将CNN和cGAN结合起来用于许多应用,包括facegeneration [7],边缘地图的对象重建[11]和对象属性操作[24]。

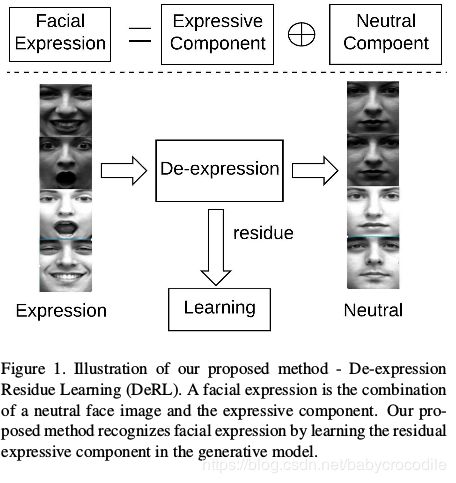

在这篇文章中,我们提出了一种新的方法叫做残余表情学习去学习面部表情通过提取表情残余手段。如图一所示,给定一个致力于面部表情的人脸,他的大致的中性表情被训练好的生成模型产生。经过这个步骤,当表达组件被移除时,主题的身份信息保持不变。我们把它叫做残余表情信息。尽管带有表达式的输入图像被“标准化”为中性表达式作为输出,但被过滤出来的表情成分仍然沉淀在生成模型中。换句话说,表情信息,在残余过程中表情信息被记录在生成器中。这样的沉淀是表情元素的残留。这是精确的表情成分我们想要在表情分类中使用。

相比于之前的对输入表情图片和中性图片用像素差异或特征水平差异的方法,我们提出的DERL框架学习残余在生成模型中的残余表情元素,试图去缓和个体特征的影响并提高面部表情识别能力。这项工作的贡献有两方面:

1、我们提出了一种新奇的方法去学习表情通过表情元素。我们首先训练一个生成模型去为查询的图片生成大致的中性脸;然后学习生成模型的的残留,这是为了减缓识别相关的变化因素。

2、我们提出的方法有能力处理无意识的表情、姿势表情、变化类型和种族背景等情形。他成功地提高了单数据集的识别能力,在交叉验证数据集上也比最先进的方法表现好。

2、相关工作

以前的工作表明使用中性脸对面部表情识别有益。从像素级或特征级别的相应面部表情图像中减去中性面部图像可以强调面部表情,同时减少类内变异。

Bazzo et al.[2]通过应用Gabor 小波在提取的中性脸上,获得了良好的识别率。Zafeiriou etal.[30]对于不同的图片应用稀疏面部表情表示,这是从表现中性图像中减去中性图像得出的,并证明使用中性图像往往强调移动的面部部分。Lee at al.[15]从训练集生成几个类内变异图像(包括中性),然后由待识别面部图像减去

获得不同的图像。 差异图像用于强调查询面部图像中的面部表情。

Kim et al.[13]在网络中采用对比表示来提取查询面部图像和中性面部图像之间的特征级别差异。

然而,这些先前的论文假设在给定相同主题的任何表达的情况下中性表达总是可用的,这是不现实的。根据需要从任何输入表情生成中性脸。最近的工具-GAN在展现出成功在这样的应用。Gauthier [7]试图用CGAN去生成特定属性的人脸,Radford et al. [24][24]尝试使用CNN来扩大GAN以模拟图像,并引入深度卷积生成对抗网络(DCGAN)的结构。这项工作展示了通过矢量算法操纵生成的面部样本的能力。Isola等。 [11]利用条件性逆向网络进行图像到图像的转换,并展示了许多有趣的应用,即从地图生成航空照片,从边缘地图重建物体,以及着色图像。此外,周等人[36] 应用cGAN来合成来自中性面部的面部表情图像。

到目前为止,已经使用查询图像和生成的中性图像的图像或特征差异,但是没有探索生成模型中记录的任何隐式表达信息。我们提出去探索表情信息,那些插入在生成器中,并且在中间层直接提取表情成分。事实上,这样的信息这种信息在去表达过程中由发生器“滤除”,而其表示(或残留)仍然存放在生成模型中,因此成为表示表达成分的关键信息。我们提出的方法不是同时使用查询图像和生成的中性人脸图像来训练具有对比度损失函数的深度模型(例如[13]),而是着重于学习生成模型的残差,从而有效地捕获表达成分和 对个体变化更加健壮。

3、提出方法 - DeRL

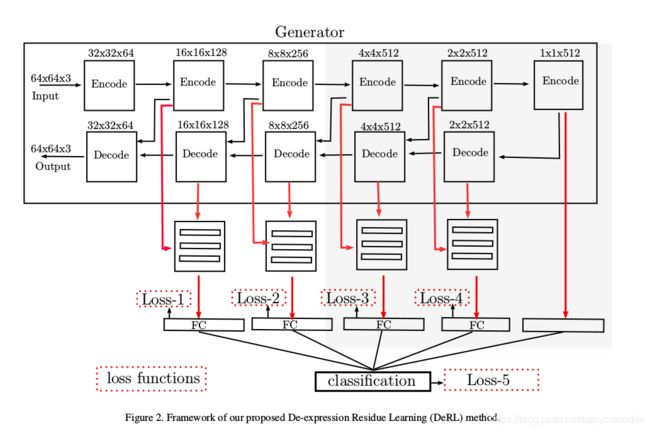

我们提出的DERL方法结构框架如图2。包含两个学习过程:第一步是通过cGANs学习中性脸生成器。第二步是从生成器中间层学习。输入图像对e.g. < I input , I target >,被用来训练cGANs.我输入的是显示任何表情的脸部图像,而我的目标是同一主题的中性脸部图像。在训练之后,生成器为任何输入重建相应的中性面部图像,同时保持身份信息不变。 从表情面部图像到中性面部图像,表达相关信息被记录为中间层中的表达成分。 对于第二学习过程,生成器的参数是固定的,并且中间层的输出被组合并输入到用于面部表情分类的深度模型中。

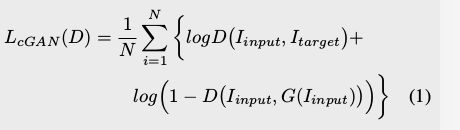

3.1中性脸生成器

cGAN被利用去通过给定的表情图片生成中性面部表示。一个GAN框架经常包含两个不同的部分,一个生成器(G),和一个判别器(d)训练发生器通过用鉴别器进行所谓的minmax游戏来恢复训练数据的分布。提供图像对用于训练cGAN.我输入首先输入到生成器中以重新构造I输出,然后和被赋予鉴别器。 鉴别器试图在生成器尝试时将与 output>区分开来.不仅最大限度地混淆鉴别器,而且还产生尽可能接近目标图像的图像。

鉴别器的目标表示为:

在这里,我们使用L1损失来获得图像相似度而不是L2,因为L2损失倾向于过度模糊输出图像[11]。 最终目标是:

3.2面部表情识别组成

经过中性脸生成,可以在像素级或者特征级通过比较中性脸和待识别表情来分析表情信息。然而,由于图像之间的变化,即旋转,平移和照明条件变化,像素级差异是不可靠的。即使没有表达式更改,这也会导致较大的像素级差异。 此外,特征级别差异是不稳定的,因为表达信息可能根据身份信息而变化。 由于查询图像和中性图像的差异记录在中间层中,我们利用表达式 直接从中间层中分解成分,以缓解上述问题,

我们用面部表情表示一个图像:I

在输入生成模型后,生成中性表达图像:

其中,G是生成器,E属于六种基本原型面部表情中的任何一种。 从等式(4),我们可以看到具有主题(A)和表达(E)的图像变为同一主题(A)的中性面部。可以合理地得出结论,每个人的独特表达信息(a.k.a.表达成分)必须记录在发生器的中间层中。 因此,我们提出了第二种学习策略,即直接从发生器的中间层学习表达式。 该独特信息也称为去表达残基(例如,参见图3)。

如图2所示,为了从发生器的中间层学习去表达残差,这些层的所有滤波器都是固定的,并且具有相同大小的所有层被连接并输入到本地CNN中。 面部表情分类模型。 对于每个本地CNN模型,代价函数被标记为损失i,i∈[1,2,3,4]。 每个本地CNN模型的最后完全连接的层被进一步连接并与用于面部表情分类的最后编码层组合。 因此,总损失函数定义为:

4.实验

提出的DeRL方法在五个公共面部表情数据库上进行评估,包括CK + [20],OuluCASIA [33],MMI [23]和BU-3DFE [29],以及自发表达数据库BP4D + [32]。 此外,另外两个带有表达式BU-4DFE [28]和自发表达式BP4D [31]的数据库用于预训练。

4.1实施细节

三个标志点(眼睛的中心和下巴)用于对准面部区域。对于未提供地标的数据库,我们将TSM [37]应用于人脸检测和地标定位。然后裁剪对齐的面部区域并将其尺寸调整为70×70的大小。为了避免过度补偿,我们应用数据增强方法来生成更多的训练数据。首先,从每个图像的五个位置(分别为中心和四个角)分别制作五个64×64个补丁。每个图像块分别旋转[-15o,-12o,-9o,-6o,-3o,0o,3o,6o,9o,12o,15o]。还应用水平移动。结果是增强数据集,比原始数据集大110倍。数据增强方法仅适用于训练数据。生成模型首先在BU4DFE [28]上预先训练,其中包含来自101个受试者的60,600个图像。每个受试者有六个序列,每个序列显示从中性到峰值表达的六个基本面部表情之一,再次以中性结束。为了构建训练数据集,每个序列的第一帧用作目标图像,并且序列的其余部分用作输入图像。预先训练的模型进一步在CK +,Oulu-CASIA,MMI,BU-3DFE和BP4D +数据库上进行了网络化。我们使用Adam优化器,批量大小为150,动量为0.9,在训练期间完全连接的层的丢失为0.5。我们使用200个时代来训练生成模型,并使用50个时期来进行面部表情分类模型。我们分别为损失函数设置λ1= 0.7,λ2= 0.5,λ3= 0.3,λ4= 0.2和λ5= 1.0。所提出的方法是使用GeForce GTX 1080平台上的张量流[1]实现的。

4.2.表达组件和再生中性面孔的可视化

图4分别示出了在CK +,Oulu-CASIA,BU-4DFE和BP4D +数据库上生成的中性面部图像的几个样本。第一列是输入图像,第三列是同一主体的地面实况中性面部图像,中间是生成模型的输出。如图所示,表达组件由生成模型过滤掉,同时保留与主题相关的信息。图3示出了来自CK +数据集的去表达残基的样本,它们分别是愤怒,厌恶,恐惧,快乐,悲伤和惊奇的表达成分。还显示每个表达组件的相应直方图。我们可以看到,表达组件和相应的直方图在六个表达式中是可区分的。

4.3表达识别结果

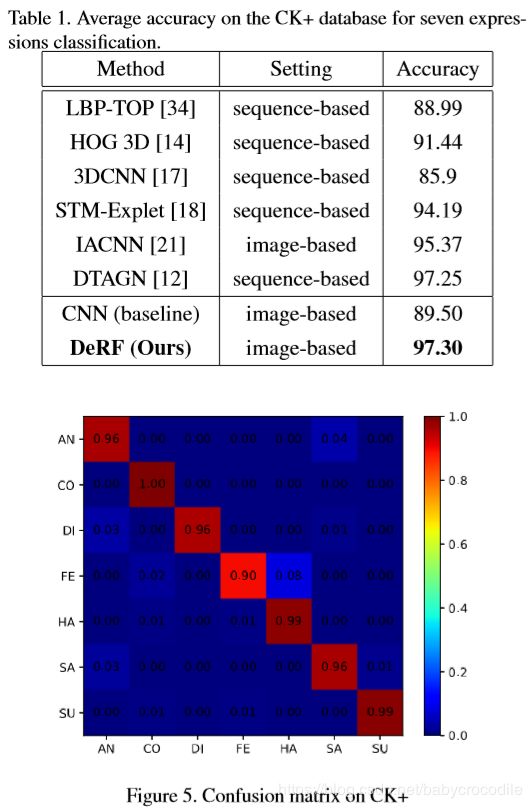

Extended Cohn-Kanade数据库(CK +)[20]广泛用于评估面部表情识别。它包含从123个科目收集的593个视频序列。其中,327个具有118个主题的视频序列被标记为七种表达之一,即从中性到高峰表达的愤怒,蔑视,厌恶,恐惧,快乐,悲伤和惊讶。仅标记每个序列的最后一帧,作为一般程序,我们使用提供的标签的每个序列的最后三个帧,其产生981个图像。基于身份以升序将图像进一步分成10倍,因此任何两个子集中的主体是互斥的。结果报告为10次运行的平均值。如表1所示,我们提出的DeRL方法实现了超过97%的识别率,优于最先进的比较方法。请注意,除了IACNN [21],CNN基线和我们的DeRL方法之外的所有这些方法都利用了从图像序列中提取的时间信息。 DTAGN [12]也利用了里程碑式的特征。与所有其他方法相比,我们提出的DeRL方法在识别静态图像上的面部表情方面表现良好,与IACNN相比实现了约2%的改善[21]。图5是我们方法的混淆矩阵,其中恐惧表达显示最低识别率,90%。

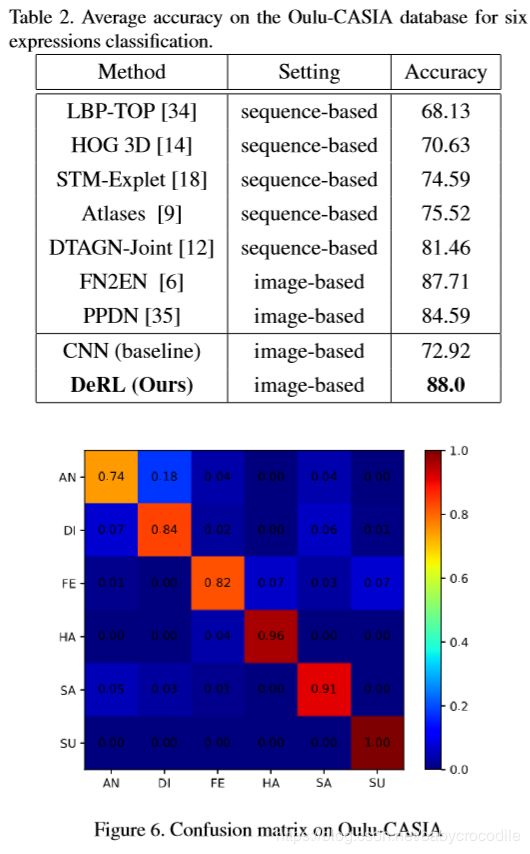

ulu-CASIA数据库[33]包含使用两种类型的相机在三种不同照明条件下捕获的数据。在实验期间,仅使用利用VIS相机在强照条件下捕获的数据。 Oulu-CASIA VIS拥有480个视频序列,取自80个主题和每个视频序列被标记为六个基本表达式之一。与CK +数据库类似,每个视频序列从中性面开始,以峰面部表情结束。为了包括更多数据,选择每个序列的最后三个帧。与CK +中的实验设置类似,进行10倍受试者独立的交叉验证。表10显示了在10次运行中识别Oulu-CASIA上六个表达式的平均准确度。与最先进的方法相比,我们的DeRL方法实现了最高的准确度,包括基于CNN的方法(DTAGN-Joint [12],FN2EN [6]和PPDN [35])和基于手工制作的特征方法( LBP-TOP [34],HOG 3D [14]和STM-Explet [18])。请注意,只有FN2EN [6],PPDN [35]和我们的DeRL方法使用静态图像进行面部表情识别,而其他方法则利用视频序列的时间信息。混淆矩阵如图6所示,我们的方法在识别表达幸福和惊喜方面表现得非常好,而愤怒表现出相对较低的识别率,这主要与厌恶相混淆。

MMI数据库[23]由236个图像组成表淬灭了31名受试者。每个序列被标记为六个基本面部表情之一。我们选择了在正面视图中捕获的208个序列。每个序列以中性表达开始,在序列中间附近达到峰值表达,并以中性表达结束。由于标签仅针对整个序列给出,因此我们在每个序列的中间选择三个帧作为峰值帧并将它们与提供的标签相关联。这导致具有624个图像的数据集。与CK +数据库设置类似,执行10倍主题独立交叉验证。表3报告MMI数据库上10次运行的平均准确度,用于识别六个表达式。尽管STM-Explet [18]显示出最高的75.12%的准确度,但它采用了从视频序列中提取的时间信息。我们的DeRL方法显示了73.23%的接近结果,它仅基于静态图像识别面部表情,这更适合于视频序列不可用的某些应用。与IACNN [21](也是基于图像的方法)相比,我们的DeRL方法显示出1.7%的改善。如图7中的混淆矩阵所示,恐惧相对难以识别,大多与惊讶和厌恶相混淆。另一方面,快乐相对容易分类。

BU-3DFE数据库[29]包含2,500对静态3D人脸模型和来自100个具有各种年龄和种族的受试者的纹理图像。对于每个受试者,捕获了具有四个强度水平和中性表达的六个基本表达。在实验期间,仅使用纹理图像和高强度表达(即最后两个级别)。执行10倍交叉验证,并且拆分是独立的。表4总结了BU-3DFE数据库上10次运行的平均结果。从数据我们可以发现,我们提出的方法明显优于其他两种基于图像的方法。请注意,基于多模态的方法(2D + 3D)[16]比单模态方法表现更好。然而,与多模态融合方法相比,我们的单模态(基于图像)DeRL方法实现了接近的性能。从BU-3DFE数据库的混淆矩阵图8可以看出,惊喜相对容易识别,显示出96%的识别率,而恐惧识别率相对较低,并且大多与厌恶和幸福相混淆。

BP4D + [32]是一种多模态自发情绪语料库(MMSE),包括来自140名受试者的同步3D,2D,热,生理数据序列(例如,心率,血压,皮肤电导(EDA)和呼吸率)。男性和82名女性)年龄在18至66岁之间。尽管数据库提供FACS代码,但每个帧都没有可用的面部表情标签。为了评估自发表达数据库BP4D +,我们基于FACS代码在四个任务中半自动地从72个受试者(45个女性和27个男性)中选择2468个帧。在实验中,我们仅使用2D纹理图像和四种表达(即,快乐,惊讶,疼痛和中性)。执行10倍交叉验证,并且分割是独立的。正如我们在表5中所看到的,当BP4D +上进行训练和测试时,我们提出的方法优于CNN基线。

为了进一步验证我们的DeRL方法,我们还进行了跨数据库验证,以识别四种表达(即幸福,惊讶,痛苦和中立)。我们选择自发表达数据库BP4D [31]进行训练,选择BP4D +进行测试。与BP4D +上的标记过程类似,我们还以半自动方式基于AU代码标记了BP4D数据库中所有41个主题的1262个帧。实验结果表明,跨数据库验证的性能低于同一数据库验证,但仍然可以与CNN基线进行比较。

4.4。内部层的分类

生成模型的内部层对识别率有不同的贡献。正如我们在图10中看到的,本地CNN-1和CNN-2模型显示出比CNN-3和CNN-4高得多的识别率。因此,对于公式(5)中的总损耗的组合,其中λ1和λ2具有比λ3和λ4更大的权重。这种组合在个体数据集上实现了最高的识别率。

5.结论

在本文中,我们提出了一种新的面部表情识别方法,它基于去表达残留学习(a.k.a. DeRL)。首先,由cGAN训练生成模型以再生任何查询图像的中性面部图像。其次,在生成模型的内部层上执行学习过程。学习过程能够捕获已经记录在生成模型中的面部表情的表达成分。我们提出的方法在posed和spontaneous表达式数据集上进行了评估。在不利用时间信息的情况下,DeRL方法优于基线CNN方法,最先进的基于图像的方法,甚至大多数利用时空信息的最先进的基于序列的方法。还进行跨数据库验证以显示从生成模型的中间层提取表达组分的有效性。这种表达组件可扩展用于面部动作单元检测。我们未来的工作将结合具有时间信息的表达组件来解决AU检测的问题,以及具有各种头部姿势和微妙面部变化的3D面部分析。

6.致谢

该材料基于美国国家科学基金会在CNS-1629898和CNS-1205664的资助下所支持的工作。