- 集群介绍

- keepalived介绍

- 用keepalived配置高可用集群

- 负载均衡集群介绍

- LVS介绍

- LVS调度算法

- LVS NAT模式搭建

1. 集群介绍

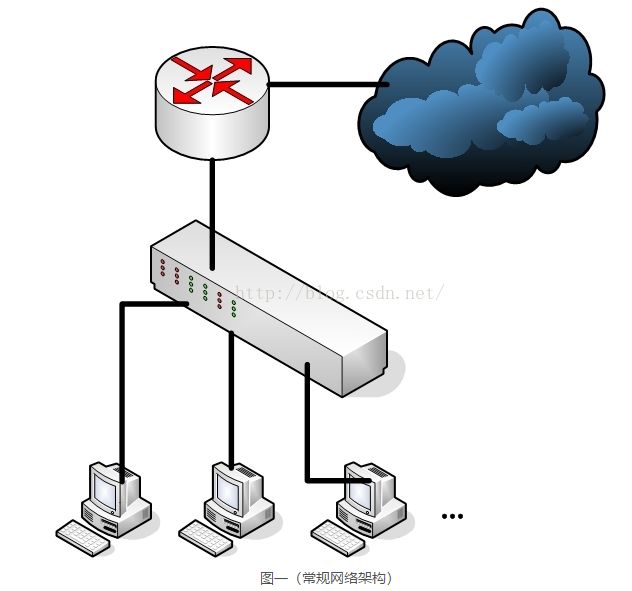

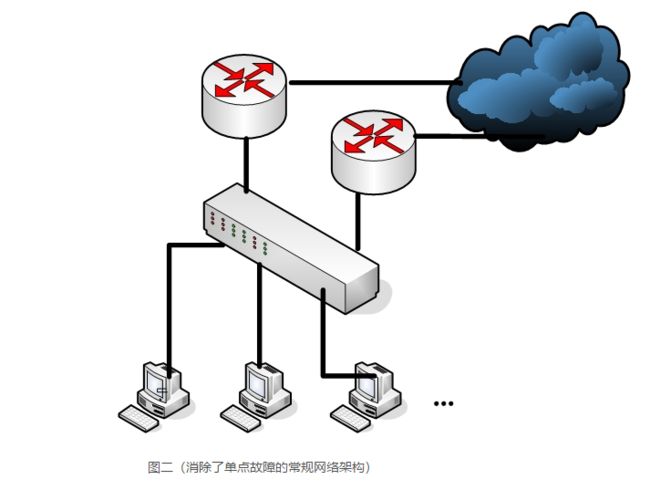

- 根据功能划分为两大类:高可用和负载均衡

- 高可用集群通常为两台服务器,一台工作,另外一台作为冗余,当提供服务的机器宕机,

冗余将接替继续提供服务

- 实现高可用的开源软件有:heartbeat、keepalived

- 负载均衡集群,需要有一台服务器作为分发器,它负责把用户的请求分发给后端的服务器处理,

在这个集群里,除了分发器外,就是给用户提供服务的服务器了,这些服务器数量至少为2

- 实现负载均衡的开源软件有LVS、keepalived、haproxy、nginx,商业的有F5、Netscaler

2. keepalived介绍

- 在这里我们使用keepalived来实现高可用集群,因为heartbeat在centos6上有一些问题,影响实验效果

- keepalived通过VRRP(Virtual Router Redundancy Protocl)来实现高可用。

- 在这个协议里会将多台功能相同的路由器组成一个小组,这个小组里会有1个master角色和N(N>=1)个backup角色。

- master会通过组播的形式向各个backup发送VRRP协议的数据包,当backup收不到master发来的VRRP数据包时,

就会认为master宕机了。此时就需要根据各个backup的优先级来决定谁成为新的mater。

- Keepalived要有三个模块,分别是core、check和vrrp。其中core模块为keepalived的核心,

负责主进程的启动、维护以及全局配置文件的加载和解析,check模块负责健康检查,vrrp模块是来实现VRRP协议的。

3. 用keepalived配置高可用集群

准备两台机器132和133,132作为master,133作为backup

两台机器都执行yum install -y keepalived

两台机器都安装nginx,其中133上已经编译安装过nginx,132上需要yum安装nginx: yum install -y nginx

设定vip为100

编辑132上keepalived配置文件,

vim /etc/keepalived/keepalived.conf

global_defs {

notification_email {

[email protected]

}

notification_email_from [email protected]

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_script chk_nginx {

script "/usr/local/sbin/check_ng.sh"

interval 3

}

vrrp_instance VI_1 {

state MASTER

interface ens33

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass aminglinux>com

}

virtual_ipaddress {

192.168.188.100

}

track_script {

chk_nginx

}

}

编辑132监控脚本

vim /usr/local/sbin/check_ng.sh

#!/bin/bash

#时间变量,用于记录日志

d=`date --date today +%Y%m%d_%H:%M:%S`

#计算nginx进程数量

n=`ps -C nginx --no-heading|wc -l`

#如果进程为0,则启动nginx,并且再次检测nginx进程数量,

#如果还为0,说明nginx无法启动,此时需要关闭keepalived

if [ $n -eq "0" ]; then

/etc/init.d/nginx start

n2=`ps -C nginx --no-heading|wc -l`

if [ $n2 -eq "0" ]; then

echo "$d nginx down,keepalived will stop" >> /var/log/check_ng.log

systemctl stop keepalived

fi

fi

给脚本755权限

chmod 755 /usr/local/sbin/check_ng.sh

启动keepalived

systemctl start keepalived

[root@mylinux sbin]# ps -aux |grep keep

root 8939 0.0 0.1 122876 1412 ? Ss 00:25 0:00 /usr/sbin/keepalived -D

root 8940 0.0 0.3 125000 3144 ? S 00:25 0:00 /usr/sbin/keepalived -D

root 8941 0.0 0.2 125000 2444 ? S 00:25 0:00 /usr/sbin/keepalived -D

root 8964 0.0 0.0 112724 988 pts/0 R+ 00:25 0:00 grep --color=auto keep

[root@mylinux sbin]# ps -aux |grep nginx

root 8842 0.0 0.2 125004 2116 ? Ss 00:02 0:00 nginx: master process /usr/sbin/nginx

nginx 8843 0.0 0.3 125392 3156 ? S 00:02 0:00 nginx: worker process

root 8973 0.0 0.0 112724 988 pts/0 R+ 00:26 0:00 grep --color=auto nginx

#说明:

#如果停掉nginx后keepalived无法拉起nginx

#则检查脚本拉起nginx的命令

#配置文件中定义的脚本路径

#检查脚本权限

#检查keepalived服务是否启动、重启

#检查防火墙:iptables -nvL

#检查selinux:getenforce→Disabled

#back上操作

133上编辑配置文件

vim /etc/keepalived/keepalived.conf

bal_defs {

notification_email {

[email protected]

}

notification_email_from [email protected]

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

vrrp_script chk_nginx {

script "/usr/local/sbin/check_ng.sh"

interval 3

}

vrrp_instance VI_1 {

state BACKUP

interface ens33

virtual_router_id 51

priority 90

advert_int 1

authentication {

auth_type PASS

auth_pass aminglinux>com

}

virtual_ipaddress {

192.168.88.100

}

track_script {

chk_nginx

}

}

133上编辑监控脚本

vim /usr/local/sbin/check_ng.sh

#时间变量,用于记录日志

d=`date --date today +%Y%m%d_%H:%M:%S`

#计算nginx进程数量

n=`ps -C nginx --no-heading|wc -l`

#如果进程为0,则启动nginx,并且再次检测nginx进程数量,

#如果还为0,说明nginx无法启动,此时需要关闭keepalived

if [ $n -eq "0" ]; then

/etc/init.d/nginx start

n2=`ps -C nginx --no-heading|wc -l`

if [ $n2 -eq "0" ]; then

echo "$d nginx down,keepalived will stop" >> /var/log/check_ng.log

systemctl stop keepalived

fi

fi

给脚本755权限

chmod 755 /usr/local/sbin/check_ng.sh

133上也启动服务 systemctl start keepalived

测试高可用

关闭主上的keepalived

systemctl stop keepalived vip立马到从上

开启主上的keepalived

systemctl start keepalived vip立马到主上

MySQL做高可用必须保证两边数据一样

4. 负载均衡集群介绍

- 主流开源软件LVS、keepalived、haproxy、nginx等

- 其中LVS属于4层(网络OSI 7层模型),nginx属于7层,haproxy既可以认为是4层,也可以当做7层使用

- keepalived的负载均衡功能其实就是lvs

- lvs这种4层的负载均衡是可以分发除80外的其他端口通信的,比如MySQL的,而nginx仅仅支持http,https,mail,haproxy也支持MySQL这种

- 相比较来说,LVS这种4层的更稳定,能承受更多的请求,而nginx这种7层的更加灵活,能实现更多的个性化需求

5. LVS介绍

- LVS是由国人章文嵩开发

- 流行度不亚于apache的httpd,基于TCP/IP做的路由和转发,稳定性和效率很高

- LVS最新版本基于Linux内核2.6,有好多年不更新了

- LVS有三种常见的模式:

NAT、就是转发

DR、更改mac地址(arp)

IP Tunnel、目标ip做了一个更高改

- LVS架构中有一个核心角色叫做分发器(Load balance),它用来分发用户的请求,

还有诸多处理用户请求的服务器(Real Server,简称rs)

6. LVS调度算法

轮询 Round-Robin rr

加权轮询 Weight Round-Robin wrr

最小连接 Least-Connection lc

加权最小连接 Weight Least-Connection wlc

基于局部性的最小连接 Locality-Based Least Connections lblc

带复制的基于局部性最小连接 Locality-Based Least Connections with Replication lblcr

目标地址散列调度 Destination Hashing dh

源地址散列调度 Source Hashing sh

7. LVS NAT模式搭建

三台机器

分发器,也叫调度器(简写为dir)

内网:133.130,外网:147.144(vmware仅主机模式)

rs1

内网:133.132

rs2

内网:133.133

三台机器

分发器,也叫调度器(简写为dir)

内网:133.130,外网:142.147(vmware仅主机模式)

rs1

内网:133.132,设置网关为133.130

rs2

内网:133.133,设置网关为133.130

三台机器上都执行执行

systemctl stop firewalld; systemc disable firewalld

systemctl start iptables-services; iptables -F; service iptables save

在dir上安装ipvsadm

yum install -y ipvsdam

在dir上编写脚本,vim /usr/local/sbin/lvs_nat.sh//内容如下

#! /bin/bash

# director 服务器上开启路由转发功能

echo 1 > /proc/sys/net/ipv4/ip_forward

# 关闭icmp的重定向

echo 0 > /proc/sys/net/ipv4/conf/all/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/default/send_redirects

# 注意区分网卡名字,阿铭的两个网卡分别为ens33和ens37

echo 0 > /proc/sys/net/ipv4/conf/ens33/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/ens37/send_redirects

# director 设置nat防火墙

iptables -t nat -F

iptables -t nat -X

iptables -t nat -A POSTROUTING -s 192.168.133.0/24 -j MASQUERADE

# director设置ipvsadm

IPVSADM='/usr/sbin/ipvsadm'

$IPVSADM -C

$IPVSADM -A -t 192.168.147.144:80 -s wlc -p 3

$IPVSADM -a -t 192.168.147.144:80 -r 192.168.133.132:80 -m -w 1

$IPVSADM -a -t 192.168.147.144:80 -r 192.168.133.133:80 -m -w 1

NAT模式效果测试

两台rs上都安装nginx

设置两台rs的主页,做一个区分,也就是说直接curl两台rs的ip时,得到不同的结果

浏览器里访问192.168.142.147,多访问几次看结果差异

总结

集群:就是多台机器一起为我们提供工作

负载均衡集群、高可用集群、分布式集群

ARRP 虚拟路由冗余协议

VRRP路由器:运行VRRP协议一个或多个实例的路由器

虚拟路由器:由一个Master路由器和多个Backup路由器组成。其中, 无论Master路由器还是Backup路由器都是一台VRRP路由器,下行设备将虚拟路由器当做默认网关。

VRID:虚拟路由器标识,在同一个VRRP组内的路由器必须有相同的VRID,其实VRID就相当于一个公司的名称, 每个员工介绍自己时都要包含公司名称,表明自己是公司的一员,同样的道理,VRID表明了这个路由器属于这个VRRP组。

Master路由器:虚拟路由器中承担流量转发任务的路由器

Backup路由器:当一个虚拟路由器中的Master路由器出现故障时,能够代替Master路由器工作的路由器

虚拟IP地址:虚拟路由器的IP地址,一个虚拟路由器可以拥有一个或多个虚拟IP地址。

IP地址拥有者:接口IP和虚拟路由器IP地址相同的路由器就叫做IP地址拥有者。

主IP地址:从物理接口设置的IP地址中选择,一个选择规则是总是选用第一个IP地址,VRRP通告报文总是用主IP地址作为该报文IP包头的源IP。

虚拟MAC地址:组成方式是00-00-5E-00-01-{VRID},前三个字节00-00-5E是IANA组织分配的,接下来的两个字节00-01是为VRRP协议指定的,最后的VRID是虚拟路由器标识,取值范围[1,255]

集群的特点

1)高性能performance

2)性价比

3)可伸缩性

4)高可用性

lvs集群

NAT

NAT(Network Address Translation)是一种外网和内网地址映射的技术。

NAT 模式下,网络报的进出都要经过 LVS 的处理。LVS 需要作为 RS 的网关。

当包到达 LVS 时,LVS 做目标地址转换(DNAT),将目标 IP 改为 RS 的 IP。RS 接收到包以后,仿佛是客户端直接发给它的一样。

RS 处理完,返回响应时,源 IP 是 RS IP,目标 IP 是客户端的 IP。

这时 RS 的包通过网关(LVS)中转,LVS 会做源地址转换(SNAT),将包的源地址改为 VIP,这样,这个包对客户端看起来就仿佛是 LVS 直接返回给它的。客户端无法感知到后端 RS 的存在。

DR

请求由 LVS 接受,由真实提供服务的服务器(RealServer, RS)直接返回给用户,返回的时候不经过 LVS。

DR 模式下需要 LVS 和绑定同一个 VIP(RS 通过将 VIP 绑定在 loopback 实现)。

一个请求过来时,LVS 只需要将网络帧的 MAC 地址修改为某一台 RS 的 MAC,该包就会被转发到相应的 RS 处理,注意此时的源 IP 和目标 IP 都没变,LVS 只是做了一下移花接木。

RS 收到 LVS 转发来的包,链路层发现 MAC 是自己的,到上面的网络层,发现 IP 也是自己的,于是这个包被合法地接受,RS 感知不到前面有 LVS 的存在。

而当 RS 返回响应时,只要直接向源 IP(即用户的 IP)返回即可,不再经过 LVS。

DR 模式是性能最好的一种模式。

tun

隧道传输ipip:不修改请求报文ip首部,而是通过ip隧道机制在原有的ip报文之外在封装ip首部,经由互联网把请求报文交给选定的rs;

架构特性:

(1)RIP,DIP,VIP都是公网地址;

(2)RS的网关不能,也不可能指向DIP;

(3)请求报文由Director分发,但响应报文直接由RS响应给Client;

(4)不支持端口映射;

(5)RS的OS必须得支持IP隧道,现在只有linux系统支持,windows,bsfdb等不支持;

Full-NAT

无论是 DR 还是 NAT 模式,不可避免的都有一个问题:LVS 和 RS 必须在同一个 VLAN 下,否则 LVS 无法作为 RS 的网关。

这引发的两个问题是:

1、同一个 VLAN 的限制导致运维不方便,跨 VLAN 的 RS 无法接入。

2、LVS 的水平扩展受到制约。当 RS 水平扩容时,总有一天其上的单点 LVS 会成为瓶颈。

Full-NAT 由此而生,解决的是 LVS 和 RS 跨 VLAN 的问题,而跨 VLAN 问题解决后,LVS 和 RS 不再存在 VLAN 上的从属关系,可以做到多个 LVS 对应多个 RS,解决水平扩容的问题。

Full-NAT 相比 NAT 的主要改进是,在 SNAT/DNAT 的基础上,加上另一种转换,转换过程如下:

在包从 LVS 转到 RS 的过程中,源地址从客户端 IP 被替换成了 LVS 的内网 IP。

内网 IP 之间可以通过多个交换机跨 VLAN 通信。

当 RS 处理完接受到的包,返回时,会将这个包返回给 LVS 的内网 IP,这一步也不受限于 VLAN。

LVS 收到包后,在 NAT 模式修改源地址的基础上,再把 RS 发来的包中的目标地址从 LVS 内网 IP 改为客户端的 IP。

Full-NAT 主要的思想是把网关和其下机器的通信,改为了普通的网络通信,从而解决了跨 VLAN 的问题。采用这种方式,LVS 和 RS 的部署在 VLAN 上将不再有任何限制,大大提高了运维部署的便利性。