- 探索安全的开发之路:Eclipse Steady深度揭秘

尚竹兴

探索安全的开发之路:EclipseSteady深度揭秘steadyEclipseSteady:这是一个开源的持续集成和持续部署工具,用于自动化软件的开发和部署过程。它提供了一个基于Web的界面,用于创建和管理软件项目的构建和部署流程。适合用于需要自动化软件开发和部署的开发团队。特点包括简单易用、丰富的插件生态系统和与Maven和Jenkins的紧密集成。项目地址:https://gitcode.c

- 探索终端的新境界:Scurses与Onions框架深度揭秘

雷竹榕

探索终端的新境界:Scurses与Onions框架深度揭秘ScursesScurses,terminaldrawingAPIforScala,andOnions,aScursesframeworkforeasyterminalUI项目地址:https://gitcode.com/gh_mirrors/sc/Scurses在数字化的今天,终端不仅是命令行交互的简单界面,它成为了开发人员和系统管理员的

- 探索简明虚拟机新纪元 —— SSVM 深度揭秘与应用指南

殷巧或

探索简明虚拟机新纪元——SSVM深度揭秘与应用指南SSVMJavaVMrunningonaJVM项目地址:https://gitcode.com/gh_mirrors/ssv/SSVM在当今软件开发的浩瀚宇宙中,一种名为SSVM(StupidlySimpleVM)的轻量级虚拟机正悄然兴起,承诺为开发者带来前所未有的灵活性与效率。本文将深入剖析SSVM的核心特性,探讨其技术实现,展示应用场景,并揭示

- 阿里云全球节点:技术无国界,开发者如何借力数字新基建

AWS官方合作商

阿里云云计算服务器

在全球化进程加速的今天,开发者与企业的技术需求早已跨越地理边界。无论是跨境电商的数据同步、游戏出海的低延迟保障,还是跨国团队的高效协作,服务器的地理位置与稳定性直接决定了业务的成败。阿里云作为国内最早布局全球化基础设施的云服务商之一,其海外服务器的核心价值并非简单的“资源覆盖”,而是通过技术架构与本地化服务,为开发者构建了一张无缝连接的“数字高速公路”。一、全球化的本质:不止于服务器,而是技术普惠

- Java 大视界 -- Java 大数据在智能医疗远程会诊与专家协作中的技术支持(146)

青云交

大数据新视界Java大视界java大数据智能医疗远程会诊专家协作数据安全病例诊断

亲爱的朋友们,热烈欢迎来到青云交的博客!能与诸位在此相逢,我倍感荣幸。在这飞速更迭的时代,我们都渴望一方心灵净土,而我的博客正是这样温暖的所在。这里为你呈上趣味与实用兼具的知识,也期待你毫无保留地分享独特见解,愿我们于此携手成长,共赴新程!一、欢迎加入【福利社群】点击快速加入:青云交灵犀技韵交响盛汇福利社群点击快速加入2:2024CSDN博客之星创作交流营(NEW)二、本博客的精华专栏:大数据新视

- python中的递归、回调函数以及闭包总结

敲代码敲到头发茂密

Python成长之路python开发语言

这里写目录标题一、递归例1:利用递归函数计算1到10的和例2:利用递归函数计算10的阶乘二、回调函数特别注意:在函数中的调用函数分为以下情况:1、同步回调2、异步回调三、闭包一、递归作用:在函数内部调用自己若干次例1:利用递归函数计算1到10的和defsum_num(num):ifnum>=1:sum=num+sum_num(num-1)else:sum=0returnsumprint(sum_n

- 一篇文章带你了解-selenium工作原理详解

程序员笑笑

软件测试selenium测试工具软件测试自动化测试功能测试程序人生职场和发展

前言Selenium是一个用于Web应用程序自动化测试工具。Selenium测试直接运行在浏览器中,就像真正的用户在操作一样。支持的浏览器包括IE(7,8,9,10,11),MozillaFirefox,Safari,GoogleChrome,Opera等。主要功能包括:测试与浏览器的兼容性——测试你的应用程序看是否能够很好得工作在不同浏览器和操作系统之上。测试系统功能——创建回归测试检验软件功能

- 使用Pygame实现记忆拼图游戏

点我头像干啥

Aipygamepython开发语言

引言记忆拼图游戏是一种经典的益智游戏,玩家需要通过翻转卡片来匹配相同的图案。这类游戏不仅能够锻炼玩家的记忆力,还能带来很多乐趣。本文将详细介绍如何使用Pygame库来实现一个简单的记忆拼图游戏。我们将从Pygame的基础知识开始,逐步构建游戏的各个部分,最终完成一个完整的游戏。1.Pygame简介Pygame是一个用于编写视频游戏的Python库,它基于SDL库(SimpleDirectMedia

- 《Python实战进阶》No28: 使用 Paramiko 实现远程服务器管理

带娃的IT创业者

Python实战进阶python服务器开发语言

No28:使用Paramiko实现远程服务器管理摘要在现代开发与运维中,远程服务器管理是必不可少的一环。通过SSH协议,我们可以安全地连接到远程服务器并执行各种操作。Python的Paramiko模块是一个强大的工具,能够帮助我们实现自动化任务,如代码部署、批量命令执行和文件传输。本集将深入讲解Paramiko的核心功能,并通过实战案例展示如何高效管理远程服务器。核心概念和知识点SSH协议的基本原

- Selenium工作原理详解

天才测试猿

selenium测试工具自动化测试软件测试测试用例python职场和发展

Selenium是一个用于Web应用程序自动化测试工具。Selenium测试直接运行在浏览器中,就像真正的用户在操作一样。支持的浏览器包括IE(7,8,9,10,11),MozillaFirefox,Safari,GoogleChrome,Opera等。主要功能包括:测试与浏览器的兼容性——测试你的应用程序看是否能够很好得工作在不同浏览器和操作系统之上。测试系统功能——创建回归测试检验软件功能和用

- 云原生周刊丨CIO 洞察:Kubernetes 解锁 AI 新纪元

KubeSphere 云原生

云原生kubernetes人工智能

开源项目推荐DRANETDRANET是由谷歌开发的K8s网络驱动程序,利用K8s的动态资源分配(DRA)功能,为高吞吐量和低延迟应用提供高性能网络支持。它旨在优化资源管理,确保K8s集群中的网络资源能够按需高效分配。DRANET采用Apache-2.0开源许可,鼓励社区贡献与扩展,是云原生环境下提升网络性能的创新解决方案。LazyjournalLazyjournal是一个用Go语言编写的终端用户界

- 深入解析深度学习中的过拟合与欠拟合诊断、解决与工程实践

古月居GYH

深度学习人工智能

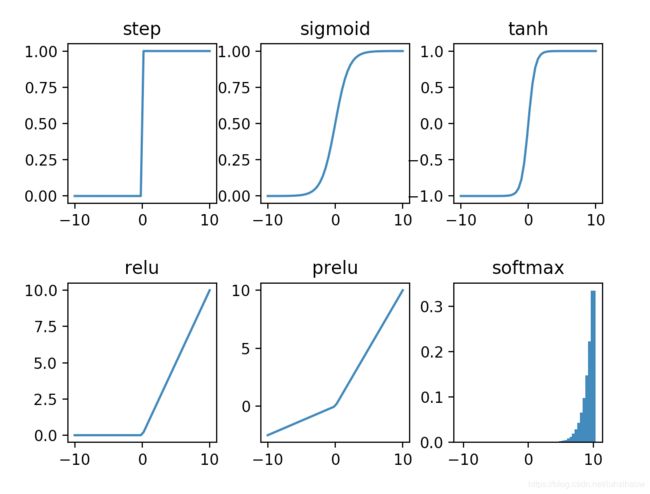

一、引言:模型泛化能力的核心挑战在深度学习模型开发中,欠拟合与过拟合是影响泛化能力的两个核心矛盾。据GoogleBrain研究统计,工业级深度学习项目中有63%的失败案例与这两个问题直接相关。本文将从基础概念到工程实践,系统解析其本质特征、诊断方法及解决方案,并辅以可复现的代码案例。二、核心概念与通熟易懂解释简单而言,欠拟合是指模型不能在训练集上获得足够低的误差。换句换说,就是模型复杂度低,模型在

- 设计模式之装饰器模式

周努力.

设计模式设计模式装饰器模式

装饰器模式(Decorator)依然是我们设计模式中的结构型模式,其中的构造思想仍然是对多个类进行组合使用,以达成系统调用实现指定功能的设计模式。装饰器模式不论在我们日常开发过程中还是在我们提升技术阅读源码过程中都是比较常见的,但是整体学习这个模式的思路难度不大,接下来我将详细讲解此设计模式。目录1.概念2.代码实现3.应用场景4.装饰器模式与代理模式的区别1.概念我们前期所讲到的适配器模式,是连

- OpenManus 架构的详细技术实现

大势下的牛马

搭建本地gpt架构OpenManusManusAgent

一、OpenManus架构的详细技术实现1.核心分层架构的深度解析底层:LLM层模型选择与适配:OpenManus允许用户替换底层LLM(如mPLUG-Owl3、Qwen、Llama等),通过统一接口调用模型API,实现跨模型兼容性Prompt工程设计:用户输入的自然语言指令通过精心设计的Prompt转换为结构化指令。例如,PlanningTool使用预定义的Prompt模板(如请将任务分解为可执

- python八股(—) --FBV,CBV

suohanfjiusbis

数据库python

引言FBV是面向函数的视图。defFBV(request):ifrequest.method=='GET':returnHttpResponse("GET")elifrequest.method=='POST':returnHttpResponse("POST")CBV是面向类的视图。classCBV(View):defget(self,request):returnHttpResponse("G

- C# 设计模式之桥接模式

鲤籽鲲

C#c#设计模式桥接模式

总目录前言1基础介绍定义:将抽象部分与实现部分分离,使它们都可以独立地变化。桥模式不能只认为是抽象和实现的分离,它其实并不仅限于此。其实两个都是抽象的部分,更确切的理解,应该是将一个事物中多个维度的变化分离。一个维度可以认为是抽象部分,另一个维度可以认为是实现部分,而这两个维度可以独立扩充和维护。桥接模式中的角色:抽象化角色(Abstraction):定义抽象类的接口,一般为抽象类,规范Refin

- 一文读懂什么是服务器

小熊猫Q

服务器科普服务器运维

服务器基础介绍介绍服务器相关基础知识,如服务器分类、组成、机箱内部构造等,个人公众号:SRE杂谈,欢迎关注1、什么是服务器?服务器品牌有惠普、戴尔、浪潮、华为、华三、曙光等,各厂商服务器型号存在差异,惠普DL380G10、戴尔PowerEdgeR750、浪潮NF5280M5、华为2288HV5、曙光R6230HA一般用SN序列号和资产编号来对服务器进行标识,其中SN为唯一标识2、服务器演进2.1、

- 【纯职业小组——思维】

Kent_J_Truman

蓝桥杯算法

题目思路第十五届蓝桥杯省赛PythonB组H题【纯职业小组】题解(AC)_蓝桥杯纯职业小组-CSDN博客代码#includeusingnamespacestd;usingll=longlong;intmain(){ios::sync_with_stdio(0);cin.tie(0);intt;cin>>t;while(t--){intn;llk;cin>>n>>k;unordered_maph;f

- 第十五届蓝桥杯省赛PythonB组B题【数字串个数】题解(AC)

信奥郭老师

蓝桥杯职场和发展

设n=10000n=10000n=10000。法一枚举333的个数以及777的个数,假设333的个数为iii,777的个数为jjj,那么非3,73,73,7的个数即为n−i−jn-i-jn−i−j。在长度为nnn的字符串中选取iii的方案数为CniC^i_nCni,在剩余n−in-in−i个位置选取jjj个的方案数为Cn−ijC^j_{n-i}Cn−ij,剩余位置个数为n−i−jn-i-jn−i−

- WRF移动嵌套结合伏羲模型与CFD(PALM)高精度多尺度降尺度分析研究

Hardess-god

WRF算法人工智能

随着大气科学与数值模拟技术的发展,高精度多尺度气象模拟日益成为科研与应用的热点问题。本文将详细介绍如何使用WRF移动嵌套技术结合伏羲(Fuxi)模型,并通过CFD模型PALM实现精细化降尺度,以满足城市或区域局地精细化气象预报的需求。1.技术路线概述WRF移动嵌套(MovingNesting):动态调整高分辨率嵌套网格位置,追踪天气系统(如台风、强对流系统)以提高局地预报精度。伏羲(Fuxi)模型

- Fluent 与 Openfoam 网格比较

Hardess-god

CFD服务器

ANSYSFluent和OpenFOAM是两个广泛使用的计算流体动力学(CFD)软件,它们在网格生成、处理和使用方面存在一些基本差异。这些差异主要源于两者的设计哲学、目标用户群体和工作流程。以下是Fluent和OpenFOAM在网格生成方面的一些关键比较:1.网格生成工具ANSYSFluent:Fluent通常与ANSYSWorkbench集成使用,后者提供了一个强大的网格生成工具(如ANSYSM

- ModuleNotFoundError: No module named ‘h5py‘

Hardess-god

python

到ModuleNotFoundError:Nomodulenamed'h5py'错误表明Python环境中没有安装h5py模块。h5py是一个用于处理HDF5二进制数据格式的Python接口,广泛用于大规模存储和操纵数据。解决方案:安装h5py要解决这个问题,你需要在你的Python环境中安装h5py。以下是如何在不同环境中安装h5py的步骤:使用pip安装如果你使用的是pip包管理器,可以通过以

- 使用Ollama部署开源大模型

好好学习 666

开源

Ollama是一个简明易用的本地大模型运行框架,可以一键启动启动并运行Llama3、Mistral、Gemma和其他大型语言模型。安装MacOS,Windows用户直接在官网下载页下载安装包即可。Linux系统运行如下命令安装curl-fsSLhttps://ollama.com/install.sh|sh使用Usage:ollama[flags]ollama[command]AvailableC

- 纯「牛马」的逻辑玩儿不转了!

求职面试职场创业创业者

又在微信群里被「声讨」了,距离上次这等待遇也过去一段时间了,让人有点「怀念」呢~(别瞎想,我不是字母!)我想此刻趁这心情还未消散殆尽,把近期一直想说但没说的话先说一遍,也暂时不管它是否严谨了,看完想吐槽就尽管来吧!麻木的纯「牛马」们在2022年11月末,ChatGPT的横空出世拉开了AI时代的帷幕,迄今为止两年多过去了,相关基础设施和上层应用已经涌现并迭代了很多版本。在这期间,很多人都至少听说过几

- 01年实习生被曝负责字节RL核心算法!系字节LLM攻坚小组成员

量子位

一个超越DeepSeekGRPO的关键RL算法出现了!用上该算法后,Qwen2.5-32B模型只经过RL训练,不引入蒸馏等其他技术,在AIME2024基准上拿下50分,优于相同setting下使用GRPO算法的DeepSeek-R1-Zero-Qwen,且DAPO使用的训练步数还减少了50%。这个算法名为DAPO,字节、清华AIR联合实验室SIALab出品,现已开源。论文通讯作者和开源项目负责人都

- CSP-J备考冲刺必刷题(C++) | AcWing 1253 家谱

热爱编程的通信人

c++开发语言

本文分享的必刷题目是从蓝桥云课、洛谷、AcWing等知名刷题平台精心挑选而来,并结合各平台提供的算法标签和难度等级进行了系统分类。题目涵盖了从基础到进阶的多种算法和数据结构,旨在为不同阶段的编程学习者提供一条清晰、平稳的学习提升路径。欢迎大家订阅我的专栏:算法题解:C++与Python实现!附上汇总贴:算法竞赛备考冲刺必刷题(C++)|汇总【题目来源】Acwing:1253.家谱-AcWing题库

- 重塑家用机器人大脑!云鲸旗舰机型逍遥002搭载旭日5正式开售

量子位

2025年3月20日,全球家庭清洁机器人明星品牌云鲸智能携最新一代旗舰机型——云鲸逍遥002,亮相中国家电及消费电子博览会(AWE)。该产品以”AI智能深度清洁“为核心,基于地瓜机器人全新一代旭日5智能计算芯片,推出首创的双目AI视觉感知自适应系统,以10TOPs的端侧算力与180万点/秒的3D稠密深度点云生成能力,为家庭场景带来毫米级障碍测距精度与语义级环境理解,是家庭清洁机器人智能化演进的又一

- 量子位招聘 | DeepSeek帮我们改的招聘启事

量子位

关注前沿科技量子位未来同事,你好~这是一则招聘帖。如果你与我们志同道合,对AI大模型、具身智能、终端硬件、AI新媒体编辑感兴趣,我们正在招聘这些领域的原创作者。以下岗位均为全职,工作地点:北京中关村。岗位面向:社招、应届毕业生,所有岗位均可实习——表现出色均可转正加分项:乐于探索AI新工具,善用AI新工具;拥有解读论文的能力,能深入浅出讲解原理;有写代码能力;量子位长期读者。加入我们,你可以获得:

- “三分钟”带你看懂批次管理!(一)

wms系统

一、批次管理的定义与重要性1.批次管理的定义:批次管理是一种针对产品或物料的管理方法,它将同一生产周期或相同条件下生产、具有一致质量特征、生产信息和使用属性的产品组作为一个批次,进行分类、标识、追踪和管理。2.批次管理的重要性:提高可追溯性:精准追踪物料和产品的来源、去向及生命周期,在质量问题或召回需求出现时,能快速锁定问题批次,降低损失。增强质量控制:监控不同批次产品的质量指标,及时发现和分析质

- 分析K8S中Node状态为`NotReady`问题

网络飞鸥

Kuberneteskubernetes容器云原生

在Kubernetes(k8s)集群中,Node状态为NotReady通常意味着节点上存在某些问题,下面为你分析正常情况下节点应运行的容器以及解决NotReady状态的方法。正常情况下Node节点应运行的容器1.kubeletkubelet是节点上的核心组件,它负责与控制平面通信,管理节点上的容器生命周期。它通常作为系统服务运行,而不是以容器形式存在,但也有使用容器化部署的情况。2.kube-pr

- ztree设置禁用节点

3213213333332132

JavaScriptztreejsonsetDisabledNodeAjax

ztree设置禁用节点的时候注意,当使用ajax后台请求数据,必须要设置为同步获取数据,否者会获取不到节点对象,导致设置禁用没有效果。

$(function(){

showTree();

setDisabledNode();

});

- JVM patch by Taobao

bookjovi

javaHotSpot

在网上无意中看到淘宝提交的hotspot patch,共四个,有意思,记录一下。

7050685:jsdbproc64.sh has a typo in the package name

7058036:FieldsAllocationStyle=2 does not work in 32-bit VM

7060619:C1 should respect inline and

- 将session存储到数据库中

dcj3sjt126com

sqlPHPsession

CREATE TABLE sessions (

id CHAR(32) NOT NULL,

data TEXT,

last_accessed TIMESTAMP NOT NULL,

PRIMARY KEY (id)

);

<?php

/**

* Created by PhpStorm.

* User: michaeldu

* Date

- Vector

171815164

vector

public Vector<CartProduct> delCart(Vector<CartProduct> cart, String id) {

for (int i = 0; i < cart.size(); i++) {

if (cart.get(i).getId().equals(id)) {

cart.remove(i);

- 各连接池配置参数比较

g21121

连接池

排版真心费劲,大家凑合看下吧,见谅~

Druid

DBCP

C3P0

Proxool

数据库用户名称 Username Username User

数据库密码 Password Password Password

驱动名

- [简单]mybatis insert语句添加动态字段

53873039oycg

mybatis

mysql数据库,id自增,配置如下:

<insert id="saveTestTb" useGeneratedKeys="true" keyProperty="id"

parameterType=&

- struts2拦截器配置

云端月影

struts2拦截器

struts2拦截器interceptor的三种配置方法

方法1. 普通配置法

<struts>

<package name="struts2" extends="struts-default">

&

- IE中页面不居中,火狐谷歌等正常

aijuans

IE中页面不居中

问题是首页在火狐、谷歌、所有IE中正常显示,列表页的页面在火狐谷歌中正常,在IE6、7、8中都不中,觉得可能那个地方设置的让IE系列都不认识,仔细查看后发现,列表页中没写HTML模板部分没有添加DTD定义,就是<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3

- String,int,Integer,char 几个类型常见转换

antonyup_2006

htmlsql.net

如何将字串 String 转换成整数 int?

int i = Integer.valueOf(my_str).intValue();

int i=Integer.parseInt(str);

如何将字串 String 转换成Integer ?

Integer integer=Integer.valueOf(str);

如何将整数 int 转换成字串 String ?

1.

- PL/SQL的游标类型

百合不是茶

显示游标(静态游标)隐式游标游标的更新和删除%rowtyperef游标(动态游标)

游标是oracle中的一个结果集,用于存放查询的结果;

PL/SQL中游标的声明;

1,声明游标

2,打开游标(默认是关闭的);

3,提取数据

4,关闭游标

注意的要点:游标必须声明在declare中,使用open打开游标,fetch取游标中的数据,close关闭游标

隐式游标:主要是对DML数据的操作隐

- JUnit4中@AfterClass @BeforeClass @after @before的区别对比

bijian1013

JUnit4单元测试

一.基础知识

JUnit4使用Java5中的注解(annotation),以下是JUnit4常用的几个annotation: @Before:初始化方法 对于每一个测试方法都要执行一次(注意与BeforeClass区别,后者是对于所有方法执行一次)@After:释放资源 对于每一个测试方法都要执行一次(注意与AfterClass区别,后者是对于所有方法执行一次

- 精通Oracle10编程SQL(12)开发包

bijian1013

oracle数据库plsql

/*

*开发包

*包用于逻辑组合相关的PL/SQL类型(例如TABLE类型和RECORD类型)、PL/SQL项(例如游标和游标变量)和PL/SQL子程序(例如过程和函数)

*/

--包用于逻辑组合相关的PL/SQL类型、项和子程序,它由包规范和包体两部分组成

--建立包规范:包规范实际是包与应用程序之间的接口,它用于定义包的公用组件,包括常量、变量、游标、过程和函数等

--在包规

- 【EhCache二】ehcache.xml配置详解

bit1129

ehcache.xml

在ehcache官网上找了多次,终于找到ehcache.xml配置元素和属性的含义说明文档了,这个文档包含在ehcache.xml的注释中!

ehcache.xml : http://ehcache.org/ehcache.xml

ehcache.xsd : http://ehcache.org/ehcache.xsd

ehcache配置文件的根元素是ehcahe

ehcac

- java.lang.ClassNotFoundException: org.springframework.web.context.ContextLoaderL

白糖_

javaeclipsespringtomcatWeb

今天学习spring+cxf的时候遇到一个问题:在web.xml中配置了spring的上下文监听器:

<listener>

<listener-class>org.springframework.web.context.ContextLoaderListener</listener-class>

</listener>

随后启动

- angular.element

boyitech

AngularJSAngularJS APIangular.element

angular.element

描述: 包裹着一部分DOM element或者是HTML字符串,把它作为一个jQuery元素来处理。(类似于jQuery的选择器啦) 如果jQuery被引入了,则angular.element就可以看作是jQuery选择器,选择的对象可以使用jQuery的函数;如果jQuery不可用,angular.e

- java-给定两个已排序序列,找出共同的元素。

bylijinnan

java

import java.util.ArrayList;

import java.util.Arrays;

import java.util.List;

public class CommonItemInTwoSortedArray {

/**

* 题目:给定两个已排序序列,找出共同的元素。

* 1.定义两个指针分别指向序列的开始。

* 如果指向的两个元素

- sftp 异常,有遇到的吗?求解

Chen.H

javajcraftauthjschjschexception

com.jcraft.jsch.JSchException: Auth cancel

at com.jcraft.jsch.Session.connect(Session.java:460)

at com.jcraft.jsch.Session.connect(Session.java:154)

at cn.vivame.util.ftp.SftpServerAccess.connec

- [生物智能与人工智能]神经元中的电化学结构代表什么?

comsci

人工智能

我这里做一个大胆的猜想,生物神经网络中的神经元中包含着一些化学和类似电路的结构,这些结构通常用来扮演类似我们在拓扑分析系统中的节点嵌入方程一样,使得我们的神经网络产生智能判断的能力,而这些嵌入到节点中的方程同时也扮演着"经验"的角色....

我们可以尝试一下...在某些神经

- 通过LAC和CID获取经纬度信息

dai_lm

laccid

方法1:

用浏览器打开http://www.minigps.net/cellsearch.html,然后输入lac和cid信息(mcc和mnc可以填0),如果数据正确就可以获得相应的经纬度

方法2:

发送HTTP请求到http://www.open-electronics.org/celltrack/cell.php?hex=0&lac=<lac>&cid=&

- JAVA的困难分析

datamachine

java

前段时间转了一篇SQL的文章(http://datamachine.iteye.com/blog/1971896),文章不复杂,但思想深刻,就顺便思考了一下java的不足,当砖头丢出来,希望引点和田玉。

-----------------------------------------------------------------------------------------

- 小学5年级英语单词背诵第二课

dcj3sjt126com

englishword

money 钱

paper 纸

speak 讲,说

tell 告诉

remember 记得,想起

knock 敲,击,打

question 问题

number 数字,号码

learn 学会,学习

street 街道

carry 搬运,携带

send 发送,邮寄,发射

must 必须

light 灯,光线,轻的

front

- linux下面没有tree命令

dcj3sjt126com

linux

centos p安装

yum -y install tree

mac os安装

brew install tree

首先来看tree的用法

tree 中文解释:tree

功能说明:以树状图列出目录的内容。

语 法:tree [-aACdDfFgilnNpqstux][-I <范本样式>][-P <范本样式

- Map迭代方式,Map迭代,Map循环

蕃薯耀

Map循环Map迭代Map迭代方式

Map迭代方式,Map迭代,Map循环

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年

- Spring Cache注解+Redis

hanqunfeng

spring

Spring3.1 Cache注解

依赖jar包:

<!-- redis -->

<dependency>

<groupId>org.springframework.data</groupId>

<artifactId>spring-data-redis</artifactId>

- Guava中针对集合的 filter和过滤功能

jackyrong

filter

在guava库中,自带了过滤器(filter)的功能,可以用来对collection 进行过滤,先看例子:

@Test

public void whenFilterWithIterables_thenFiltered() {

List<String> names = Lists.newArrayList("John"

- 学习编程那点事

lampcy

编程androidPHPhtml5

一年前的夏天,我还在纠结要不要改行,要不要去学php?能学到真本事吗?改行能成功吗?太多的问题,我终于不顾一切,下定决心,辞去了工作,来到传说中的帝都。老师给的乘车方式还算有效,很顺利的就到了学校,赶巧了,正好学校搬到了新校区。先安顿了下来,过了个轻松的周末,第一次到帝都,逛逛吧!

接下来的周一,是我噩梦的开始,学习内容对我这个零基础的人来说,除了勉强完成老师布置的作业外,我已经没有时间和精力去

- 架构师之流处理---------bytebuffer的mark,limit和flip

nannan408

ByteBuffer

1.前言。

如题,limit其实就是可以读取的字节长度的意思,flip是清空的意思,mark是标记的意思 。

2.例子.

例子代码:

String str = "helloWorld";

ByteBuffer buff = ByteBuffer.wrap(str.getBytes());

Sy

- org.apache.el.parser.ParseException: Encountered " ":" ": "" at line 1, column 1

Everyday都不同

$转义el表达式

最近在做Highcharts的过程中,在写js时,出现了以下异常:

严重: Servlet.service() for servlet jsp threw exception

org.apache.el.parser.ParseException: Encountered " ":" ": "" at line 1,

- 用Java实现发送邮件到163

tntxia

java实现

/*

在java版经常看到有人问如何用javamail发送邮件?如何接收邮件?如何访问多个文件夹等。问题零散,而历史的回复早已经淹没在问题的海洋之中。

本人之前所做过一个java项目,其中包含有WebMail功能,当初为用java实现而对javamail摸索了一段时间,总算有点收获。看到论坛中的经常有此方面的问题,因此把我的一些经验帖出来,希望对大家有些帮助。

此篇仅介绍用

- 探索实体类存在的真正意义

java小叶檀

POJO

一. 实体类简述

实体类其实就是俗称的POJO,这种类一般不实现特殊框架下的接口,在程序中仅作为数据容器用来持久化存储数据用的

POJO(Plain Old Java Objects)简单的Java对象

它的一般格式就是

public class A{

private String id;

public Str