Fully Convolutional Speech Recognition

目录

- Abstract

- 1. Introduction

- 2. Model

- 2.1. Convolutional Front-end

- 2.2. Convolutional Acoustic Model

- 2.3. Convolutional Language Model

- 2.4. Beam-search decoder

- 3. Experiments

- 4. Results

- 4.1. Word Error Rate results

- 4.1.1. Wall Street Journal dataset

- 4.1.2. Librispeech dataset

- 4.2. Analysis of the convolutional language model

- 4.3. Analysis of the learnt front-ends

- 5. Conclusion

Abstract

当前最先进的语音识别系统建立在rnn上,用于声学和/或语言建模,并依靠特征提取管道来提取梅尔滤波器组或倒频谱系数。 在本文中,我们提出了一种仅基于卷积神经网络的替代方法,它利用了原始波形和语言建模在声学模型方面的最新进展。 对这种完全卷积的方法进行了端到端的训练,以预测原始波形中的字符,从而完全消除了特征提取步骤。 外部卷积语言模型用于解码单词。 在《华尔街日报》上,我们的模型与当前的最新技术相匹配。 在Librispeech上,我们报告了端到端模型(包括Deep Speech 2)中的最新性能,该模型接受了12倍以上的声学数据和明显更多的语言数据训练。

1. Introduction

卷积神经网络体系结构的最新研究表明,即使在对远程依赖性建模至关重要的任务上,例如语言建模[1],机器翻译[2、3]和语音合成[4],它们在循环体系结构方面也具有竞争力。 然而,在端到端语音识别中,递归神经网络在声学和/或语言建模中仍然很流行[5、6、7、8、9]。

在语音识别中有使用卷积网络的历史,但仅作为其他传统管道的一部分。 它们首先作为TDNN引入,以预测音素类别[10],后来又生成HMM后缀[11]。 它们最近已用于端到端系统,但仅与循环层[7]或n-gram语言模型[12]或电话识别[13、14]结合使用。 当从原始波形[15、16、17、14、18]中学习时,卷积架构很普遍,因为它们从本质上模拟了诸如mel-filterbank之类的标准特征的计算。 鉴于有证据表明卷积网络也适用于远程依赖任务,我们希望它们在语音识别管道的所有级别上都具有竞争力。

在本文中,我们提出了一种完全卷积的端到端语音识别方法。 基于语音[14、18],卷积声学模型[12]和卷积语言模型[1]的卷积可学习前端的最新进展,我们的模型是一个深度卷积网络,它将原始波形作为输入并 经过端到端的培训以预测字母。 然后使用带有卷积语言模型的波束搜索解码来预测句子。

除了介绍卷积语言模型在语音识别中的首次应用外,本文的主要贡献是表明全卷积架构可实现端到端系统中的最新性能。 。 因此,我们的结果挑战了语音识别的递归体系结构的普遍性,并且与卷积架构与递归体系结构相当的其他应用领域的先前结果相平行。

更准确地说,我们对《华尔街日报》数据集(WSJ)的大型语音任务和1000h Librispeech进行了实验。 我们的总体流程改进了两个数据集上最新的端到端系统。 尤其是,与DeepSpeech 2 [7]和最佳序列到序列模型[9]相比,我们在嘈杂的Librispeech测试集上将词错误率降低了2%(绝对值)。 与最佳的端到端系统相比,在语音干净的情况下,Librispeech的性能提高约0.5%。 在《华尔街日报》上,我们的研究结果与当前最先进的DNN-HMM系统[19]相比具有竞争力。

特别是,详细的结果表明,卷积语言模型比4克语言模型具有更好的困惑性和更大的接收范围,因此可以产生系统且一致的改进。 此外,我们补充了[18]关于学习语音识别系统前端性能的有希望的结果:首先,我们表明,与mel-filterbanks前端相比,学习前端在嘈杂语音方面产生了实质性的改进, 结束。 其次,通过改变可学习的前端中的过滤器数量,我们在WSJ和Librispeech上均显示出其他改进,从而导致在Librispeech嘈杂的测试集上WER绝对降低了1.5%。 我们的结果是首次在原始波形上训练的端到端系统在两个数据集上达到了最先进的性能(在所有端到端系统中)。

2. Model

2.1. Convolutional Front-end

已经提出了一些学习语音识别系统前端的建议[16、17、14、18]。 按照[18]中的比较,我们考虑它们的最佳架构,称为“基于散射”(以下称为可学习的前端)。 可学习的前端首先包含宽度2的卷积,该卷积模仿mel-filterbank中使用的预加重步骤。 随后是宽度为25ms和k个滤波器的复杂卷积。 取平方的绝对值后,宽度为25ms且步幅为10ms的低通滤波器执行抽取。 前端最终应用对数压缩和每通道均方差归一化(等效于实例归一化层[20])。 根据[18],“预加重”卷积被初始化为[-0.97; 1],然后与网络的其余部分一起训练。 低通滤波器保持恒定到平方的汉宁窗,并且复杂的卷积层被随机初始化。

除了[18]使用的k = 40个滤波器外,我们还使用了k = 80个滤波器。 请注意,由于步幅与mel-filterbanks相同,因此可将学习型前端之上的声学模型也应用于mel-filterbanks(如果k! = 40,则只需修改输入通道的数量)。

2.2. Convolutional Acoustic Model

声学模型是具有门控线性单元[1]的卷积神经网络,该网络被馈入可学习前端的输出。 如[12]中所述,网络使用越来越多的信道,并使用丢包[21]进行正则化。 这些声学模型经过训练,可以利用自动分段标准(ASG)直接预测字母[22]。 ASG标准类似于CTC [5],不同之处在于它在字母之间添加了与输入无关的转换分数。 根据训练数据量分别调整深度,每层特征图的数量,接受区域和模型在每个数据集上的缺失量。

2.3. Convolutional Language Model

卷积语言模型(LM)是[1]的GCNN-14B,它在语言建模基准上获得了具有竞争力的结果,其词汇量和训练数据的大小与我们的实验中使用的相似。 该网络包含14个卷积残差块[23],这种深层结构为我们提供了足够大的接收场。 在每个残差块中,两个1×1 1-D卷积层放在开始和结束处,这是提高计算效率的瓶颈。 门控线性单元用作激活函数。

除了下一节中介绍的波束搜索解码器中的声学模型外,我们还使用语言模型对候选转录进行评分。 与n-gram LM相比,卷积LM允许解码器以更好的困惑看待更长的上下文。

2.4. Beam-search decoder

给定声学模型的输出,我们使用[12]中介绍的波束搜索解码器生成单词序列。 给定声学模型的输入X,解码器会找到最大的单词转录W:

![]()

其中π是表示W的有效字母序列的路径,而πi是该序列中的第i个字母。 声学模型的分数是根据与输出序列兼容的字母(包括无声)路径的分数来计算的。 用Gasg表示对应的图,由声学模型给出的单词序列W的得分为

其中T是要解码的输出帧数,f i t是字母i对于帧t的对数概率,g i,j分别是从字母i到字母j的转换分数。

(1)中的其他超参数α,β,γ≥0控制语言模型的权重,单词插入奖励和静默插入惩罚。 波束搜索的其他超参数是波束大小和波束得分。 后者是要包含在波束中的假设得分的全局阈值,仅用于效率

为了使解码更有效率,在每个时间步长处,我们将所有假设合并到G asg中的同一节点之前进行排序,以便更好地利用波束。 另外,为了减少通过LM的前向通行次数,我们缓存了先前时间步中未改变的LM状态的得分,并且仅对当前步骤中产生的新假设进行前批处理。

3. Experiments

我们评估了《华尔街日报》(WSJ)数据集[24]的大词汇量任务的方法,该数据集包含80个小时的纯净阅读语音,而Librispeech [25]则包含1000个小时,分别针对 干净嘈杂的演讲。 每个数据集都附带用于训练语言模型的官方文本数据,其中包含3700万个WSJ令牌,8亿个Librispeech令牌。 我们仅针对官方文本数据上的每个数据集分别对我们的语言模型进行培训。 选择这些数据集来研究我们系统的不同组件在不同规模的训练数据和不同记录条件下的影响

这些模型以Word错误率(WER)进行评估。 我们的实验将wav2letter 1的开源代码用于声学模型,将fairseq 2用作语言模型。 实验设置的更多细节如下。

baseline 每个数据集的基线如下[12]。 它使用与我们的方法相同的卷积声学模型,但是使用了mel-filterbanks前端和4克语言模型。

训练/测试拆分在WSJ上,模型在si284上进行训练。 nov93dev用于验证,nov92用于测试。 在Librispeech,我们将火车清洁与其他火车串联起来进行训练。 当在test-clean上进行测试时,验证集为dev-clean,在test-other上进行测试时,验证集为dev-other。

声学建模卷积声学模型的体系结构是[12]中Librispeech的“高辍学”模型,该模型除前端(基线的melfilter库或可学习的前端)外还有19层 对于我们的方法)。 在WSJ上,我们使用[18]中使用的较轻版本,该版本有17层。 在[22]之后,在前端之后的每一层都应用了Dropout。 可学习的前端使用40或80个过滤器

遵循[12,18],使用SGD以降低的学习速率,权重归一化和梯度裁剪为0.2和动量为0.9来训练声学模型。

语言建模如2.3节中所述,我们使用[1]的GCNN-14B模型,在WSJ和Librispeech的每个卷积和线性层均具有辍学。 每个残差块中间的一维卷积层的内核大小设置为5。就训练词汇而言,我们将所有单词(162K)保留在WSJ训练语料库中,而仅使用最频繁的200K标记 900,000中的部分将保留给Librispeech。 语言模型通过Nesterov加速梯度进行训练[26]。 根据[1],我们还将权重归一化和梯度修剪作为正则化。

超参数调整波束搜索的参数(请参见第2.4节)在验证集上进行了调整,波束大小为2500,波束得分为26,以提高计算效率。 一旦选择了α,β,γ,则将具有最佳数量的测试WER一起推到开发集上,光束大小为3000,光束得分为50。

4. Results

4.1. Word Error Rate results

4.1.1. Wall Street Journal dataset

表1显示了最新技术和我们模型在WSJ上的单词错误率(WER)。在此数据集上训练的当前最佳模型是基于HMM的系统,该系统结合了卷积层,循环层和完全连接层以及说话者自适应,在nov92上的WER达到3.5%。 DeepSpeech 2的WER为3.6%,但对声学模型使用的训练数据多150倍,对LM训练使用的文本数据集大150倍。最后,仅在WSJ上训练的端对端系统中的最新技术(因此与我们的系统最相像)在增强数据上使用了无格MMI(具有速度扰动),并且获得了4.1%的WER。我们的基线系统经过mel-filterbank训练,并使用n-gram语言模型进行解码,WER为5.6%。用卷积模型代替n-gram LM将WER降低到4.1%,并使我们的模型与当前最佳的端到端系统相提并论。通过将可学习的前端替换为语音功能,最终将WER降低到3.7%,然后在将可学习的过滤器数量增加一倍时将WER降低到3.5%,优于DeepSpeech 2并与最佳HMM-DNN系统的性能相匹配。

4.1.2. Librispeech dataset

表2报告了Librispeech数据集的WER。 CAPIO [28]集成模型结合了来自8个单独的HMM-DNN系统(使用卷积层和LSTM层)的网格,是Librispeech上的最新技术。 CAPIO(单个)是最好的单个系统,可以在devclean或dev-other上选择。序列到序列的基线是具有注意力和BPE级别[29] LM的编码器-解码器,目前是该数据集上最佳的端到端系统。我们可以观察到,我们的全卷积模型在干净的部分上比CAPIO(单一)有所改进,并且是目前在测试其他方面最好的端到端系统,绝对值提高了2.3%。我们的系统在两个测试集上的表现也都优于DeepSpeech 2。一个有趣的观察是每个卷积块的影响。用卷积LM代替4克LM可以在干净和嘈杂的部分上得到类似的改进,但学习语音前端在干净部分可以得到类似的性能,但是可以显着提高在嘈杂,更难说话时的性能,这一发现与以前的文献[16]。此外,将可学习过滤器的数量加倍可以提高我们系统在所有开发和测试集上的性能,这与《华尔街日报》的结果相符。

4.2. Analysis of the convolutional language model

由于本文是首次将卷积语言模型用于语音识别系统,因此我们单独提出了有关语言模型的其他研究。 这些实验在Librispeech上使用了我们最好的语言模型,而WER的评估是通过在mel-filterbanks上训练的基线系统进行的。 使用第3节中描述的网格搜索来调整解码器参数。为节省计算资源,在这些实验中,我们分别使用略微欠佳的波束大小/波束得分固定为2500/30。

困惑度和WER图2显示了随着训练的进行,困惑度和WER之间的相关性。 随着困惑度的降低,dev-clean和dev-other的WER也会随着相同的趋势而降低。 它说明语言数据的困惑是语音识别管道最终性能的良好替代。 因此,大多数情况下,仅使用困惑即可进行架构选择或超参数调整。

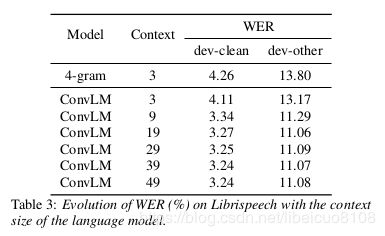

上下文和WER表3报告了针对LM中使用的不同上下文大小而获得的WER。 在我们的最佳语言模型中,从3(相当于n-gram基线)到50的上下文范围来看,WER会单调减小,直到上下文大小约为20,然后几乎保持不变。 我们观察到,即使在相同上下文大小的情况下,卷积LM也已经在n-gram模型上得到了改善。 增加上下文会显着提高性能,在3到9(绝对WER的-1.9%绝对值)之间会获得很大的收益。

4.3. Analysis of the learnt front-ends

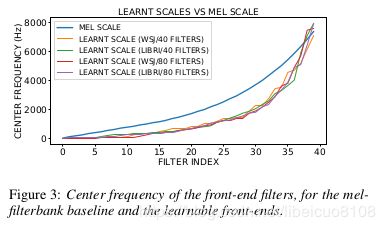

为了定性地了解可学习的前端优于mel滤波器组的优势,我们比较了在波形上训练的系统所学习的频率范围。为此,我们计算了第一层每个卷积滤波器的功率谱。然后,我们将功率谱最大的频率定义为其中心频率。

图3将mel规模与WSJ和Librispeech上我们最佳模型的前端所学习的规模进行了比较。该图是通过根据滤波器的中心频率对滤波器进行排序而获得的,对于具有80个滤波器的前端,其降采样率为2倍。我们观察到所有模型都收敛到相似的比例,无论它们在其上训练的数据集如何,或它们具有多少个过滤器。这些学习的音阶显示出类似于mel音阶的对数形状,但是它们明显偏向低频。而且,这些学习的量表与先前提出的基于γ-丙氨酸的可学习前端所学习的量表非常接近(参见[16]的图2和[17]的图3)。

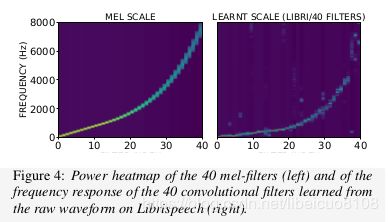

但是,仅通过中心频率来分析可学习的滤波器并不能说明其他重要特征,例如其频率定位。 图4显示了mel滤波器沿频率轴的功率以及在收敛时在Librispeech上学习的40个滤波器的功率的热图。 我们观察到,即使学习的滤波器在高频下显示出一些伪像,它们也与mel滤波器类似,大多位于其中心频率附近。

总体而言,在各种研究中以及在许多数据集上,各种前端所学习的音阶的一致性强烈表明,mel音阶对于自动语音识别而言不是最理想的,并且可学习的前端能够学习更合适的音阶 。

5. Conclusion

我们引入了第一个用于语音识别的全卷积流水线,该流水线可以直接处理原始波形,并在《华尔街日报》和端到端系统中的Librispeech上显示了最新的性能。 在语音识别中利用卷积语言模型的首次尝试与两个数据集上的4克语言模型相比都有显着改善。 用可学到的前端替换mel-filterbank可以提高性能,这在嘈杂的数据上似乎更为普遍。 这表明学习前端是具有挑战性的录音条件的语音识别的有希望的途径。