机器学习之逻辑回归、Softmax回归

1、Odds(比值比/优势比)

用来衡量特征当中分类之间关联的一种方式,指的是该事件发生的概率与该事件不发生的概率的比值,即p/(1-p)

2、Logit函数

也称评定模型、分类评定模型,是最早的离散选择模型

这个式子在形式上仍然是线性回归,但实质上是在求输入空间到输出空间的非线性函数映射,这里的对数函数起到了将线性回归模型的预测值与真实值联系起来的作用,这样得到的模型称为广义线性模型(generalized linear model)。

3、Logistic/Sigmoid函数

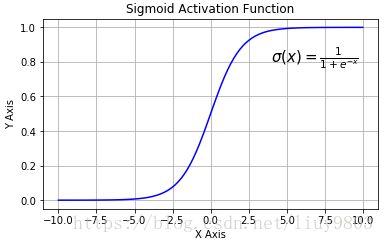

对于分类问题,需要找到一个单调可微函数将真实值与广义线性回归模型的预测值联系起来,这个函数就是Logistic函数,或者称Sigmoid函数。(单位阶跃函数不连续,且瞬间跳跃的过程很难处理)

Logistic/Sigmoid函数是一个常见的S型函数,适合于提供概率的估计以及依据这些估计的二进制响应;由于其单调递增、反函数单调递增、任意阶可导等性质,且可以将变量映射到(0, 1)之间,在逻辑回归、神经网络中有着广泛的应用。

![]()

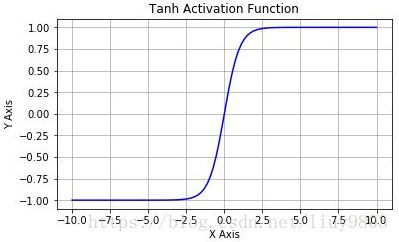

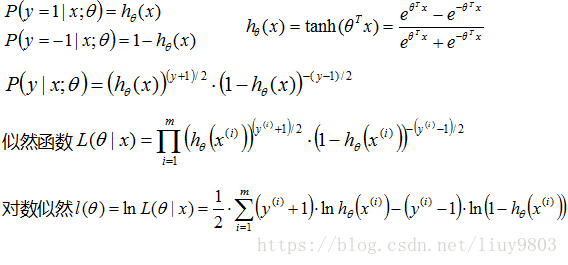

tanh双曲正切函数是双曲函数的一种,它和它的导函数在(-∞, +∞)单调递增,且可以将变量映射到(-1, 1)之间,也常用于逻辑回归、神经网络等。

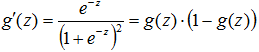

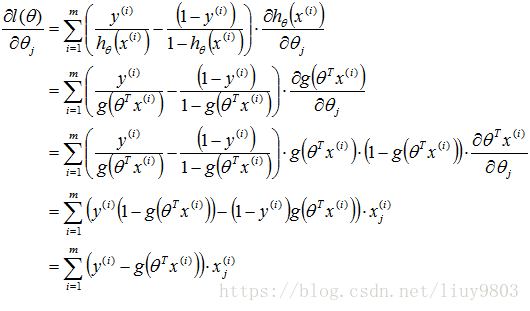

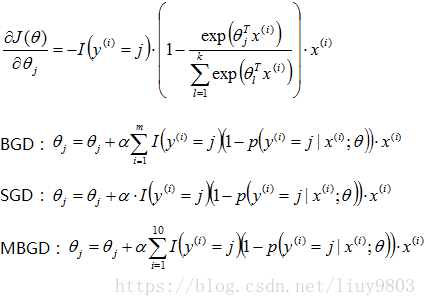

使用梯度下降求θ,先对最大似然函数求导

代入Sigmoid函数,由链式求导法则可得:

因此可知Logistic回归θ参数的求解过程为:

可以发现逻辑回归与线性回归梯度下降求解的形式类似,唯一的区别在于假设函数hθ(x)不同,线性回归假设函数为θTx,逻辑回归假设函数为Sigmoid函数。

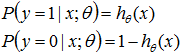

线性回归模型服从正态分布,逻辑回归模型服从二项分布(Bernoulli分布),因此逻辑回归不能应用最小二乘法作为目标/损失函数,所以用梯度下降法。

多分类问题(Multi-class classification)

对于分类多于2个的问题, 可以将其看做二分类问题,即以其中一个分类作为一类,剩下的其他分类作为另一类,多分类问题的假设函数为 ![]()

one-vs-all/rest 问题解决方法:

训练一个逻辑回归分类器,预测 i 类别 y=i 的概率;

对一个新的输入值x,为了作出类别预测,分别在k个分类器运行输入值,选择h最大的类别 ![]()

Softmax回归模型

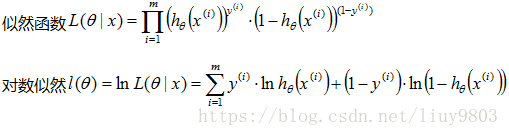

Softmax回归是logistic回归的一般化模型,适用于k(k>2)分类的问题,第k类的参数为向量θk,组成的二维矩阵为θk*n。

Softmax函数的本质就是将一个k维的任意实数向量映射成为另一个k维的实数向量,其中向量中的每个元素的取值都介于(0,1)之间。

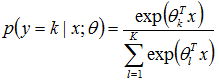

Softmax回归的概率函数为:

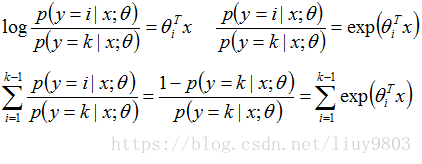

推导和Logistic回归类似,只是将分类的个数从2扩展到k的情形。根据Odds Ratio定义可知:(i=1, 2, ... ,k)

可求出:

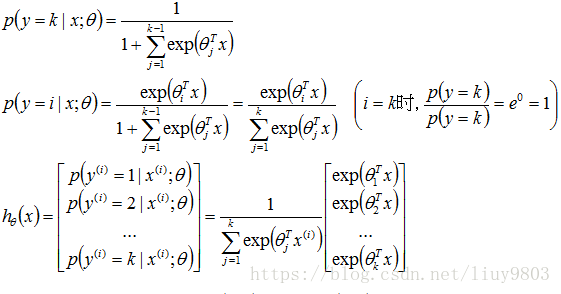

Softmax算法的损失函数:

梯度下降求解θ:

总结

1、线性回归模型一般用于回归问题,逻辑回归和Softmax回归模型一般用于分类问题;

2、求θ的主要方式是梯度下降算法,该算法是参数优化的重要手段,主要使用SGD或MBGD;

3、逻辑回归/Softmax回归模型是实际问题中解决分类问题的最重要的方法;

4、广义线性模型对样本的要求不必一定要服从正态分布,只要服从指数分布簇(二项分布、Poisson分布、Bernoulli分布、指数分布等)即可;广义线性模型的自变量可以是连续的也可以是离散的。

Model——Loss function——Algorithm

1、线性回归模型

目标函数:极大似然估计=>最小二乘;

求解算法:梯度下降、最小二乘法解析解(解方程-对数似然偏导=0)

2、逻辑回归模型

目标函数:极大似然估计(对数损失函数);

求解算法:梯度下降

3、Softmax回归模型

目标函数:求交叉熵极小值

求解算法:梯度下降