ICDAR2019发票比赛冠军论文解读(文字检测Corner)

1. 文章背景:ICDAR2019任务3: 发票比赛端到端识别比赛冠军,技术方案Corner+CRNN,其中的Corner方法就是本文方法,开源代码:https://github.com/lvpengyuan/corner

2. 题目:Multi-Oriented Scene Text Detection via Corner Localization and Region Segmentation(基于边角的多方向场景文本检测和区域分割),文章链接:https://arxiv.org/abs/1802.08948,该文章被【CVPR2018】收录。

3. 作者相关:该文章由华中科技大学白翔教授团队出品

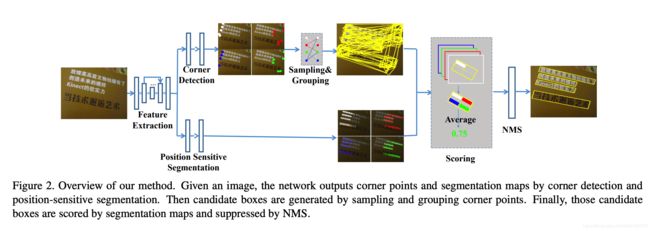

4. 方法简介:作者提出了一种可端到端训练和评估的文本检测网络,结合了目标检测和语义分割两种思路。其中,主干网络使用了VGG16,主要用于进行特征提取;网络外接两个并行分支,第一个分支用来进行边角点检测来提取文本区域;第二个分支用类似RFCN的网格划分的思路做位置敏感分割。最后,使用NMS算法对候选文本区域进行过滤。

5. 方法细节:

5.1 主要创新:

1)提出了结合目标检测和语义分割思想的新的场景文本检测算法,可实现端到端的训练评估;

2)基于位置敏感ROI pooling提出了旋转位置敏ROI pooling层实现任意方向传播;

3)可以同时处理多方向旋转文本、高长宽比文本、近距离文本区域等场景;

4)检测准确性和速度性能相比较其他方法更优。

5.2 整体流程:

如fig2所示,完整的端到端过程包含以下几个步骤。

首先经过backbone网络进行特征提取,然后,将提取好的特征并行输入到两个分支中共享特征。其中,第一个分支为Corner Detection,用来进行候选bounding box的生成,这部分类似于传统的目标检测算法;第二个分支为Position ensitive Segmentation,用于将特征图逐像素打分,和一般分割不同的是输出4个score map,分别对应左上、左下、右上、右下不同位置的得分;最后,通过Corner Detection 和 Position sensitive Segmentation共同计算得分,去掉低于置信度阈值的候选框,经过NMS后处理即得到最终的文本区域。

5.2 网络架构:主要包括三个部分,如fig3所示

![]() 1)Feature Extraction:模型的backbone网络,使用了预训练的VGG16,将VGG16的最后两个全连接层换成卷积层,同时添加4个卷积层以增大感受野,再追加堆叠6个带残差的反卷积层提升分辨率;

1)Feature Extraction:模型的backbone网络,使用了预训练的VGG16,将VGG16的最后两个全连接层换成卷积层,同时添加4个卷积层以增大感受野,再追加堆叠6个带残差的反卷积层提升分辨率;

2)Corner Detection:用来生成候选检测框,是一个独立的检测模块,类似于RPN的功能。这里面Fi为反卷积得到的特征图,经过DSSD框架后得到,score branch得到2种score,offset branch四种偏移量。最后,使用DSSD中过滤的方法得到候选bounding box;

3)Position sensitive Segmentation:位置敏感分割,用于对Coner Detection得出的候选bounding box打分使用。这部分将文本区域划分为g*g个网格(bin),使用上采样过后的反卷积层F3、F4、F7、f8、F9合并的结果作为特征图,输出g*g个通道的特征图。

5.3 损失函数:包含3个部分

1) Lconf是Corner Detection中分数分支的损失函数,用来衡量置信度的损失,这里使用了交叉熵损失;

2) Lloc是Corner Detection中偏移量分支的损失函数,用来衡量模块中定位边角点的损失,这里使用了Smooth L1损失;

3) Lseg是计算位置敏感分割中的损失函数,这里使用了Dice巡视;

4) Nc是正样本默认box的数量,Ns是分割图中像素的数量。Nc和Ns用来归一化边角点预测和分割的损失。λ1和λ2是平衡因子,λ1的默认值是1,λ2的默认值是10。

译文:

基于边角的多方向场景文本检测和区域分割

(25 Feb 2018)白翔团队

Abstract

此前,效果较好的基于深度学习的场景文本检测方法可以大致分为两类。第一类是将场景文本看作通用目标,进而使用通用目标检测算法来定位场景文本区域,通常的方式是使用回归的文本框。但是由于场景文本的多方向性和较大的宽高比,这种方法通常比较困难。第二种方法是直接分割文本区域,但大多数情况下需要复杂的后处理过程。在这篇文章中,我们提出了一种结合以上两种思路以避免各自缺陷的方法,通过定位边角点的文本框并在相关位置分割文本区域的场景文本检测算法。在模型的前向传播阶段,通过采样和分组边角点生成候选框,用于进行特征分割和NMS过滤。结合了之前的方法以后,我们所提方法能够处理多方向自然场景中的文本并且不必进行复杂的后处理过程。我们在ICDAR2013,ICDAR2015, MSRA-TD500, MLT和COCO-Text等数据集上都进行了实验,实验结果证实了我们所提出方法较好效果。其中,基于VGG16网络的模型,在ICDAR2015上达到了84.3%的F值,在MSRA-TD500上取得了81.5%的F值。

1. Introduction

最近,由于在现实中日益增长的自然场景文本识别需求(商品搜索、图像修复、自动驾驶),有关从自然场景中提取文本信息的研究变得越来越热门。自然场景文本检测在多种文本阅读体系中占据着重要的角色。

长文本检测是一种挑战,其原因有二。外部原因是由于环境的问题,如噪音,模糊,光线遮挡等,这些也是自然场景目标检测的难题;内部原因是由场景文本的特点和多样性造成的。与通用目标检测对比,场景文本检测更加复杂:

1)场景文本可能在自然图片中具有多种方向,因此文本框可能是旋转矩形或者四边形;

2)宽高比巨大;

3)场景文本可能是字符、单词或文本行,算法可能在定位边界时会很困难。

过去几年,随着目标检测和语义分割研究的高速发展,场景文本检测已经被广泛研究并取得了明显的进步。一些基于通用场景目标检测和语义分割,修改为使用文本检测的模型更加精准。这些模型可以被归类划分到两个分支:第一个分支是基于通用目标检测(SSD, YOLO, DenseBox)算法的模型,例如,TextBoxes, FCRN和EAST等,这些算法直接预测候选文本框。第二个分支是基于语义分割,能够生成语义分割图,并通过后处理产生最终的文本框。

与先前方法不同的是,我们在这篇文章中结合了目标检测和语义分割的思想,并在一种可选的方式下应用它们。这么做的目的是源于两种观察:

1)不管矩形的尺寸是什么,长宽比或者矩形的角度是什么,它都可以被边角点唯一确定;

2)区域语义特征能够提供有效的文本位置信息。

因此我们首先检测文本区域的边角点(上左,上右,下右,下左,类似fig1中展示的)而不是直接检测文本框。除此之外,我们预测位置语义分割map而不是直接预测文本/非文本区域。最后,我们通过采样和组合检测边角点生成候选生成候选的bounding box,并通过语义信息估计不可能的bounding box。我们将整条pipeline描述在fig2中。

![]()

下面,列出本文的主要优势:

1)因为我们通过采样和组合边角点来检测区域文本,我们的方法能够处理任意方向的文本;

2)检测边角点而不是bounding box让我们的方法自然而然的避免了长宽比剧烈变化的问题;

3)位置语义分割的使用让我们可以较好的分割出文本实例,无论是字符级别、单词级别或文本行级别;

4)在我们的方法中,候选框的边界决定于边角点,与从anchor或文本区域中回归文本框相比,我们产生的文本框更加准确,特别是对长文本来说。

我们在水平文本、长文本和多角度和多语言的公开数据集上都验证了本文方法的有效性(公开评测指标)。结果展示出了我们所提出的方法在准确率和速度上的优势。特别的是,在ICDAR-2015,MSRA-TD500和MLT上的F值各自为84.3%,81.5%和72.4%,这些都超出了先前的最优结果。而且,我们的方法在速度性能上一样具有竞争力,检测速度超过10.4张图片(512*512)/s。

本文的贡献有四点:

1)我们提出了一种包含目标检测和语义分割功能的新的场景文本检测器,可以实现端到端训练和评估。

2)基于位置敏感的ROI pooling,我们提出了一种旋转的位置敏感ROI average pooling层,能够处理任意方向的传播。

3)我们的方法可以应用处理先前方法效果不好的多方向场景文本。

4)我们的方法在准确率和性能上都表现的更好。

2. Related Work

2.1 Regression Based Text Detection

基于文本检测的回归已经成为了过去两年文本检测的主流算法。一些基于通用目标检测已经达到了较好的效果。基于SSD算法的TextBoxes[27]使用了“long”默认框和“long”的卷积核来处理大长宽比的问题。类似的,[32]利用Faster-RCNN的框架,并在RPN中添加了旋转anchors来检测多方向文本。SegLink[39]算法预测文本语义,并使用SSD风格的网络连接语义像素成为文本框,以此处理长的多方向文本。基于DenseBox,EAST直接回归文本框。

我们的方法也从通用目标检测算法DSSD[11]中获得灵感。但不同于以上所列方法那样回归文本框或直接回归语义,我们提出了使用边角点来定位位置,同时通过采样和组合检测边角点来生成文本框。

2.2 Segmentation Based Text Detection

基于文本检测的分割是另一种文本检测的研究方向。受FCN[31]的启发,一些方法倾向于使用分割map检测场景文本。[52]首先利用FCN从分割map中提取文本块,然后使用MSER[34]在这些文本块中检测字符,并通过前置规则将检测出的字符组合成为单词或文本行。在[50]中使用了FCN来预测图片中的三种类型的map(文本区域,字符和连接方向)。然后使用一些后处理规则来处理这三种map以获得文本bounding box。

不同于先前的基于文本检测方法的分割(需要复杂的后处理规则),我们的方法简洁高效。在前向传播阶段,我们提出的旋转位置敏感average ROI pooling层能够通过位置敏感分割map来预测候选框的得分。

2.3 Corner Point Based General Object Detection

基于通用目标检测的边角点是一种新的通用目标检测趋势。在DeNet[45]中,作者提出了一种边角点层和一个稀疏采样层来代替基于Faster-RCNN系的二阶模型中的RPN网络。在[48]中,作者提出了PLN(点连接网络)来回归边角点/中心点的bounding box并使用全卷积网络来建立这些点之间的连接,然后,使用这些点坐标和连接关系来生成目标的bounding box。

我们的方法受到基于边角点的目标检测算法的启发,却又十分不同。第一,边角点检测器不同;第二,我们使用分割map来计算候选框的得分;第三,算法可以产生多方向的目标框。

2.4 Position-Sensitive Segmentation

最近,许多基于特征敏感map的语义分割方法被提出来了。在[8]中作者利用了相对位置来分割和前向传播InstanceFCN。在FCIS[26]中,作者借助了位置敏感内/外分数图,提出了实例敏感的端到端语义分割网络。

我们也参考了位置敏感分割map来预测文本区域。与以上提及的方法相比较,主要有三点不同:

1)我们直接使用位置敏感真实样本优化网络(4.1.1详细描述);

2)不同于FCIS算法使用的两种类型的位置敏感map,我们的位置敏感map可以同时用于预测文本区域和分数特征(4.2.2);

3)我们提出的旋转位置敏感ROI average pooling能够处理多方向的情况

3. Network

我们方法中的网络是一种全卷积网络,起到特征提取,边角点检测和位置敏感语义分割的作用。网络的结构展示在fig3中。给定一张图片,网络产生候选边角点和分割map。

3.1 Feature Extraction

我们的模型主干网络使用预训练的VGG16,同时对以下问题进行考虑:

1)场景文本的尺寸变化剧烈,主干网络必须有足够强的能力来处理好这个问题;

2)自然场景中的背景复杂,因此特征必须包含足够多的信息。参考FPN和DSSD算法对这些问题的良好解决,我们在FPN/DSSD架构中扩展特征。

在网络细节上,我们将VGG16中的fc6和fc7层换成conv6和conv7层。同时又在conv7后面叠加了一些额外的卷积层(conv8-conv11),来扩大感受野,增强特征提取的能力。然后,我们在从上到下的路径上使用了DSSD[13]中提出的一系列的反卷积模块,如fig3所示。特别的,为了使用不同尺寸的文本区域,我们从conv11到conv3总共串联了6个反卷积模块,包含256个通道。为了方便表示,我们将卷积层对应的特征表示为Fi,例如conv11的特征表示为F11。最后,通过conv11和反卷积模块来扩展特征,这样一来,我们就有了丰富的特征表示,可以更好的进行边角点检测和位置语义map预测了。

3.2 Corner Detection

对于一个给定的旋转矩形bounding box R=(x, y, w, h, xita) ,它有4个边角点,可以表示为一组顺时针的二维坐标{(x1, y1), (x2, y2), (x3, y3), (x4, y4)}。为了方便表示,我们使用一个水平正方形C=(xc, yc, ss, ss)重定义和表示了边角点,其中xc, yc 是边角点(例如左上边角点),也是水平正方形的中心。ss是旋转矩形bounding box R的短边长度。

参考了SSD和DSSD,我们使用预先设定的boxes检测边角点。不同于DSSD或SSD中每个默认box输出分类分数和相对候选box偏移量的方式,边角点检测更加复杂,因为可能在一个相同位置出现不止一个边角点(例如在一个位置可能同时有下左和上右边角点box)。因此在我们的例子中,默认的box应该输出分类分数和对应于4类边角点的4个候选框偏移量。

我们使用了[11]中提出的预测模块在一次卷积过程的两个分支分别预测分数和偏移量。为了减少计算复杂度,所有卷积核的大小设置为256。对于一个大小为m*n的特征图,在每个单元中有k个box。对每个box,分数分支和偏移量分支输出2个分数和4个偏移量。这里分数分支中“2”代表该位置是否为边角点。总的来说,输出通道的分数分支和偏移量分支大小为 k*q*2和k*q*4,其中q代表边角点的类型,默认是4。

在训练阶段,我们遵从SSD中默认box和真实box的匹配策略。为了适应不同尺寸下的场景文本,我们在多种特征图下使用多种尺寸的默认box。所有默认box的尺寸被列在tab1中。默认的高宽比设置为1。

3.3 Position-Sensitive Segmentation

在先前基于文本检测的分割方法[52, 50]中,分割图被用于表示每个像素属于文本区域的概率值。然而那些文本区域在分数图中总是不能够彼此分开,结果就是导致文本区域的重叠和文本像素的错误预测。为了从分割图中得到文本的bounding box,[50, 52]进行了复杂的后处理。

与先前的文本分割方法使用相关联位置作为文本区域相比,我们受到InstanceFCN[8]的启发,使用位置敏感分割来创建文本分割图。更详细的说,对于一个文本bounding box R,一个g*g的规则网格用于分割该文本boungding box成为多个单元(例如,对于一个2*2的网格,一个文本区域能够被分割为4个单元,分别是上左,上右,下右,下左)。对于每个单元,分割图都被用于表示该像素是否属于该单元。

我们在带有边角点检测的同一网络中创建了位置敏感分割器。重用了特征F3,F4,F7,F8,F9并追加边角点检测分支中的残差块架构来建立一些卷积块(见fig3)。这些模块的所有输出都通过双线性上采样放缩到F3的尺寸范围,上采样的比例分别为1,2,4,8,16。然后,所有具有相同尺寸的输出都被添加到一起concate成为更加丰富的特征。为了进一步为了扩大融合特征的分辨率,我们使用两个连续的1*1conv-BN-Relu-Deconv2*2模块,并设置最后的反卷积层的卷积核为g*g。因此,最后的特征敏感分割图具有g*g的通道数,并具有与输入图片相同的尺寸。在本文中,我们设置g默认为2。

4. Training and Inference

4.1 Training

4.1.1 Label Generation

对于一个输入训练样本,我们首先将真实样本的每个文本框转化为覆盖最小文本框区域的矩形;然后,设置相对位置和4个边角点。

我们通过以下规则来设置一个旋转矩形的相对位置:

1)上左,下左边角点的x坐标必须小于上右,下右边角点的x坐标;

2)上左和上右边角点的y坐标必须小于下左,下右边角点的y坐标。这样一来,原始的真实样本可以被表示为一个具有边角点相对位置的旋转矩形。为了方便,我们记为旋转矩形R={Pi|i属于{1,2,3,4}},其中Pi=(xi, yi)是旋转矩形在上左,上右,下右和下左边角点;

我们使用R生成边角点检测和位置敏感分割的label。对于边角点检测,我们首先计算R的短边和代表4个边角点的水平正方形,如fig5(a)中所示。对于位置敏感分割,我们使用R生产出文本/非文本的pixel-wise标记。我们首先使用与输入图片相同的尺寸并设置所有的像素值为0来初始化4个标记。然后我们将R分成2*2的规则网格单元,就这样形成了4个单元,并将每个单元分给一个标记,例如上左单元分给第一个标记。然后,我们设置这些单元中的所有像素的值为1,如fig5(b)所示。

4.1.2 Optimization

我们同时训练边角点检测和位置敏感分割。损失函数定义如下:

其中,Lconf是分数分支的损失函数,用来预测置信度;Lloc是偏移量分支的损失函数,用来在模块中定位边角点。Lseg是位置敏感的损失函数。Nc是正样本默认box的数量,Ns是分割图中像素的数量。Nc和Ns用来归一化边角点预测和分割的损失。λ1和λ2是平衡因子,默认λ1是1,λ2是10。

我们使用SSD中的匹配策略来训练分数分支,使用交叉熵损失:

这里yc代表真实样本的所有默认box,正样本为1否则为0。pc代表预测分数。考虑到正负样本的极度不平衡问题,类均化很有必要。我们使用[40]提出的在线负样本挖掘来平衡训练样本,并设置正负样本比例为1:3。

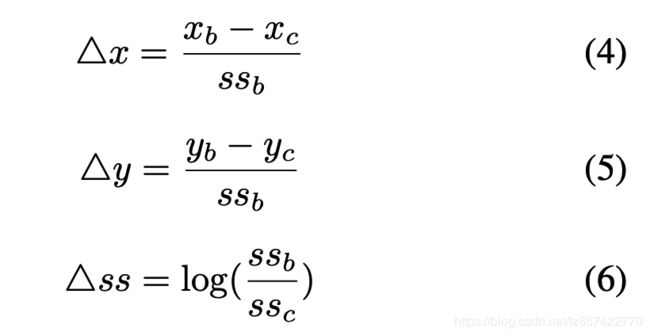

对于偏移量分支,我们像Fast RCNN一样回归默认box的相对偏移量,并使用Smooth L1损失优化它们:

![]()

其中,yl=(detx, dety, detss, detss)是真实偏移量分支的真实样本,pl是预测样本。yl能够通过默认box B=(xb, yb, ssb, ssb)和一个边角点 box C=(xc, yc, ssc, ssc)计算得出:

![]()

我们使用最优化Dice损失[33]来训练位置敏感分割:

![]()

其中ys是位置敏感分割的真实值l,ps是我们的分割模块的预测。

4.2 Inference

4.2.1 Sampling and Grouping

在前向传播阶段,很多带有预测位置、短边长度和置信度的的边角点被产生出来。具有高分数(默认超过0.5为高分数)的点被保留。在经过NMS之后,包含4个边角点的集合可以通过相对位置信息组合而得到。

我们通过采样和组合预测边角点来生产候选bounding box。在理论上,一个旋转矩形能够被两个点和一个与其垂直的边构建出来。对于一个预测点,短边已知,因此我们可以通过采样和组合一个边角点集合中的两个来直接构建一个旋转矩形,例如(上左,上右),(上右,下右),(下左,下右),(下左,上左)。

我们使用一些前置规则来过滤掉不合适的边角点对:

1)不能违背位置关系,例如上左的x必须小于上右的的x坐标位置;

2)已构建的旋转矩形的最短边必须高于阈值(默认为5);

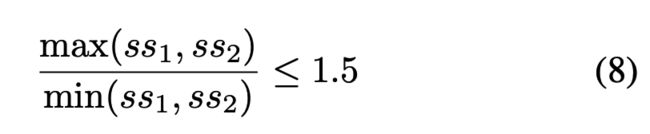

3)成对的两点预测出的短边ss1和ss2必须满足:

4.2.2 Scoring

在采样和组合边角点以后,会生成大量的候选bounding box。收到InstanceFCN和RFCN的启发,我们通过位置敏感分割图给候选bounding box赋予分数。具体的过程展示在fig5中。

为了处理旋转文本bounding box,我们改进了[9]中提出的位置敏感ROI pooling层成为旋转位置敏感ROI Average pooling层。特别的,对于一个旋转的box,我们首先将该box分割为g*g个单元,然后我们对每个单元建立一个最小覆盖矩形。对该单元中的所有像素重复该步骤,并计算所有像素的最小覆盖矩形的均值。最后,旋转bounding box的分数就是g*g单元中的分数均值。具体过程可见算法1:

低分数的候选box会被过滤掉,我们将阈值τ默认设置为0.6。

5. Experiments

为了验证本文方法的有效性,我们在5个开源数据集上进行实验:ICDAR21015、ICDAR2013、MSRA-TD500、MLT、COCO-Text,并与其他的业界领先算法进行比较。

5.1 Datasets

5.2 Implementation Details

训练:我们的模型是在SynthText上预训练,然后在其他数据集上finetuning(除了COCO-Text)。我们使用Adam作为优化器,学习率调整到1e-4。在预训练阶段,我们在SynthText上训练一个epoch。在finetuning阶段,迭代的次数取决于数据集的尺寸。

数据增强:我们使用与SSD算法中相同的数据增强方式。在输入图片中随机采样一小块,然后重放缩到512*512。

后处理:NMS是本算法的一个唯一的后处理步骤,设置阈值为0.3。

我们的方法使用PyTorch实现,所有的实验构建在工作站上(CPU: Intel(R) Xeon(R) CPU E5-2650 v3 @ 2.30GHz; GPU:Titan Pascal; RAM: 64GB)。训练的batch大小设置为24,GPU数量为4。评测时GPU为1个,batch大小设置为1。

5.3. Detecting Oriented Text

我们在ICDAR2015数据集上评估模型对于多方向文本的能力。我们将模型在ICDAR2015和ICDAR2013数据集上finetune另外500个epoch。值得强调的是,为了更好的检测垂直方向的文本,在最后的15个epoch,我们使用0.2的概率随机旋转了采样样本90度。在测试中,我们设置τ为0.7并且resize输入图片到768/*1280。参考了[53,17,16],我们也在ICDAR2015数据集上使用多尺度评估我们的模型,默认τ{512×512, 768×768, 768×1280, 1280×1280} 。

我们将本文方法与业界领先方法对比的结果列在了tab2中。本文方法性能高于其他方法很多。当使用单一尺度评测时,我们方法的F值达到了80.7%,远超其他方法;在使用多尺度评测时,F值为84.3%,超过目前最优算法3.3%。

为了探索本文基于边角点的方法和基于回归文本框的方法的差距,我们训练了一个与本文方法参数设置相同的网络命名为baseline,列在tab2中。baseline网络包含与本文方法相同的主干网络和类似SSD/DSSD的相同预测模块。在略微多的时间消耗下,本文方法取得了巨大的准确率提升(53.3% VS 80.7%)。

5.4. Detecting Horizontal Text

我们在ICDAR2013数据集上评估模型对于水平文本的能力。我们在fintuned的ICDAR2015模型的基础上使用ICDAR2013的数据集训练了60个epoch。在测试中,输入图片放缩到512*512。我们也使用了多尺寸输入来评估我们的模型。

结果被列在了tab3中,大多数使用了"Deteval"评估指标。我们的方法达到了一个非常有竞争力的结果。当使用单尺度进行评测时,我们的方法达到了85.8%的F值,仅仅比最优结果低一点。而且,我们的方法速度达到10.4FPS,远远快于大多数方法。对于多尺度评测,我们的方法达到88.0%的F值,相比较其他方法也十分具有竞争能力。

5.5 Detecting Long Oriented Tect Line

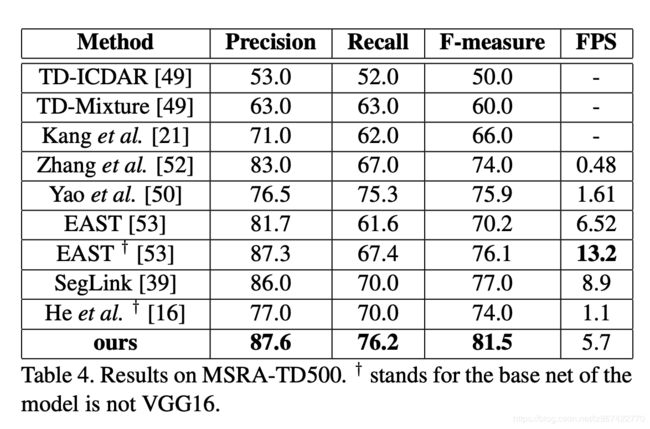

在MSRA-TD500数据集上,我们评估模型的检测长文本和多语言文本行的能力。HUST-TR400也被用做训练数据,因为MSRA-TD500仅仅包含300个训练图片。模型初始化使用在SynthText上的预训练模型,然后finetuned了另外240个epoch。在测试阶段,输入图片尺寸设置为768*768并且设置τ为0.65。

正如在tab4中展示的那样,我们的方法超过先前所有方法很多。我们的方法在召回率、精度和F值等方面均达到了业界领先水准,远超先前结果。这意味着我们的方法更加适合检测任意方向的长文本。

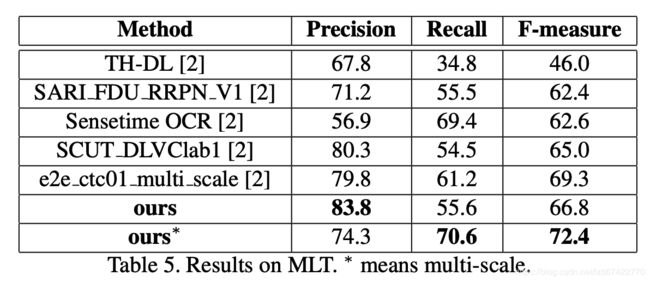

5.6 Detecting Multi-Lingual Text

我们在MLT数据集上验证本文模型的多语言文本检测的能力。使用SynthText的预训练模型并finetune大概20个epoch。当在单尺度输入下进行测试,输入图片尺寸设置为768*768。我们在线评估了本文方法并和其他的优秀方法进行了对比。正如tab5中展示的那样,我们的方法高出所有的方法至少3.1%个点。

5.7 Generaliization Ability

为了评估模型的通用能力,我们使用finetuned的ICDAR2015的模型测试COCO-Text数据集。设置图片尺寸为768*768。使用标注(V1.1)来对比其他方法,为了公平起见,结果如tab6。在COCO-Text未训练的场景下,我们的模型达到了42.5%的F值,比其他方法更好。

除此之外,我们也在ICDAR2017 鲁棒性阅读挑战COCO-Text标注(V1.4)上进行了评测,我们方法在所有排名中登顶。特别是当阈值设置为0.75,我们方法超越其他方法很大一部分,这展示了本文方法在文本检测方面的优越性。

5.8 Limitations

本文方法的局限性是当两个文本实例非常接近时,它可能把两个文本行预测成为一个(fig7),因为位置敏感分割可能失效。除此之外,该方法在扭曲文本方面检测较差(fig7),因为训练集合中扭曲文本非常少。

6. Conclusion

在这篇文章中,我们提出了一种使用边角点和位置敏感分割来定位文本的场景文本检测器。我们在一些文本区域为多方向、水平长文本、多语言等的开源数据集上评测该方法。我们的方法具有更加卓越的性能,显著的效果和更好的鲁棒性。在未来,我们将要在所提方法上研究构造一种端到端的OCR体系。

References

见论文页

https://arxiv.org/pdf/1802.08948.pdf

提交错误或技术交流请联系邮箱:[email protected];

欢迎互相交流学习~