HigherHRNet论文详解

Hello,今天要更新一下“HigherHRNet- Scale-Aware Representation Learning for Bottom-Up Human Pose Estimation”论文的详解,文章被CVPR 2020接收。先对文章进行翻译:

摘要

自下而上的人体姿态估计方法由于尺度变化的挑战而难以为小人体预测正确的姿态。在本文中,我们提出了HigherHRNet:一种新的自下而上的人体姿势估计方法,用于使用高分辨率特征金字塔学习尺度感知表示。该方法配备了用于训练的多分辨率监督和用于推理的多分辨率聚合,能够解决自下而上的多人姿势估计中的尺度变化挑战,并能更精确地定位关键点,尤其是对于小人物。HigherHRNet中的特征金字塔包括HRNet的特征图输出和通过转置卷积进行上采样的高分辨率输出。在COCO test-dev中,HigherHRNet的中等人体的AP性能比以前最佳的自下而上方法高2.5%,显示了其在处理尺度变化方面的有效性。此外,HigherHRNet在COCO test-dev(AP: 70.5%)上获得了最新的最新结果,而无需使用优化或其他后处理技术,从而超越了所有现有的自下而上的方法。HigherHRNet甚至在CrowdPose测试(AP:67.6%)上超过了所有自上而下的方法,表明它在拥挤场景中的稳健性。这些代码和模型可从https://github.com/HRNet/Higher-HRNet-Human-Pose-Estimation获得。

1.引言

2D人体姿势估计旨在定位人体解剖学关键点(例如肘部,腕部等)或部位。作为人类行为理解的基本技术,近年来受到越来越多的关注。

当前的人体姿势估计方法可以分为自上而下的方法和自下而上的方法。自上而下的方法[34、9、16、42、38、40、39、16]依赖于人体检测器来检测每个带有边界框的人体实例,然后将问题简化为一个简单的单人姿势估计任务。由于自上而下的方法可以通过裁剪和调整检测到的人的边界框的大小来将所有人标准化为大致相同的比例,因此它们通常对人的比例变化不那么敏感。因此,在各种多人人体姿势估计基准上的最新性能大多是通过自上而下的方法实现的。然而,由于这种方法依赖于单独的人体检测器并且需要分别估计每个人的姿势,因此它们通常是计算密集的并且不是真正的端到端系统。相比之下,自下而上的方法[3、30、33、22]首先通过预测不同解剖学关键点的热图来定位输入图像中所有人的无身份关键点,然后将它们分组为人实例。该策略有效地使自下而上的方法更快,并且更有能力实现实时姿势估计。但是,由于自下而上方法需要处理规模变化,因此自下而上和自上而下方法的性能之间仍然存在很大的差距,特别是对于小尺度人体而言。

图1.(a)使用图像金字塔进行热图预测[33,30]。(a)通过对图像进行上采样来生成更高分辨率和空间上更准确的热图。PersonLab [33]的最新工作依赖于扩大输入图像的大小来生成高质量的特征图。(c)我们的HigherHRNet使用高分辨率特征金字塔。

预测小尺度人体的关键点主要有两个挑战。一种是应对尺度变化,即在不牺牲大人体性能的情况下提高小人体的性能。另一种方法是生成高质量的高分辨率热图,以精确定位小型人群的关键点。以前的自下而上的方法[3、30、33、22]主要集中于对关键点进行分组,并且仅使用特征图的单一分辨率(即输入图像分辨率的1/4)来预测关键点的热图。这些方法忽略了尺度变化的挑战,并在推理过程中依赖图像金字塔(图1(a))。特征金字塔是处理次尺度变化的基本组件,但是,自顶向下的特征金字塔中分辨率较低的特征图通常会遇到第二个挑战。PersonLab [33]通过提高输入分辨率来生成高分辨率的热图(图1(b))。尽管随着输入分辨率的提高,小型人体的性能将持续提高,但是当输入分辨率太大时,大型人员的性能将开始下降。为了解决这些挑战,至关重要的是,以自然而简单的方式为自下而上的关键点预测生成空间上更准确且具有尺度感知的热图,而又不会牺牲计算成本。

在本文中,我们提出了一个尺度感知的高分辨率网络(HigherHRNet)来应对这些挑战。HigherHRNet通过新的高分辨率特征金字塔模块生成高分辨率热图。与传统的特征金字塔从1/32分辨率开始并使用具有横向连接的双线性上采样逐渐将特征图分辨率提高到1/4有所不同,高分辨率特征金字塔直接从1/4分辨率开始,这是backbone中最高分辨率的特征。通过反卷积生成甚至更高分辨率的特征图(图1(c))。我们在HRNet的1/4分辨率路径上构建高分辨率要特征金字塔[38,40],以使其高效。为了使HigherHRNet能够处理尺度变化,我们进一步提出了一种多分辨率监督策略,以将不同分辨率的训练目标分配给相应的特征金字塔级别。最后,我们在推理过程中引入了一种简单的“多分辨率热图聚合”策略,以生成尺度感知的高分辨率热图。

我们在具有挑战性的COCO关键点检测数据集上验证了我们的方法[27],并展示了出色的关键点检测性能。具体来说,HigherHRNet在COCO2017 test-dev上无需任何后期处理即可达到70.5%的AP,大大优于所有现有的自下而上的方法。此外,我们观察到,大多数收益来自中级人体(关键点检测任务没有小人体标注),HigherHRNet在不牺牲性能的情况下,对中型人体的性能比以前最佳的自下而上方法高2.5%。大人体(+0.3%AP)。这一观察结果证明HigherHRNet确实在解决尺度变化难题。我们还为新的CrowdPose [24]数据集上的自下而上方法提供了坚实的基础。我们的HigherHRNet在CrowdPose测试中的AP达到67.6%,超过了所有现有方法。该结果表明,自下而上的方法在拥挤的场景中自然具有优势。

我们的贡献如下:

•我们尝试解决尺度变化的挑战,这在自下而上的多人姿势估计中很少进行研究。

•我们提出了一个HigherHRNet,它可以在训练阶段生成具有多分辨率监督的高分辨率特征金字塔,并在推理阶段生成多分辨率热图聚合,以预测有利于小型人体的尺度感知的高分辨率热图。

•我们在具有挑战性的COCO数据集上展示了我们的HigherHRNet的有效性。我们的模型优于其他所有自下而上的方法。我们尤其观察到中型人体的巨大增益。

2.相关工作

top-down 方法:自上而下的方法[42、38、40、34、16、18、15、9、31]在人体的边界框内检测单个人的关键点。人体边界框通常由目标检测器[36、26、14、13]生成。Mask R-CNN [16]直接在Faster R-CNN [36]上添加关键点检测分支,并在ROIPooling之后重用features。G-RMI [34]和以下方法进一步将自上而下的方法分为两个步骤,并使用单独的模型进行人体检测和姿势估计。

bottom-up 方法:自下而上的方法[35,19,20,3,30]在图像中为所有人检测无身份的身体关节,然后将其分组。OpenPose [3]使用两分支多阶段网络,其中一个分支用于热图预测,一个分支用于分组。OpenPose使用一种称为 part affinity field的分组方法,该方法学习链接两个关键点的2D矢量场。通过计算两个关键点之间的线积分并将其与最大积分对进行分组来完成分组。Newell等。[30]使用堆叠沙漏网络[31]进行热图预测和分组。分组是通过一种称为关联嵌入的方法完成的,该方法为每个关键点分配一个“tag”(向量表示),并根据标签向量之间的L2距离对这些关键点进行分组。PersonLab [33]使用dialated ResNet [17]并通过直接学习每对关键点的2D偏移字段来对关键点进行分组。PifPaf [22]使用Part Intensity Field(PIF)来定位身体部位,并使用Part Association Field(PAF)将身体部位彼此关联以形成完整的人体姿势。

特征金字塔:金字塔形表示已在最近的目标检测和分割框架中被广泛采用以处理尺度变化。SSD [29]和MSCNN [2]可以预测网络多层中的目标,而无需合并功能。特征金字塔网络(FPN)[26]使用自上而下的路径扩展了主干模型,该路径使用双线性上采样和横向连接逐渐将特征分辨率从1/32恢复到1/4。共同的动机是让来自不同金字塔等级的特征预测不同尺度的实例。但是,这种金字塔形表示法在自下而上的多人姿势估计中很少得到探索。在这项工作中,我们设计了一个高分辨率的特征金字塔,该金字塔将金字塔扩展到另一个不同方向,从1/4分辨率的特征开始,并生成具有更高分辨率的特征金字塔。

高分辨率特征图:生成高分辨率特征图的方法主要有4种。(1)Encoderdecoder [31、16、9、37、1、25、41、10]捕获编码器路径中的上下文信息,并恢复解码器路径中的高分辨率特征。解码器通常包含一系列双线性上采样操作,并具有相同分辨率的编码器功能的跳过连接。(2)扩展卷积[44、5、6、7、8、4、28、43、11、12](也称为“atrous”卷积)用于删除多个跨步卷积/最大池,以保留特征图分辨率。扩散卷积可防止丢失空间信息,但会带来更多的计算成本。(3)在网络末端依次使用反卷积(转置卷积)[42],以有效地提高特征图的分辨率。SimpleBaseline [42]演示了反卷积可以生成用于热图预测的高质量特征图。(4)最近,提出了一种高分辨率网络(HRNet)[38,40],作为在整个网络上保持高分辨率传输的有效方法。HRNet [38,40]由具有不同分辨率的多个分支组成。较低分辨率的分支捕获上下文信息,而较高分辨率的分支保留空间信息。通过分支之间的多尺度融合,HRNet [38,40]可以生成具有丰富语义的高分辨率特征图。

我们采用HRNet [38,40]作为我们的基础网络来生成高质量的特征图。并且我们添加了一个反卷积模块,以生成更高分辨率的特征图以预测热图。生成的模型称为“尺度感知“的高分辨率网络”(HigherHRNet)。由于HRNet [38、40、40]和反卷积都是有效的,HigherHRNet是一种高效模型,可用于生成用于热图预测的高分辨率特征图。

3.Higher-Resolution Network

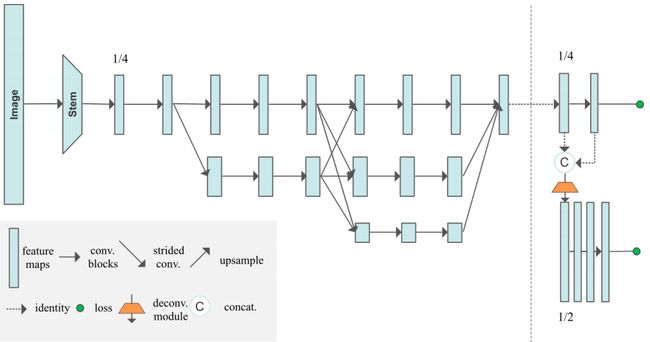

在本节中,我们介绍使用HigherHRNet提出的尺度感知的高分辨率表示学习。图2说明了我们方法的总体架构。我们将首先简要介绍提出的HigherHRNet,然后详细描述其组成部分。

3.1.HigherHRNet

HRNet:HigherHRNet使用HRNet [38,40](如图2所示)作为backbone。HRNet [38,40]在第一阶段从高分辨率分支开始。在随后的每个阶段中,都会将一个新分支与当前分支中分辨率最低的1/2并行添加到当前分支中。随着网络具有更多阶段,它将具有更多具有不同分辨率的并行分支,并且先前阶段的分辨率都保留在以后阶段。图2显示了一个包含3个并行分支的示例网络结构。

我们使用与HRNet [38,40]类似的方式实例化backbone。网络从一个stem开始,该stem由两个跨步的3×3卷积组成,将分辨率降低到1/ 4。第一级包含4个残差单元,其中每个单元由一个bottleneck(宽度(通道数)为64)形成,然后是一个3×3卷积,将特征图的宽度减小到C。第二,第三,第四级包含1, 4个和3个多分辨率块。四个分辨率的卷积宽度分别为C,2C,4C和8C。多分辨率群卷积中的每个分支都有4个残差单位,每个单位的每个分辨率中都有2个3×3卷积。通过将C分别设置为32和48,我们可以测试两个容量不同的网络。

HRNet [38,40]最初是为自上而下的姿势估计而设计的。在这项工作中,我们通过添加1×1卷积来预测热图和标tagmap,从而将HRNet [38,40]应用于自下而上的方法,类似于[30]。我们仅使用最高分辨率(输入图像的1/4)的特征图进行预测。[30]之后,我们为每个关键点使用标量tag。

HigherHRNet:热图的分辨率对于预测小型人群的关键点很重要。现有的大多数人体姿势估计方法都是通过准备ground truth 热图来预测高斯平滑的热图,其中将未标准化的高斯核应用于每个关键点位置。添加此高斯核有助于训练网络,因为CNN倾向于输出空间平滑的响应,这是卷积运算的本质。但是,应用高斯核也会给关键点的精确定位带来混乱,特别是对于属于小人物的关键点。减少这种混乱的简单方法是减少高斯核的标准偏差。但是,从经验上我们发现,这会使优化变得更加困难,并导致更糟糕的结果。

图2. HigherHRNet的示意图。该网络使用HRNet [38,40]作为backbone,随后是一个或多个反卷积模块以生成多分辨率和高分辨率热图。多分辨率监督用于训练。更多细节在第3节中给出。

我们没有降低标准偏差,而是通过以更高的分辨率预测热图来解决此问题,而在不同分辨率下标准偏差不变。自下而上的方法通常以输入图像的分辨率1/4预测热图。但是我们发现该分辨率还不足以预测准确的热图。受[42]的启发,这表明可以使用反卷积有效地生成高质量和高分辨率的特征图,我们通过在图2中所示的HRNet中最高分辨率的特征图的基础上,通过添加一个反卷积模块来构建HigherHRNet,如图2所示。第3.3节。

反卷积模块将来自HRNet的特征和预测热图作为输入,并生成分辨率比输入特征图大2倍的新特征图。因此,反卷积模块会与HRNet的特征图一起生成具有两种分辨率的特征金字塔。反卷积模块还通过添加额外的1×1卷积来预测热图。我们遵循第3.4节,以不同的分辨率训练热图预测变量,并使用第3.5节中所述的热图聚合策略进行推理。

如果需要更大的分辨率,可以添加更多的反卷积模块。我们发现反卷积模块的数量取决于数据集人体尺度的分布。一般而言,包含较小人体的数据集需要较大分辨率的特征图才能进行预测,反之亦然。在实验中,我们发现添加单个反卷积模块可在COCO数据集上实现最佳性能。

3.2.Grouping

最近的工作[30,23]表明,可以通过使用关联嵌入的简单方法[30]高精度地解决分组问题。有证据表明,[30]中的实验结果表明,在带有COCO关键点检测数据集的500个训练图像上,使用具有预测tags的ground truth检测将AP从59.2提高到94.0 [27] 。我们遵循[30]将关联嵌入用于关键点分组。分组过程通过将tags具有小的L2距离的关键点分组,将无身份的关键点聚类为多个个体。

3.3. Deconvolution Module

我们提出了一个简单的反卷积模块,用于生成高质量的特征图,其分辨率是输入特征图的两倍。[42]之后,我们使用4×4反卷积(也称为转置卷积),然后使用BatchNorm和ReLU来学习对输入特征图进行上采样。可选地,我们可以在反卷积之后进一步添加几个基本残差块[17],以细化上采样的特征图。我们在HigherHRNet中添加4个残差块。

与[42]不同,反卷积模块的输入是来自HRNet或以前的反卷积模块的特征图和预测的热图的串联。每个反卷积模块的输出特征图也可用于以多尺度方式预测热图。

3.4.Multi-Resolution Supervision

与其他仅对最大分辨率热图应用监视的自下而上的方法[30、33、3]不同,我们在训练过程中引入了多分辨率监督以处理尺度变化。我们将ground truth关键点位置转换为所有分辨率的热图上的位置,以生成具有不同分辨率的ground truth热图。然后,我们将具有相同标准偏差(默认情况下使用标准偏差= 2)的高斯核应用于所有这些ground truth热图。我们发现重要的是不要缩放高斯核的标准偏差。这是因为特征金字塔的不同分辨率适合于预测不同尺度的关键点。在更高分辨率的特征图上,需要相对较小的标准偏差(与特征图的分辨率相比)以更精确地定位小人物的关键点。

在HigherHRNet中的每个预测尺度上,我们计算该尺度的预测热图与其关联的ground truth热图之间的均方误差。热图的最终损失是所有分辨率的均方误差之和。

值得强调的是,由于以下原因,我们没有将不同尺度的人体分配给特征金字塔中的不同级别。首先,用于分配训练目标的启发式方法取决于数据集和网络体系结构。由于数据集(人对所有目标的尺度分布)和体系结构(HigherHRNet仅具有2个金字塔等级,而FPN有4个)变化,很难将FPN [26]的启发式方法转换为HigherHRNet。其次,由于我们应用了高斯核,因此发round truth关键点目标彼此相互作用。因此,仅通过设置忽略区域来分离关键点非常困难。我们认为模型能够自动关注特征金字塔不同级别中的特定尺度。

tagmap的训练与HigherHRNet中的热图不同。我们仅以最低分辨率预测标签图,而不使用所有分辨率。这是因为学习标记图需要全局推理,它更适合于以较低的分辨率预测标记图。根据经验,我们还发现更高的分辨率无法很好地预测标签图,甚至无法收敛。因此,我们遵循[30]来以14分辨率的输入图像在特征图上训练标签图。

3.5. Heatmap Aggregation for Inference

我们提出了推理过程中的热图聚合策略。我们使用双线性插值法将具有不同分辨率的所有预测热图上采样到输入图像的分辨率,并平均所有尺度的热图以进行最终预测。此策略与以前的方法[3,30,33]完全不同,以前的方法仅使用单个尺度或单个阶段的热图进行预测。

我们使用热图聚合的原因是为了启用尺度感知姿势估计。例如,COCO关键点数据集[27]包含从322个像素到超过1282个像素的大规模尺度变化的人。自上而下的方法[34、9、42]通过将人的区域近似标准化为单个尺度来解决此问题。但是,自下而上的方法需要注意尺度,以从所有尺度中检测关键点。我们在HigherHRNet中发现了不同尺度的热图,更好地捕获了不同尺度的关键点。例如,可以在较高分辨率的热图中恢复在较低分辨率的热图中丢失的小人们的关键点。因此,对来自不同分辨率的预测热图进行平均,使HigherHRNet成为可识别尺度的姿势估计器

4.实验

4.1.COCO关键点检测

Dataset. COCO数据集[27]包含超过200000张图像和250000个人体实例,并标有17个关键点。COCO被分为分别具有57k,5k和20k图像的train / val / test-dev集。本文所有实验仅在训练集上进行训练。我们报告了用于消融研究的val设置的结果,并与test-dev设置上的其他最新方法进行了比较。

Evaluation metric. 标准评估指标基于目标关键点相似性(OKS)OKS =  这里是检测到的关键点与其对应的ground truth之间的欧几里得距离,是ground truth的可见性标记,s 是目标尺度, 是控制衰减的每个关键点常数。我们报告标准平均精确度和召回力评分:AP50(OKS处的AP = 0.50),AP75,AP(OKS处的AP评分的平均值= 0.50、0.55,...,0.90; 0.95),中型对象的APM,APL的 大对象和AR(在OKS处的召回平均值= 0.50、0.55,...,0.90、0.95)。

这里是检测到的关键点与其对应的ground truth之间的欧几里得距离,是ground truth的可见性标记,s 是目标尺度, 是控制衰减的每个关键点常数。我们报告标准平均精确度和召回力评分:AP50(OKS处的AP = 0.50),AP75,AP(OKS处的AP评分的平均值= 0.50、0.55,...,0.90; 0.95),中型对象的APM,APL的 大对象和AR(在OKS处的召回平均值= 0.50、0.55,...,0.90、0.95)。

Training. 根据[30],我们使用随机旋转([−30◦,30◦]),随机缩放([0.75,1.5]),随机平移([−40,40])的数据增强来裁剪 输入大小为512×512的图像块以及随机翻转。如第3.4节所述,我们生成了两个分辨率为128×128和256×256的ground truth热图。

我们使用Adam优化器[21]。基本学习率设置为1e-3,在第200个和第260个epochs分别降至1e-4和1e-5。我们对模型进行了总共300个epochs的训练。为了平衡热图损失和分组损失,我们将两个损失的权重分别设置为1和1e-3。

Testing. 我们首先将输入图像的短边尺寸调整为512,并保持宽高比。热图聚合是通过将所有预测的热图的大小调整为输入图像的大小并取平均值来完成的。follow[30],翻转测试用于所有实验。所有报告的数字都是使用单个模型获得的,没用集合。

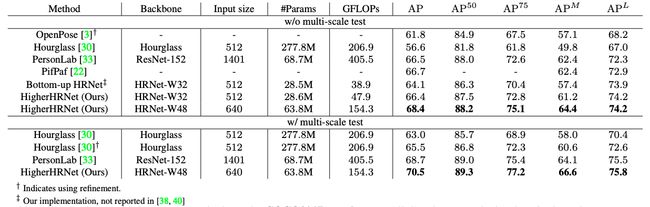

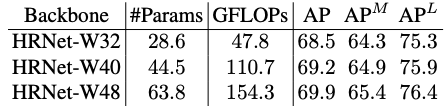

COCO2017 test-dev上的结果:表1总结了COCO2017 test-dev数据集上的结果。从结果可以看出,使用HRNet [38,40]本身已成为自下而上方法(64.1 AP)的简单而强大的基准。我们的仅使用单一尺度测试的HRNet baseline方法优于使用多尺度测试的Hourglass [30],而HRNet在FLOP方面的参数和计算量要少得多。配备轻量级反卷积模块,我们提出的HigherHRNet(66.4 AP)在参数(+0.4%)和FLOPs(+23.1%)略有增加的情况下,以+2.3 AP胜过HRNet。HigherHRNet可与PersonLab [33]媲美,但参数仅为50%,FLOP为11%。如果我们进一步使用多尺度测试,我们的HigherHRNet将达到70.5的AP,大大优于所有现有的自下而上的方法。在[3,30]中,我们不使用任何自上而下的方法来进行后期处理,例如进行优化。

表1.与COCO2017 test-dev集上的自下而上方法的比较。所有GFLOP均以单尺度计算。对于PersonLab [33],我们仅计算其主干的#Params和GFLOP。顶部:w/o尺度测试。底部:w /多尺度测试。值得注意的是,我们的结果是在没有refinement的情况下实现的。

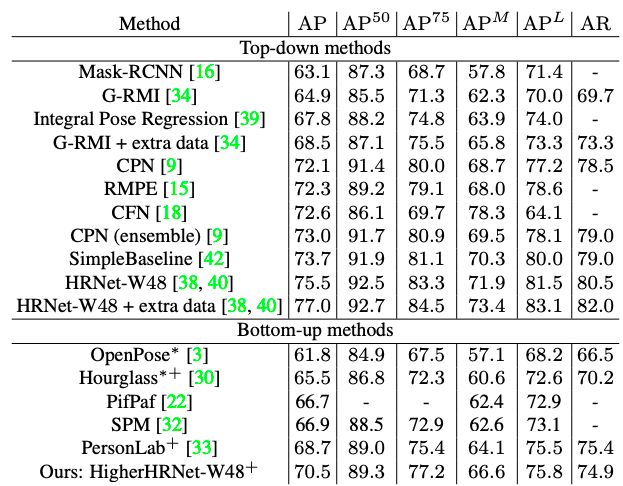

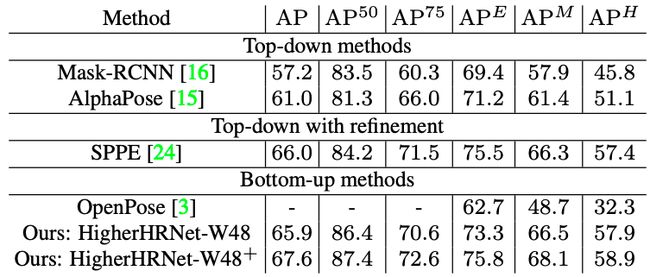

表2列出了COCO2017 test-dev数据集的自下而上和自上而下的方法。HigherHRNet进一步缩小了自下而上和自上而下方法之间的性能差距。

表2.在COCO2017 test-dev数据集上与自顶向下和自底向上方法的比较。* 表示使用refinement。+表示使用多尺度测试。

4.2.消融实验

我们执行了许多消融实验,以分析COCO2017 [27] val数据集上尺度感知的高分辨率网络(HigherHRNet)。

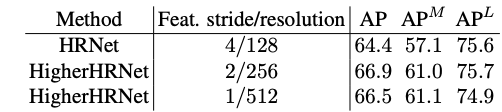

HRNet vs. HigherHRNet

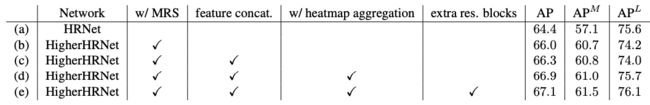

我们比较HRNet和HigherHRNet进行消融研究。对于HigherHRNet,使用没有额外残差块的反卷积模块,并且使用热图聚合进行inference。结果显示在表3中。通过使用特征步长为4的HRNet的简单的自下而上的基线可以达到AP = 64.4。通过添加一个反卷积模块,我们的HighHRHRNet的特征跨度为2,大大超过了HRNet +2.5 AP(实现了66.9 AP)。此外,主要改进来自中型人体,其中APM从HRNet的57.1提高到HigherHRNet的61.0。

表3.在COCO2017 val数据集上HRNet与HigherHRNet的消融研究。对HigherHRNet使用一个反卷积模块在COCO数据集上表现最佳。

这些结果表明,HigherHRNet由于具有高分辨率的热图,因此在小尺度下的性能要好得多。我们还发现大人体姿势的AP不会下降。这主要是因为我们还使用较小分辨率的热图进行预测。它表明1)以更高的分辨率进行预测对自下而上的姿势估计很有帮助,并且2)尺度感知预测很重要。

如果我们在HRNet之后添加两个反卷积模块的序列以生成与输入图像具有相同分辨率的特征图,则会观察到性能从66.9 AP降低到66.5 AP,仅添加一个反卷积模块。中型人体的改善很小(+0.1 AP),但大人体的表现却有很大的下降(-0.8 AP)。我们假设这是因为特征图尺度和目标尺度之间的不匹配。较大的分辨率特征图(特征步幅= 1)适合于检测甚至更小的人的关键点,但不考虑COCO中的小人进行姿势估计。因此,默认情况下,我们仅对COCO数据集使用一个反卷积模块。但我们想指出的是,级联反卷积模块的数量应取决于数据集,我们将在以后的工作中在更多数据集上对此进行验证。

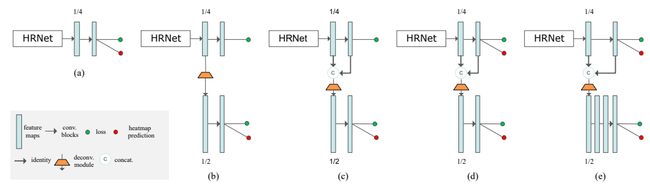

图3.(a)使用HRNet [38,40]作为backbone的baseline方法。(b)具有多分辨率监督(MRS)的HigherHRNet。(c)具有MRS和特征串联的HigherHRNet。(d)具有MRS和特征串联的HigherHRNet。(e)具有MRS,特征串联和额外残差块的HigherHRNet。对于(d)和(e),使用热图聚合。

图3.(a)使用HRNet [38,40]作为backbone的baseline方法。(b)具有多分辨率监督(MRS)的HigherHRNet。(c)具有MRS和特征串联的HigherHRNet。(d)具有MRS和特征串联的HigherHRNet。(e)具有MRS,特征串联和额外残差块的HigherHRNet。对于(d)和(e),使用热图聚合。

表4.在COCO2017 val数据集上HigherHRNet组件的消融研究。MSR:多分辨率监督。feature concat .:特征串联。res. bolck:残差块。

HigherHRNet 增益故障:为了更好地理解所提出组件的增益,我们对每个单独的组件进行了详细的消融研究。图3展示了我们实验的所有架构。结果示于表4。

反卷积模块的效果: 我们对添加反卷积模块以生成更高分辨率的热图的效果进行消融研究。为了公平地比较,我们仅使用最高分辨率的特征图来生成用于预测的热图(图3(b))。HRNet(图3(a))达到了64.4 AP的baseline。通过添加一个反卷积模块,该模型可实现66.0 AP,这比baseline好1.6 AP。这种改进完全归因于对具有更高质量的较大特征图的预测。该结果验证了我们的主张,即对于自下而上的姿势估计,预测更高分辨率的特征图非常重要。

特征串联的效果: 我们将特征图与来自HRNet的预测热图连接起来,作为反卷积模块的输入(图3(c)),性能进一步提高到66.3 AP。我们还观察到,中型人体的收益很大,而大型人体的表现却有所下降。比较方法(a)和(c),以较高的分辨率预测热图的收益主要来自中等人体(+3.7APM)。此外,大人体的AP下降(-1.6 AP)证明了我们的主张,即特征图的不同分辨率对不同尺度的人敏感。

热图聚合的效果: 我们根据热图聚合策略进一步使用热图的所有分辨率进行inference(图3(d))。与仅使用最高分辨率的热图进行inference的图3(c)(66.3 AP)相比,应用热图聚合策略可实现66.9 AP。比较方法(d)和(e),热图聚合的收益来自大人体(+1.7 AP)。大人体的表现甚至比较低分辨率下的预测要好一些(方法(a))。这意味着使用热图聚合策略预测热图是真正尺度感知的。

额外残差块的影响: 我们在反卷积模块中添加了4个残差块,我们的最佳模型实现了67.1 AP。添加残差块可以进一步细化特征图,并且同样增加中型和大型人员的AP。

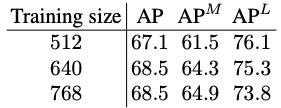

表5.在COCO2017 val数据集上具有不同训练图像大小的HigherHRNet的消融研究。

用更大图片尺寸训练:一个自然的问题是,使用更大的输入size进行训练是否可以进一步提高性能? 为了回答这个问题,我们用640×640和768×768训练HigherHRNet,结果如表5所示,所有三种模型都使用训练图像尺寸进行了测试。我们发现,通过将训练图像大小增加到640,可以显着提高AP的1.4增益。大部分收益来自中型人体,而大型人体的表现则略有下降。当我们进一步将训练图像大小更改为768时,整个AP不再变化。我们观察到中等人体的略微改善以及大人体的大幅度衰减。

表6.在COCO2017 val数据集上具有不同backbone的HigherHRNet的消融研究。

更大的backbone:在先前的实验中,我们使用HRNet-W32(1/4分辨率特征图具有32个通道)作为backbone。我们使用较大backbone 的HRNet W40和HRNet-W48进行实验。结果显示在表6中。我们发现使用较大的backbone可以持续提高中型和大型人体的性能。

4.3. CrowdPose

CrowdPose [24]数据集由20,000张图像组成,包含约80,000个人。训练,验证和测试子集按5:1:4的比例分配。与COCO关键点数据集相比,CrowdPose的场景更为拥挤,给姿势估计方法带来了更多挑战。评估指标与COCO [27]相同。

另一方面,自下而上的方法自然在拥挤的场景中具有优势。为了验证HigherHRNet在拥挤场景中的稳健性,以及为自下而上的方法设置一个强大的基准。我们在CrowdPose训练和val集合上训练了最好的HigherHRNet-W48模型,并在测试集中报告了性能。所有训练参数均严格遵循COCO,我们使用640×640的crop size进行训练和测试。

结果显示在表7中。我们的HigherHRNet优于单纯的自上而下的方法,大大提高了6.6 AP。HIGHERHRNET还以1.6 AP优于以前的最佳方法[24](对自上而下的方法[15]进行了global refinement),大部分收益来自APM(+1.8 AP)和APH(+1.5 AP) ,其中包含人群最多的图像。即使没有多尺度测试,HigherHRNet在APH中也比SPPE [24]高出0.5

表7.与CrowdPose测试数据集上的自上而下和自下而上方法的比较。AP的上标E,M,H表示容易,中等和困难。+表示使用多尺度测试。

5.结论

我们提出了一个尺度感知的高分辨率网络(HigherHRNet)去解决在自底向上多人姿态估计中的尺度变化挑战的问题,特别是准确定位小尺度人的关键点。我们发现多尺度图像金字塔和更大的输入尺寸有解决这个问题的潜力,但是这些方法会导致高计算量损耗。为了解决这个问题,我们提出了一个有效的基于HRNet并且在多分辨率监督训练的高分辨率特征金字塔。进过推理,HigherHRNet结合多分辨率热图融合,是有能力生成多分辨率,和高分辨率的热图用于更准确的人体姿态估计。HigherHRNet在COCO挑战数据集上超过现存的全部自底向上的方法一大截,特别是在小尺度人上。

终于翻译完了。总结一下,多尺度训练,inference时进行heatmap aggregation可以一定程度上解决bottom-up方法,关于人尺度多样性难训练的老大难问题。Top-Down方法之所以精度高,就是因为将不同尺度的person rescale到同一个尺度下。output feature map需要再大一点,但不是越大越好,这个一般来说是和数据集有关系的,更大一些的feature map对提高检测small person的效果更明显。

最近在利用这篇论文中提到的方法进行实验,HigherHRNet是bottom-up的方法,使用之前论文提出的associate embedding对每个heatmap point赋上一个tag,用来做后面的后处理工作。论文只着重强调在前半部分关键点的提取上,后处理部分没有详细介绍,下次再更新一下与associate embedding相关的论文,然后看看能不能有一下改进,随后也会更新一些实验的具体进展。有做相关领域的朋友可以找我交流。

最近因为疫情原因,我们没有办法返校,但是我们依然有着非常艰巨的科研任务和比赛项目。宅家抗疫期间也尝试了很多种跑实验的方法,用CPU跑,用colab跑,真是一顿操作猛如虎,一看战绩0.5。没有办法,最后在师兄的帮助下,我发现可以远程租用服务器,既省去了我环境配置的难题,有没有GPU运行时的噪音,有需求的朋友可以参考一下他们的官网: http://www.ai-galaxy.cn/,淘宝店:https://shop36573300.taobao.com/,公众号: 智星AI

今天我们中国人有一次登上了珠峰,在现在全球抗疫的背景下,证明了我们抗疫取得了令人瞩目的成功,在这里恭喜登上队,同时也期待更多的好消息。PEACE&LOVE

参考资料:

https://arxiv.org/pdf/1908.07919.pdf

https://github.com/HRNet/HigherHRNet-Human-Pose-Estimation

https://blog.csdn.net/Murdock_C/article/details/104851289

https://blog.csdn.net/weixin_40671425/article/details/105600137

http://www.ai-galaxy.cn/index.php

https://shop36573300.taobao.com/