Flume的安装及简单的使用(一)

1.Flume简介

Flume是Cloudera提供的一个高可用、高可靠、分布式的海量日志采集、聚合和传输的系统。Flume支持在日志系统中定制各类数据发送方用于收集数据,同时Flume提供对数据的简单处理,并将数据处理结果写入各种数据接收方的能力。

Flume作为Cloudera开发的实时日志收集系统,受到了业界的认可与广泛应用。2010年11月Cloudera开源了Flume的第一个可用版本0.9.2,这个系列版本被统称为Flume-OG。随着Flume功能的扩展,Flume-OG代码工程臃肿、核心组件设计不合理、核心配置不标准等缺点暴露出来,尤其是在Flume-OG的最后一个发行版本 0.94.0中,日志传输不稳定的现象尤为严重。为了解决这些问题,2011年10月Cloudera重构了核心组件、核心配置和代码架构,重构后的版本统称为Flume-NG。改动的另一原因是将 Flume 纳入 Apache 旗下,Cloudera Flume改名为Apache Flume。

2.Flume工作原理

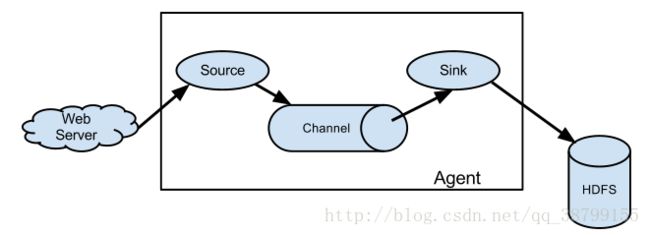

Flume的数据流由事件(Event)贯穿始终。事件是Flume的基本数据单位,它携带日志数据(字节数组形式)并且携带有头信息,这些Event由Agent外部的Source生成,当Source捕获事件后会进行特定的格式化,然后Source会把事件推入(单个或多个)Channel中。可以把Channel看作是一个缓冲区,它将保存事件直到Sink处理完该事件。Sink负责持久化日志或者把事件推向另一个Source。以下是Flume的一些核心概念:

(1)Events:一个数据单元,带有一个可选的消息头,可以是日志记录、avro 对象等。

(2)Agent:JVM中一个独立的Flume进程,包含组件Source、Channel、Sink。

(3)Client:运行于一个独立线程,用于生产数据并将其发送给Agent。

(4)Source:用来消费传递到该组件的Event,从Client收集数据,传递给Channel。

(5)Channel:中转Event的一个临时存储,保存Source组件传递过来的Event,其实就是连接 Source 和 Sink ,有点像一个消息队列。

(6)Sink:从Channel收集数据,运行在一个独立线程。

Flume以Agent为最小的独立运行单位,一个Agent就是一个JVM。单Agent由Source、Sink和Channel三大组件构成,如下图所示:

值得注意的是,Flume提供了大量内置的Source、Channel和Sink类型。不同类型的Source、Channel和Sink可以自由组合。组合方式基于用户设置的配置文件,非常灵活。比如:Channel可以把事件暂存在内存里,也可以持久化到本地硬盘上;Sink可以把日志写入HDFS、HBase、ES甚至是另外一个Source等等。Flume支持用户建立多级流,也就是说多个Agent可以协同工作,如下图所示:

![]()

更多的了解,请查看官网:http://flume.apache.org/FlumeUserGuide.html

3.系统环境

| 主机名称 | 操作系统 | Java版本 | Fiume版本 |

|---|---|---|---|

| hadoop | centos7 | Java1.8+ | 1.7.0 |

**系统需求:**Flume需要Java 1.6及以上(推荐1.8),对Agent监控目录的读写权限。

4.下载及安装

1.Flume

到Flume官网上http://flume.apache.org/download.html下载软件安装包,如图:

可以在Windows下下载完成,通过xftp上传至hadoop根目录下,也可以在图片上箭头指向的版本,点击“右键”,复制链接地址,在hadoop下通过wget安装

下载、解压

$ wget http://www.apache.org/dyn/closer.lua/flume/1.7.0/apache-flume-1.7.0-bin.tar.gz

$ tar -xzf apache-flume-1.7.0-bin.tar.gz

$ mv apache-flume-1.7.0-bin flume2.jdk1.8的安装

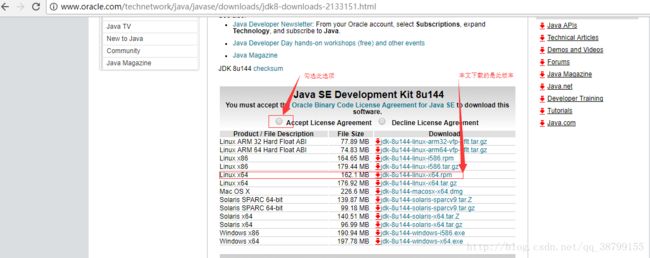

1.到jdk官网http://www.oracle.com/technetwork/java/javase/downloads/index.html 下载软件安装包,如图:

在Windows下下载完成,通过xftp上传至hadoop根目录下

首先先卸载虚拟机自带的openjdk,通过如下命令

$ sudo yum -y remove java*2.安装jdk

$ sudo yum -y install jdk-8u144-linux-x64.rpm3.配置java环境变量(局部)

$ vi .bashrc添加如下内容

# Java Environment Variables

export JAVA_HOME=/usr/java/jdk1.8.0_144

export PATH=$PATH:$JAVA_HOME/bin

通过如下命令使其生效

$ source .bashrc测试:$ echo $JAVA_HOME 会显示如下:

/usr/java/jdk1.8.0_144至此Java环境变量配置成功

5.修改Flume配置文件

进入到flume的conf下,创建一个flume.conf 文件

$ cd /home/hadoop/flume/conf/

$ vi flume.conf输入以下内容

# 指定Agent的组件名称

a1.sources = r1

a1.sinks = k1

a1.channels = c1

# 指定Flume source(要监听的路径)

a1.sources.r1.type = spooldir

a1.sources.r1.spoolDir = /home/hadoop/log

# 指定Flume sink

a1.sinks.k1.type = logger

# 指定Flume channel

a1.channels.c1.type = memory

a1.channels.c1.capacity = 1000

a1.channels.c1.transactionCapacity = 100

# 绑定source和sink到channel上

a1.sources.r1.channels = c1

a1.sinks.k1.channel = c1

6.启动flume agent

$ cd flume

$ bin/flume-ng agent --conf conf --conf-file conf/flume.conf --name a1 -Dflume.root.logger=INFO,console| 参数 | 作用 | 举例 |

|---|---|---|

| –conf 或 -c | 指定配置文件夹,包含flume-env.sh和log4j的配置文件 | –conf conf |

| –conf-file 或 -f | 配置文件地址 | –conf-file conf/flume.conf |

| –name 或 -n | agent名称 | –name a1 |

| -z | zookeeper连接字符串 | -z zkhost:2181,zkhost1:2181 |

| -p | zookeeper中的存储路径前缀 | -p /flume |

7.简单的操作

写入日志内容

在/home/hadoop/log 下创建一个flume.log 日志文件,写入hello flume 作为测试内容

$ cd /home/hadoop/log

$ vi flume.log接着就可以在前一个终端看到刚刚采集的内容了,如下:

2017-09-18 22:18:28,937 (SinkRunner-PollingRunner-DefaultSinkProcessor) [INFO - org.apache.flume.sink.LoggerSink.process(LoggerSink.java:95)] Event: { headers:{} body: 68 65 6C 6C 6F 20 66 6C 75 6D 65 20 21 21 hello flume !! }

如图:

![]()

至此flume已经能够正常运行。

————————-华丽的分割线——————————–

笔者推荐博客:http://blog.csdn.net/qq_38799155/article/details/78025621