LVS负载均衡环境搭建

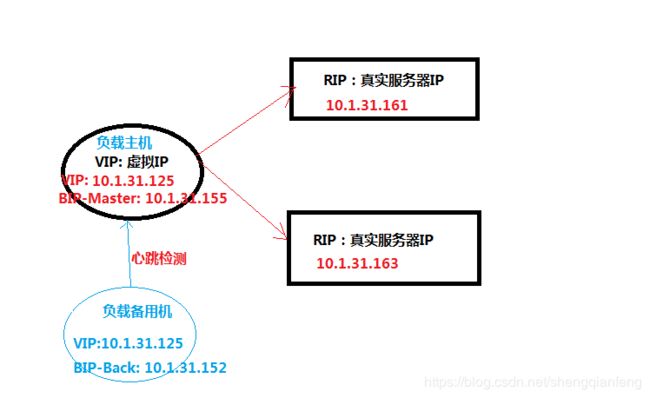

LVS+Keepalived构建拓扑图

![]()

准备工作

因为搭建了两套环境,所以括号中的是我另一个的环境,紫色标识

RIP: 10.1.31.161+10.1.31.163 (home:192.168.1.103+192.168.1.104)

表示realip对应的真实服务器,即http服务器是apache公司的服务器,linux系统自带可以直接使用,方便快捷。

VIP: 10.1.31.125(192.168.1.125)

表示visualIP虚拟IP,即负载均衡主机虚拟出来的ip地址。用户访问服务必须经过VIP经由负载调度器到RIP某一节点。

DIRECT_SERVER(负载均衡主机和备机):

BIP-Master: 10.1.31.155 (192.168.1.105) ------负载均衡主机真实IP

BIP-Back: 10.1.31.152 (192.168.1.102) --------负载均衡备机真实IP

如图:

搭建RIP指向的两台Http应用服务器

即realServer服务器

① 最先开始从http服务器开始搭建:

# /sbin/iptables -IINPUT -p tcp --dport 80 -j ACCEPT //开启80端口

# systemctl list-units --type=service

# yum -y install httpdhttpd-devel

//开启Http服务器

# /bin/systemctl start httpd.service -------或 # service httpd start

http服务器搭建完成,测试两台http服务器(两个准备的RIP服务器)

在本地环境测试http服务器访问情况:http:// 10.1.31.161/ (http://192.168.1.103)

同样的方式测试另一台http服务器:http:// 10.1.31.163/ (http://192.168.1.104)

②编写静态页

注意:最好http服务器访问应该不一样,这样请求转发时我们能区分。

# cd /var/wwww/html //进入Http服务器默认的目录

# vi index.html //编辑Http服务器默认访问页面

---http服务器两台都搭建完毕--end---

③ 为每台Real Server创建lvsrs文件

RealServer给自己的lo网卡(127.0.0.1,即localhost)配置虚拟IP-----SNS_VIP地址作为回环,同时配置子网掩码为255.255.255.255,以及广播地址为SNS_VIP。

SNS_VIP=192.168.1.125

./etc/rc.d/init.d/functions

case "$1" in

start)

ifconfig lo:0 $SNS_VIP netmask 255.255.255.255 broadcast $SNS_VIP

/sbin/route add -host$SNS_VIP dev lo:0

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2">/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1">/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2">/proc/sys/net/ipv4/conf/all/arp_announce

sysctl -p >/dev/null2>&1

echo "RealServerStart OK"

;;

stop)

ifconfig lo:0 down

route del $SNS_VIP>/dev/null 2>&1

echo "0">/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "0">/proc/sys/net/ipv4/conf/lo/arp_announce

echo "0">/proc/sys/net/ipv4/conf/all/arp_ignore

echo "0">/proc/sys/net/ipv4/conf/all/arp_announce

echo "RealServerStoped"

;;

*)

echo "Usage: $0{start|stop}"

exit 1

esac

exit 0

以上参数说明

SNS_VIP=192.168.1.125 #定义VIP变量

./etc/rc.d/init.d/functions #导脚本库

case "$1" in #case语句 $1传递给该shell脚本的第一个参数

start)

ifconfig lo:0 $SNS_VIPnetmask 255.255.255.255 broadcast $SNS_VIP #设置Lo:0 VIP netmask 及广播

/sbin/route add -host$SNS_VIP dev lo:0 ##route add 增加本地路由

echo "1">/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2">/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1">/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2">/proc/sys/net/ipv4/conf/all/arp_announce

sysctl -p >/dev/null2>&1 # -p

(default /etc/sysctl.conf)将标准信息输入设备空文件 echo "RealServerStart OK"

;;

stop)

ifconfig lo:0 down

route del $SNS_VIP>/dev/null 2>&1 #route del 删除本地路由

echo "0">/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "0">/proc/sys/net/ipv4/conf/lo/arp_announce

echo "0">/proc/sys/net/ipv4/conf/all/arp_ignore

echo "0">/proc/sys/net/ipv4/conf/all/arp_announce

echo "RealServerStoped"

;;

*)

echo "Usage: $0{start|stop}" #$0 是脚本本身的名字

exit 1 #表示进程正常退出

esac #case结束

exit 0 #表示进程非正常退出

启动:

/etc/init.d/lvsrs start

报错:

![]()

解决办法:

# cd /etc/init.d

# ./lvsrs start

lVS成功!

④ Director Server的配置

在Director Server上配置LVS负载均衡集群,有两种方法:

Ø 通过ipvsadm命令行进行配置LVS

Ø 通过Redhat提供的工具piranha来配置LVS

4.1 通过ipvsadm命令行方式配置LVS

系统安装完毕,可以通过如下命令检查kernel是否已经支持LVS的ipvs模块:

[root@localhost ~]#modprobe -l |grep ipvs

/lib/modules/2.6.18-194.11.1.el5/kernel/net/ipv4/ipvs/ip_vs.ko

/lib/modules/2.6.18-194.11.1.el5/kernel/net/ipv4/ipvs/ip_vs_dh.ko

如果有类似上面的输出,表明系统内核已经默认支持了IPVS模块。接着就可以安装IPVS管理软件了。

- 安装IPVS管理软件:

rpm -ivh ipvsadm-1.24-10.i386.rpm

Error: libc.so.6 被ipvsadm-1.24-10.i386 需要

解决:

yum install glibc.i686

yum install libpopt*

yum install libpopt.so.0

#rpm –ivh

nss-softokn-freebl-3.16.2.3-14.2.el7_2.i686.rpmnss-softokn-freebl-3.16.2.3-14.2.el7_2.x86_64.rpmglibc-2.17-106.el7_2.8.i686.rpm

#rpm -ivh popt-1.13-16.el7.i686.rpm ipvsadm-1.24-10.i386.rpm

- 配置LVS集群

安装IPVS后,就可以配置LVS集群了,首先在Director Server上给网卡ens33绑定一个虚拟IP(也叫VIP),此IP用于对外提供服务,执行如下命令

# ifconfig ens33:0 10.1.31.125 broadcast 10.1.31.125 netmask 255.255.255.255 up

(ifconfig ens33:0 192.168.1.125 broadcast 192.168.1.125 netmask 255.255.255.255 up)

常见错误:

[root@192 init.d]# ifconfig ens33:0 192.168.1.125 broadcast 192.168.1.125netmask 255.255.255.255 up

SIOCSIFFLAGS: 无法指定被请求的地址

解决:关闭keepalived服务再执行。

在ens33网卡设备上绑定了一个虚拟设备ens33:0,同时设置了一个虚拟IP是10.1.31.125,也就是上面我们规划的虚拟IP地址,然后指定广播地址也为10.1.31.125,需要特别注意的是,这里的子网掩码为255.255.255.255。

然后给设备ens33:0指定一条路由,执行如下指令

#route add -host 10.1.31.125 dev ens33:0

(#route add -host 192.168.1.125 dev ens33:0 )

#echo "1" >/proc/sys/net/ipv4/ip_forward

指令中,参数值为1时启用ip转发,为0时禁止ip转发。

其实在DR模式中,开启系统的包转发功能不是必须的,而在NAT模式下此操作是必须的。

--->然后配置ipvs:

清除内核虚拟服务器列表中的所有记录

ipvsadm -C

添加一条新的虚拟IP记录,这个新的IP是10.1.31.125,同时指定持续服务时间为600秒

ipvsadm -A -t 10.1.31.125:80 -srr -p 600

(ipvsadm –A –t 192.168.1.125:80 –s rr –p 600)

在新加虚拟IP记录中添加两条新的Real Server记录,并且指定LVS 的工作模式为直接路由模式。

ipvsadm -a -t 10.1.31.125:80 -r 10.1.31.161:8081 -g

ipvsadm -a -t 10.1.31.125:80 -r 10.1.31.163:8082 –g

ipvsadm –a –t 192.168.1.125:80 –r192.168.1.103:80 –g

ipvsadm –a –t 192.168.1.125:80 –r192.168.1.104:80 -g

启动ipvsadm服务:

#ipvsadm

如此LVS在Director Server上的配置就完成了.

记得开启keepalived服务:

# service keepalived start

浏览器访问VIP地址:http://192.168.1.125/,成功则看到如下界面:

失败则看下80端口是否限制,可用以下语句开启!

/sbin/iptables -I INPUT -p tcp --dport80 -j ACCEPT

以上操作可以写成一个脚本如下:

#!/bin/sh

# description: StartLVS of Director server

VIP=10.1.31.125 #定义VIP变量

RIP1=10.1.31.161 #定义RIP变量

RIP2=10..1.31.163#定义RIP变量

. /etc/rc.d/init.d/functions #导脚本库

case "$1"in #case语句$1传递给该shell脚本的第一个参数

start)

echo " start LVS of DirectorServer"

# 设置eth0:0VIP 和广播

/sbin/ifconfig eth0:0 $VIP broadcast $VIP netmask 255.255.255.255 up

echo"1" >/proc/sys/net/ipv4/ip_forward

#Clear IPVS table

/sbin/ipvsadm -C

#set LVS

/sbin/ipvsadm -A -t$VIP:80 -s rr -p 600

/sbin/ipvsadm -a -t$VIP:80 -r $RIP1:80 -g

/sbin/ipvsadm -a -t$VIP:80 -r $RIP2:80 -g

#Run LVS

/sbin/ipvsadm

;;

stop)

echo "close LVSDirectorserver"

echo "0">/proc/sys/net/ipv4/ip_forward

/sbin/ipvsadm -C

/sbin/ifconfig eth0:0 down

;;

*)

echo "Usage: $0 {start|stop}"

exit 1

Esac

3 通过Redhat提供的工具piranha来配置LVS

Piranha是REDHAT提供的一个基于Web的LVS配置软件,可以省去手工配置LVS的繁琐工作,同时,也可单独提供cluster功能,例如,可以通过Piranha激活Director Server的后备主机,也就是配置DirectorServer的双机热备功能。

Piranha工具的安装非常简单,下载Piranha的rpm包,进行安装即可:

rpm –ivh piranha-0.8.2-1.i386.rpm

Piranha安装完毕后,会产生/etc/sysconfig/ha/lvs.cf文件,默认此文件是空的,可以通过Piranha提供的web界面配置此文件,也可以直接手动编辑此文件,编辑好的lvs.cf文件内容类似如下:

root@localhost ~]# more/etc/sysconfig/ha/lvs.cf

serial_no = 18 #序号。

primary = 192.168.1.105 #指定主DirectorServer的真实IP地址,是相对与有备用的Director Server而言的,也就是给DirectorServer做HA Cluster。

service = lvs #指定双机的服务名。

backup_active = 0 #是否激活备用DirectorServer。“0”表示不激活,“1”表示激活。

backup = 0.0.0.0 #这里指定备用Director Server的真实IP地址,如果没有备用Director Server,可以用“0.0.0.0”代替。

heartbeat = 0 #是否开启心跳,1表示开启,0表示不开启。

heartbeat_port = 539 #指定心跳的UDP通信端口。

keepalive = 5 #心跳间隔时间,单位是秒。

deadtime = 10 #如果主Director Server在deadtime(秒)后没有响应,那么备份Director

Server就会接管主DirectorServer的服务。

network = direct #指定LVS的工作模式,direct表示DR模式,nat表示NAT模式,tunnel表示TUNL模式。

debug_level = NONE #定义debug调试信息级别。

virtual www.ixdba.net{ #指定虚拟服务的名称。

active = 1 #是否激活此服务。

address =192.168.1.125 eth0:0 #虚拟服务绑定的虚拟IP以及网络设备名。

port = 80 #虚拟服务的端口。

send = "GET /HTTP/1.0\r\n\r\n" #给real server发送的验证字符串。

expect = "HTTP" #服务器正常运行时应该返回的文本应答信息,用来判断real server是否工作正常。

use_regex = 0 # expect选项中是否使用正则表达式,0表示不使用,1表示使用。

load_monitor = none #LVS中的Director Server能够使用 rup 或ruptime 来监视各个real server的负载状态。该选项有3个可选值,rup、ruptime和none,如果选择rup,每个real server就必须运行rstatd服务。如果选择了ruptime,每个real server就必须运行 rwhod 服务。

scheduler = rr #指定LVS的调度算法。

protocol = tcp #虚拟服务使用的协议类型。

timeout = 6 #real server失效后从lvs路由列表中移除失效real server所必须经过的时间,以秒为单位。

reentry = 15 #某个real server被移除后,重新加入lvs路由列表中所必须经过的时间,以秒为单位。

quiesce_server = 0 #如果此选项为1.那么当某个新的节点加入集群时,最少连接数会被重设

为零,因此LVS会发送大量请求到此服务节点,造成新的节点服务阻塞,

建议设置为0。

server RS1 { #指定real server服务名。

address = 192.168.1.103 #指定realserver的IP地址。

active = 1 #是否激活此real server服务。

weight = 1 #指定此real server的权值,是个整数值,权值是相对于所有real server节点而言的,权值高的realserver处理负载的性能相对较强。

}

server RS2 {

address = 192.168.1.104

active = 1

weight = 1

}

}

编辑完成,然后启动pulse服务,即启动lvs服务

[root@localhost ~]#service pulse start

同理,此种方式下也要启用系统的包转发功能:

[root@localhost ~]#echo "1">/proc/sys/net/ipv4/ip_forward

到此为止,Piranha工具方式配置Director Server完毕。

⑤ Real server 的配置

在lvs的DR和TUN模式下,用户的访问请求到达真实服务器后,是---->直接返回给用户的,而不再经过前端的Director Server.

因此,就需要在每个Realserver节点上增加虚拟的VIP地址,这样数据才能直接返回给用户,增加VIP地址的操作可以通过创建脚本的方式来实现,创建文件/etc/init.d/lvsrs,脚本内容如下:

#description: start Real Server

VIP=192.168.1.125

/etc/rc.d/init.d/functions

case"$1" in

start)

echo " Start LVS of Real Server"

/sbin/ifconfig lo:0 $VIP broadcast $VIP netmask 255.255.255.255 up

/sbin/route add -host $VIP dev lo:0

echo "1">/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2">/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1">/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2">/proc/sys/net/ipv4/conf/all/arp_announce

;;

stop)

/sbin/ifconfig lo:0 down

echo "close LVS Director server"

echo"0">/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "0">/proc/sys/net/ipv4/conf/lo/arp_announce

echo "0">/proc/sys/net/ipv4/conf/all/arp_ignore

echo "0">/proc/sys/net/ipv4/conf/all/arp_announce

;;

*)

echo "Usage: $0 {start|stop}"

exit 1

esac

此操作是在回环设备网卡lo上绑定了一个虚拟IP地址,并设定其子网掩码为255.255.255.255,与Director Server上的虚拟IP保持互通,然后禁止了本机的ARP请求。

由于虚拟ip,也就是上面的VIP地址,是Director Server和所有的Real server共享的,如果有ARP请求VIP地址时,Director Server与所有Real server都做应答的话,就出现问题了,因此,需要禁止Real server响应ARP请求,而lvsrs脚本的作用就是使RealServer不响应arp请求。

RealServer的状态监控

- ldirectord监控realserver状态

在heartbeat中,ldirectord其实是作为它的一个插件出现的,所以它默认包含在heartbeat软件包中,Ldirectord的核心作用是监控Real Server节点状态,当Real Server失效时,把它从虚拟服务器列表中删除,恢复时重新添加到列表,同时,它还能调用ipvsadm自动创建LVS路由表,这点从下面要讲述的ldirectord.cf中可以看出,这里需要说明的是,ldirectord和Piranha都具有监控Real Server的功能。

------ldirectord: “如果要通过ldirectord监控节点状态,只需启动ldirectord服务,整个集群系统就可以运行起来,而无需执行上面我们配置的LVS脚本,因为ldirectord会自动调用ipvsadm创建LVS路由表,而我们上面讲述的利用ipvsadm命令行方式配置LVS,是为了让读者能更深入的了解ipvsadm的实现细节和实现机制。“

- Piranha监控realserver状态

------Piranha:"如果是通过Piranha工具配置LVS,就无需使用ldirectord,Piranha工具对应的系统进程是pluse,此进程也会自动调用ipvsadm创建LVS路由表,同时会利用自身的nanny守护进程监控real server的状态!"

-

安装ldirectord

ldirectord的安装非常简单,直接通过yum就可以安装完成:

[root@localhost root]#yum install heartbeat-ldirectord

安装完成后,默认的安装路径为/etc/ha.d,同时需要将模板配置文件拷贝到这个目录下,执行如下命令:

[root@localhost root]# rpm -qheartbeat-ldirectord -d

/usr/share/doc/heartbeat-ldirectord-2.1.3/ldirectord.cf

/usr/share/man/man8/ldirectord.8.gz

[root@localhost root]# cp/usr/share/doc/heartbeat-ldirectord-2.1.3/ldirectord.cf /etc/ha.d

-

启动或关闭ldirectord服务

/etc/init.d/ldirectord {start|stop}

-

ldirectord配置文件

Ldirectord的配置文件是/etc/ha.d/ldirectord.cf,下面详述下这个文件每个参数的含义:

下面是需要配置的选项,注意,“#”号后面的内容为注释:

# Global Directives

checktimeout=20 #判定real server出错的时间间隔。

checkinterval=10 #指定ldirectord在两次检查之间的间隔时间。

fallback=127.0.0.1:80 #当所有的realserver节点不能工作时,web服务重定向的地址。

autoreload=yes #是否自动重载配置文件,选yes时,配置文件发生变化,自动载入配置信息。

logfile="/var/log/ldirectord.log" #设定ldirectord日志输出文件路径。

quiescent=no #当选择no时,如果一个节点在checktimeout设置的时间周期内没有响应,ldirectord将会从LVS的路由表中直接移除real server,此时,将中断现有的客户端连接,并使LVS丢掉所有的连接跟踪记录和持续连接模板,如果选择为yes,当某个real server失效时,ldirectord将失效节点的权值设置为0,新的连接将不能到达,但是并不从LVS路由表中清除此节点,同时,连接跟踪记录和程序连接模板仍然保留在Director上。

注意:以上几行为ldirectord.cf文件的“全局”设置,它们可以应用到下面多个虚拟主机,下面是每个虚拟主机的配置。

下面是需要配置的选项,注意,“#”号后面的内容为注释:

# Sample for an http virtual service

virtual=10.1.31.125:80 #指定虚拟的IP地址和端口号,注意,在virtual行后面的行必

须缩进4个空格或以一个tab字符进行标记。

real=10.1.31.161:80 gate #指定RealServer服务器地址和端口,同时设定LVS工作模式,

用gate表示DR模式,ipip表示TUNL模式,masq表示NAT模式。

real=10.1.31.163:80 gate

fallback=127.0.0.1:80 gate

service=http #指定服务的类型,这里是对http服务做负载均衡。

request="index.html" #ldirectord将根据指定的Real Server地址,结合该选项给出

的请求路径,发送访问请求,检查Real Server上的服务是否正常运行,确保这里给出的页面地址是可访问的,不然ldirectord会误认为此节点已经失效,发生错误监控现象。

receive="Test Page" #指定请求和应答字串。

scheduler=rr #指定调度算法,这里是rr(轮叫)算法。

protocol=tcp #指定协议的类型,LVS支持TCP和UDP协议。

checktype=negotiate #指定Ldirectord的检测类型,默认为negotiate。

checkport=80 #指定监控的端口号。

virtualhost=www.ixdba.net #虚拟服务器的名称,随便指定。

-

启动Piranha +LVS集群服务

LVS负载均衡管理和使用有两种方式,这里以Piranha工具为主进行介绍。

首先,启动每个real server节点的服务:lvsrs:禁止arp

[root@localhost ~]# /etc/init.d/lvsrs start

start LVS of REALServer

然后,在Director Server启动pulse服务:

[root@DR1 ~]#/etc/init.d/pulse start

[root@DR1 ~]#/ ipvsadm -L

IP Virtual Server version 1.2.0 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 10.1.31.125:http rr persistent 600

-> 10.1.31.161:http Route 1 3 22

-> 10.1.31.163:http Route 1 9 10

此时查看pulse服务的系统日志信息如下:

[root@localhost ~]# tail -f/var/log/messages

Nov 22 15:52:55 lvs lvs[7031]: startingvirtual service www.ixdba.net active: 80

Nov 22 15:52:55 lvs lvs[7031]:create_monitor for www.ixdba.net/RS1 running as pid 7039

Nov 22 15:52:55 lvs nanny[7039]: startingLVS client monitor for 192.168.12.135:80

Nov 22 15:52:55 lvs lvs[7031]:create_monitor for www.ixdba.net/RS2 running as pid 7040

Nov 22 15:52:55 lvs nanny[7039]: making192.168.12.246:80 available

Nov 22 15:52:55 lvs nanny[7040]: startingLVS client monitor for 192.168.12.135:80

Nov 22 15:52:55 lvs nanny[7040]: making192.168.12.237:80 available

从日志可以看出,pulse服务启动了一个www.ixdba.net的虚拟服务,同时加载了RS1和RS2两个节点,然后检测到RS1和RS2两个节点对应的80端口可用,最后启动了虚拟IP的80端口,对外提供服务。

日志中“www.ixdba.net”、“RS1”、“RS2”等标识均在Piranha的配置文件/etc/sysconfig/ha/lvs.cf中定义。

Pulse服务启动完毕,通过“ps–ef”命令可以看到有如下进程在运行:

[root@localhost ~]# ps -ef|grep nanny

/usr/sbin/nanny -c -h 10.1.31.161 -p 80-s GET / HTTP/1.0\r\n\r\n -x HTTP -a 15 -I /

/usr/sbin/nanny -c -h 10.1.31.163 -p 80-s GET / HTTP/1.0\r\n\r\n -x HTTP -a 15 -I /

其中,nanny就是Pulse服务的守护进程,用于监控LVS服务节点的运行状态,类似与ldirectord的节点监控功能

下一篇keepalived: keepalived环境搭建