Netty学习笔记(Reactor线程模型)

Netty学习笔记(Reactor线程模型)

- NIO selector 多路复用Reactor线程模型

- 模型实现部分代码讲解

- 创建mainReactor和subReactor

- 创建serverSocketChannel,注册到mainReactor线程上的selector上

- Netty线程模型

- Netty模块组件

- NioEventLoopGroup

- NioEventLoop

- Selector

- Channel

- Netty工作原理

- 个人小结

- 参考资料

NIO selector 多路复用Reactor线程模型

在文章《Scalable IO in Java》中,介绍了使用NIO与Reactor模式相结合来实现高伸缩性网络的模型。在这个模型中,mianReactor负责处理client的请求;subReactor可以有多个,每个subReactor都会在一个独立线程中执行。

模型实现部分代码讲解

创建mainReactor和subReactor

/**

* 初始化线程组

*/

private void newGroup() throws IOException {

// 创建IO线程,负责处理客户端连接以后socketChannel的IO读写

for (int i = 0; i < subReactorThreads.length; i++) {

subReactorThreads[i] = new ReactorThread() {

@Override

public void handler(SelectableChannel channel) throws IOException {

// work线程只负责处理IO处理,不处理accept事件

SocketChannel ch = (SocketChannel) channel;

ByteBuffer requestBuffer = ByteBuffer.allocate(1024);

while (ch.isOpen() && ch.read(requestBuffer) != -1) {

// 长连接情况下,需要手动判断数据有没有读取结束 (此处做一个简单的判断: 超过0字节就认为请求结束了)

if (requestBuffer.position() > 0) break;

}

if (requestBuffer.position() == 0) return; // 如果没数据了, 则不继续后面的处理

requestBuffer.flip();

byte[] content = new byte[requestBuffer.limit()];

requestBuffer.get(content);

System.out.println(new String(content));

System.out.println(Thread.currentThread().getName() + "收到数据,来自:" + ch.getRemoteAddress());

// TODO 业务操作 数据库、接口...

workPool.submit(() -> {

});

// 响应结果 200

String response = "HTTP/1.1 200 OK\r\n" +

"Content-Length: 11\r\n\r\n" +

"Hello World";

ByteBuffer buffer = ByteBuffer.wrap(response.getBytes());

while (buffer.hasRemaining()) {

ch.write(buffer);

}

}

};

}

// 创建mainReactor线程, 只负责处理serverSocketChannel

for (int i = 0; i < mainReactorThreads.length; i++) {

mainReactorThreads[i] = new ReactorThread() {

AtomicInteger incr = new AtomicInteger(0);

@Override

public void handler(SelectableChannel channel) throws Exception {

// 只做请求分发,不做具体的数据读取

ServerSocketChannel ch = (ServerSocketChannel) channel;

SocketChannel socketChannel = ch.accept();

socketChannel.configureBlocking(false);

// 收到连接建立的通知之后,分发给I/O线程继续去读取数据

int index = incr.getAndIncrement() % subReactorThreads.length;

ReactorThread workEventLoop = subReactorThreads[index];

workEventLoop.doStart();

SelectionKey selectionKey = workEventLoop.register(socketChannel);

selectionKey.interestOps(SelectionKey.OP_READ);

System.out.println(Thread.currentThread().getName() + "收到新连接 : " + socketChannel.getRemoteAddress());

}

};

}

}

ReactorThread类中封装了selector.select()等事件轮询的代码,上面的代码中创建了mainReactor线程和subReactor线程, mainReactor线程只负责处理serverSocketChannel,subReactor线程负责IO处理。当mainReactor收到连接建立的通知之后,分发给I/O线程继续去读取数据。

创建serverSocketChannel,注册到mainReactor线程上的selector上

/**

* 初始化channel,并且绑定一个eventLoop线程

*

* @throws IOException IO异常

*/

private void initAndRegister() throws Exception {

// 1、 创建ServerSocketChannel

serverSocketChannel = ServerSocketChannel.open();

serverSocketChannel.configureBlocking(false);

// 2、 将serverSocketChannel注册到selector

int index = new Random().nextInt(mainReactorThreads.length);

mainReactorThreads[index].doStart();

SelectionKey selectionKey = mainReactorThreads[index].register(serverSocketChannel);

selectionKey.interestOps(SelectionKey.OP_ACCEPT);

}

Netty线程模型

为了让NIO处理更好地利用多线程特性,Netty实现了Reactor线程模型。

Netty模块组件

NioEventLoopGroup

NioEventLoopGroup,主要管理 EventLoop 的生命周期,可以理解为一个线程池,内部维护了一组线程,每个线程(NioEventLoop)负责处理多个 Channel 上的事件,而一个 Channel 只对应于一个线程。

NioEventLoop

NioEventLoop 中维护了一个线程和任务队列,支持异步提交执行任务,线程启动时会调用 NioEventLoop 的 run 方法,执行 I/O 任务和非 I/O 任务:

I/O 任务,即 selectionKey 中 ready 的事件,如 accept、connect、read、write 等,由 processSelectedKeys 方法触发。

非 IO 任务,添加到 taskQueue 中的任务,如 register0、bind0 等任务,由 runAllTasks 方法触发。

Selector

Netty 基于 Selector 对象实现 I/O 多路复用,通过 Selector 一个线程可以监听多个连接的 Channel 事件。

当向一个 Selector 中注册 Channel 后,Selector 内部的机制就可以自动不断地查询(Select) 这些注册的 Channel 是否有已就绪的 I/O 事件(例如可读,可写,网络连接完成等),这样程序就可以很简单地使用一个线程高效地管理多个 Channel 。

Channel

Netty的Channel可以理解为对NIO中Channel的增强和拓展,增加了很多属性和方法。

Netty工作原理

Netty服务端典型代码如下

public static void main(String[] args) throws Exception {

// Configure the server.

// 创建EventLoopGroup accept线程组 NioEventLoop

EventLoopGroup bossGroup = new NioEventLoopGroup(1);

// 创建EventLoopGroup I/O线程组

EventLoopGroup workerGroup = new NioEventLoopGroup(1);

try {

// 服务端启动引导工具类

ServerBootstrap b = new ServerBootstrap();

// 配置服务端处理的reactor线程组以及服务端的其他配置

b.group(bossGroup, workerGroup).channel(NioServerSocketChannel.class).option(ChannelOption.SO_BACKLOG, 100)

.handler(new LoggingHandler(LogLevel.DEBUG)).childHandler(new ChannelInitializer<SocketChannel>() {

@Override

public void initChannel(SocketChannel ch) throws Exception {

ChannelPipeline p = ch.pipeline();

p.addLast(new EchoServerHandler());

}

});

// 通过bind启动服务

ChannelFuture f = b.bind(PORT).sync();

// 阻塞主线程,知道网络服务被关闭

f.channel().closeFuture().sync();

} finally {

// 关闭线程组

bossGroup.shutdownGracefully();

workerGroup2.shutdownGracefully();

}

}

服务端代码基本过程描述如下:

1)初始化创建 2 个 NioEventLoopGroup:其中 boosGroup 用于 accept 连接建立事件并分发请求,workerGroup 用于处理 I/O 读写事件和业务逻辑。

2)基于 ServerBootstrap(服务端启动引导类):配置 EventLoopGroup、Channel 类型,连接参数、配置入站、出站事件 handler。

3)绑定端口:开始工作。

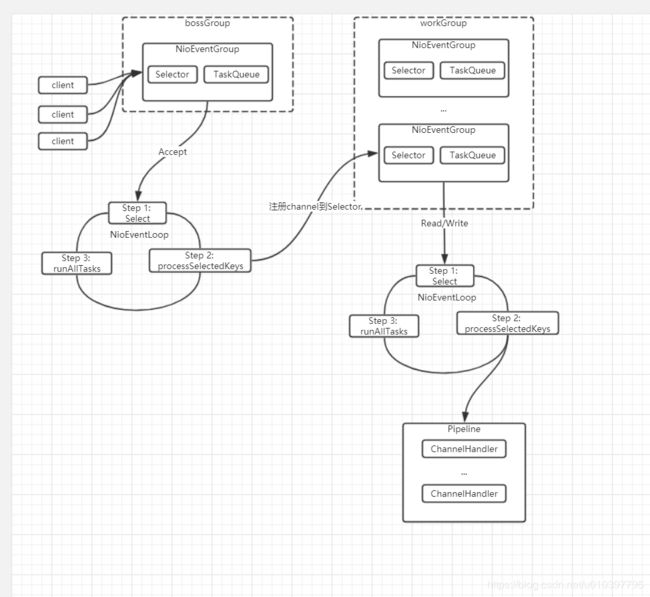

结合上面介绍的 Netty Reactor 模型,介绍服务端 Netty 的工作架构图如下:

服务端包含 1 个 Boss NioEventLoopGroup(bossGroup) 和 1 个 Worker NioEventLoopGroup(workGroup)。

NioEventLoopGroup 相当于 1 个事件循环组,这个组里包含多个事件循环 NioEventLoop,每个 NioEventLoop 包含 1 个 Selector 和 1 个事件循环线程。

每个 Boss NioEventLoop 循环执行的任务包含 3 步:

1)轮询 Accept 事件;

2)处理 Accept I/O 事件,与 Client 建立连接,生成 NioSocketChannel,并将 NioSocketChannel 注册到某个 Worker NioEventLoop 的 Selector 上;

3)处理任务队列中的任务,runAllTasks。任务队列中的任务包括用户调用 eventloop.execute 或 schedule 执行的任务,或者其他线程提交到该 eventloop 的任务。

每个 Worker NioEventLoop 循环执行的任务包含 3 步:

1)轮询 Read、Write 事件;

2)处理 I/O 事件,即 Read、Write 事件,在 NioSocketChannel 可读、可写事件发生时进行处理;

3)处理任务队列中的任务,runAllTasks。

个人小结

Netty实现了Reactor线程模型,Netty服务端包含 1 个 bossGroup 和 1 个 workGroup,其中 boosGroup 中的 NioEventLoop 负责 accept 连接建立事件并分发请求,workerGroup 中的多个 NioEventLoop 用于处理 I/O 读写事件和业务逻辑。

参考资料

[1].Scalable IO in Java http://gee.cs.oswego.edu/dl/cpjslides/nio.pdf

[2].Netty源码解读(四)Netty与Reactor模式 https://yq.aliyun.com/articles/25425?spm=a2c4e.11153940.0.0.34ee5e71hGNfnN

[3].Netty 4.x学习(三):线程模型详解 http://www.52im.net/thread-98-1-1.html