Deeply-Recursive Convolutional Network for Image Super-Resolution

Deeply-Recursive Convolutional Network for Image Super-Resolution

摘要

我们提出了使用深度递归卷积网络(DRCN)的图像超分辨率方法(SR)。 我们的网络有一个非常深的递归层(最多16个递归)。增加递归深度可以提高性能,而不会为附加卷积引入新参数。 尽管有一个优点,但由于梯度爆炸/消失问题,使用标准梯度下降法来学习DRCN是非常困难的。为了减轻模型训练的难度,我们提出两个扩展:递归监督和跳过连接。

介绍

对于图像超分辨率(SR),卷积网络的感受野决定了可以利用的上下文信息的量来推断丢失的高频分量。例如,如果训练中一类边缘信息出现在感受野中,那么重建过程中这一类边缘可以被识别且强化。由于SR是一个不定逆向问题,收集和分析更多的邻域像素可对恢复下采样后可能丢失的信息提供更多线索。

成功实现各种计算机视觉任务的深度卷积网络(DCN)通常使用非常大的感受野(ImageNet分类中常见的224x224)。在扩展感受野的许多方法中,增加网络深度是一种可能的方式。利用大于1×1的过滤器大小的卷积(转换)层或者减少中间表示的维度的池层可以使用的。 这两种方法都有缺点:层引入更多的参数和池层。网络层通常丢弃一些像素级别的信息。

对于图像恢复问题,如超分辨率和去噪,图像细节非常重要。因此,这些问题的大多数深度学习方法不能使用池化技术。通过添加新的网络层来增加深度,基本上会引入更多的参数。可能会出现两个问题。首先,很可能会过度拟合,需要更多的训练数据,使模型变得越来越大。

为了解决这些问题,我们使用深度递归卷积网络(DRCN)。DRCN根据需要重复地使用相同的卷积层参数。参数的数量不会增加,而执行了更多的递归。我们的网络的感受野为41乘41,与SRCNN相比较(13比13)。DRCN具有良好的性能,我们发现用广泛使用的随机梯度下降法优化的DRCN不容易收敛。这是由于爆炸/消失的梯度。提出了一个高性能的模型结构,能够捕捉像素长程的依赖,在保持较小模型的情况下,有更宽的感受野,41×41。

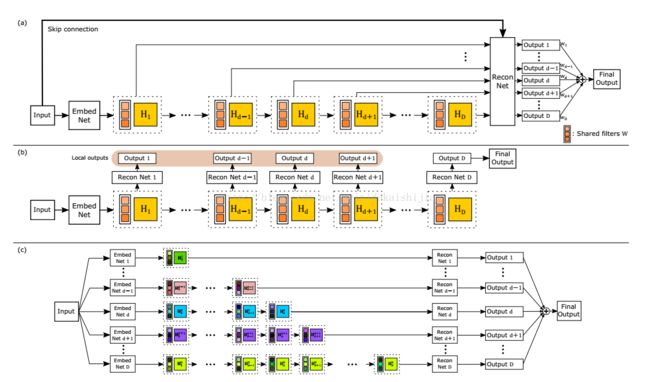

我们提出两种方法来缓解训练的难度。首先,对所有递归进行监督。每个递归之后的特征图用于重构目标高分辨率图像(HR)。重建方法(专用于重建的层)对于所有递归都是相同的。由于每个递归导致不同的HR预测,因此我们将从不同递归级别得到的所有预测结合起来,以提供更准确的最终预测。第二个提议是使用从输入到重建层的跳过连接。在SR中,低分辨率图像(输入)和高分辨率图像(输出)在很大程度上共享相同的信息。然而,输入的精确副本在许多正向传递期间可能被衰减。我们将输入显式连接到层以进行输出重建。当输入和输出高度相关时,这是特别有效的。

论文贡献

递归网络:递归网络与前馈网络有所不同,递归网络中节点间连接方式存在反馈,即神经元之间存在着反馈回路。因此在递归网络中,输入也可以由同一层的各节点通过反馈回路输入,还可以由下一层的各节点通过反馈回路输入。递归网络中至少存在一个反馈环,反馈环对整个神经网络的学习、“记忆”等性能有较深的影响。递归网络,即数据循环地通过该层多次。将这个循环进行展开,就等效于使用同一组参数的多个串联的卷积层。

贡献一:因为重建过程只是重建图片的高频细节,所以低分辨图片的大部分信息可以用到的, 增加低分辨率图片,作为ReconNet的输入(即skip connection).低分辨率图像和网络输出的高分辨率图像有很高的相关性,而随着递归深度的加深学习不到这种线性映射,所以通过该技巧可以使用大部分低分辨率信息用于重建高分辨率图像。

贡献二:提出使用的卷积层增加网络感受野(41*41),同时避免过多网络参数,提出递归神经网络,中间隐层参数共享,参数数量减少,不过递归网络同样也容易出现梯度消失或者梯度爆炸,所以提出递归监督。DRN中间隐层使用递归层,共享网络参数,使得网络参数变少。DRN网络层的中间隐层的输出也可以用于最后的重建,文章里训练的时候后向传播可以有多条路径传播误差。下图DRN的训练目标函数, 网络隐层的参数共享,隐层输出的feature map参与重建,加入损失函数。

网络结构

整个网络分三个部分,每个部分都只有一层隐层,只有inference 网络是递归的。

Embedding network :用于从RGB和灰度图像产生feature map,相当于特征提取

inference network :解决超分辨率,相当于特征的非线性变换。

reconstruction network:用于把多个通道的转成三个通道的图片。

recursive-supervision :训练递归网络也会出现梯度爆炸和梯度消失,所以作者使用递归层监督,可以让损失通过多条路径传播。每一个子层都是256个filters,filter尺寸为3×3。每一个循环子层的loss都会叠加到最终的总loss,从而成为一个有效的supervision,也对梯度消失与爆炸有平滑作用。

skip-connection:使用该技巧的原因是超分辨率重建,低分辨率图像和网络输出的高分辨率图像有很高的相关性,而随着递归网络深度加深学习不到这种线性映射,所以通过该技巧可以使用大部分低分辨率信息用于重建高分辨率图像。

其中的到是D个共享参数的卷积层。DRCN将每一层的卷积结果都通过同一个Reconstruction Net得到一个重建结果,从而共得到D个重建结果,再把它们加权平均得到最终的输出。另外,受到ResNet的启发,DRCN通过skip connection将输入图像与的输出相加后再作为Reconstruction Net的输入,相当于使Inference Net去学习高分辨率图像与低分辨率图像的差,即恢复图像的高频部分。

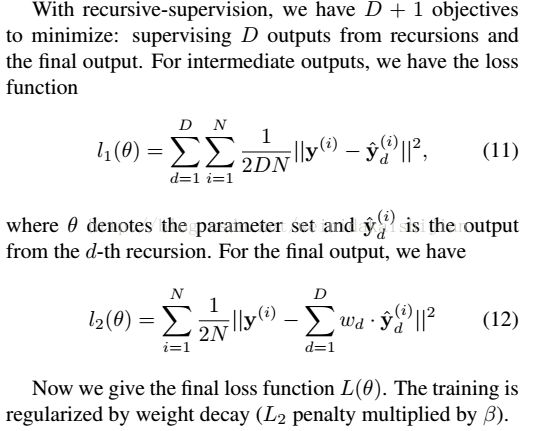

训练目标函数

我们现在描述用于找到我们模型的最优参数的训练目标。 给定训练数据集{x(i),y(i)},我们的目标是找到准确预测值y = f(x)的最佳模型。在最小二乘回归设置中,SR中的典型训练目标是在训练集中平均的均方误差y - f被最小化。这有利于得到高峰值信噪比(PSNR),这是广泛使用的评估标准。其中α表示伴随目标对中间输出的重要性,β表示重量衰减的乘数。 设置α高使训练过程稳定,因为早期递归容易收敛。 随着训练的进行,α衰退提高了最终输出的表现。

参考: