MSRN:Multi-scale Residual Network for Image Super-Resolution 论文翻译

Multi-scale Residual Network for Image Super-Resolution

用于图像高分辨率的多尺度残差网络

原文:Multi-scale Residual Network for Image Super-Resolution, ECCV2018

github(pytorch): https://github.com/MIVRC/MSRN-PyTorch

MSRN:Multi-scale Residual Network for Image Super-Resolution 论文理解

文章目录

- Multi-scale Residual Network for Image Super-Resolution

- 1. Introduction引言

- 2. Related Works相关网络

- 2.1 Single-image Super-resolution单图像超分辨率

- 2.2 Feature Extraction Block特征提取算法

- 3. Proposed Method提出的方法

- 3.1 Multi-scale Residual Block (MSRB)多尺度残差块

- 3.2 Hierarchical Feature Fusion Structure (HFFS)分级特征融合结构

- 3.3 Image Reconstruction图像重建

- 4 Experiments实验

- 4.1 Datasets数据集

- 4.2 Implementation Details实施细节

- 4.3 Comparisons with State-of-the-art Methods与最先进的几种方法比较

- 4.4 Qualitative Analysis定性分析

- 5 Discussion and Future Works讨论与未来工作

- 6 Conclusions总结

- References参考文献

摘要:近年来的研究表明,深度神经网络可以显著提高单幅图像的超分辨率。目前的研究倾向于使用更深层次的卷积神经网络来提高性能。然而,盲目地增加网络的深度并不能有效地改善网络。更糟糕的是,随着网络深度的增加,训练过程中出现的问题越来越多,需要更多的训练技巧。在本文中,我们提出了一种新的多尺度残差网络(multiscale residual network,MSRN) 来充分利用图像的特征,其性能优于大多数现有的方法。在残差块的基础上,引入不同大小的卷积核,自适应地检测不同尺度的图像特征。同时,我们让这些特征相互作用,得到最有效的图像信息,我们称之为结构多尺度残差块(Multi-scale Residual Block,MSRB)。此外,将每个MSRB的输出作为不同层次的特征进行全局特征融合。最后,将所有这些特征送到重构模块,获得高分辨率图像。

1. Introduction引言

图像超分辨率(SR),特别是单图像超分辨率(SISR)越来越受到学术界和工业界的关注。SISR旨在从低分辨率(LR)图像重建高分辨率(HR)图像,这是一个不适定问题,因为LR和HR之间的映射有多个解决方案。因此,学习方法被广泛应用于通过应用大型图像数据集来学习从LR到HR图像的映射。

目前,卷积神经网络(convolutional neural networks, CNNs)已经表明在SISR问题中可以提供显著的性能。2014年,Dong等人提出了一个称为SRCNN[1]的SISR问题模型,这是第一个成功地将CNNs用于SR问题的模型。SRCNN是一个高效的网络,可以学习一种LR和HR图像之间的端到端映射,而不需要任何工程特性,达到当时最令人满意的性能。此后,许多研究集中于建立更高效的网络来学习LR和HR图像之间的映射,从而提出了一系列基于CNNs的SISR模型[2-9]。EDSR[9]是 NTIRE2017 SR挑战赛的冠军。它以SRResNet[8]为基础,通过去除归一化层和使用更深更广的网络结构来增强网络。在SISR问题中,这些模型在峰值信噪比(PSNR)和结构相似指数(SSIM[10])方面都有很好的表现。然而,所有这些模型都倾向于构建更深入、更复杂的网络结构,这意味着训练这些模型会消耗更多的资源、时间和技巧。在这项工作中,我们重建了一些经典的SR模型,如SRCNN [1], EDSR[9]和SRResNet[8]。在重构实验中,我们发现现有的大部分SR模型存在以下问题:

(a)很难复现:实验结果表明,大多数高级模型对网络结构的细微变化敏感,其中一些由于网络结构的缺乏而难以达到原论文的水平。同样,同一个模型通过使用不同的训练技巧,如权值初始化、梯度截断、数据归一化等,获得了不同的性能。这意味着性能的提高可能不是由于模型架构的改变,而是使用了一些未知的训练技巧。

(b)特征利用不足:大多数方法为了提高网络的性能而盲目地增加网络的深度,而忽略了充分利用LR图像的特征。随着网络深度的增加,特征在传输过程中逐渐消失。如何充分利用这些特征,是网络重构高质量图像的关键。

(c)可扩展性不足:使用预处理的LR图像作为输入不仅会增加计算复杂性而且会产生可见的伪影。因此,最近的方法都是直接在LR图像放大重建,结果就是SR模型很难适应任意的缩放因子,或者说只需要对网络结构进行小调整就可以迁移到任何缩放因子。

为了解决上述问题,我们提出了一种新的多尺度残差网络(multi-scale residual network, MSRN)。此外,还提出了一种多尺度残差块(MSRB)作为MSRN的构建模块。首先,我们使用MSRB获取不同尺度的图像特征,将其视为局部多尺度特征。其次,将每个MSRB的输出组合起来进行全局特征融合。最后,将局部多尺度特征与全局特征相结合,可以最大限度地利用LR图像特征,彻底解决特征在传输过程中消失的问题。另外,我们引入了一个以1×1卷积核作为瓶颈层的卷积层来获得全局特征融合。此外,我们使用了一个设计良好的重构结构,该结构简单但高效,并且可以很容易地迁移到任何向上扩展的因子。

我们在没有特殊的权重初始化方法或其他训练技巧的情况下,在DIV2K[11]数据集上训练我们的模型。我们的基本模型在基准测试数据集上显示出优于最先进的方法的性能。此外,该模型还可以通过增加MSRB的数量或训练图像的大小来获得更有竞争力的结果。更令人兴奋的是,我们的MSRB模块可以迁移到其他恢复模型进行特征提取。本文的贡献如下:

-

不同于以往的工作,我们提出了一种新的多尺度残差块(multi-scale residual block, MSRB),它不仅能够自适应地检测图像的特征,而且能够实现不同尺度的特征融合。这是第一个基于残差结构的多尺度模块。更重要的是,它很容易训练和超越现有的模块。

-

我们将我们的工作扩展到计算机视觉任务,结果超越了没有深度网络结构的先进的SISR方法。此外,MSRB还可用于其他恢复任务的特征提取,取得了良好的效果。

-

提出了一种简单的分层特征融合(HFFS)和图像重建的体系结构。它可以很容易地扩展到任何向上扩展的因子。

2. Related Works相关网络

2.1 Single-image Super-resolution单图像超分辨率

SISR问题大致可分为三个主要阶段。早期的方法使用基于采样理论的插值技术,如线性或双三次。这些方法运行速度快,但不能重建详细的、真实的纹理。改进工作旨在建立LR和HR图像之间的复杂映射函数。这些方法依赖于从相邻嵌入到稀疏编码的各种技术。

最近的工作倾向于建立端到端CNNs模型,通过使用大型训练数据集来学习从LR到HR图像的映射功能。自从Dong等人提出了SRCNN[1]模型以来,各种CNNs架构已经被用于SISR问题。以前的工作通常使用预处理后的LR图像作为输入,通过双三次向上采样算子将其放大到HR空间。然而,这种方法已经被证明会增加计算复杂度并产生可见的伪影。为此,提出了快速超分辨率卷积神经网络(FSRCNN[3])和高效亚像素卷积网络(ESPCN[2])等新方法。以上模型均为浅的网络(小于5层)。Kim等人[12]首先引入了用于训练更深层网络(20层)的残差体系结构,并取得了良好的性能。此后,许多SR模型被提出,包括DRCN[5]、DRNN[7]、LapSRN[6]、SRResNet[8]和EDSR[9]。不幸的是,这些模型变得越来越深,非常难以训练。

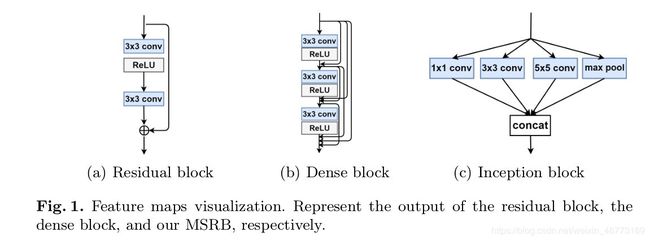

图1:特征图可视化。分别表示剩余块、稠密块和我们的MSRB的输出。

2.2 Feature Extraction Block特征提取算法

目前,已有许多特征提取块被提出。inception块[13](图1.©)的主要思想是找出卷积网络中最优的局部稀疏结构是如何工作的。然而,这些不同的尺度特征简单地连接在一起,导致了局部特征的未充分利用。2016年,Kim等人[12]提出了一个残差学习框架(图1.(a)),以简化网络的训练,使其能够获得更有竞争力的结果。之后,Huang等人引入了稠密块(图1.(b))。残差块和稠密块使用单一大小的卷积核,稠密块的计算复杂度以较高的增长速度增长。为了解决这些问题,我们提出了一个多尺度的残差块。

在残差结构的基础上,我们引入了不同大小的卷积核,用于自适应地检测不同尺度图像的特征。同时,在不同尺度特征之间应用跳跃连接,实现特征信息的共享和重用。这有助于充分利用图像的局部特征。此外,在块的末端有一个1×1的卷积层可以作为瓶颈层,有助于特征融合,降低计算复杂度。我们将在3.1节中给出更详细的描述。

3. Proposed Method提出的方法

在超分辨率中,我们的目的是从低分辨率图像 I L R I^{LR} ILR得到对应的超分辨率图像 I S R I^{SR} ISR,高分辨率图像 I H R I^{HR} IHR是通过双三次插值得到 I H R I^{HR} IHR。我们将图像转化为YCbCr通道,并且只在Y通道上训练。将 I L R I^{LR} ILR 记作W × H × C, I H R I^{HR} IHR和 I S R I^{SR} ISR记作rW × rH × C,其中C=1,表示Y通道,r表示缩放因子。

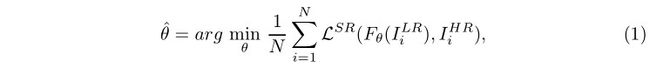

最终目标是学习 I L R I^{LR} ILR和 I H R I^{HR} IHR之间的端到端映射函数 F F F。即给定训练集 { I i L R , I i H R } i = 1 N \lbrace{I^{LR}_i,I^{HR}_i}\rbrace_{i=1}^N {IiLR,IiHR}i=1N,我们需要解决下面这个问题:

这里, θ = { W 1 , W 2 , W 3 ⋯ W m , b 1 , b 2 , b 3 ⋯ B m } \theta =\lbrace {W_1,W_2,W_3 \cdots W_m,b_1,b_2,b_3 \cdots B_m }\rbrace θ={W1,W2,W3⋯Wm,b1,b2,b3⋯Bm} ,θ表示权重w和偏置b, ς S R \varsigma^{SR} ςSR是用来最小化 I H R I^{HR} IHR和 I S R I^{SR} ISR差异的损失函数。最近,研究人员也致力于寻找一种辅助损失函数来提高网络性能。最常用的图像目标优化函数是MSE函数和L2函数。虽然这些方法可以获得很高的PSNR/SSIM,但是对于MSE优化和L2优化问题的解决方案往往会产生过于平滑的纹理。现在已经提出了各种各样的损失函数,如VGG[4]函数和Charbonnier Penalty函数[6]。相反,我们发现他们的绩效改善微乎其微。为了避免引入不必要的训练技巧,减少计算量,我们最终选择了L1函数。因此,损失函数 ς S R \varsigma^{SR} ςSR可以定义为:

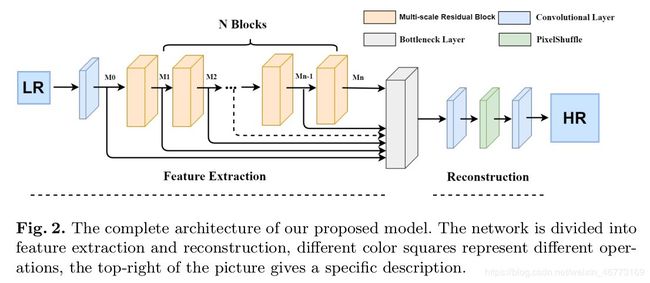

如图2所示,它是我们提出的模型的完整架构。我们的模型将未处理的LR图像作为输入,通过网络直接上采样到高分辨率空间。我们的模型可以分为两部分:特征提取模块和图像重建模块。特征提取模块由多尺度残差块(multi-scale residual block, MSRB)和层次特征融合结构(hierarchy feature fusion structure, HFFS)两部分组成。

3.1 Multi-scale Residual Block (MSRB)多尺度残差块

为了检测不同尺度下的图像特征,我们提出了多尺度残差块(multi-scale residual block, MSRB)算法。在这里,我们将提供这个结构的详细描述。如图3所示,我们的MSRB包含两部分:多尺度特征融合和局部残差学习。

多尺度特征融合:不同于以往的工作,我们构建了一个双旁路网络,不同旁路使用了不同的卷积核。通过这种方式,这些旁路之间的信息可以相互共享,从而能够检测出不同尺度的图像特征。该操作可以定义为:

其中, w w w和 b b b分别表示权值和偏置,上标表示它们所在的层数,下标表示该层中使用的卷积核的大小。 σ ( x ) = m a x ( 0 , x ) \sigma(x)=max (0, x) σ(x)=max(0,x) 代表ReLU函数, [ S 1 , P 1 ] , [ P 1 , S 1 ] , [ S 2 , P 2 ] [S_1,P_1],[P_1,S_1],[S_2, P_2] [S1,P1],[P1,S1],[S2,P2] 表示连接操作。

设M表示送到MSRB的feature map的数量。所以第一个卷积层的输入和输出有M个feature map。第二个卷积层输入或输出有2M 个feature map。所有这些feature map被连接起来,然后送到一个1×1 卷积层。这一层将这些特征映射的数量减少到M,因此我们的MSRB的输入和输出具有相同数量的特征映射。独特的体系结构允许多个MSRBs一起使用。

局部残差学习:为了提高网络的效率,我们对每个MSRB采用剩余学习。形式上,我们将一个多尺度残差块(multi-scale residual block, MSRB)描述为:

其中 M n M_n Mn 和 M n − 1 M_{n−1} Mn−1 分别表示MSRB的输入和输出。操作 S ′ + M n − 1 S' +M_{n−1} S′+Mn−1是通过快捷连接和按元素顺序添加来执行的。值得一提的是,使用局部残差学习使得计算复杂度大大降低,同时提高了网络的性能。

3.2 Hierarchical Feature Fusion Structure (HFFS)分级特征融合结构

对于SISR问题,输入和输出图像是高度相关的。关键是要充分利用输入图像的特征,并将其传输到网络的末端进行重构。然而,随着网络深度的增加,这些特征在传输过程中逐渐消失。在这一问题的驱动下,出现了各种方法,其中跳跃连接是最简单、最有效的方法。所有这些方法都试图在不同的层之间创建不同的连接。遗憾的是,这些方法不能充分利用输入图像的特征,产生了过多的冗余信息,难以达到目的。

在实验中,我们注意到随着深度的增加,网络的空间表达能力逐渐下降,而语义表达能力逐渐增强。此外,每个MSRB的输出都包含不同的特性。因此,如何充分利用这些层次特征将直接影响重建图像的质量。在本文中,我们使用了一个简单的分级特征融合结构。我们将MSRB的所有输出发送到网络的末端进行重构。一方面,这些特征图包含了大量的冗余信息。另一方面,直接将它们用于重构会大大增加计算复杂度。为了自适应地从这些层次化特征中提取有用的信息,我们引入了一个卷积层,它对于具有1×1内核的卷积层是必不可少的。分级特征融合结构(HFFS)的输出可以表示为:

其中, M 0 M_0 M0 为第一卷积层的输出, M i ( i ≠ 0 ) M_i(i \neq 0) Mi(i=0) 为第 i i i 个MSRB的输出, [ M 0 , M 1 , M 2 , ⋯ , M N ] [M_0,M_1,M_2, \cdots , M_N] [M0,M1,M2,⋯,MN] 表示连接( concatenation)操作。

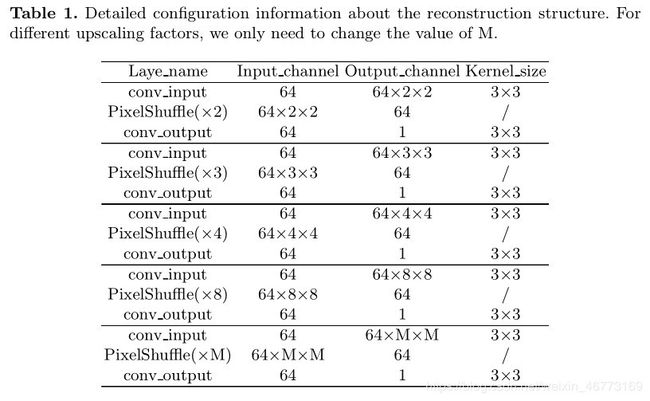

3.3 Image Reconstruction图像重建

之前的工作主要是学习LR和HR图像之间的映射函数,其中LR图像被bicubic上采样到与HR相同的维度。然而,这种方法引入了冗余信息,增加了计算复杂度。受此启发,最近的工作倾向于使用未放大的LR作为输入图像,以训练一个可以直接上采样到HR维度的网络。相反,很难找到一个SR模型,它能够迁移到任何向上扩展的因子,只需要对网络体系结构进行少量的调整。此外,这些网络中的大多数往往是一个固定的放大(x4),没有给出迁移到其他升级因子的具体指令。

PixelShuffle [2] 和反卷积层在SISR任务中得到了广泛的应用。如上图所示,有几种常见的重构模块。以放大因子4为例,各模块均采用PixelShuffle或反卷积操作,以放大因子2为基础逐步重构SR图像。然而,随着规模因子的增加(如x8),网络变得更加深入,训练问题也变得更加不确定。此外,这些方法对奇数向上缩放因子不起作用,而人们可能希望放大因子是缓慢增长的(2–>3–>4–>5)而不是指数增长。

为此,提出了一种新的重构模块,该模块结构简单、高效、灵活。由于pixelshuffle,模块可以迁移到任何放大因子,只需进行少量调整。在表格中,提供了关于重建结构的详细配置信息。在我们的网络中,对于不同的放大因子,我们只需要改变M的值,其变化可以忽略不计。实验表明,该结构在不同的放大因子下均有较好的性能。

4 Experiments实验

在本节中,我们将评估我们的模型在几个基准测试数据集上的性能。我们首先介绍用于训练和测试的数据集,然后给出实现细节。接下来,我们将我们的模型与几种最先进的方法进行比较。最后,给出了一系列定性分析的实验结果。此外,我们还展示了使用MSRB执行其他低级计算机视觉任务的一些结果。

4.1 Datasets数据集

以往研究中使用最广泛的训练数据集包括291张图像,其中91张来自[14],另外200张来自[15]。一些方法以ImageNet[16]作为训练数据集,因为它包含更丰富的样本。在我们的工作中,我们选择了DIV2K[11]作为我们的训练数据集,一个新的高质量的图像数据集的图像恢复挑战。在测试时,我们使用5个广泛使用的基准数据集:Set5[17]、Set14[18]、BSDS100[19]、Urban100[20]和Manga109[21]。这些数据集包含各种各样的图像,可以完全验证我们的模型。在之前的工作中,我们所有的训练和测试都是基于YCbCr色彩空间中的亮度通道进行的,并使用了升级因子:×2、×3、×4、×8进行训练和测试。

4.2 Implementation Details实施细节

根据[6],我们以三种方式增加训练数据:(1)缩放(2)旋转(3)翻转。在每个训练batch中,我们随机抽取16个LR patch,大小为64×64,每个epoch有1000次的反传播迭代。我们使用ADAM optimizer通过设置学习率lr = 0.0001来训练我们的模型。在我们最终的模型中,我们使用了8个多尺度残差块(MSRB, N = 8),每个MSRB的输出有64个feature map。同时,每个瓶颈层(1×1 convolutional layer)的输出都有64个feature map。我们实现了MSRN与Pytorch框架,训练使用NVIDIA Titan Xp GPU。我们不使用特殊的权重初始化方法或其他训练技巧,代码可以从https://github.com/mivrc/msrn.pytorch获得。

4.3 Comparisons with State-of-the-art Methods与最先进的几种方法比较

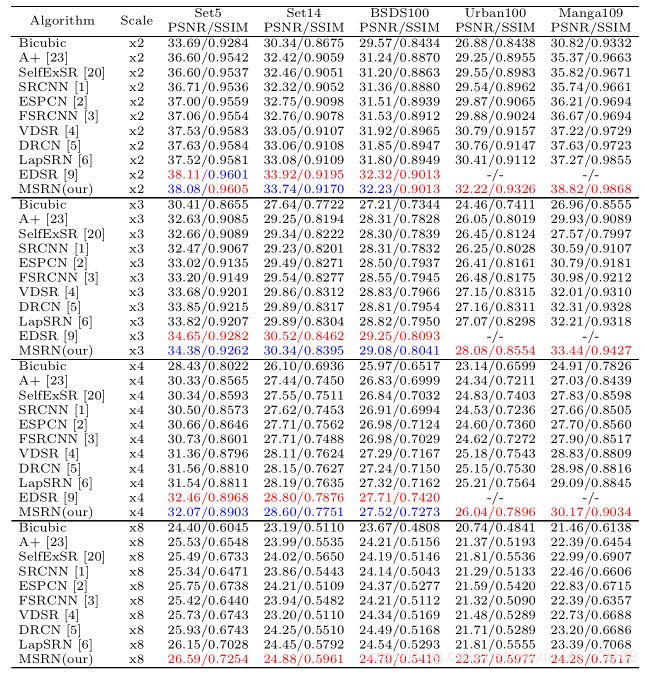

我们将我们的模型与10种最先进的SR方法进行比较,包括Bicubic、A+[23]、SelfExSR[20]、SRCNN[1]、ESPCN[2]、FSRCNN[3]、VDSR[4]、DRCN[5]、LapSRN[6]和EDSR[9]。为了公平起见,我们对这些模型进行了再训练(EDSR[9]除外,EDSR的结果由他们的原始论文提供)。

考虑到比较的平等性,我们用两个常用的图像质量指标:PSNR和SSIM来评价SR图像。此外,所有被分类的PSNR/SSIM测量值都在亮度通道上进行计算,并从每个b阶中移除M像素(M代表向上缩放因子)。

SR方法的评价结果包括我们的模型和10种最先进的方法,如表2所示。

表2。最先进方法的定量比较。红色的文字表示最好的性能,蓝色的文字表示第二好的性能。请注意,EDSR结果并不是由我们重新训练的,而是由他们的原始论文提供的。

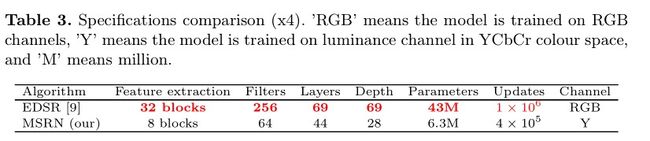

我们的模型在不同的上升率因子和测试数据集上表现得非常好。可以看出,我们的结果略低于EDSR[9]。但是值得注意的是EDSR[9]的使用RGB通道用于训练,同时,数据增强方法也不同。为了更好地说明与EDSR[9]的区别,我们在表3中对模型规范进行了比较。

EDSR[9]是一个杰出的模型,取得了惊人的结果。然而,它是一个包含大量卷积层和参数的深度广的网络。换句话说,训练这个模型将花费更多的内存、空间和数据集。相比之下,我们的模型规格比EDSR[9]小得多,这使得它更容易复制和推广。

在图6和图7中,我们展示了具有不同向上缩放因子的不同数据集的视觉性能。我们的模型可以重建清晰的自然图像,并且比其他最先进的方法表现得更好。这可能是因为MSRB模块可以检测出不同尺度的图像特征,并将其用于重建。为了更好的说明,可以在https://goo.gl/bGnZ8D找到更多由我们的模型重建的SR图像。

4.4 Qualitative Analysis定性分析

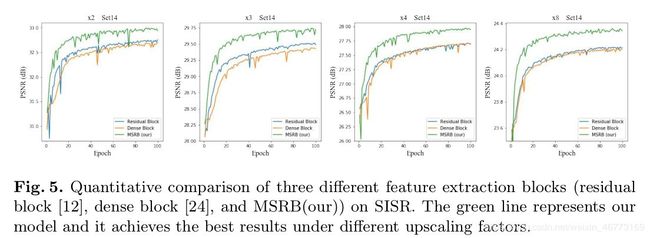

MSRB的优点:在这项工作中,我们提出一个有效的特征提取结构:多尺度残差块。该模块能够自适应地检测不同尺度的图像特征,充分挖掘图像的潜在特征。为了验证我们的模块的有效性,我们设计了一组对比实验来比较剩余块[12]、密集块[24]和MSRB在SISR任务中的性能。基于MSRN体系结构,我们替换了网络中的特征提取块。这三个网络包含不同的特征提取块,每个网络只包含一个特征提取块。为了快速验证,我们在这部分使用了一个小的训练数据集,所有这些模型都在相同的环境中进行了 1 0 5 10^5 105次迭代训练。结果(图5)所示,

我们的MSRB模块在所有上采样因子上都优于其他模块。如图9所示,我们将这些特征提取块的输出可视化。值得注意的是,激活是稀疏的(大多数值为零,如黑色所示),一些激活映射可能都为零,这表示过滤器已死。显然,MSRB的输出包含了更多有效的激活映射,这进一步证明了该结构的有效性。

增加MSRB数量的好处:众所周知,增加网络的深度可以有效地提高性能。在本工作中,加入MSRBs的麻木er是获得优秀效果的最简单方法。为了验证MSRBs数量对网络的影响,我们设计了一系列实验。如图8所示,随着MSRBs数量的增长,我们的MSRN性能迅速提高。虽然网络的性能将通过使用更多的MSRB进一步提高,但这将导致更复杂的网络。在权衡网络性能和网络复杂度时,我们最终使用了8个 MSRBs,结果接近EDSR,但是模型参数的数量只有EDSR的1 / 7。

其他任务的性能:为了进一步验证我们提出的MSRB模块的有效性,我们将其应用于其他低级计算机视觉任务中进行特征提取。如图10所示,我们分别给出了图像去噪和图像去雾的结果。很明显,我们的模型在其他低级计算机视觉任务上取得了很好的效果。

5 Discussion and Future Works讨论与未来工作

为了使重建图像在SISR中更加逼真,人们提出了许多训练技巧。例如,[4]、[9]采用多尺度混合训练方法(这里的尺度代表向上尺度因子),[9]提出了几何自集成方法。我们相信这些训练技巧也可以提高我们的模型性能。然而,我们更倾向于探索一个有效的模型,而不是使用训练技巧。虽然我们的模型表现出了良好的性能,但是在较大的上移因子下,重构图像仍然不够清晰。在今后的工作中,我们将更加关注大尺度的下采样图像重建。

6 Conclusions总结

本文提出了一种高效的多尺度残差块(multi-scale residual block, MSRB),用于自适应地检测不同尺度的图像特征。基于MSRB,提出了多尺度剩余网络(multi-scale residual network, MSRN)。它是一种简单高效的SR模型,能够充分利用图像的局部多尺度特征和层次特征,获得准确的SR图像。此外,我们将MSRB模块应用于其他计算机视觉任务,如图像去噪和图像去雾,取得了令人满意的结果。

References参考文献

-

Dong, C., Loy, C.C., He, K., Tang, X.: Learning a deep convolutional network for

image sup er-resolution. In: Europ ean conference on computer vision, Springer (2014)

184–199 -

Shi, Wenzhe and Caballero, Jose and Huszár, Ferenc and Totz, Johannes and Aitken,

Andrew P and Bishop, Rob and Rueckert, Daniel and Wang, Zehan.: Real-time

single image and video sup er-resolution using an efficient sub-pixel convolutional

neural network. In: Pro ceedings of the IEEE Conference on Computer Vision and

Pattern Recognition. (2016) 1874–1883 -

Dong, C., Loy, C.C., Tang, X.: Accelerating the sup er-resolution convolutional neu-

ral network. In: Europ ean Conference on Computer Vision, Springer (2016) 391–407 -

Kim, J., Kwon Lee, J., Mu Lee, K.: Accurate image sup er-resolution using very deep

convolutional networks. In: Pro ceedings of the IEEE conference on computer vision

and pattern recognition. (2016) 1646–1654 -

Kim, J., Kwon Lee, J., Mu Lee, K.: Deeply-recursive convolutional network for

image sup er-resolution. In: Pro ceedings of the IEEE conference on computer vision

and pattern recognition. (2016) 1637–1645 -

Lai, W.S., Huang, J.B., Ahuja, N., Yang, M.H.: Deep laplacian pyramid networks

for fast and accurate sup erresolution. In: IEEE Conference on Computer Vision and

Pattern Recognition. Volume 2. (2017) 5 -

Tai, Y., Yang, J., Liu, X.: Image sup er-resolution via deep recursive residual net-

work. In: Pro ceedings of the IEEE Conference on Computer Vision and Pattern

Recognition. Volume 1. (2017) 5 -

Ledig, C., Theis, L., Huszár, F., Caballero, J., Cunningham, A., Acosta, A., Aitken,

A., Tejani, A., Totz, J., Wang, Z., et al.: Photo-realistic single image sup erresolution

using a generative adversarial network. In: The IEEE conference on computer vision

and pattern recognition. (2017) -

Lim, B., Son, S., Kim, H., Nah, S., Lee, K.M.: Enhanced deep residual networks

for single image sup er-resolution. In: The IEEE conference on computer vision and

pattern recognition workshops. Volume 1. (2017) 4 -

Wang, Z., Bovik, A.C., Sheikh, H.R., Simoncelli, E.P.: Image quality assessment:

from error visibility to structural similarity. IEEE transactions on image pro cessing

13(4) (2004) 600-612 -

Agustsson, E., Timofte, R.: Ntire 2017 challenge on single image sup er-resolution:

Dataset and study. In: The IEEE Conference on Computer Vision and Pattern

Recognition Workshops. Volume 3. (2017) 2 -

He, K., Zhang, X., Ren, S., Sun, J.: Deep residual learning for image recognition.

In: Pro ceedings of the IEEE conference on computer vision and pattern recognition.

(2016) 770–778 -

Szegedy, C., Liu, W., Jia, Y., Sermanet, P., Reed, S., Anguelov, D., Erhan, D.,

Vanhoucke, V., Rabinovich, A.: Going deep er with convolutions. In: Pro ceedings of

the IEEE conference on computer vision and pattern recognition. (2015) 1-9 -

Yang, J., Wright, J., Huang, T.S., Ma, Y.: Image sup er-resolution via sparse rep-

resentation. IEEE transactions on image pro cessing 19(11) (2010) 2861–2873 -

Martin, D., Fowlkes, C., Tal, D., Malik, J.: A database of human segmented natu-

ral images and its application to evaluating segmentation algorithms and measuring

ecological statistics. In: Pro ceedings Eighth IEEE International Conference on Com-

puter Vision. (2001) 416–423 -

Russakovsky, O., Deng, J., Su, H., Krause, J., Satheesh, S., Ma, S., Huang, Z.,

Karpathy, A., Khosla, A., Bernstein, M., et al.: Imagenet large scale visual recogni-

tion challenge. International Journal of Computer Vision 115(3) (2015) 211–252 -

Bevilacqua, M., Roumy, A., Guillemot, C., Alberi-Morel, M.L.: Low-complexity

single-image super-resolution based on nonnegative neighbor embedding. In: Pro-

ceedings of the 23rd British Machine Vision Conference. (2012) -

Zeyde, R., Elad, M., Protter, M.: On single image scale-up using sparserepresenta-

tions. In: International conference on curves and surfaces, Springer (2010) 711–730 -

Arbelaez, P., Maire, M., Fowlkes, C., Malik, J.: Contour detection and hierarchical

image segmentation. IEEE transactions on pattern analysis and machine intelligence

33(5) (2011) 898–916 -

Huang, J.B., Singh, A., Ahuja, N.: Single image super-resolution from transformed

self-exemplars. In: Proceedings of the IEEE Conference on Computer Vision and

Pattern Recognition. (2015) 5197–5206 -

Matsui, Y., Ito, K., Aramaki, Y., Fujimoto, A., Ogawa, T., Yamasaki, T., Aizawa,

K.: Sketch-based manga retrieval using manga109 dataset. Multimedia Tools and

Applications 76(20) (2017) 21811–21838 -

Kingma, D.P., Ba, J.L.: Adam: Amethod for stochastic optimization. In: Proceed-

ings of the 3rd International Conferencce on Learning Representations. (2014) -

Timofte, R., De Smet, V., Van Gool, L.: A+: Adjusted anchored neighborhood

regression for fast super-resolution. In: Asian Conference on Computer Vision,

Springer (2014) 111–126 -

Huang, G., Liu, Z., Weinberger, K.Q., van der Maaten, L.: Densely connected

convolutional networks. In: Proceedings of the IEEE conference on computer vision

t super-resolution. In: Asian Conference on Computer Vision,

Springer (2014) 111–126 -

Huang, G., Liu, Z., Weinberger, K.Q., van der Maaten, L.: Densely connected

convolutional networks. In: Proceedings of the IEEE conference on computer vision

and pattern recognition. Volume 1. (2017) 3