三、安装Ambari+HDP

大家在安装之前,一定要先确认好安装哪个版本的,如果不知道自己需要安装哪个版本的,可以先到官网查看一下每个版本的差别:

https://zh.hortonworks.com/products/data-platforms/hdp/

比如:在3.0版本以后,已经不支持flume组件了,如果说业务当中有需要flume的话,那就最好不要安装3.0及其以上版本的了,因为如果自己手动集成的话,会相当麻烦,我就踩过这个坑,最后结果就是没踩出结果。。。如果有踩出结果的同学,麻烦不吝赐教哈。。

3.1安装Ambari

3.1.1 在mysql中创建ambari数据库

1)创建数据库

mysql> create database ambari default character set utf8;

mysql> create user 'ambari'@'%' identified by 'bigdata';

mysql> grant all privileges on ambari. * to 'ambari'@'%';

mysql> flush privileges;

2)添加mysql驱动包

创建目录:[root@amabri ~]# mkdir -p /usr/share/java/

上传驱动包:将mysql-connector-java-5.1.27.jar上传到该目录

修改jar包权限:[root@master java]# chmod 777 mysql-connector-java-5.1.27.jar

建立软连接:[root@ambari java]# ln -s mysql-connector-java-5.1.27.jar mysql-connector-java.jar

3.1.2准备本地数据源

1)创建路径

mkdir -p /var/www/html/hdp_repo

2)将下面四个压缩包放入该目录

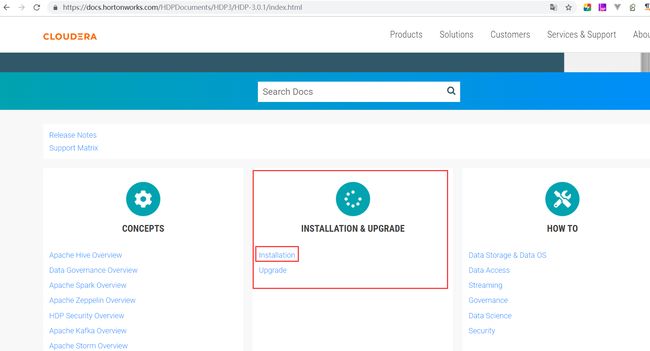

官网下载:https://docs.hortonworks.com/

我们这里选择3.0.1版本进去

我们选择“ Installation”

选择“Apache Ambari Installation”

选择“3 Obtaining Public Repostories”

https://docs.hortonworks.com/HDPDocuments/Ambari-2.7.1.0/bk_ambari-installation/content/ambari_repositories.html

然后右侧选择离线安装包下载

接着再下载HDP离线安装包

完整的就是下列四个压缩包:

ambari-2.7.1.0-centos7.tar.gz

HDP-3.0.1.0-centos7-rpm.tar.gz

HDP-GPL-3.0.1.0-centos7-gpl.tar.gz

HDP-UTILS-1.1.0.22-centos7.tar.gz

3)将四个压缩文件解压

4)浏览器验证

打开浏览器输入:http://39.104.115.79/hdp_repo/

5)在/etc/yum.repos.d下创建.repo文件

ambari.repo:

[ambari-2.7.1.0]

name=ambari_repo

baseurl=http://39.104.115.79/hdp_repo/ambari/centos7/2.7.1.0-169

enabled=true

gpgcheck=false

hdp.repo:

[HDP-3.0.1.0]

name=hdp_repo

baseurl= http://39.104.115.79/hdp_repo/HDP/centos7/3.0.1.0-187/

enabled=true

gpgcheck=false

hdp-utils.repo:

[HDP-UTILS-1.1.0.22]

name=hdp_utils_repo

baseurl= http://39.104.115.79/hdp_repo/HDP-UTILS/centos7/1.1.0.22/

enabled=true

gpgcheck=false

hdp-gpl.repo:

[HDP-GPL-3.0.1.0-187]

name=hdp_gpl_repo

baseurl= http://39.104.115.79/hdp_repo/HDP-GPL/centos7/3.0.1.0-187/

enabled=true

gpgcheck=false

3.1.3执行安装

1)通过yum安装Ambari Server

[root@ambari ~]# yum install ambari-server

出现如果信息,表示安装成功

2)建立Ambari与MySQL驱动的连接

[root@ambari ~]# ambari-server setup

--jdbc-db=mysql --jdbc-driver=/usr/share/java/mysql-connector-java.jar

3)初始化Ambari Server

[root@ambari ~]# ambari-server setup

4)初始化Ambari数据库

在Ambari也即是MySQL节点执行以下命令:

[root@ambari ~]# mysql -uroot -p -Dambari

< /var/lib/ambari-server/resources/Ambari-DDL-MySQL-CREATE.sql

5)启动Ambari

[root@mambari ~]# ambari-server start

6)浏览器验证

浏览器输入: http://39.104.115.79:8080/#/login

3.2安装HDP

3.2.1集群名称

hdp_bigdata

3.2.2选择HDP版本

3.0.1.0

选择本地仓库,并删除不需要的OS

最后输入HDP-3.0,HDP-3.0-GPL,HDP-UTILS-1.1.0.22的http地址,点击Next

http://39.104.115.79/hdp_repo/HDP/centos7/3.0.1.0-187/

http://39.104.115.79/hdp_repo/HDP-GPL/centos7/3.0.1.0-187/

http://39.104.115.79/hdp_repo/HDP-UTILS/centos7/1.1.0.22/

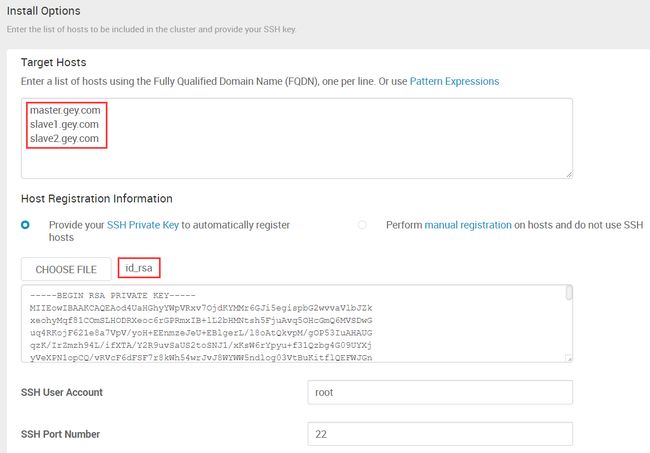

3.2.3安装选项

输入三台机器上hostname以及ambari所在机器的公钥文件,点击“Next”

3.2.4确认机器

一定要确保Status这一栏都是Success,再点击Next

3.2.5选择服务

先只安装HDFS、Zookeeper和Ambari Metrics(这个就算不选也会自动安装),点击Next

3.2.6分配机器

3.2.7分配从节点和客户端

三个节点全部安装DataNode,点击Next

3.2.8自定义服务

设置好密码,并且要用一个txt统一记下密码,点击Next

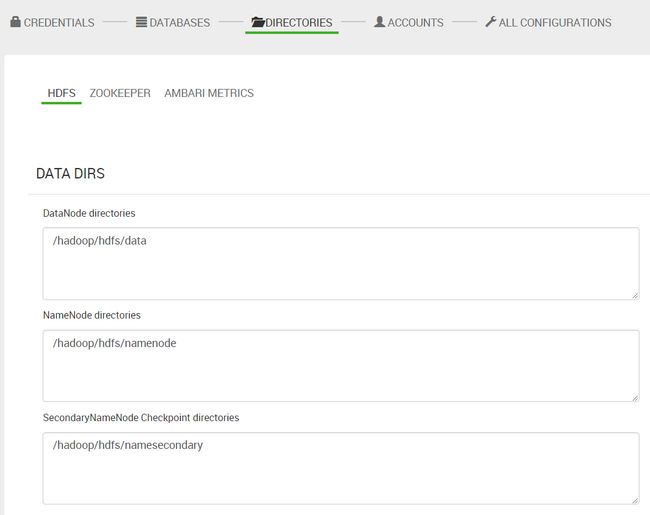

全部默认,点击Next

全部默认,点击Next

全部默认,点击Next

3.2.9重新检查

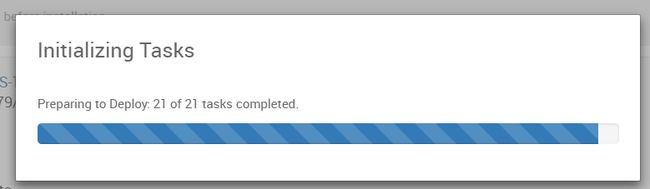

点击Reploy

3.2.10安装、启动和测试

出现:Python script has been killed due to timeout after waiting 1800 secs

解决方法:vim /etc/yum.conf,把installonly_limit的值设成3600,然后重启ambari-server

点击Next

3.2.11 汇总

点击complete完成

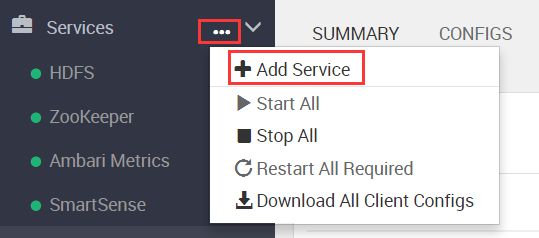

3.3HDP添加服务

3.3.1添加yarn+marpreduce2

1)参数调整

Ambari Metrics服务参数调整

hbase_master_heapsize 这个参数默认值为768,改为2048

hbase_master_xmn_size 这个参数值需要调大,默认值为192M,这个参数值不能小于12% of hbase_master_heapsize + hbase_regionserver_heapsize

改为512

改完之后重启Ambari Metrics服务

1)Add Service

3.3.2添加hive

在master.gey.com这台机器上重新安装了mysql服务(按照上一篇讲述的安装),并创建hive元数据库。。。

mysql> create database metastore default character set utf8;

mysql> create user 'hive'@'%' identified by 'bigdata';

mysql> grant all privileges on metastore. * to 'hive'@'%';

mysql> flush privileges;

注意:这里的DataBase Name、DataBase Username、DataBase URL以及DataBase Password一定要填写正确,否则无法启动hive。

如图则表示安装成功。。。

3.3.3添加sqoop

Sqoop只涉及到安装客户端

这个安装比较简单

3.3.4添加spark2

将参数值:spark.shuffle.file.buffer 由默认的1M改为100M

spark.shuffle.unsafe.file.output.buffer 由默认的5M改为50M

spark.io.compression.lz4.blockSize 由默认的128kb改为10M

3.3.5添加hbase

到此为止,整个环境就安装完毕。。。

安装过程中,设置的一些参数是根据机器性能来设置的,如果搭建的环境机器配置不一样,可能参数设置也会有所差别。。

内容将同步到微信公众号,欢迎关注微信公众号:LearnBigData