七月文章导读【5G相关】:从摩斯码到5G;5G承载网;5G链路自适应及CQI工作过程

Table of Contents

从摩斯码到5G:通讯背后这182年都干了什么?

萌芽期:现代通信的诞生

蛰伏期:等待,耐心的等待

爆发期:从1G到4G,日新月异的移动通信

展望未来:通信路在何方

参考文献:

5G承载网到底有什么不同?

5G承载网,到底要咋办?

大带宽

低时延、高可靠性

高精度同步能力

易于运维

低能耗

支持切片

5G承载网,到底包括哪些部分?

5G链路自适应及CQI工作过程概述

1. 链路自适应工作过程

2. CQI测量和上报

从摩斯码到5G:通讯背后这182年都干了什么?

小枣君 电子工程专辑

https://mp.weixin.qq.com/s/11aa4e03S9irL6r0NWIhxw

萌芽期:现代通信的诞生

泰勒斯认为,这和磁铁是一个原理,他将这种未知的神秘力量,称之为“电”。

后来,越来越多的人开始研究电,并取得了不错的进展。其中最伟大的发现,就是本杰明·富兰克林的“风筝实验”。

1821年,英国人迈克尔·法拉第(Michael Faraday)发明了电动机。10年后,1831年,他又发现了电磁感应定律,并且制造出世界上第一台能产生持续电流的发电机。

1837年,美国人摩斯(Morse)发明了摩斯电码和有线电报。

1888年,德国人海因里希·鲁道夫·赫兹(Heinrich Rudolf Hertz)用实验证明了电磁波的存在。至此,经典电磁理论大厦正式落成。

蛰伏期:等待,耐心的等待

爆发期:从1G到4G,日新月异的移动通信

1G使用的是模拟通信技术,保密性差,容量低,通话质量也不行,信号不稳定。

2G是数字移动通信技术的闪亮登场。刚起步时,为了摆脱1G时代通信标准被美国垄断的局面,欧洲打算自己搞一个通信标准。于是,1982年,欧洲邮电管理委员会成立了“移动专家组”,专门负责通信标准的研究。这个“移动专家组”,法语缩写是GroupeSpécialMobile,后来这一缩写的含义被改为“全球移动通信系统”(Global System for Mobilecommunications),也就是大名鼎鼎的GSM。

1G的技术核心,是FDMA(频分多址)。顾名思义,就是不同的用户使用不同频率的信道,以此来实现通信。

2G GSM的核心,是TDMA(时分多址)。其特点是将一个信道平均分给八个通话者,一次只能一个人讲话、每个人轮流用1/8的信道时间。

没想到的是,美国公司高通,又搞出了第三套系统,那就是CDMA。

CDMA的核心,是码分多址。相比于GSM,CDMA的容量更大,抗干扰性更好,安全性更高。

不过,CDMA起步较晚,GSM已经在全球占据了大部分的市场份额,形成了事实上的全球主流标准。再加上使用高通的CDMA,需要缴纳巨额的专利授权费。所以,虽然同属2G标准,CDMA的影响力和市场规模和GSM无法相提并论。

为了上网,为了对分组数据业务提供支持,演进出了2.5G,也就是GPRS,General Packet Radio Service,通用分组无线业务。

3G的三大标准,分别是欧洲主导的WCDMA,美国主导的CDMA2000,还有中国推出的TD-SCDMA。

再往后,就是4G LTE了。这一阶段的故事,相信大家都非常熟悉。

从1G到4G,从用户的角度来说,1G出现了移动通话,2G普及了移动通话,2.5G实现了移动上网,3G实现了更快速率的上网,4G实现了更更快速率的上网,并基本满足了人们所有的互联网需求。

展望未来:通信路在何方

通过5G的Massive MIMO增强型天线阵列、波束赋形、更强的编码方式,进一步榨干电磁波的潜力。

参考文献:

1、《大话移动通信》-张海君等

2、《通信之道,从微积分到5G》-杨学志

3、从1G到5G,回顾波澜壮阔的移动网络进化史-网优雇佣军

4、马丁库帕词条-百度百科

5G承载网到底有什么不同?

原创: 小枣君 鲜枣课堂 6月17日

https://mp.weixin.qq.com/s/Cl3cq0sORGMJbt0prQjLJQ

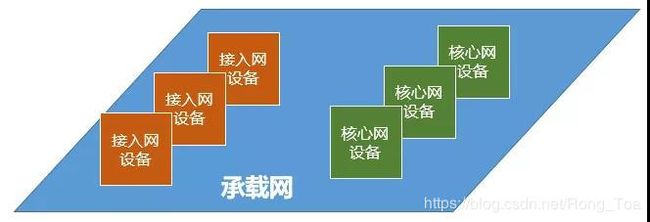

什么是承载网?顾名思义,承载网就是专门负责承载数据传输的网络。

以前我们更多介绍的是接入网和核心网。如果说核心网是人的大脑,接入网是四肢,那么承载网就是连接大脑和四肢的神经网络,负责传递信息和指令。

虽然承载网的重要性被大家一致认可,但存在感却很弱。

在大多数人看来,承载网只是一个管道。只要它没有断,就不用去管它。

也有很多人认为,承载网的技术含量低,整天就是面对让人密集恐惧症发作的光纤和网线,没有什么前途可言。其实,这都是对承载网的误解。承载网看似简单,实际上内部结构非常复杂。承载网的整个技术体系规模,一点都不输给接入网和核心网。尤其是5G时代下,承载网的发展更是到了“疯狂”的地步,引入了很多高大上的黑科技,让人目不暇接,不明觉厉。接下来,就让我慢慢给大家介绍。

5G承载网,到底要咋办?

从1G到4G,承载网经历了从低带宽到高带宽、从小规模到大规模的巨大变化。

如今的承载网网络,事实上已经非常强大和完善了。承载网设备的性能,也十分强劲。

尽管如此,在5G面前,这些现有设备和技术方案还是只有瑟瑟发抖的份。

进入5G时代,通信网络的指标发生了大幅的变化,有的指标标准甚至提升了十几倍。想要达到要求,只靠无线空中接口部分改进是办不到的。包括承载网在内的整个端到端网络架构,都必须自我革命。

那承载网的革命目标在哪里呢?主要来说,包括以下几个方面:

-

大带宽

带宽!带宽!带宽!

毫无疑问,带宽是5G承载网最基础和最重要的技术指标。空口的速率提升了几十倍,承载网相应也要大幅提升。尤其是在目前5G刚起步的阶段,eMBB是首先要实现的业务场景,最关注的也就是带宽。

-

低时延、高可靠性

车联网、工业控制等垂直行业,对网络的时延和可靠性要求苛刻。

5G最重要的需求之一,就是低时延低,需要实现个位数毫秒级的端到端时延。承载网作为端到端的一部分,虽然不是时延的重点提升对象,但也要分摊一部分指标压力。

在5G很多场景下,都提出了“6个9级别(99.9999%)”的可靠性要求。因此,承载网也必须服务于这样的要求,还要有足够强大的容灾能力和故障恢复能力。

-

高精度同步能力

5G对承载网的频率同步和时间同步能力提出了很高的要求。

同步到底是干啥用的?

简单举几个例子:5G的载波聚合、多点协同和超短帧,需要很高的时间同步精度;5G的基本业务采用时分双工(TDD)制式,需要精确的时间同步;再有就是室内定位增值服务等,也需要精确的时间同步。

-

易于运维

5G承载网将会无比巨大,设备数量多,网络架构复杂。如果网络不能够做到灵活、智能、高效、开放,那对于运营商和运维工作人员来说就是一场噩梦。

-

低能耗

网络既要足够强大,又要尽量省电。省电就是省钱。

-

支持切片

切片之前我们介绍过,它是5G网络的核心能力。承载网当然也必须支持切片。

以上几个方面,就是5G承载网自我革命的目标。任何一个目标无法实现,就不是合格的5G承载网。

5G承载网,到底包括哪些部分?

介绍5G承载网结构之前,我们先来看看接入网的变化。

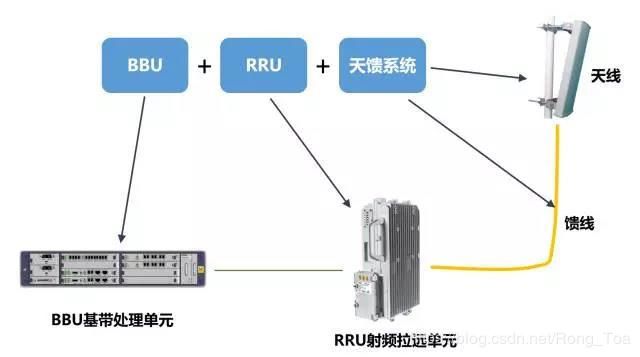

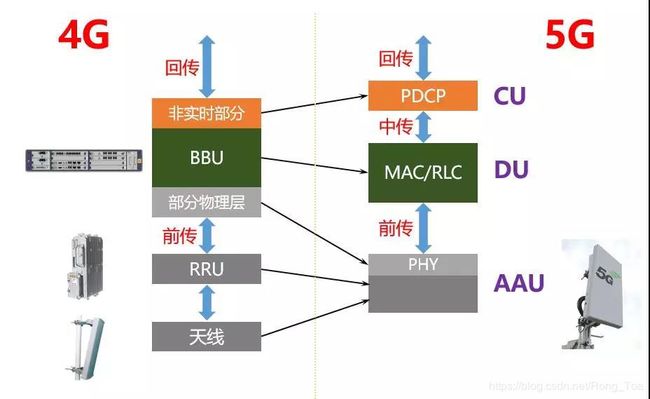

4G接入网,大家都很熟悉了,是由BBU(基带处理单元)、RRU(射频拉远单元)、天馈系统共同组成的。

到了5G,接入网被重构为3个功能实体,分别是:

-

CU(Centralized Unit,集中单元)

-

DU(Distribute Unit,分布单元)

-

AAU(Active Antenna Unit,有源天线单元)

- CU:原BBU的非实时部分将分割出来,重新定义为CU,负责处理非实时协议和服务。

- DU:BBU的剩余功能重新定义为DU,负责处理物理层协议和实时服务。

- AAU:BBU的部分物理层处理功能与原RRU及无源天线合并为AAU。

之所以要拆分得这么细,是为了更好地调配资源,服务于业务的多样性需求(例如降低时延、减少能耗),服务于“网络切片”。(详情可以看这里:关于5G接入网,看这一篇就够啦!)

接入网变成AAU、DU、CU之后,承载网也随之发生了巨变。

这个我要澄清一个误区:一直以来,很多人认为承载网只是连接接入网和核心网的,就像本文开头画的那样:

其实是不严谨的,那样画只是为了方便。准确来说,承载网也包括接入网内部连接的部分,还有核心网内部连接的部分。所以,更准确的逻辑关系画法,应该是这样:

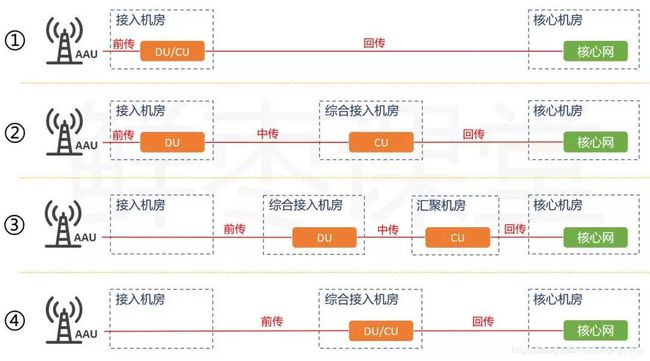

5G接入网网元之间,也就是AAU、DU、CU之间,也是5G承载网负责连接的。不同的连接位置,有自己独特的名字,分别叫作:前传、中传、回传。

- AAU和DU之间,是前传

- DU和CU之间,是中传

- CU和核心网之间,是回传

- 这三个“传”,都属于承载网

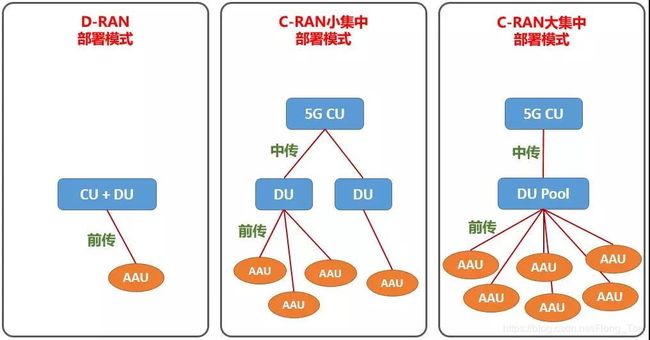

现实生活中的5G网络,DU和CU的位置并不是严格固定的。运营商可以根据环境需要,灵活调整。

以前小枣君曾经专门介绍过D-RAN和C-RAN。D-RAN就是分布式无线接入网(Distributed RAN),C-RAN是集中化无线接入网(Centralized RAN)。

4G时期,所谓分布和集中,指的就是BBU的分布或集中。5G时期,指的是DU的分布或集中。这种集中还分为“小集中”和“大集中”。

再次提醒,采用C-RAN进行集中化的目的,就是为了实现统一管理调度资源,提升能效,也可以进一步实现虚拟化(接入网那篇文章有详细介绍)。

正因为部署模式的多样性,使得前传、中传、回传的位置也随之不同。

文章内容不详细写出,这里在给个网址:https://mp.weixin.qq.com/s/Cl3cq0sORGMJbt0prQjLJQ

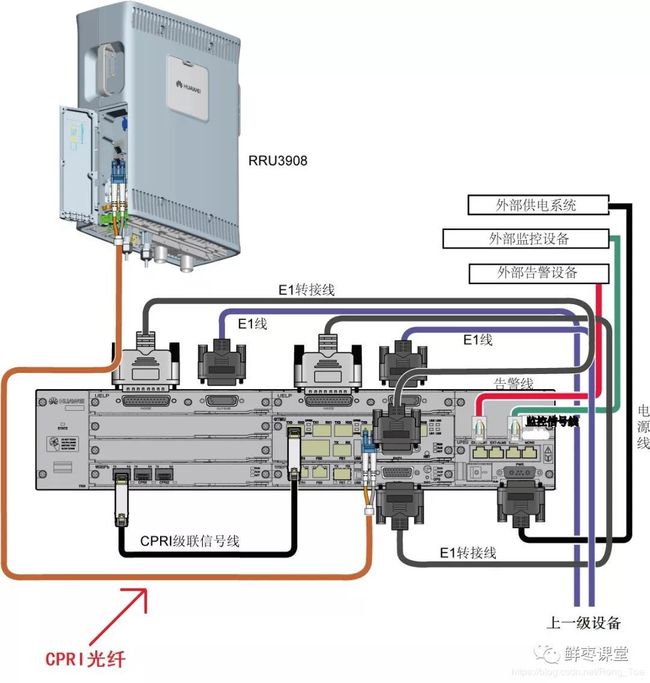

BBU和RRU之间的CPRI光纤

5G链路自适应及CQI工作过程概述

胡郝文 5G通信技术 4月21日

https://mp.weixin.qq.com/s/34fb1l_QL2xtQffb6VRZRA

1. 链路自适应工作过程

链路自适应是指系统根据无线环境和链路状态等信息对调制方式、TBS及码率进行动态选择的过程。5G系统中,上/下行方向上的链路自适应都是由基站来进行控制的。

下行方向上,网络可以根据终端上报的信道状态信息(CSI)中的CQI来选择调制方式和码率,并对UE所使用的调制方式及其与目标码率的组合进行动态指示,以便确定传输块大小。目标码率共有28种(如果支持256QAM则29种),目标码率范围从0.1到0.95。5G系统支持灵活的CSI机制,如CSI的类别、上报数量、上报频度、上报粒度以及时域行为都可以配置。支持网络控制的周期性和非周期性(触发的)报告模式,其中非周期报告可以由网络来请求采用哪个CSI-RS资源来进行CSI上报。

上行方向上,基站可以测量话务信道或者探测参考信号,并使用它们作为链路自适应的输入。

MAC层中,支持传输兼采用软合并的混合ARQ。不同传送可以使用不同的冗余版本。重传时调制模式和编码方式可以改变。为了降低时延和反馈,可以使用一组并行的停/等协议。为了对残留错误(residualerror)进行校正,RLC层采用强壮的选择-重复ARQ协议来对MACARQ进行补充。详见TS38.321和TS38.322。

2. CQI测量和上报

下行链路自适应基于UE上报的CQI(信道质量指示)来进行。UE对无线信道质量如SINR进行测量,并上报信道相关的CQI信息,用以为分组调度和链路适配等无线资源管理算法提供信道质量信息,链路适配算法则基于CQI来选择最有效的调制和编码机制(MCS)。

CQI是在预定义的观察周期下满足特定BLER需求时所推荐的频谱效率。UE上报CQI的目的是为了让系统侧根据无线状况选择合适的下行传输参数。特定BLER目标值要求下,UE测量每个PRB上接收功率以及干扰来获取SINR,并根据频谱效率需求,将SINR映射到相应的CQI,随后将CQI上报给gNB。

gNB根据UE上报的CQI来选择当前信道状况下的最合适的MCS,以满足特定比特错误率和分组误帧率下的频谱效率,确保数据速率最大化。比如,如果无线条件较好,则在物理层上使用较高的MCS和码率,以增加系统吞吐量;反之,如果无线环境较差,则需要使用较低的MCS和码率,以增加传送可靠性。

系统根据CQI与MCS的对应关系以及相关的传输块大小(即TBS),为PDSCH选择合适的调制方式和传输块大小的组合,进行上/下行传送工作。这种调制方式和传输块大小的组合应当使得有效信道码率与CQI索引所指示的码率最为接近。如果有多个组合都产生相同的有效码率,且都与CQI索引指示值相接近,则只选择传输块最小的那种组合。

CQI反馈可以是周期性的,也可以是非周期性的,具体采用哪种方式由gNB进行控制。非周期性CQI反馈只在需要的时候才进行发送,它比周期性反馈中所包含的频域信道状态信息更为精确,从而便于调度器获取频率分集。