python进阶爬虫class 2(缓存)

下载缓存

通过缓存已经下载好了的url网页,来检查是否有重复下载的情况

将网页信息保存在本地磁盘上时,要注意不同操作系统的文件系统的合法字符和最大长度,以确保做到兼容,同时要注意替换后是否会产生同名现象。默认保存的网页名称为路径后的文件名,也可以使用哈希值来保存网页路径。

但是也存在着文件名为空的可能性,那么文件名为空的文件默认为index

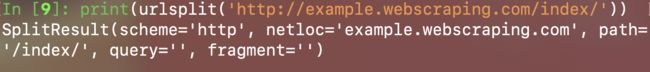

可以同过 urllib.parse 里的 urlsplit(url)方法来实现对url的解析

对下载的html网页进行压缩

在二进制写文件下:

使用f.write( zlib.compress(pickle.dumps(html)))可以将网页压缩二进制的html网页,直接打开会乱码,可以将网页大小大致缩小为原来的一半

在二进制读文件下:

使用pickle.loads(zlib.decompress(f.read()))可以将之前的二进制的html网页读取出来,str类型

注:使用压缩会使程序速度变慢些