- MTK ADSP

yyc_audio

嵌入式硬件

MTK音频硬件概念AFE:音频前端硬件audiofrontendhwAFEMEMIF(FE):PCMDMA,memoryread/writeAudiointerconnection:connectionfabricforaudiosubmodule。核心路由器件。负责FE和BE之间的连接和路由。DAI(BE):DigitalAudioI/F,eTDM/I2S/DMIC.–EnhancedTDM,c

- Chapter 4-16. Troubleshooting Congestion in Fibre Channel Fabrics

mounter625

Linuxkernel服务器运维linuxkernel

ShowFCSIeExample4-17showstheNX-OScommandshowfcsieonCiscoMDSswitches.例4-17显示了CiscoMDS交换机上的NX-OS命令showfcsie。Example4-17NX-OScommandshowfcsieonCiscoMDSswitchesMDS9706-C#showfcsieIEListforVSAN:20---------

- Python进行DevOps实践

黑夜照亮前行的路

pythondevops开发语言

使用Python进行DevOps实践可以涉及多个方面,从自动化部署、配置管理、监控到日志分析等等。下面是一些具体的方法和实践,展示如何使用Python在DevOps环境中进行工作:1.自动化部署使用Python编写自动化部署脚本,可以极大地提高部署效率。例如,可以使用fabric或paramiko等库来远程执行命令,或者使用Ansible这样的自动化工具,它本身使用Python编写,并提供了丰富的

- 用Python玩转Hyperledger:构建企业级区块链解决方案

Echo_Wish

Python!实战!perlpythonopencv人工智能

用Python玩转Hyperledger:构建企业级区块链解决方案大家好,我是Echo_Wish。在区块链技术的炙手可热中,“企业级区块链”俨然成为了下一个重磅关键词。相比于公有区块链,企业级区块链更注重隐私性、灵活性和高效性。而在这片“蓝海”中,Hyperledger项目无疑是企业级区块链解决方案的标杆。如果再搭配上Python这种“高效工具”,简直让人事半功倍!那么,如何将Python与Hyp

- Microsoft Fabric 功能更新!更多智能优化,数据平台更强大

近期,微软MicrosoftFabric又更新了,大大增强了AI方面的功能。迅易科技作为微软13年来紧密的生态合作伙伴,为300+行业头部客户实施1000+项目。今天,我们带大家来看下,MicrosoftFabric有什么新玩法?一年前,微软正式推出了一款端到端数据平台,MicrosoftFabric(国际版)是一个集成一体化的平台,提供支持各种数据项目的人工智能驱动服务,帮助所有数据团队能够更快

- 推荐开源项目:YFT Design - 强大的在线图片设计工具

咎旗盼Jewel

推荐开源项目:YFTDesign-强大的在线图片设计工具yft-design基于fabric.js的图片设计,fabric.jsandvue3andtypescriptandelement-plus,supportingthemostcommonlyusedelementtypessuchastext,images,shapes,lines,QRcodes,andbarcodes.Eachelem

- 快图设计:一款强大的Vue图片编辑器

姚婕妹

快图设计:一款强大的Vue图片编辑器项目地址:https://gitcode.com/gh_mirrors/vu/vue-fabric-editor在数字化时代,图片编辑工具已成为设计师和开发者的必备利器。今天,我要向大家推荐一款基于fabric.js和Vue开发的插件化图片编辑器——快图设计(vue-fabric-editor)。这款开源项目不仅功能强大,而且易于扩展,非常适合需要轻量级图片编辑

- Ubuntu20.04搭建Hyperledger Fabric2.4

WangF1rst

基础环境dockergolangraspberrypiarmfabric

基础环境操作系统:ubuntu-20.04.4安装Gitaptinstallgit安装curlaptinstallcurl安装dockeraptinstalldocker.ioapt-yinstalldocker-compose检测docker是否安装成功docker--version启动docker并设置docker为开机自启动systemctlstartdockersystemctlenabl

- 桂链:区块链模型介绍

桂云网络OSG

区块链

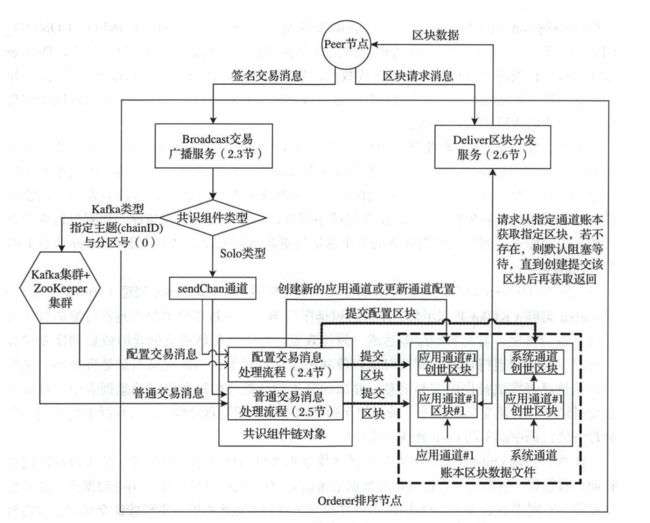

桂链区块链基于Hyperledger开发,本文转自HyperledgerFabric。HyperledgerFabric模型¶本节概述了HyperledgerFabric的关键设计特性,这些特性确保其成为全方位、可定制的企业级区块链解决方案:资产—资产定义使得几乎任何具有货币价值的东西都可以在网络上交换,包括从食品到古董汽车再到货币期货。链码—链码执行与交易排序的分离,限制了跨节点类型所需的信任和

- 桂链:什么叫区块链网络?

桂云网络OSG

桂链区块链区块链网络服务器

本文由桂云网络转自HyperledgerFabric,桂链基于HyperledgerFabric开发,是桂云网络公司旗下的区块链产品。区块链网络¶这个话题会在概念层面上描述HyperledgerFabric是如何让组织间以区块链网络的形式进行合作的。如果你是一个架构师,管理员或者开发者,你可以通过这个话题来深入理解在HyperledgerFabric区块链网络中的主要结构和处理组件。这个话题会使用

- 数据分析与AI丨AI Fabric:数据和人工智能架构的未来

Altair澳汰尔

数据分析aiRapidMiner知识图谱人工智能

AIFabric架构是模块化、可扩展且面向未来的,是现代商业环境中企业实现卓越的关键。在当今商业环境中,数据分析和人工智能领域发展可谓日新月异。几乎每天都有新兴技术诞生,新的应用场景不断涌现,前沿探索持续拓展。可遗憾的是,众多企业在利用数据和人工智能方面,脚步总是滞后。这是每个行业进行创新和获得竞争优势的冲刺阶段,但正如大多数企业时常感受到的那样,大规模实施下一代数据和AI工具说起来容易做起来难。

- Chapter 4-6. Troubleshooting Congestion in Fibre Channel Fabrics

mounter625

Linuxkernel网络运维服务器linuxkerneltcp/ip

Oncethecongestionischasedtotheadjacentswitch(Switch-1inFigure4-8),thencontinuelookingforcongestiononthatswitchandrepeatthesesteps.IfthecongestionindicationontheISLportonthelocalswitch(Switch-3inFigure

- Chapter 4-8. Troubleshooting Congestion in Fibre Channel Fabrics

mounter625

Linuxkernel服务器网络kernellinux

Utilizingtheshowtech-supportslowdrainCommandTheshowtech-supportslowdrainisasinglecommandonCiscoMDSswitchesthataggregatesalltheothercommandsnormallynecessaryfortroubleshootingcongestionintoasingleoutpu

- Fabric合约(Java)打包及发布

qsqya

区块链javafabricmybatis

文档合约打包将打包好的合约(jar)上传到服务器/root/fabric/fabric-samples-2.2.0/chaincode/fabric-contract-demo1打包peerlifecyclechaincodepackagefabric-contract-demo1.tar.gz--path../chaincode/fabric-contract-demo1/--langjava-

- Aloudata 正式发布 NoETL 数据工程架构与三款创新产品,率先实现 Data Fabric 在中国的最佳实践

12月15日,国内领先的自动化数据管理软件提供商Aloudata(大应科技)在线举办了「NoETL!重构数据生产力」战略与产品发布会,AloudataCEO周卫林携创始团队正式发布面向未来的NoETL数据工程架构,并发布AloudataAIR逻辑数据平台、AloudataBIG主动元数据平台和AloudataCAN自动化指标平台三款颠覆性创新产品,为企业解决数字化转型中的难点、痛点提供了全新的思路

- 自动化运维工具ansible实战

元气满满的热码式

运维自动化ansible云原生

什么ansibleansible是新出现的自动化运维工具,基于Python开发,集合了众多运维工具(puppet、chef、func、fabric)的优点,实现了批量系统配置、批量程序部署、批量运行命令等功能。ansible的特点部署简单,只需在主控端部署Ansible环境,被控端无需做任何操作;默认使用SSH协议对设备进行管理;有大量常规运维操作模块,可实现日常绝大部分操作;配置简单、功能强大、

- ansible面试题

三颗草丶

1024程序员节

简述Ansible及其优势?Ansible是一款极其简单的开源的自动化运维工具,基于Python开发,集合了众多运维工具(puppet,cfengine,chef,func,fabric)的优点。实现了批量系统配置,批量程序部署,批量运行命令等功能。同时Ansible是基于模块工作,其实现批量部署的是ansible所运行的模块。Ansible其他重要的优势:跨平台支持:Ansible在物理、虚拟、

- Hyperledger Fabric 应用实战(3)--配置文件core.yaml

vvgo123

HyperledgerFabric应用实战fabricdocker容器区块链

1.简介core.yaml主要是为Peer服务提供一些配置定义,当Peer节点启动时,会先从命令行获取参数、环境变量、和core.yaml读取配置信息。通过docker去搭建一个Peer服务,命令行默认是不带参数的,主要通过docker-compose文件和core.yaml去定义配置信息。docker-compose相当于环境变量,其优先级比较高,用来更灵活和个性化配置Peer服务的配置,因此在

- Linux修改/etc/hosts不起作用(ping: xxx: Name or service not known)的解决方法——开启NSCD

荆棘鸟骑士

linux

问题描述起因是我在实验室云资源池的一台虚拟机(CentOS8.5)上的/etc/hosts文件中为Fabric网络节点的域名指定了IP:IP可以ping通,但是ping域名时提示ping:xxx:Nameorservicenotknown。问题本身应该是Linux通用的,不局限于CentOS8。特记录以供参考。已尝试但不起作用的方法花了两个上午在网上搜索关键词,尝试了各种方法,但是都不起作用。比如

- Hyperledger Fabric 入门笔记(十六)Fabric V2.5 测试网络部署补充 - 手动从通道中移除组织

荆棘鸟骑士

HyperledgerFabricfabric区块链

文章目录一、手动从通道中移除组织1.1.准备工作1.2.流程1.2.1.停止组织Org2的对等体1.2.2.通道配置更新1.2.2.1.获取现有通道配置1.2.2.2.将通道配置转换为JSON格式并修剪1.2.2.3.修改通道配置1.2.2.4.签名并提交配置更新1.2.3.重启Org1和Org3的Peer节点一、手动从通道中移除组织1.1.准备工作本节从包含了组织Org1、Org2和Org3的F

- Hyperledger Fabric 入门笔记(六)Fabric V2.5 测试网络进阶之网络部署

荆棘鸟骑士

HyperledgerFabricfabric区块链

文章目录前言一、手动部署链码1.1.准备工作1.2.启用Logspout(可选)1.3.流程1.3.1.打包智能合约1.3.1.1.安装依赖1.3.1.2.创建链码包1.3.2.安装链码包1.3.3.批准链码定义1.3.4.提交链码定义到通道二、手动部署通道2.1.准备工作2.2.V2.5版本流程2.2.1.生成通道创世区块2.2.2.创建应用通道2.2.3.将Peer节点加入到通道中2.3.V2

- io.fabric8.docker-maven-plugin插件使用

瞳孔里的阳光

Mavenspringbootmavenspringboot

io.fabric8.docker-maven-plugin插件使用一、说明本文记录内容主要为了在开发和测试环境快速部署使用,详细内容参考一下原博主文章:Docker守护进程+远程连接+安全访问+启动冲突解决办法(完整收藏版)最强大的Docker插件fabric8io/docker-maven-plugin二、环境、软件情况总共有三台服务器,一台window系统,两台linux系统,三台服务器网络

- 如何用MySQL打造具备动态调整能力的企业级数据编织架构

墨夶

数据库学习资料1mysql架构数据库

在当今数字化转型的浪潮中,企业对于数据管理的需求日益增长。传统的数据处理方式已经难以满足现代业务快速变化的要求。为了应对这一挑战,一种新的概念——“数据编织”(DataFabric)应运而生。它不仅能够整合来自多个源的数据,还能根据业务需求自动调整和优化数据流。今天,我们将深入探讨如何利用MySQL构建一个具备动态调整能力的企业级数据编织架构,让您的企业在激烈的市场竞争中立于不败之地。一、理解数据

- 编织数据的未来——利用MySQL构建弹性企业级数据编织架构

墨夶

数据库学习资料2mysql架构数据库

在当今数字化转型加速的时代,企业面临着前所未有的挑战与机遇。随着业务复杂度和数据量的不断增长,传统的数据管理方式已难以满足现代企业的需求。为了应对这一变化,越来越多的企业开始探索更加智能和灵活的数据架构——数据编织(DataFabric)。它不仅能够无缝连接来自不同来源的数据,还提供了跨平台、跨部门的一致性和可访问性。本文将详细介绍如何利用MySQL构建一个具备弹性的企业级数据编织架构,帮助企业在

- python fabric

Facechat

介绍Fabric是一个Python(2.5-2.7)库和命令行工具,用来流水线化执行SSH以部署应用或系统管理任务。更具体地说,面料是:一个让你通过命令行执行任意Python函数的工具;一个让通过SSH执行Shell命令更加容易和pythonic的子程序库(建立于一个更低层次的库)。自然地,大部分用户把这两件事结合着用,使用Fabric来写和执行Python函数或任务,以实现与远程服务器的自动化交

- Python模块学习 - fabric

anhuoqiu1787

python运维shell

简介fabric是一个Python的库,同时它也是一个命令行工具。使用fabric提供的命令行工具,可以很方便地执行应用部署和系统管理等操作。fabric依赖于paramiko进行ssh交互,fabric的设计思路是通过几个API接口来完成所有的部署,因此fabric对系统管理操作进行了简单的封装,比如执行命令,上传文件,并行操作和异常处理等。#fabric3支持python3pip3instal

- python Fabric在自动化部署中的应用

jingbo1801

开发工具pythonfabric自动化

1、介绍Fabric是一个Python的库和命令行工具,用来提高基于SSH的应用部署和系统管理效率。更具体地说,Fabric是:一个让你通过命令行执行无参数Python函数的工具;一个让通过SSH执行Shell命令更加容易、更符合Python风格的命令库(建立于一个更低层次的库)。自然而然地,大部分用户把这两件事结合着用,使用Fabric来写和执行Python函数或task,以实现与远程服务器的自

- ansible学习

让美好继续发生

ansibleansible学习

ansible学习介绍Ansible是一个基于Python开发的自动化运维工具,它集合了众多运维工具(如puppet、cfengine、chef、func、fabric)的优点,实现了批量系统配置、批量程序部署、批量运行命令等功能。前置环境准备:配置密钥认证:1.生成密钥ssh-keygen-trsa2.将公钥复制到远程服务器中ssh-copy-id用户名@远程服务器IP地址安装yuminstal

- FFmpeg 中 -f 命令参数详解

码流怪侠

ffmpegFFmpeg音视频直播转码命令行

FFmpegFFmpeg是一个开源的、功能强大的多媒体框架,它能够处理几乎所有格式的音频和视频文件。FFmpeg由FabriceBellard创立,并由MichaelNiedermayer等人继续开发。它包括了libavcodec(用于编解码)、libavformat(用于格式转换)、libavfilter(用于音视频过滤)、libavdevice(用于输入输出)、libavutil(包含一些工具

- React native新架构组成

会编程的猩猩

reactnative

ReactNative的新架构(NewArchitecture)引入了一些新的组件和概念,旨在提高性能、增强灵活性和简化跨平台开发。主要组成部分包括:Fabric:FabricRenderer:Fabric是新的渲染引擎,它旨在取代现有的渲染引擎。与现有渲染引擎相比,Fabric更高效,并且能够更好地支持异步渲染。ConcurrentRendering:Fabric支持并发渲染,使得React能够

- Java实现的简单双向Map,支持重复Value

superlxw1234

java双向map

关键字:Java双向Map、DualHashBidiMap

有个需求,需要根据即时修改Map结构中的Value值,比如,将Map中所有value=V1的记录改成value=V2,key保持不变。

数据量比较大,遍历Map性能太差,这就需要根据Value先找到Key,然后去修改。

即:既要根据Key找Value,又要根据Value

- PL/SQL触发器基础及例子

百合不是茶

oracle数据库触发器PL/SQL编程

触发器的简介;

触发器的定义就是说某个条件成立的时候,触发器里面所定义的语句就会被自动的执行。因此触发器不需要人为的去调用,也不能调用。触发器和过程函数类似 过程函数必须要调用,

一个表中最多只能有12个触发器类型的,触发器和过程函数相似 触发器不需要调用直接执行,

触发时间:指明触发器何时执行,该值可取:

before:表示在数据库动作之前触发

- [时空与探索]穿越时空的一些问题

comsci

问题

我们还没有进行过任何数学形式上的证明,仅仅是一个猜想.....

这个猜想就是; 任何有质量的物体(哪怕只有一微克)都不可能穿越时空,该物体强行穿越时空的时候,物体的质量会与时空粒子产生反应,物体会变成暗物质,也就是说,任何物体穿越时空会变成暗物质..(暗物质就我的理

- easy ui datagrid上移下移一行

商人shang

js上移下移easyuidatagrid

/**

* 向上移动一行

*

* @param dg

* @param row

*/

function moveupRow(dg, row) {

var datagrid = $(dg);

var index = datagrid.datagrid("getRowIndex", row);

if (isFirstRow(dg, row)) {

- Java反射

oloz

反射

本人菜鸟,今天恰好有时间,写写博客,总结复习一下java反射方面的知识,欢迎大家探讨交流学习指教

首先看看java中的Class

package demo;

public class ClassTest {

/*先了解java中的Class*/

public static void main(String[] args) {

//任何一个类都

- springMVC 使用JSR-303 Validation验证

杨白白

springmvc

JSR-303是一个数据验证的规范,但是spring并没有对其进行实现,Hibernate Validator是实现了这一规范的,通过此这个实现来讲SpringMVC对JSR-303的支持。

JSR-303的校验是基于注解的,首先要把这些注解标记在需要验证的实体类的属性上或是其对应的get方法上。

登录需要验证类

public class Login {

@NotEmpty

- log4j

香水浓

log4j

log4j.rootCategory=DEBUG, STDOUT, DAILYFILE, HTML, DATABASE

#log4j.rootCategory=DEBUG, STDOUT, DAILYFILE, ROLLINGFILE, HTML

#console

log4j.appender.STDOUT=org.apache.log4j.ConsoleAppender

log4

- 使用ajax和history.pushState无刷新改变页面URL

agevs

jquery框架Ajaxhtml5chrome

表现

如果你使用chrome或者firefox等浏览器访问本博客、github.com、plus.google.com等网站时,细心的你会发现页面之间的点击是通过ajax异步请求的,同时页面的URL发生了了改变。并且能够很好的支持浏览器前进和后退。

是什么有这么强大的功能呢?

HTML5里引用了新的API,history.pushState和history.replaceState,就是通过

- centos中文乱码

AILIKES

centosOSssh

一、CentOS系统访问 g.cn ,发现中文乱码。

于是用以前的方式:yum -y install fonts-chinese

CentOS系统安装后,还是不能显示中文字体。我使用 gedit 编辑源码,其中文注释也为乱码。

后来,终于找到以下方法可以解决,需要两个中文支持的包:

fonts-chinese-3.02-12.

- 触发器

baalwolf

触发器

触发器(trigger):监视某种情况,并触发某种操作。

触发器创建语法四要素:1.监视地点(table) 2.监视事件(insert/update/delete) 3.触发时间(after/before) 4.触发事件(insert/update/delete)

语法:

create trigger triggerName

after/before

- JS正则表达式的i m g

bijian1013

JavaScript正则表达式

g:表示全局(global)模式,即模式将被应用于所有字符串,而非在发现第一个匹配项时立即停止。 i:表示不区分大小写(case-insensitive)模式,即在确定匹配项时忽略模式与字符串的大小写。 m:表示

- HTML5模式和Hashbang模式

bijian1013

JavaScriptAngularJSHashbang模式HTML5模式

我们可以用$locationProvider来配置$location服务(可以采用注入的方式,就像AngularJS中其他所有东西一样)。这里provider的两个参数很有意思,介绍如下。

html5Mode

一个布尔值,标识$location服务是否运行在HTML5模式下。

ha

- [Maven学习笔记六]Maven生命周期

bit1129

maven

从mvn test的输出开始说起

当我们在user-core中执行mvn test时,执行的输出如下:

/software/devsoftware/jdk1.7.0_55/bin/java -Dmaven.home=/software/devsoftware/apache-maven-3.2.1 -Dclassworlds.conf=/software/devs

- 【Hadoop七】基于Yarn的Hadoop Map Reduce容错

bit1129

hadoop

运行于Yarn的Map Reduce作业,可能发生失败的点包括

Task Failure

Application Master Failure

Node Manager Failure

Resource Manager Failure

1. Task Failure

任务执行过程中产生的异常和JVM的意外终止会汇报给Application Master。僵死的任务也会被A

- 记一次数据推送的异常解决端口解决

ronin47

记一次数据推送的异常解决

需求:从db获取数据然后推送到B

程序开发完成,上jboss,刚开始报了很多错,逐一解决,可最后显示连接不到数据库。机房的同事说可以ping 通。

自已画了个图,逐一排除,把linux 防火墙 和 setenforce 设置最低。

service iptables stop

- 巧用视错觉-UI更有趣

brotherlamp

UIui视频ui教程ui自学ui资料

我们每个人在生活中都曾感受过视错觉(optical illusion)的魅力。

视错觉现象是双眼跟我们开的一个玩笑,而我们往往还心甘情愿地接受我们看到的假象。其实不止如此,视觉错现象的背后还有一个重要的科学原理——格式塔原理。

格式塔原理解释了人们如何以视觉方式感觉物体,以及图像的结构,视角,大小等要素是如何影响我们的视觉的。

在下面这篇文章中,我们首先会简单介绍一下格式塔原理中的基本概念,

- 线段树-poj1177-N个矩形求边长(离散化+扫描线)

bylijinnan

数据结构算法线段树

package com.ljn.base;

import java.util.Arrays;

import java.util.Comparator;

import java.util.Set;

import java.util.TreeSet;

/**

* POJ 1177 (线段树+离散化+扫描线),题目链接为http://poj.org/problem?id=1177

- HTTP协议详解

chicony

http协议

引言

- Scala设计模式

chenchao051

设计模式scala

Scala设计模式

我的话: 在国外网站上看到一篇文章,里面详细描述了很多设计模式,并且用Java及Scala两种语言描述,清晰的让我们看到各种常规的设计模式,在Scala中是如何在语言特性层面直接支持的。基于文章很nice,我利用今天的空闲时间将其翻译,希望大家能一起学习,讨论。翻译

- 安装mysql

daizj

mysql安装

安装mysql

(1)删除linux上已经安装的mysql相关库信息。rpm -e xxxxxxx --nodeps (强制删除)

执行命令rpm -qa |grep mysql 检查是否删除干净

(2)执行命令 rpm -i MySQL-server-5.5.31-2.el

- HTTP状态码大全

dcj3sjt126com

http状态码

完整的 HTTP 1.1规范说明书来自于RFC 2616,你可以在http://www.talentdigger.cn/home/link.php?url=d3d3LnJmYy1lZGl0b3Iub3JnLw%3D%3D在线查阅。HTTP 1.1的状态码被标记为新特性,因为许多浏览器只支持 HTTP 1.0。你应只把状态码发送给支持 HTTP 1.1的客户端,支持协议版本可以通过调用request

- asihttprequest上传图片

dcj3sjt126com

ASIHTTPRequest

NSURL *url =@"yourURL";

ASIFormDataRequest*currentRequest =[ASIFormDataRequest requestWithURL:url];

[currentRequest setPostFormat:ASIMultipartFormDataPostFormat];[currentRequest se

- C语言中,关键字static的作用

e200702084

C++cC#

在C语言中,关键字static有三个明显的作用:

1)在函数体,局部的static变量。生存期为程序的整个生命周期,(它存活多长时间);作用域却在函数体内(它在什么地方能被访问(空间))。

一个被声明为静态的变量在这一函数被调用过程中维持其值不变。因为它分配在静态存储区,函数调用结束后并不释放单元,但是在其它的作用域的无法访问。当再次调用这个函数时,这个局部的静态变量还存活,而且用在它的访

- win7/8使用curl

geeksun

win7

1. WIN7/8下要使用curl,需要下载curl-7.20.0-win64-ssl-sspi.zip和Win64OpenSSL_Light-1_0_2d.exe。 下载地址:

http://curl.haxx.se/download.html 请选择不带SSL的版本,否则还需要安装SSL的支持包 2. 可以给Windows增加c

- Creating a Shared Repository; Users Sharing The Repository

hongtoushizi

git

转载自:

http://www.gitguys.com/topics/creating-a-shared-repository-users-sharing-the-repository/ Commands discussed in this section:

git init –bare

git clone

git remote

git pull

git p

- Java实现字符串反转的8种或9种方法

Josh_Persistence

异或反转递归反转二分交换反转java字符串反转栈反转

注:对于第7种使用异或的方式来实现字符串的反转,如果不太看得明白的,可以参照另一篇博客:

http://josh-persistence.iteye.com/blog/2205768

/**

*

*/

package com.wsheng.aggregator.algorithm.string;

import java.util.Stack;

/**

- 代码实现任意容量倒水问题

home198979

PHP算法倒水

形象化设计模式实战 HELLO!架构 redis命令源码解析

倒水问题:有两个杯子,一个A升,一个B升,水有无限多,现要求利用这两杯子装C

- Druid datasource

zhb8015

druid

推荐大家使用数据库连接池 DruidDataSource. http://code.alibabatech.com/wiki/display/Druid/DruidDataSource DruidDataSource经过阿里巴巴数百个应用一年多生产环境运行验证,稳定可靠。 它最重要的特点是:监控、扩展和性能。 下载和Maven配置看这里: http

- 两种启动监听器ApplicationListener和ServletContextListener

spjich

javaspring框架

引言:有时候需要在项目初始化的时候进行一系列工作,比如初始化一个线程池,初始化配置文件,初始化缓存等等,这时候就需要用到启动监听器,下面分别介绍一下两种常用的项目启动监听器

ServletContextListener

特点: 依赖于sevlet容器,需要配置web.xml

使用方法:

public class StartListener implements

- JavaScript Rounding Methods of the Math object

何不笑

JavaScriptMath

The next group of methods has to do with rounding decimal values into integers. Three methods — Math.ceil(), Math.floor(), and Math.round() — handle rounding in differen