win10环境搭建OpenVINO Toolkit并编译运行例程----(1)openvino简介和win10环境搭建

OpenVINO™ toolkit简介

OpenVINO™工具包可快速部署模拟人类视觉的应用程序和解决方案。该工具包基于卷积神经网络(CNN),可在英特尔®硬件上扩展计算机视觉(CV)工作负载,从而最大限度地提高性能。OpenVINO™工具箱包括深度学习部署工具箱(DLDT)。

OpenVINO工具包:

- 在边缘启用基于CNN的深度学习推理

- 支持跨英特尔®CPU,英特尔®集成显卡,英特尔®FPGA,英特尔®Movidius™神经计算棒,英特尔®神经计算棒2和具有英特尔®Movidius™VPU的英特尔®视觉加速器设计的异构执行-

- 通过易于使用的计算机视觉功能库和预先优化的内核加快上市时间 包括对计算机视觉标准(包括OpenCV *,OpenCL™和OpenVX *)的优化调用

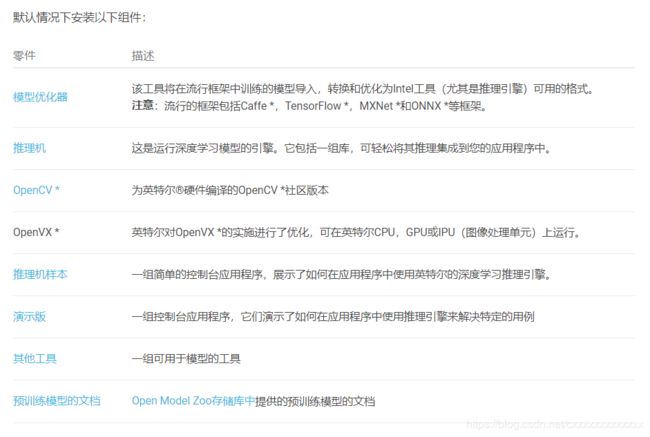

OpenVINO包括以下组件:

-

深度学习部署工具包(DLDT)

- 深度学习模型优化器

-一种跨平台的命令行工具,用于导入模型并为通过推理引擎进行最佳执行做准备。Model Optimizer导入,转换和优化模型,这些模型在流行的框架(例如Caffe ,TensorFlow ,MXNet,Kaldi和ONNX *)中进行了培训。 - 深度学习推理引擎

-统一的API,可对多种硬件类型进行高性能推理,包括英特尔®CPU,英特尔®集成显卡,英特尔®Movidius™神经计算棒,英特尔®神经计算棒2和采用英特尔®的英特尔®视觉加速器设计Movidius™VPU - 示例

-一组简单的控制台应用程序,展示了如何在应用程序中使用推理引擎 - 工具

-一组用于模型的简单控制台工具

- 深度学习模型优化器

-

Open Model Zoo开放式动物园

- 演示 -控制台应用程序,演示如何在应用程序中使用推理引擎来解决特定用例

- 工具 -用于下载模型和检查准确性的其他工具

- 预训练模型的文档-Open Model Zoo存储库中提供的预训练模型的文档

-

OpenCV-为英特尔®硬件编译的OpenCV *社区版本

-

OpenCL™2.1版的驱动程序和运行时

-

英特尔®媒体SDK

-

OpenVX * -为实现在Intel®硬件(CPU,GPU,IPU)上运行而优化的Intel OpenVX *实现。

文档集内容

OpenVINO™工具包文档集包括以下文档:

- 安装适用于Linux *的英特尔®OpenVINO™工具包发行版

- 安装具有FPGA支持的Linux版英特尔®OpenVINO™工具包

- 安装适用于Windows *的英特尔®OpenVINO™工具包发行版

- 安装适用于macOS *的英特尔®OpenVINO™工具包发行版

- 安装面向Raspbian 的英特尔®OpenVINO™工具包发行版

- 深度学习部署工具包简介

- 模型优化器开发人员指南

- 推理引擎开发人员指南

- 演示和样本

- 工具类

- 预训练模型

- 已知的问题

- 法律信息

windows*10 安装 OpenVINO™ toolkit介绍

源文档link

Windows * 10 OS的英特尔®OpenVINO™工具包特点:

- 在边缘启用基于CNN的深度学习推理

- 支持跨英特尔®CPU,英特尔®处理器图形(GPU),英特尔®Movidius™神经计算棒,英特尔®神经计算棒2和具有英特尔®Movidius™VPU的英特尔®视觉加速器设计的异构执行

- 通过易于使用的计算机视觉功能库和预先优化的内核加快上市时间

- 包括针对计算机视觉标准(包括OpenCV *,OpenCL™和OpenVX *)的优化调用

- 安装 英特尔®OpenVINO™工具包核心组件的分发

- 安装依赖项:

- 带有Visual Studio *的Microsoft Visual Studio * 2019、2017 或2015

- CMake 3.4或更高版本的 64位

注意:如果要使用Microsoft Visual Studio 2019,则需要安装CMake 3.14。 - Python 3.6.5 64位

重要说明:作为此安装的一部分,请确保单击选项以将应用程序添加到PATH环境变量中。

- 设置环境变量

- 配置模型优化器

- 运行两个验证脚本以验证安装

- 可选的:

- 安装Windows *版英特尔®图形驱动程序

- 使用英特尔®Movidius™VPU安装用于英特尔®视觉加速器设计的驱动程序和软件

- 更新Windows *环境变量

Windows *安装仅支持采用英特尔®Movidius™VPU选项的英特尔®CPU,英特尔®处理器图形,英特尔®Movidius™神经计算棒,英特尔®神经计算棒2和英特尔®视觉加速器设计。使用FPGA需要Linux *。

windows*10 安装 OpenVINO™ toolkit步骤

注意:在以下步骤中:

如果要从安装的其他版本的OpenVINO™工具包的英特尔®发行版中使用模型优化器,请替换openvino为openvino_。

如果将英特尔®OpenVINO™分发工具包安装到非默认安装目录,请替换C:\Program Files (x86)\IntelSWTools为安装软件的目录。

安装OpenVINO™工具箱核心组件的英特尔®发行版

- 下载link

会要求注册,注册后下载所选版本。(个人不建议下载最新版, 但Intel的开发测试还是很完善的,酌情自选吧)

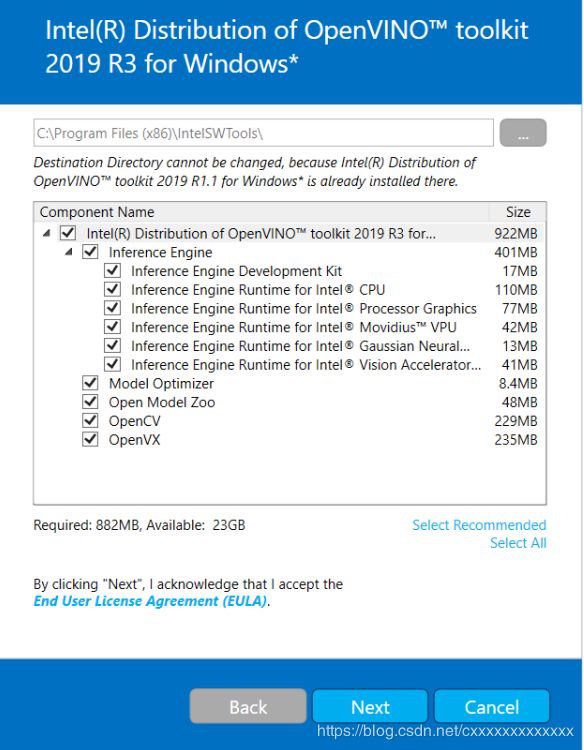

默认下载目录:\Donloads - 双击w_openvino_toolkit_p_.exe。将打开一个窗口,让您选择安装目录和组件。C:\Program Files (x86)\IntelSWTools\openvino_为简便起见,默认的安装目录是,它还会创建一个指向最新安装的快捷方式:C:\Program Files (x86)\IntelSWTools\openvino。如果选择其他安装目录,则安装程序将为您创建目录:

我选择默认安装路径,避免后期环境变量变更引起的其他问题。

因为要进行模型优化和运行所以组件全部安装。 - 单击下一步。

- 询问您是否要同意收集信息。选择您所选择的选项。单击下一步。

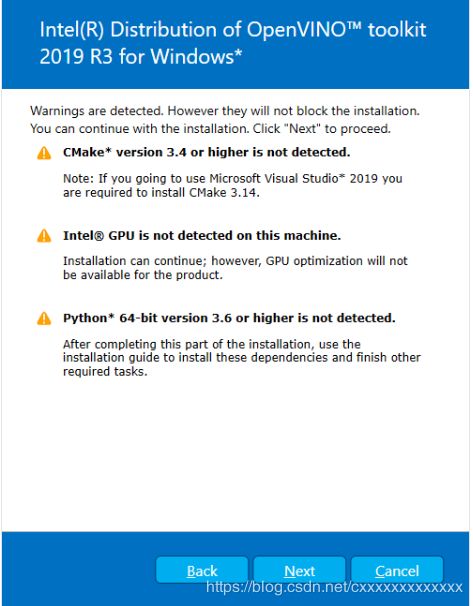

如果缺少外部依赖项,则会看到警告屏幕。写下您缺少的依赖项。您此时无需采取其他任何措施。在安装英特尔®OpenVINO™工具包核心组件发行版之后,请安装缺少的依赖项。下面的屏幕示例表明您缺少两个依赖项:

根据提示缺少的依赖项进行安装或者环境变量的添加。 - 单击下一步。

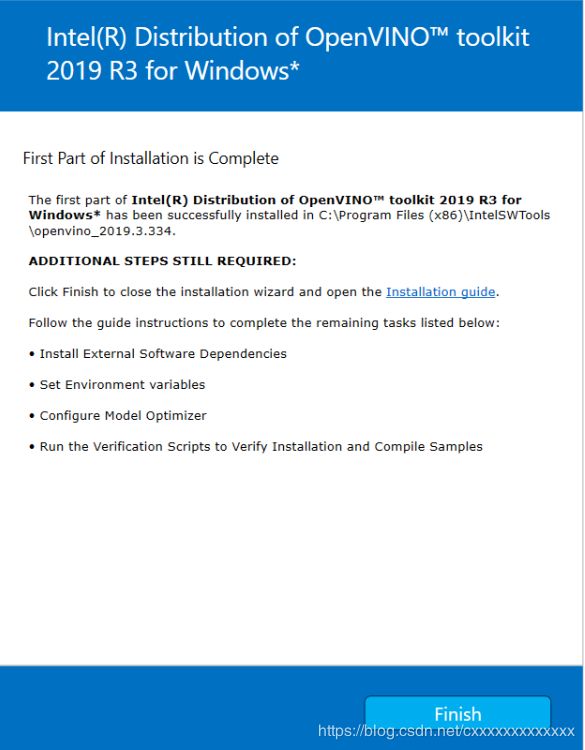

- 当安装的第一部分完成时,最后一个屏幕将通知您已经安装了核心组件,并且仍然需要执行其他步骤:

- 单击完成以关闭安装向导。一个新的浏览器窗口将打开到安装指南的下一部分,以设置环境变量。您在同一文档中。如果您在未先打开本安装指南的情况下运行安装,则会打开新窗口。

- 如果安装指示您必须安装依赖项,请先安装它们。如果没有缺少的依赖项,则可以继续设置环境变量。

设置环境变量

您必须先更新几个环境变量,然后才能编译和运行OpenVINO™应用程序。打开命令提示符,然后运行setupvars.bat批处理文件以临时设置环境变量:

cd C:\ Program Files(x86)\ IntelSWTools \ openvino \ bin \

setupvars.bat

设置环境变量

重要说明:这些步骤是必需的。您必须为至少一个框架配置模型优化器。如果您不完成本节中的步骤,则Model Optimizer将失败。

模型优化器是英特尔®OpenVINO™工具包分发的关键组件。如果不通过Model Optimizer运行模型,则无法对训练后的模型进行推断。当您通过模型优化器运行预训练的模型时,您的输出是网络的中间表示(IR)。IR是一对描述整个模型的文件:

- .xml:描述网络拓扑

- .bin:包含权重并偏置二进制数据

推理引擎使用跨CPU,GPU或VPU硬件的通用API读取,加载和推断IR文件。

Model Optimizer是基于Python *的命令行工具(mo.py),位于中C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\model_optimizer。**在经过流行的深度学习框架(例如Caffe *,TensorFlow *,MXNet 和ONNX )训练的模型上使用此工具可将它们转换为推理引擎可以使用的优化IR格式。

选项1:同时为所有受支持的框架配置模型优化器:

- 打开命令提示符。为此,请cmd在“ 搜索窗口”框中键入内容,然后按Enter。在打开的窗口中键入命令,转到“模型优化器”先决条件目录。

cd C:\ Program Files(x86)\ IntelSWTools \ openvino \ deployment_tools \ model_optimizer \ install_prerequisites

2.运行以下批处理文件以为Caffe *,TensorFlow *,MXNet *,Kaldi *和ONNX *配置模型优化器:

install_prerequisites.bat

选项2:分别为每个框架配置模型优化器:

- 转到模型优化器先决条件目录:

cd C:\ Program Files(x86)\ IntelSWTools \ openvino \ deployment_tools \ model_optimizer \ install_prerequisites

- 运行将与Model Optimizer一起使用的框架的批处理文件。您可以使用多个:

// 对于Caffe:

install_prerequisites_caffe.bat

// 对于TensorFlow:

install_prerequisites_tf.bat

// 对于MXNet:

install_prerequisites_mxnet.bat

// 对于ONNX:

install_prerequisites_onnx.bat

// 对于Kaldi:

install_prerequisites_kaldi.bat

针对一个或多个框架配置了模型优化器。类似于以下屏幕显示成功:

设置环境变量

要验证安装并编译两个样本,请在CPU上运行产品随附的验证应用程序:

- 打开命令提示符窗口。

- 转到推理引擎演示目录:

cd C:\ Program Files(x86)\ IntelSWTools \ openvino \ deployment_tools \ demo \

- 按照下一节中的说明运行验证脚本。

运行图像分类验证脚本

要运行脚本,请启动demo_squeezenet_download_convert_run.bat文件:

demo_squeezenet_download_convert_run.bat

该脚本下载一个SqueezeNet模型,使用模型优化器将模型转换为 .bin 和 .xml 中间表示(IR)文件。推理引擎需要此模型转换,因此它可以将IR用作输入并在Intel硬件上实现最佳性能。

该验证脚本将构建“ 图像分类示例异步”应用程序,并与car.png 演示目录中的图像一起运行 。有关中间表示形式的简要说明,请参阅《配置模型优化器》。

验证脚本完成后,您将获得前十名类别的标签和置信度:

该演示已完成。将控制台保持打开状态,然后继续下一部分以运行推理管道演示。

运行推理管道验证脚本

要运行脚本,请demo_security_barrier_camera.bat在仍在控制台中的情况下启动文件:

demo_security_barrier_camera.bat

该脚本下载了三个经过预先训练的模型IR,构建了 Security Barrier Camera Demo 应用程序,并与下载的模型和目录中的car_1.bmp 图像一起运行它, demo以显示推理管道。验证脚本使用车辆识别,其中车辆属性彼此建立,以缩小特定属性的范围。

首先,将物体识别为车辆。此标识用作下一个模型的输入,该模型标识特定的车辆属性,包括车牌。最后,将识别为车牌的属性用作第三种模型的输入,该模型可以识别车牌中的特定字符。

演示完成后,您将打开两个窗口:

关闭图像查看器窗口以结束演示。

要了解有关验证脚本的更多信息,请参阅README.txt中的C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo。

可选步骤

如果在win电脑上运行例程或者进行开发 则需要进一步配置环境:

在此我只简要介绍我的选择步骤。(具体link)

- 确认显示器适配器驱动程序版本。确保版本号为15.65或更高。

- 更新Windows环境变量

运行图像分类示例应用程序

环境初始化

分别通过命令行运行下面两句 初始化openVINO环境

cd C:\Program Files (x86)\IntelSWTools\openvino\bin\

setupvars.bat

编译demo(sample同理)

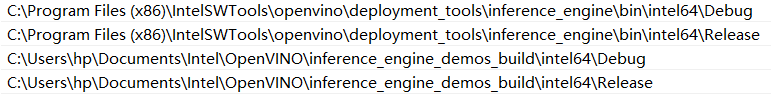

自动生成的demo路径如下:

C:\Users\hp\Documents\Intel\OpenVINO\inference_engine_demos_build

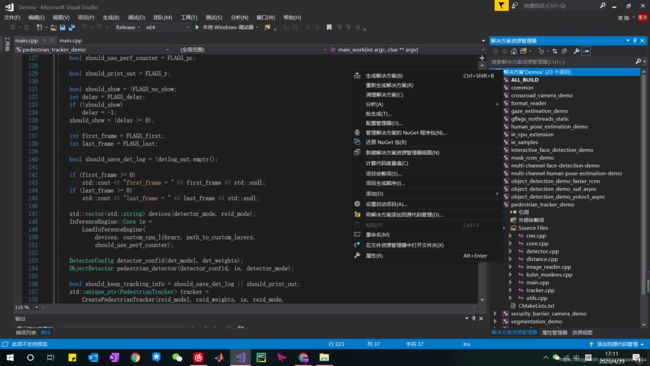

在该目录下找到Demos.sln文件 使用Visual studio打开结果如下:

在解决方案处右键选择“生成”分别得到debug和release版即在对应目录得到封装好的lib和exe文件:

环境变量添加

详细视频步骤参考link

建立神经网络模型

如果您在基于VPU的设备以外的硬件上运行推理,则您已经将必需的FP32神经网络模型转换为优化的中间表示(IR)。请按照“ 运行示例应用程序”部分中的步骤运行示例。

如果您要在VPU设备(英特尔®Movidius™神经计算棒,英特尔®神经计算棒2或具有英特尔®Movidius™VPU的英特尔®视觉加速器设计)上进行推理,则需要该模型的FP16版本,您将在本段中进行设置。

要将FP32模型转换为适用于基于VPU的硬件加速器的FP16 IR,请执行以下步骤:

- 例如,为FP16 SqueezeNet模型创建目录, C:\Users

\Documents\squeezenet1.1_FP16 - 打开命令提示符并运行模型优化器,以将安装随附的FP32 Squeezenet Caffe *模型转换为优化的FP16中间表示(IR):

python3“ C:\ Program Files(x86)\ IntelSWTools \ openvino \ deployment_tools \ model_optimizer \ mo.py” --input_model“ C:\ Users <username> \ Documents \ Intel \ OpenVINO \ openvino_models \ models \ FP32 \ classification \ squeezenet \ 1.1 \ caffe \ squeezenet1.1.caffemodel“ --data_type FP16 --output_dir” C:\ Users <用户名> \ Documents \ squeezenet1.1_FP16“

- 该squeezenet1.1.labels文件包含ImageNet使用的类。包含此文件,以便推断结果显示文本而不是分类号。复制squeezenet1.1.labels到优化的模型位置:

copy "C:\Users\Documents\Intel\OpenVINO\openvino_models\ir\FP32\classification\squeezenet\1.1\caffe\squeezenet1.1.labels" "C:\Users\Documents\squeezenet1.1_FP16"

现在,您的神经网络设置已经完成,您可以运行示例应用程序了。

运行示例应用程序

在本段中,您将运行图像分类示例应用程序,该示例应用程序是在您运行图像分类验证脚本时自动构建的。要运行示例应用程序:

- 转到示例构建目录:

cd C:\Users<username>\Documents\Intel\OpenVINO\inference_engine_samples_build\intel64\Release

car.png通过将demo目录中的文件指定为输入图像,FP16模型的IR和用于执行推理的硬件设备的插件来运行示例可执行文件。

注:在CPU 以外的硬件上运行示例应用程序需要执行其他硬件配置步骤。

// For CPU:

classification_sample_async.exe -i "C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\car.png" -m "C:\Users\Documents\squeezenet1.1_FP16\squeezenet1.1.xml" -d CPU

// For GPU:

classification_sample_async.exe -i "C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\car.png" -m "C:\Users\Documents\squeezenet1.1_FP16\squeezenet1.1.xml" -d GPU

// For VPU (Intel® Movidius™ Neural Compute Stick and Intel® Neural Compute Stick 2):

classification_sample_async.exe -i "C:\Program Files (x86)\IntelSWTools\openvino\deployment_tools\demo\car.png" -m "C:\Users\Documents\squeezenet1.1_FP16\squeezenet1.1.xml" -d MYRIAD

// For VPU (Intel® Vision Accelerator Design with Intel® Movidius™ VPUs):

classification_sample_async.exe -i "C:\Program Files (x86)\IntelSWTools\openvino\d

有关示例应用程序的信息,请参阅推理引擎示例概述。

至此介绍了openVINO tookit的功能简介、环境要求

在windows10下的安装和环境配置

安装成功测试例程

官方例程的编译和使用

下一篇文章我将具体举例怎样运行官方例程