章国锋:视觉SLAM最新观点分享

![]()

6月20日,图图Seminar学术直播邀请国内视觉SLAM领域首屈一指的专家:浙江大学章国锋教授,带来了题为“视觉SLAM在AR应用上的关键性问题探讨”的精彩直播报告。

直播精彩看点

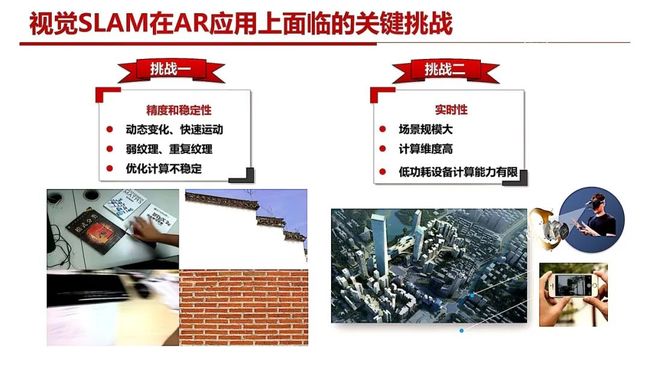

视觉SLAM应用中关键技术难题的解决思路

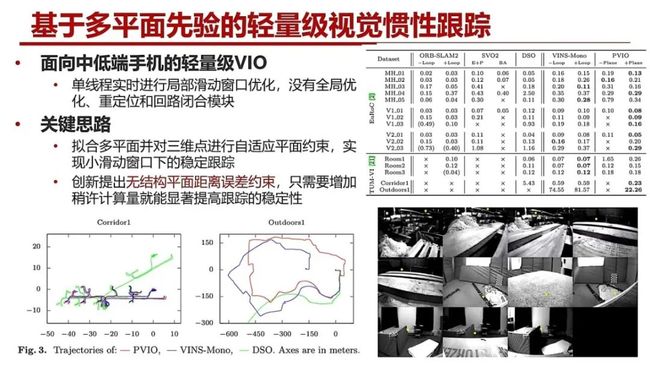

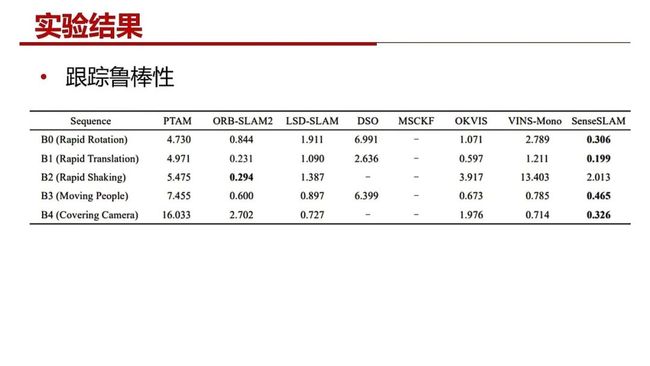

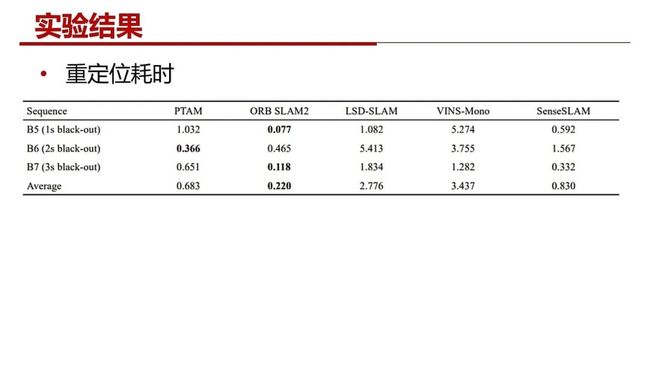

思路1:提升稳定性

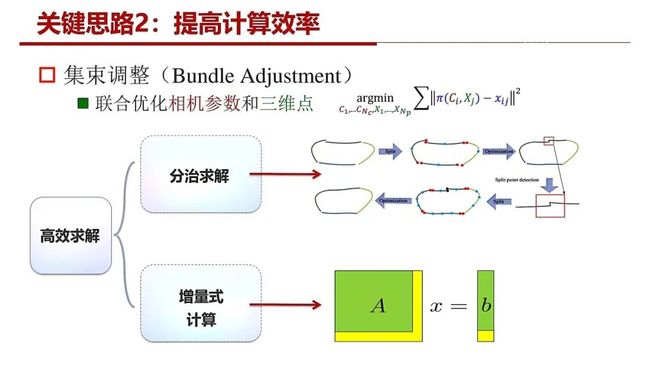

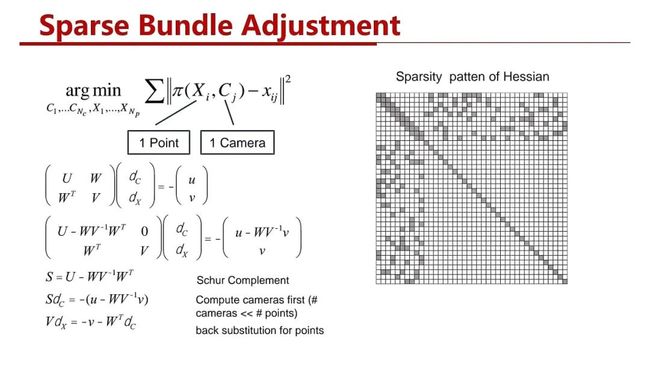

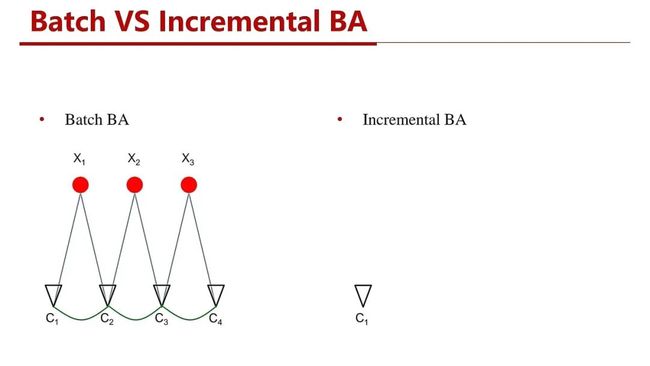

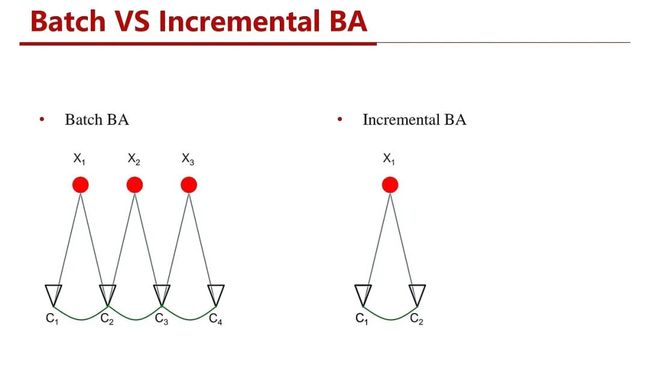

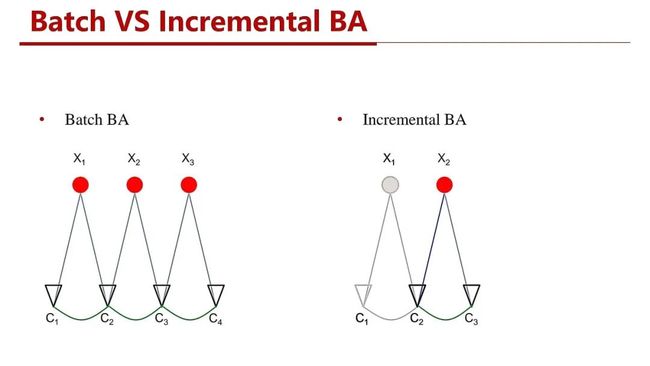

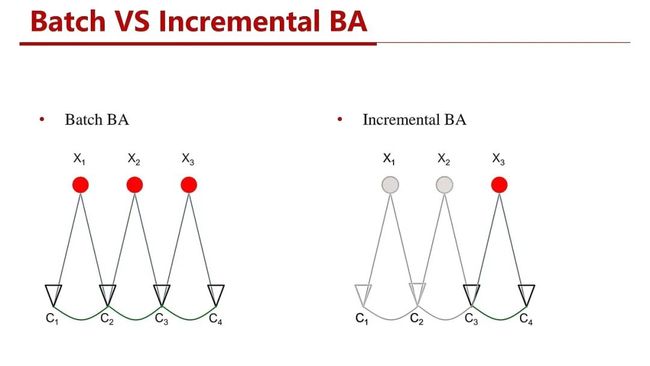

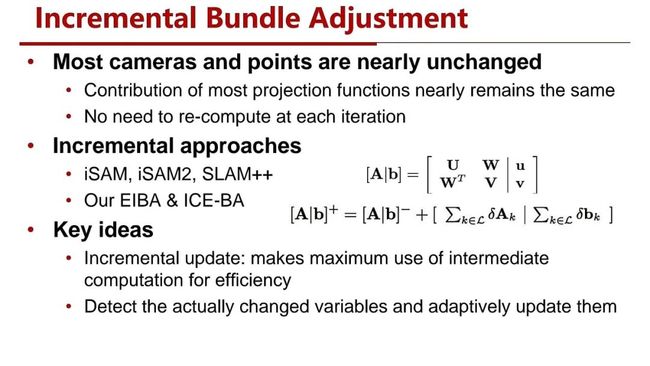

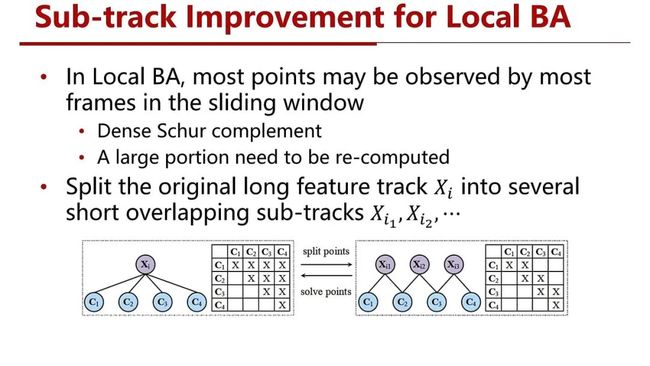

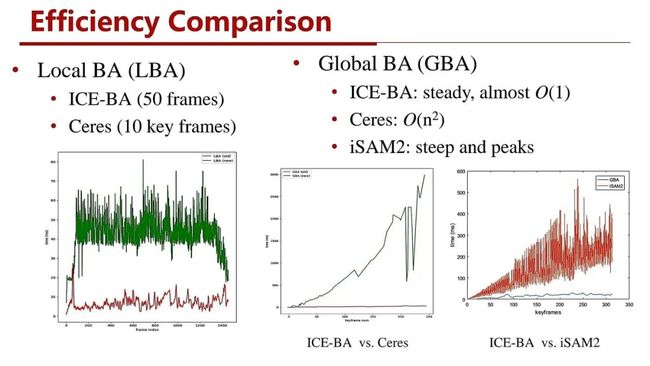

思路2:提高计算效率

思路3:云-端协同

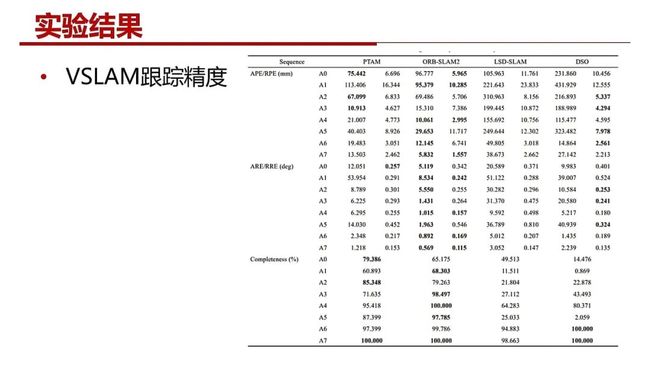

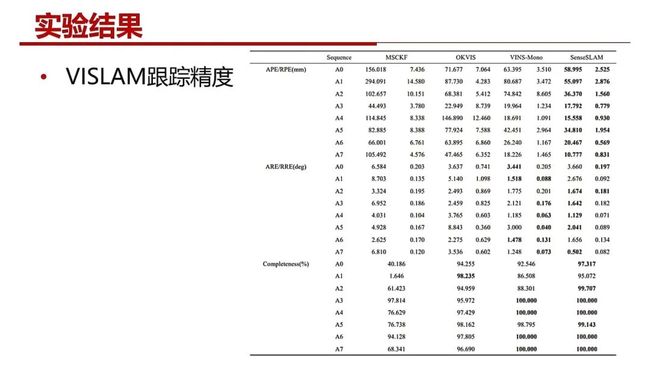

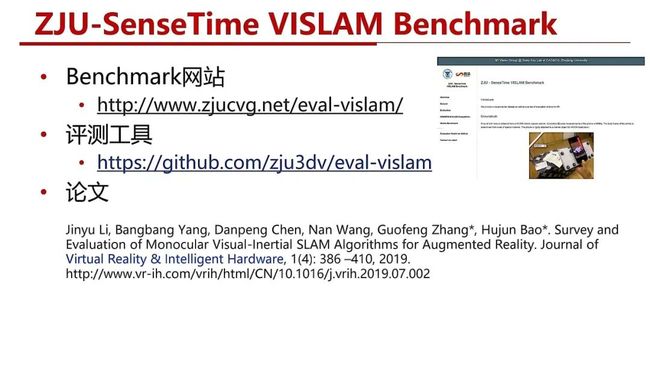

常用VSLAM/VISLAM系统对比分析及开源链接

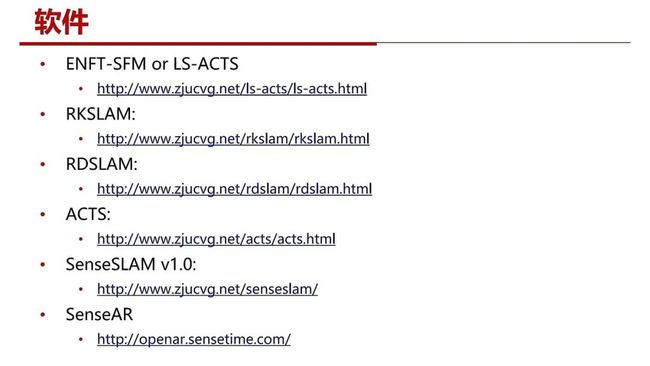

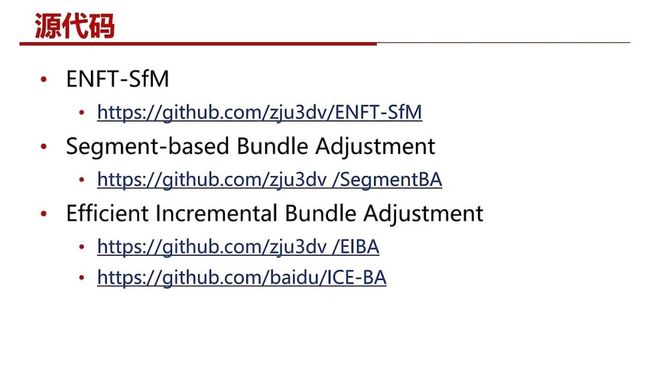

SLAM相关软件、系统、算法的开源地址

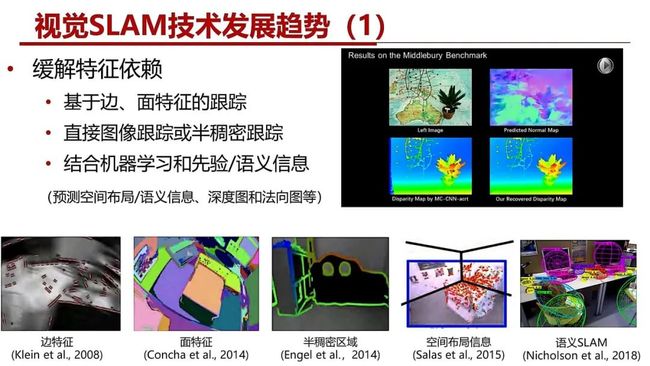

展望未来视觉SLAM技术的发展趋势

缓解特征依赖

多传感器融合

稠密三维重建

章教授与特邀观众及现场观众的互动答疑

1

直播回放

【中国知网回放地址】

http://k.cnki.net/CInfo/Index/6370

【B站回放地址】

https://www.bilibili.com/video/BV1eK411n7aa

2

报告PPT

3

补充问答

Q1:请问室内三维语义地图构建有没有好的开源?

A:目前已经有不少三维重建、语义分割和物体建模的开源工作,但三维语义地图构建的开源工作还很少,目前看到有一个基于RGBD的语义建图的工作SemanticFusion: https://github.com/seaun163/semanticfusion

另外,可以参考以下两篇知乎的文章,整理得比较全面:

https://zhuanlan.zhihu.com/p/141946874

https://zhuanlan.zhihu.com/p/60954106

Q2:请问老师,语义SLAM有推荐的资料吗?

A:推荐几个比较经典的语义SLAM工作:SemanticFusion,SLAM++,VSO,DS-SLAM,DynaSLAM。另外,推荐知乎上这篇关于语义SLAM论文笔记整理:

https://zhuanlan.zhihu.com/p/56805175

Q3:请问,没有纹理的地图数据,例如LOD模型, LOD(白膜)与照片匹配定位,有什么指导建议吗?

A:建议采用线段或基于轮廓匹配的方法。采用深度学习的方法应该也是一个可行的思路。

Q4:请问可以用FPGA对SLAM进行后端优化么?

A:个人认为应该是可以用FPGA至少做一部分的后端优化。已经有工作用FPGA实现Bundle Adjustment:Shuzhen Qin, Qiang Liu, Bo Yu, Shaoshan Liu. π-BA: Bundle Adjustment Acceleration on Embedded FPGAs with Co-observation Optimization. FCCM 2019: 100-108.

Q5:请问除了ORB还有其他在移动端实用的算子吗?

A:特征点算法包括特征点提取和描述子。在移动端常用的特征点提取方法是FAST、Freak和Harris角点,好像也有将DoG(Difference of Gaussian,就是SIFT用的特征点检测方法)方法应用在移动端上,但是一般需要芯片加速。描述子现在在移动端上比较实用的还是ORB, Brisk。现在也有不少基于深度学习的特征提取和描述子,但应用在移动端SLAM上好像还没有看到。

Q6:老师,请问 ORB_SLAM +IMU怎么融合?

A:可以看ORB-SLAM作者写的这篇文章:R. Mur-Artal and J. D. Tardos, “Visual-inertial monocular SLAM with map reuse,” IEEE Robotics and Automation Letters, vol. 2, no. 2, pp. 796–803, 2017.

Q7:请问您在直播中讲的这些方法可以被用于内窥镜的SLAM追踪及场景重建吗?

A:我没有试过不是很好说,但感觉纯粹靠视觉难度比较大,最好是结合深度传感器,即RGB-D SLAM。

Q8:老师好,请教下VO\VIO与GPS组合,有什么比较好的方法?

A:由于消费级的GPS的噪声比较大,而且往往不是高斯噪声,一般采用跟VO/VIO松耦合的方式。推荐以下2篇文章:

[1] Simon Lynen, Markus W. Achtelik, Stephan Weiss, Margarita Chli, Roland Siegwart. A robust and modular multi-sensor fusion approach applied to MAV navigation. IROS 2013: 3923-3929.

[2] Tong Qin, Shaozu Cao, Jie Pan, Shaojie Shen. A General Optimization-based Framework for Global Pose Estimation with Multiple Sensors. CoRR abs/1901.03642 (2019).

Q9:请问VSLAM、VO、SfM区别是什么?您有构造自己数据集吗?

A:VSLAM是要求实时或在线的;SfM可以分为实时和离线两种,实时的SfM其实就是VSLAM。VO,即视觉里程计,它是VSLAM的前端跟踪部分,一般没有后端优化和回路闭合。

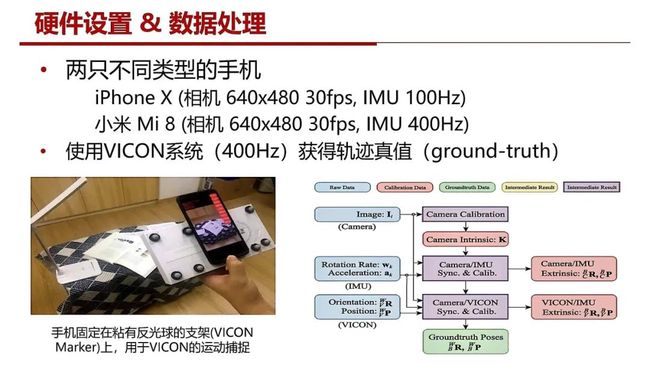

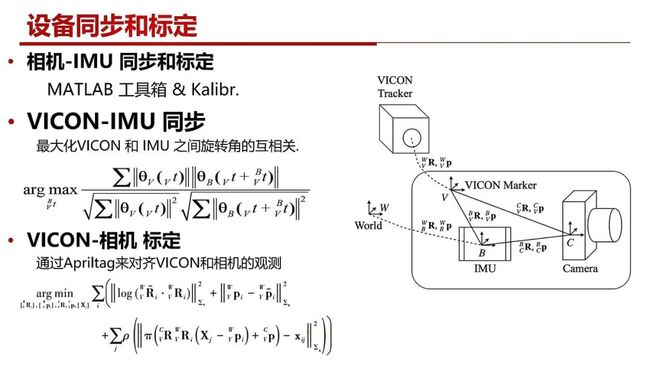

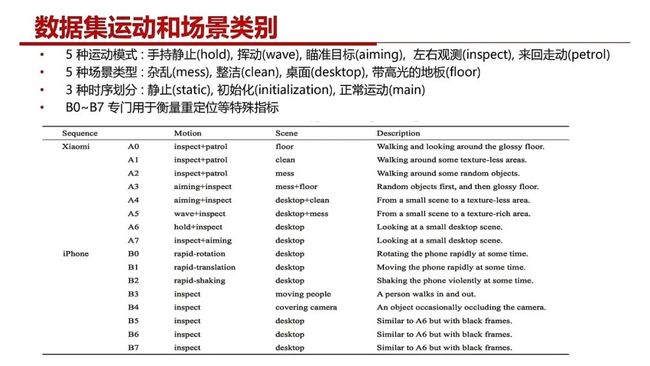

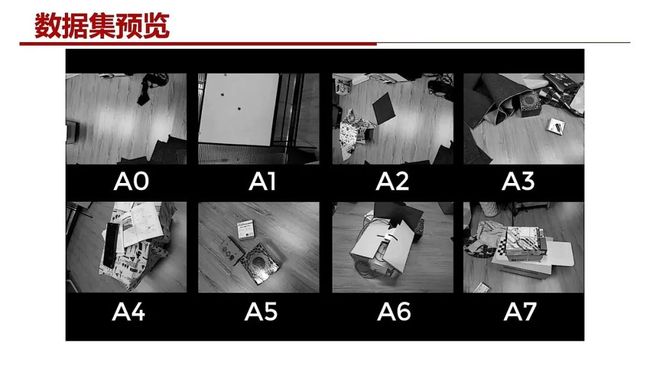

我们针对AR应用构建了一个VSLAM/VISLAM数据集和benchmark:http://www.zjucvg.net/eval-vislam/

4

主讲嘉宾

章国锋 教授

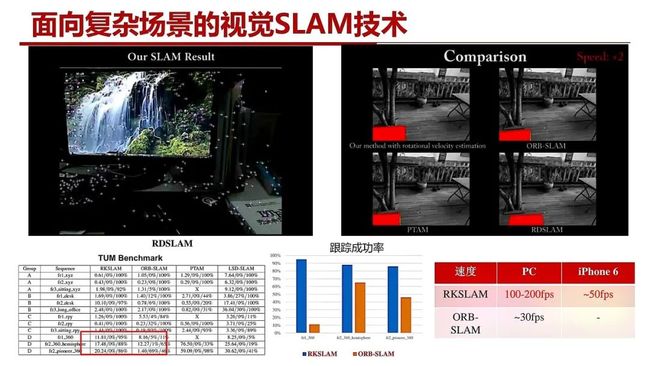

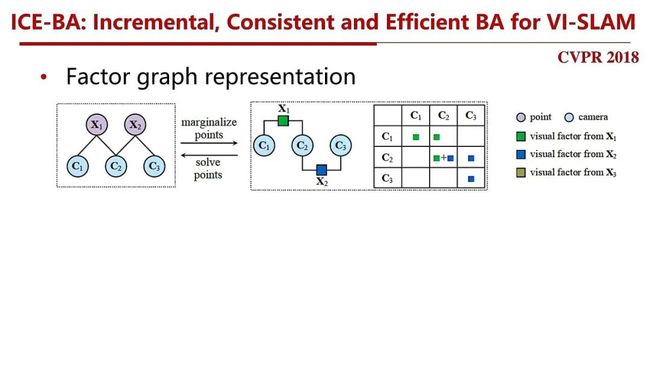

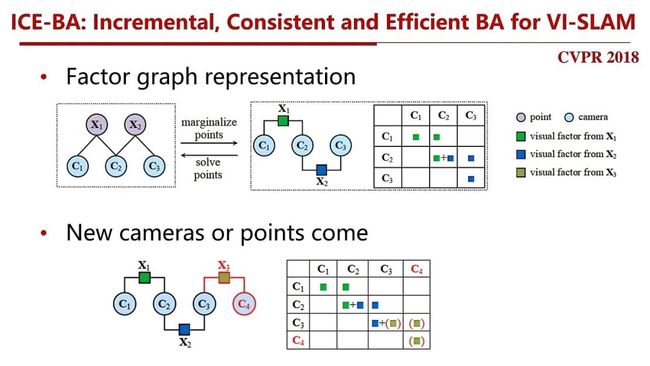

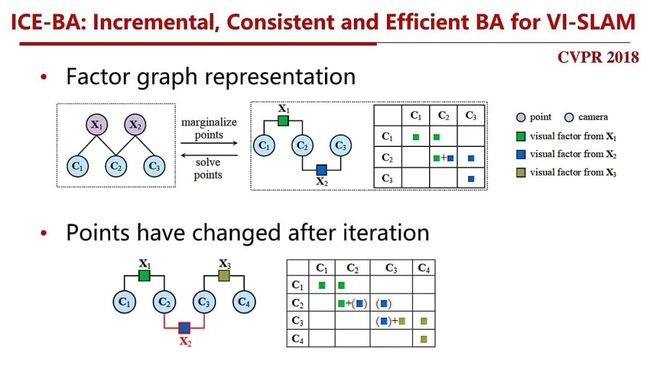

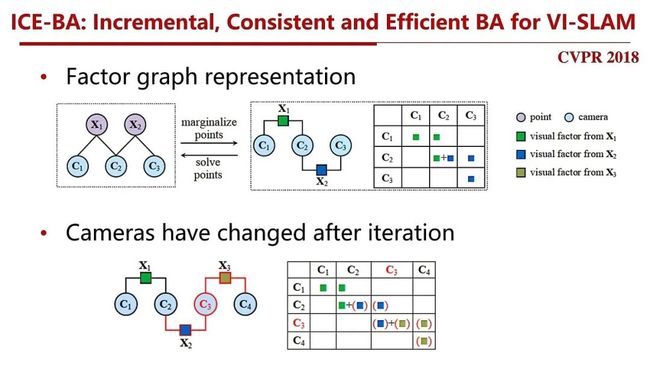

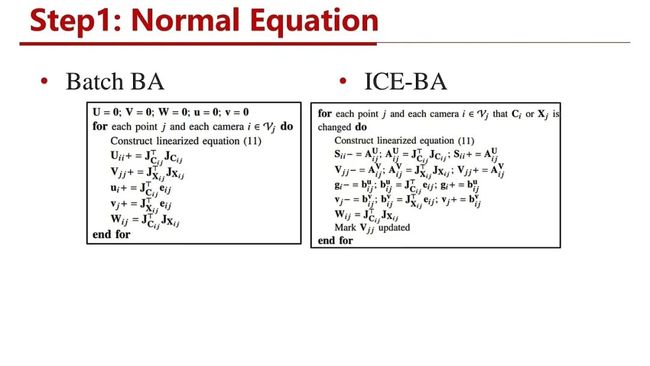

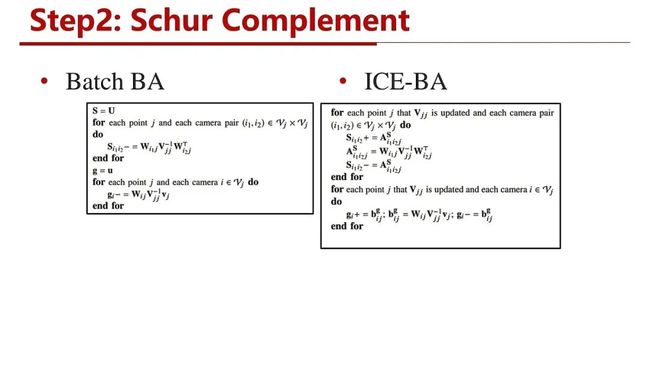

浙江大学计算机科学与技术学院,博士生导师,国家优秀青年科学基金获得者。主要从事三维视觉与增强现实方面的研究,尤其在同时定位与地图构建(SLAM)和三维重建方面取得了一系列重要成果,研制了一系列相关软件,如 ACTS、LS-ACTS、RDSLAM、RKSLAM等(http://www.zjucvg.net),并开源了基于非连续特征跟踪的大尺度运动恢复结构系统 ENFT-SfM、分段集束调整SegmentBA 和高效的增量式集束调整 EIBA、ICE-BA 等算法的源代码(https://github.com/zju3dv/)。获全国百篇优秀博士学位论文奖、计算机学会优秀博士学位论文奖以及教育部高等学校科学研究优秀成果奖科学技术进步奖一等奖(排名第四)。

编辑:韩小荷

指导:梧桐君

审校:夏薇薇

总编辑:肖 亮

![]()

备注:slam

![]()

SLAM交流群

SLAM、增强现实(AR)、机器人等最新技术,

若已为CV君其他账号好友请直接私信。

我爱计算机视觉

微信号:aicvml

QQ群:805388940

微博知乎:@我爱计算机视觉

网站:www.52cv.net

![]()

在看,让更多人看到 ![]()