自动驾驶汽车:实现实时交通信号灯检测和分类

今天,基本的交通灯信号灯检测问题已经得到解决。深度学习和计算机视觉的创新以强健的算法的形式存在。实现实时交通信号灯检测和分类。

它们在没有开发代码的情况下工作,手动确定颜色或交通信号灯的位置。例如,优化的R-CNN(https://arxiv.org/abs/1506.01497)模型能够以实时的速度获得最先进的精度。

那么它是如何工作的呢?

交通信号灯在哪里?

Google的一个团队使用提取检测到的交通信号灯的方法,然后在该方法上运行第二个分类器。这种方法(https://static.googleusercontent.com/media/research.google.com/en//pubs/archive/37259.pdf)提供了灵活性;然而,根据实现的不同,它可能会增加管道复杂度和计算成本。

更重要的是,它似乎依赖于对预期交通信号灯位置的先验信息。一般来说,将分类作为第二步添加第二个网络进行培训、测试等等。

在只有一个图像,没有先验信息的情况下,是否可以在一个神经网络中完成任务?

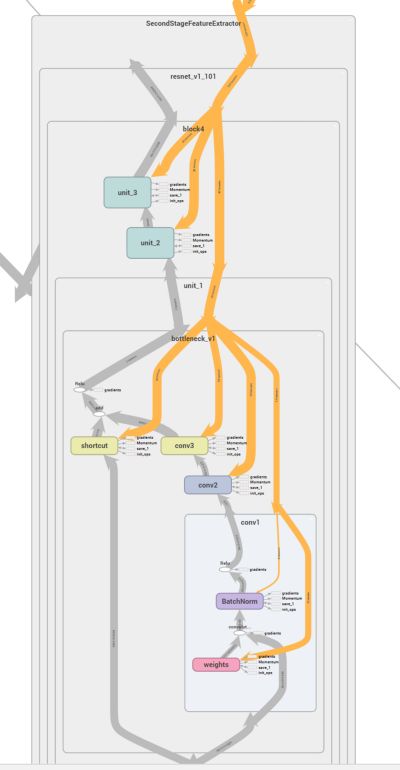

我开始先使用了单镜头检测(SSD),最后使用了Faster R-CNN,因为它对较小的对象具有较好的性能。我费力地重建了现有的实现,以自学它是如何工作的。

然后切换到使用开放源码的tensorflow对象检测api。这个最近发布的工具集(https://github.com/tensorflow/models)为测试模型提供了更快的周转时间,并准备好了预先训练的权重。它允许我更多地关注工程的实现,并且很少涉及每个神经网络实现的细节。

在该论文(https://arxiv.org/abs/1611.10012)中,他们讨论了不同方法的性能权衡。例如,SSD(类似于YOLO)对于中型到大型对象来说很好,但是对于小型对象来说,它比Faster R-CNN更糟糕。在实践中我们很难让SSD在Bosch的小交通信号灯数据集(https://hci.iwr.uni-heidelberg.de/node/6132)上收敛。相反,包含Resnet的Faster R-CNN能得到良好的结果。

想看到更多吗?查看完整的视频:测试视频(https://youtu.be/5e_9r9DROEY)或训练视频(https://youtu.be/EN2jZ-9LRjs)。

为Udacity自动驾驶汽车调整Bosch数据

我们一直在做一个关于自动驾驶汽车的有限测试。在一个很小的封闭轨道上,汽车必须成功地遵循一组路标并识别交通信号灯。

如果你对技术细节感兴趣,请查看代码(https://github.com/nhiddink/SDCND_Capstone_TEC)。

双转移学习

由于可用的数据量有限,我们严重依赖转移学习,我们可以使用以下数据集:

- COCO(http://cocodataset.org/#home)预先训练网络

- Bosch交通信号灯数据

- Udacity真实数据(150个样本)或sim数据(260个样本)

为什么要使用深度学习?

交通信号灯有不同的数量、位置、形状、大小和布局。这些差异通过深度学习是容易解决的——只收集在汽车行驶区域的交通信号灯类型的例子。

高精度定位的动机

高精度的边界框允许高精度距离估计。距离估计的越准确,我们就越接近其他数据点。看下面的图片,交通信号灯在十字路口附近或远侧?

实时性能(10 + Hz)

起初,我们需要大约220ms的推理时间,与滑动窗口的方法相比较,这是一个更快速的方法,我个人认为3 – 4帧每秒不是实时的。

根据论文的建议,我们将该区域建议数量从原来的300个减少到50个。

在推理时间里(~220 ms 到~80 ms),给了我们一个具有类似精度的~3x的速度。

预测在1280×720图像中不到1%的交通信号灯。例如,在上述谷歌的论文中,他们使用了2040×1080或2.3x像素的图像。

失败案例

有许多系统还没有准备好用于生产的示例。举个例子,在下面的图片中的灯光被认为是黄色的。

在拥有更多数据或者更多培训的情况下,很多这样的案例可以被解决。例如,我们训练了大约2万次迭代,这大概是真正收敛(最优模型的权重值)需要的1 / 10。

最后一步

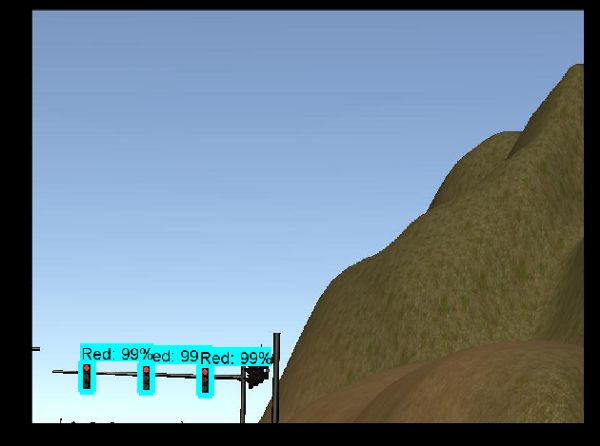

在测试过程中,我意外地在真实图像上运行了模拟图像的网络。

某种程度上来说,它可以工作,而且运行得很好。

看看下面这个例子的结果:

- 第一张:Bosch训练(不同风格的图像)=没有超过50%confidence的预测

- 第二张:Sim训练(上面的图片)=正确预测

- 第三张:真实的数据训练(bosch数据之后)=错误预测

这是一件有趣的事情。从理论上讲,你可以模拟任何你想要的情况,把它提供给一个深度学习系统,然后将其通用化到现实生活中的情况。

深度学习代码:https://github.com/swirlingsand/deeper-traffic-lights

自动驾驶汽车代码:https://github.com/nhiddink/SDCND_Capstone_TEC

测试视频:https://youtu.be/5e_9r9DROEY

训练视频:https://youtu.be/EN2jZ-9LRjs

本文转自ATYUN人工智能媒体平台,原文链接:自动驾驶汽车:实现实时交通信号灯检测和分类

更多推荐

研究报告指出在AI方面中国有望超过美国

学习K-Means算法:基于聚类的无监督机器学习算法

logistic回归的详细概述

AI通过语言体裁的元数据揭示古希腊文本意义的演变

Facebook推出新的AI技术,可检测到有关色情报复的图像和视频内容