- 为什么你总是对下属不满意?

ZhaoWu1050

【ZhaoWu的听课笔记】大多数公司,都存在两种问题。我创业四年,更是体会深切。这两种问题就是:老板经常不满意下属的表现;下属总是不知道老板想要什么;虽然这两种问题普遍存在,其实解决方法并不复杂。这节课,我们再聊聊第一个问题:为什么老板经常不满意下属表现?其实,这背后也是一条管理常识。管理学家德鲁克先生早就说过:管理者的任务,不是去改变人。*来自《卓有成效的管理者》只是大多数老板和我一样,都是一边

- vue3中el-table中点击图片放大时,被表格覆盖

叫我小鹏呀

vue.jsjavascript前端

问题:vue3中el-table中点击图片放大时,被表格覆盖。解决方法:el-image添加preview-teleported

- 正确解决ModuleNotFoundError: No module named ‘PIL‘异常的有效解决方法

飞码创造者

解决bug人工智能pythonbugpillow

正确解决ModuleNotFoundError:Nomodulenamed‘PIL‘异常的有效解决方法文章目录报错问题报错原因解决方法报错问题ModuleNotFoundError:Nomodulenamed‘PIL‘异常报错原因ModuleNotFoundError:Nomodule

- Python3.7出现“ModuleNotFoundError: No module named ‘Tkinter‘”错误的解决方法

可爱的小红猪

python

Python3.7出现“ModuleNotFoundError:Nomodulenamed‘Tkinter’”错误的解决方法在网上看到很多针对这个问题的解决方法都是重新安装或配置Tkinter库,但Tkinter是python内置的标准GUI库,安装Python时就已经内置在了库中,不需要另外下载。针对于Tkinter,你的代码很可能是这样的:importTkinter或者是这样fromTkint

- 浅谈MapReduce

Android路上的人

Hadoop分布式计算mapreduce分布式框架hadoop

从今天开始,本人将会开始对另一项技术的学习,就是当下炙手可热的Hadoop分布式就算技术。目前国内外的诸多公司因为业务发展的需要,都纷纷用了此平台。国内的比如BAT啦,国外的在这方面走的更加的前面,就不一一列举了。但是Hadoop作为Apache的一个开源项目,在下面有非常多的子项目,比如HDFS,HBase,Hive,Pig,等等,要先彻底学习整个Hadoop,仅仅凭借一个的力量,是远远不够的。

- Regular Expression 正则表达式

Aimyon_36

DataDevelopment正则表达式redis数据库

RegularExpression前言1.基本匹配2.元字符2.1点运算符.2.2字符集2.2.1否定字符集2.3重复次数2.3.1*号2.3.2+号2.3.3?号2.4{}号2.5(...)特征标群2.6|或运算符2.7转码特殊字符2.8锚点2.8.1^号2.8.2$号3.简写字符集4.零宽度断言(前后预查)4.1?=...正先行断言4.2?!...负先行断言4.3?Thefatcatsaton

- ArcGIS Pro SDK (十四)地图探索 5 时间与动画

WineMonk

ArcGISProSDKarcgisarcgisprosdkgisc#

ArcGISProSDK(十四)地图探索5时间与动画文章目录ArcGISProSDK(十四)地图探索5时间与动画1时间1.1时间提前1个月1.2禁用地图中的时间。2动画2.1设置动画长度2.2缩放动画2.3相机关键帧2.4插值相机2.5插值时间2.6插值范围2.7创建摄像机关键帧2.8创建时间关键帧2.9创建范围关键帧2.10创建图层关键帧环境:VisualStudio2022+.NET6+Arc

- 吴恩达深度学习笔记(30)-正则化的解释

极客Array

正则化(Regularization)深度学习可能存在过拟合问题——高方差,有两个解决方法,一个是正则化,另一个是准备更多的数据,这是非常可靠的方法,但你可能无法时时刻刻准备足够多的训练数据或者获取更多数据的成本很高,但正则化通常有助于避免过拟合或减少你的网络误差。如果你怀疑神经网络过度拟合了数据,即存在高方差问题,那么最先想到的方法可能是正则化,另一个解决高方差的方法就是准备更多数据,这也是非常

- Hadoop

傲雪凌霜,松柏长青

后端大数据hadoop大数据分布式

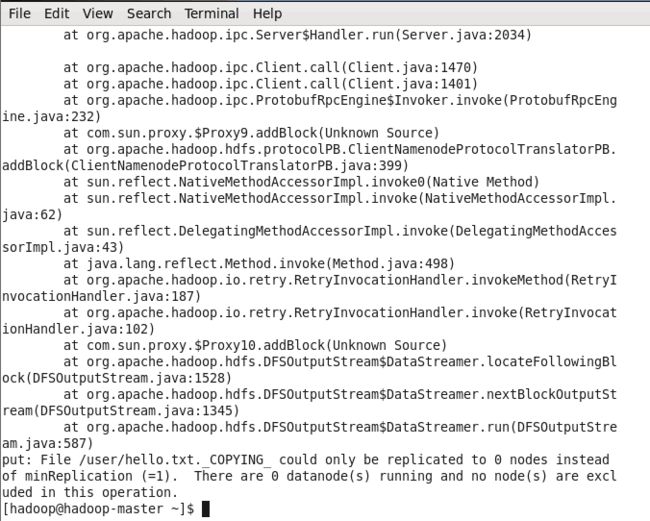

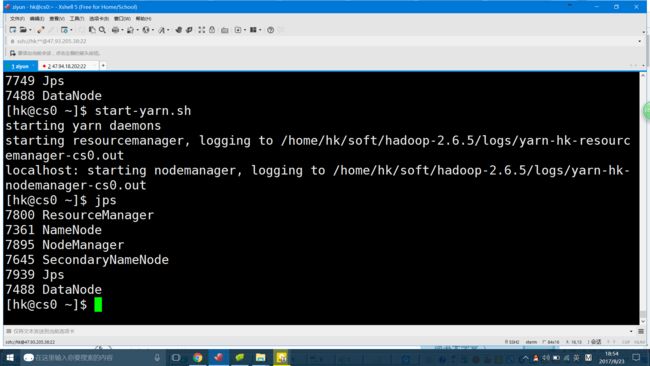

ApacheHadoop是一个开源的分布式计算框架,主要用于处理海量数据集。它具有高度的可扩展性、容错性和高效的分布式存储与计算能力。Hadoop核心由四个主要模块组成,分别是HDFS(分布式文件系统)、MapReduce(分布式计算框架)、YARN(资源管理)和HadoopCommon(公共工具和库)。1.HDFS(HadoopDistributedFileSystem)HDFS是Hadoop生

- Hadoop架构

henan程序媛

hadoop大数据分布式

一、案列分析1.1案例概述现在已经进入了大数据(BigData)时代,数以万计用户的互联网服务时时刻刻都在产生大量的交互,要处理的数据量实在是太大了,以传统的数据库技术等其他手段根本无法应对数据处理的实时性、有效性的需求。HDFS顺应时代出现,在解决大数据存储和计算方面有很多的优势。1.2案列前置知识点1.什么是大数据大数据是指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的大量数据集合,

- maven-assembly-plugin 打包实例

带着二娃去遛弯

1.先在pom.xml文件中添加assembly打包插件org.apache.maven.pluginsmaven-assembly-plugin2.6assembly/assembly.xmlmake-assemblypackagesingle说明:1.需要修改的可能就是descriptors标签下面的打包配置文件目录,指定assembly.xml的路径.2.可以添加多个打包配置文件,进行多种形

- 【K8s】专题十一:Kubernetes 集群证书过期处理方法

行者Sun1989

Kuberneteskubernetes云原生容器

本文内容均来自个人笔记并重新梳理,如有错误欢迎指正!如果对您有帮助,烦请点赞、关注、转发、订阅专栏!专栏订阅入口Linux专栏|Docker专栏|Kubernetes专栏往期精彩文章【Docker】(全网首发)KylinV10下MySQL容器内存占用异常的解决方法【Docker】(全网首发)KylinV10下MySQL容器内存占用异常的解决方法(续)【Docker】MySQL源码构建Docker镜

- Cut, Paste and Learn方法解读

wangxinwei2000

深度学习人工智能

Abstract问题背景:标注数据的缺乏:在实例检测任务中,部署物体检测模型的一个主要障碍是缺乏大量标注数据。例如,在一个特定的厨房环境中找到包含实例的大型标注数据集是不太可能的。每当面对新的环境和新的物体实例时,都需要进行昂贵的数据收集和标注工作。研究贡献:解决方法:本文提出了一种简单的方法,可以以最小的努力生成大量标注的实例数据集。关键洞察:研究者的关键洞察是,仅仅确保“局部真实感”(patc

- 管理员权限的软件不能开机自启动的解决方法

ss_ctrl

这是几种解决方法:1.将启动参数写入到32位注册表里面去在64位系统下我们64位的程序访问此HKEY_LOCAL_MACHINE\SOFTWARE\Microsoft\Windows\CurrentVersion\Run注册表路径,是可以正确访问的,32位程序访问此注册表路径时,默认会被系统自动映射到HKEY_LOCAL_MACHINE\SOFTWARE\WOW6432Node\Microsoft

- 分享一个基于python的电子书数据采集与可视化分析 hadoop电子书数据分析与推荐系统 spark大数据毕设项目(源码、调试、LW、开题、PPT)

计算机源码社

Python项目大数据大数据pythonhadoop计算机毕业设计选题计算机毕业设计源码数据分析spark毕设

作者:计算机源码社个人简介:本人八年开发经验,擅长Java、Python、PHP、.NET、Node.js、Android、微信小程序、爬虫、大数据、机器学习等,大家有这一块的问题可以一起交流!学习资料、程序开发、技术解答、文档报告如需要源码,可以扫取文章下方二维码联系咨询Java项目微信小程序项目Android项目Python项目PHP项目ASP.NET项目Node.js项目选题推荐项目实战|p

- talib的python库安装

jesonwz

python开发语言

talib的python库安装反正用清华源装不上发现talib的指标好多,想着用用,结果在python里装不上,清华源里提示找不到。也难怪,这个库上网查了一下,最新一次更新是在2013年,太老了。废话不说,上我的解决办法。解决方法步骤(靠谱的)思路:既然在线装不上,就用离线的1.下载对应python版本的talib的whl版本安装文件,链接在这:https://blog.csdn.net/FL16

- 相对与绝对路径、命令:cd、mkdir、rmdir、rm

强出头

2.6相对和绝对路径绝对路径:都是从根目录/开始的就是绝对路径,无论在任何目录下都能通过该路径找到该文件相对路径:不是以根目录开头的,相对当前目录的路径[root@mylinuxetc]#cat/etc/sysconfig/network-scripts/ifcfg-ens33(这里我们使用绝对路径查看文件ifcfg-ens33)[root@mylinuxetc]#cd/etc/sysconfig

- 颜汝老师2.6号直播@命硬私董会

酸梅子616

一层:用番茄钟;一次只做一件事;做到有结果再去做另一件事专注第二层:石墨文档全屏功能;让你完全忘记时间;抖音就是让你经常偷走时间的软件专注第三层:当别人没给你设置倒计时,你要给自己设置倒计时;有意识去给自己倒计时;乔布斯假如今天是我生命中的最后一天我要如何对待这一天)人有两种状态:一种是懒洋洋状态;另一种是灰大狼专注记者思维;随时随地进入专注的状态的那个人生疑问是什么,去训练自己,去给生活做结合;

- 安装依赖时报错:npm ERR! code ERESOLVE npm ERR! ERESOLVE could not resolve npm ERR! npm ERR! While resolving

帅气绝非偶然

npm前端node.js

这里我在npmivant@latest-v2或者其他依赖包的时候出现以上错误可能是npm版本问题报错解决方法:在安装命令后边加上1|--legacy-peer-deps或者--force如图中的指令:

- hbase介绍

CrazyL-

云计算+大数据hbase

hbase是一个分布式的、多版本的、面向列的开源数据库hbase利用hadoophdfs作为其文件存储系统,提供高可靠性、高性能、列存储、可伸缩、实时读写、适用于非结构化数据存储的数据库系统hbase利用hadoopmapreduce来处理hbase、中的海量数据hbase利用zookeeper作为分布式系统服务特点:数据量大:一个表可以有上亿行,上百万列(列多时,插入变慢)面向列:面向列(族)的

- 2020-07-08在js文件中使用elementUi报错TypeError: _this10.$message is not a function

Kason晨

问题:全局挂在elementUi后,在js文件内调用,报错_this10.$messageisnotafunction原因:在js文件里找不到this.$message这个属性。#错误的写法:this.$message({message:"解除成功",type:"success"});解决方法(正确写法):单独引入,和换一种方法使用://引入import{Message}from"element-

- 【MySQL】Win10安装MySQL-5.7.24-winX64 启动服务器失败并且没有错误提示

Jinlong_Xu

数据库SQL实战mysql-5.7.24MySQL服务无法启动netstartmysql

今天安装mysql-5.24-winX64后,在bin目录下运行netstartmysql,出现无法启动的情况:找了很多的教程,大部分的教程都是类似于下面的解决方案:但是我使用这些解决方法的时候,发现并不能很好的解决这个问题。我就核对我和他们的不一样,同时注意到cmd中打印的信息:我注意到很多的解决方案都是要初始化,所以我觉得我可能初始化的命令不对。步骤一:删除mysql目录下的data文件夹中的

- 《黑神话:悟空》游戏AkExpander.dll文件缺失,使用工具修复更快捷

李秋秋啊

游戏

在Windows操作系统中,当遇到“黑神话:悟空”游戏中的AkExpander.dll文件丢失问题时,用户可能会经历游戏启动失败或运行中断的情况。这个DLL文件是游戏正常运行所必需的,缺失或损坏会导致关键功能无法执行,影响游戏体验。针对《黑神话:悟空》游戏中AkExpander.dll文件缺失的问题,您可以尝试以下几种解决方法:一、重新安装游戏首先,考虑卸载当前安装的游戏版本,并从官方渠道重新下载

- educoder实训平台python顺序结构答案_Educoder Python顺序结构习题

weixin_39710660

1.正方形与等腰三角形组成的多边形的面积square_length=4triangle_h=2.6area_square=4*4area_triangle=(2.6*4)/2area_total=area_square+area_triangleprint(area_total)2.平抛小球与抛出点的距离G=9.8v0=5t=2s=v0*th=(G*t**2)/2d=(s**2+h**2)**0.

- 大数据毕业设计hadoop+spark+hive知识图谱租房数据分析可视化大屏 租房推荐系统 58同城租房爬虫 房源推荐系统 房价预测系统 计算机毕业设计 机器学习 深度学习 人工智能

2401_84572577

程序员大数据hadoop人工智能

做了那么多年开发,自学了很多门编程语言,我很明白学习资源对于学一门新语言的重要性,这些年也收藏了不少的Python干货,对我来说这些东西确实已经用不到了,但对于准备自学Python的人来说,或许它就是一个宝藏,可以给你省去很多的时间和精力。别在网上瞎学了,我最近也做了一些资源的更新,只要你是我的粉丝,这期福利你都可拿走。我先来介绍一下这些东西怎么用,文末抱走。(1)Python所有方向的学习路线(

- Certificate has expired(npm 安装strapi)

窥见漫天星光-莹

npmstrapi

报错信息解决方法1、清空缓存,有时,损坏的缓存会导致连接问题npmcacheclean--force2、切换到淘宝镜像源的npm注册表npmconfigsetregistryhttps://registry.npmmirror.com/执行这两步后就可以执行自己想要安装的东西了,我是在执行npxcreate-strapi-appschedul命令创建strapi项目时报上述错误。仅供参考。当然再安

- 2022年5月23日《0—8岁儿童自律教育》培训总结

心态决定一切

-------杨丹妮+春蕾怡馨幼儿园感受:当遇到纪律教育问题的时候应该如何操作1.发现孩子的行为问题,首先我们就是要分析问题的原因,然后根据原因要追究其问题的根本所在,寻找解决方法。2.纪律教育问题的解决是需要时间的。包括儿童学习需要时间、成人做计划需要时间,不是一朝一夕就能改变的,一定要有耐心,做好持久战的准备。3.成人的态度至关重要,无论孩子犯了怎样的行为问题,我们一定要平静下来再和孩子沟通,

- Mac 技术篇-应用程序被锁定无法进行卸载问题解决方法,文件、文件夹被锁定无法移入废纸篓处理方法

lq9527_

Mac使用macos

在卸载Karabiner-Elements和Karabiner-EventViewer软件时,提示应用锁定,无法卸载。参照方法。在进行/bin/ls-dleO@App路径操作后,返回提示信息与链接方法略有区别。/bin/ls-dleO@App路径drwxr-xr-x@3root wheel uchg96 3 1 2022/Applications/Karabiner-Elements.appcom

- 搜狗输入法输入上下标

xzlAwin

系统

搜狗输入法输入上下标解决方法使用自定义短语映射上下标设置[设置]→[属性设置]→[高级]→[自定义短语]→[自定义短语设置]→[直接编辑配置文件]常用上下标表常用上标⁰¹²³⁴⁵⁶⁷⁸⁹⁺⁻⁼⁽⁾ⁿº˙常用下标₀₁₂₃₄₅₆₇₈₉₊₋₌₍₎ₐₑₒₓₔₕₖₗₘₙₚₛₜ更多上标ᵃᵇᶜᵈᵉᵍʰⁱʲᵏˡᵐⁿᵒᵖᵒ⃒ʳˢᵗᵘᵛʷˣʸᙆᴬᴮᒼᴰᴱᴳᴴᴵᴶᴷᴸᴹᴺᴼᴾᴼ̴ᴿˢᵀᵁᵂˣᵞᙆꝰˀˁˤꟸꭜʱꭝꭞʴʵʶ

- 2024Mysql And Redis基础与进阶操作系列(8)作者——LJS[含MySQL 创建、修改、跟新、重命名、删除视图等具体详步骤;注意点及常见报错问题所对应的解决方法]

肾透侧视攻城狮

MYSQLREDISAdvanceoperationredismysql数据库linuxsqlbashadb

目录1MySQL视图1.概念2.作用3.特点4.具体如何操作实现MYSQL视图4.1创建视图语法示例查看表和视图查看视图的结构查看视图属性信息(比如:显示数据表的存储引擎、版本、数据行数和数据大小等)查看视图的详细定义信息4.2修改视图简介格式举例4.3更新视图简介下述结构中不可更新的视图补充说明举例更新视图视图包含聚合函数不可更新视图包含distinct不可更新视图包含goupby、having

- JAVA中的Enum

周凡杨

javaenum枚举

Enum是计算机编程语言中的一种数据类型---枚举类型。 在实际问题中,有些变量的取值被限定在一个有限的范围内。 例如,一个星期内只有七天 我们通常这样实现上面的定义:

public String monday;

public String tuesday;

public String wensday;

public String thursday

- 赶集网mysql开发36条军规

Bill_chen

mysql业务架构设计mysql调优mysql性能优化

(一)核心军规 (1)不在数据库做运算 cpu计算务必移至业务层; (2)控制单表数据量 int型不超过1000w,含char则不超过500w; 合理分表; 限制单库表数量在300以内; (3)控制列数量 字段少而精,字段数建议在20以内

- Shell test命令

daizj

shell字符串test数字文件比较

Shell test命令

Shell中的 test 命令用于检查某个条件是否成立,它可以进行数值、字符和文件三个方面的测试。 数值测试 参数 说明 -eq 等于则为真 -ne 不等于则为真 -gt 大于则为真 -ge 大于等于则为真 -lt 小于则为真 -le 小于等于则为真

实例演示:

num1=100

num2=100if test $[num1]

- XFire框架实现WebService(二)

周凡杨

javawebservice

有了XFire框架实现WebService(一),就可以继续开发WebService的简单应用。

Webservice的服务端(WEB工程):

两个java bean类:

Course.java

package cn.com.bean;

public class Course {

private

- 重绘之画图板

朱辉辉33

画图板

上次博客讲的五子棋重绘比较简单,因为只要在重写系统重绘方法paint()时加入棋盘和棋子的绘制。这次我想说说画图板的重绘。

画图板重绘难在需要重绘的类型很多,比如说里面有矩形,园,直线之类的,所以我们要想办法将里面的图形加入一个队列中,这样在重绘时就

- Java的IO流

西蜀石兰

java

刚学Java的IO流时,被各种inputStream流弄的很迷糊,看老罗视频时说想象成插在文件上的一根管道,当初听时觉得自己很明白,可到自己用时,有不知道怎么代码了。。。

每当遇到这种问题时,我习惯性的从头开始理逻辑,会问自己一些很简单的问题,把这些简单的问题想明白了,再看代码时才不会迷糊。

IO流作用是什么?

答:实现对文件的读写,这里的文件是广义的;

Java如何实现程序到文件

- No matching PlatformTransactionManager bean found for qualifier 'add' - neither

林鹤霄

java.lang.IllegalStateException: No matching PlatformTransactionManager bean found for qualifier 'add' - neither qualifier match nor bean name match!

网上找了好多的资料没能解决,后来发现:项目中使用的是xml配置的方式配置事务,但是

- Row size too large (> 8126). Changing some columns to TEXT or BLOB

aigo

column

原文:http://stackoverflow.com/questions/15585602/change-limit-for-mysql-row-size-too-large

异常信息:

Row size too large (> 8126). Changing some columns to TEXT or BLOB or using ROW_FORMAT=DYNAM

- JS 格式化时间

alxw4616

JavaScript

/**

* 格式化时间 2013/6/13 by 半仙

[email protected]

* 需要 pad 函数

* 接收可用的时间值.

* 返回替换时间占位符后的字符串

*

* 时间占位符:年 Y 月 M 日 D 小时 h 分 m 秒 s 重复次数表示占位数

* 如 YYYY 4占4位 YY 占2位<p></p>

* MM DD hh mm

- 队列中数据的移除问题

百合不是茶

队列移除

队列的移除一般都是使用的remov();都可以移除的,但是在昨天做线程移除的时候出现了点问题,没有将遍历出来的全部移除, 代码如下;

//

package com.Thread0715.com;

import java.util.ArrayList;

public class Threa

- Runnable接口使用实例

bijian1013

javathreadRunnablejava多线程

Runnable接口

a. 该接口只有一个方法:public void run();

b. 实现该接口的类必须覆盖该run方法

c. 实现了Runnable接口的类并不具有任何天

- oracle里的extend详解

bijian1013

oracle数据库extend

扩展已知的数组空间,例:

DECLARE

TYPE CourseList IS TABLE OF VARCHAR2(10);

courses CourseList;

BEGIN

-- 初始化数组元素,大小为3

courses := CourseList('Biol 4412 ', 'Psyc 3112 ', 'Anth 3001 ');

--

- 【httpclient】httpclient发送表单POST请求

bit1129

httpclient

浏览器Form Post请求

浏览器可以通过提交表单的方式向服务器发起POST请求,这种形式的POST请求不同于一般的POST请求

1. 一般的POST请求,将请求数据放置于请求体中,服务器端以二进制流的方式读取数据,HttpServletRequest.getInputStream()。这种方式的请求可以处理任意数据形式的POST请求,比如请求数据是字符串或者是二进制数据

2. Form

- 【Hive十三】Hive读写Avro格式的数据

bit1129

hive

1. 原始数据

hive> select * from word;

OK

1 MSN

10 QQ

100 Gtalk

1000 Skype

2. 创建avro格式的数据表

hive> CREATE TABLE avro_table(age INT, name STRING)STORE

- nginx+lua+redis自动识别封解禁频繁访问IP

ronin47

在站点遇到攻击且无明显攻击特征,造成站点访问慢,nginx不断返回502等错误时,可利用nginx+lua+redis实现在指定的时间段 内,若单IP的请求量达到指定的数量后对该IP进行封禁,nginx返回403禁止访问。利用redis的expire命令设置封禁IP的过期时间达到在 指定的封禁时间后实行自动解封的目的。

一、安装环境:

CentOS x64 release 6.4(Fin

- java-二叉树的遍历-先序、中序、后序(递归和非递归)、层次遍历

bylijinnan

java

import java.util.LinkedList;

import java.util.List;

import java.util.Stack;

public class BinTreeTraverse {

//private int[] array={ 1, 2, 3, 4, 5, 6, 7, 8, 9 };

private int[] array={ 10,6,

- Spring源码学习-XML 配置方式的IoC容器启动过程分析

bylijinnan

javaspringIOC

以FileSystemXmlApplicationContext为例,把Spring IoC容器的初始化流程走一遍:

ApplicationContext context = new FileSystemXmlApplicationContext

("C:/Users/ZARA/workspace/HelloSpring/src/Beans.xml&q

- [科研与项目]民营企业请慎重参与军事科技工程

comsci

企业

军事科研工程和项目 并非要用最先进,最时髦的技术,而是要做到“万无一失”

而民营科技企业在搞科技创新工程的时候,往往考虑的是技术的先进性,而对先进技术带来的风险考虑得不够,在今天提倡军民融合发展的大环境下,这种“万无一失”和“时髦性”的矛盾会日益凸显。。。。。。所以请大家在参与任何重大的军事和政府项目之前,对

- spring 定时器-两种方式

cuityang

springquartz定时器

方式一:

间隔一定时间 运行

<bean id="updateSessionIdTask" class="com.yang.iprms.common.UpdateSessionTask" autowire="byName" />

<bean id="updateSessionIdSchedule

- 简述一下关于BroadView站点的相关设计

damoqiongqiu

view

终于弄上线了,累趴,戳这里http://www.broadview.com.cn

简述一下相关的技术点

前端:jQuery+BootStrap3.2+HandleBars,全站Ajax(貌似对SEO的影响很大啊!怎么破?),用Grunt对全部JS做了压缩处理,对部分JS和CSS做了合并(模块间存在很多依赖,全部合并比较繁琐,待完善)。

后端:U

- 运维 PHP问题汇总

dcj3sjt126com

windows2003

1、Dede(织梦)发表文章时,内容自动添加关键字显示空白页

解决方法:

后台>系统>系统基本参数>核心设置>关键字替换(是/否),这里选择“是”。

后台>系统>系统基本参数>其他选项>自动提取关键字,这里选择“是”。

2、解决PHP168超级管理员上传图片提示你的空间不足

网站是用PHP168做的,反映使用管理员在后台无法

- mac 下 安装php扩展 - mcrypt

dcj3sjt126com

PHP

MCrypt是一个功能强大的加密算法扩展库,它包括有22种算法,phpMyAdmin依赖这个PHP扩展,具体如下:

下载并解压libmcrypt-2.5.8.tar.gz。

在终端执行如下命令: tar zxvf libmcrypt-2.5.8.tar.gz cd libmcrypt-2.5.8/ ./configure --disable-posix-threads --

- MongoDB更新文档 [四]

eksliang

mongodbMongodb更新文档

MongoDB更新文档

转载请出自出处:http://eksliang.iteye.com/blog/2174104

MongoDB对文档的CURD,前面的博客简单介绍了,但是对文档更新篇幅比较大,所以这里单独拿出来。

语法结构如下:

db.collection.update( criteria, objNew, upsert, multi)

参数含义 参数

- Linux下的解压,移除,复制,查看tomcat命令

y806839048

tomcat

重复myeclipse生成webservice有问题删除以前的,干净

1、先切换到:cd usr/local/tomcat5/logs

2、tail -f catalina.out

3、这样运行时就可以实时查看运行日志了

Ctrl+c 是退出tail命令。

有问题不明的先注掉

cp /opt/tomcat-6.0.44/webapps/g

- Spring之使用事务缘由(3-XML实现)

ihuning

spring

用事务通知声明式地管理事务

事务管理是一种横切关注点。为了在 Spring 2.x 中启用声明式事务管理,可以通过 tx Schema 中定义的 <tx:advice> 元素声明事务通知,为此必须事先将这个 Schema 定义添加到 <beans> 根元素中去。声明了事务通知后,就需要将它与切入点关联起来。由于事务通知是在 <aop:

- GCD使用经验与技巧浅谈

啸笑天

GC

前言

GCD(Grand Central Dispatch)可以说是Mac、iOS开发中的一大“利器”,本文就总结一些有关使用GCD的经验与技巧。

dispatch_once_t必须是全局或static变量

这一条算是“老生常谈”了,但我认为还是有必要强调一次,毕竟非全局或非static的dispatch_once_t变量在使用时会导致非常不好排查的bug,正确的如下: 1

- linux(Ubuntu)下常用命令备忘录1

macroli

linux工作ubuntu

在使用下面的命令是可以通过--help来获取更多的信息1,查询当前目录文件列表:ls

ls命令默认状态下将按首字母升序列出你当前文件夹下面的所有内容,但这样直接运行所得到的信息也是比较少的,通常它可以结合以下这些参数运行以查询更多的信息:

ls / 显示/.下的所有文件和目录

ls -l 给出文件或者文件夹的详细信息

ls -a 显示所有文件,包括隐藏文

- nodejs同步操作mysql

qiaolevip

学习永无止境每天进步一点点mysqlnodejs

// db-util.js

var mysql = require('mysql');

var pool = mysql.createPool({

connectionLimit : 10,

host: 'localhost',

user: 'root',

password: '',

database: 'test',

port: 3306

});

- 一起学Hive系列文章

superlxw1234

hiveHive入门

[一起学Hive]系列文章 目录贴,入门Hive,持续更新中。

[一起学Hive]之一—Hive概述,Hive是什么

[一起学Hive]之二—Hive函数大全-完整版

[一起学Hive]之三—Hive中的数据库(Database)和表(Table)

[一起学Hive]之四-Hive的安装配置

[一起学Hive]之五-Hive的视图和分区

[一起学Hive

- Spring开发利器:Spring Tool Suite 3.7.0 发布

wiselyman

spring

Spring Tool Suite(简称STS)是基于Eclipse,专门针对Spring开发者提供大量的便捷功能的优秀开发工具。

在3.7.0版本主要做了如下的更新:

将eclipse版本更新至Eclipse Mars 4.5 GA

Spring Boot(JavaEE开发的颠覆者集大成者,推荐大家学习)的配置语言YAML编辑器的支持(包含自动提示,