#每天一篇论文#(223/365)实时video深度估计的时间关联研究

Exploiting temporal consistency for real-time video depth estimation∗

摘要

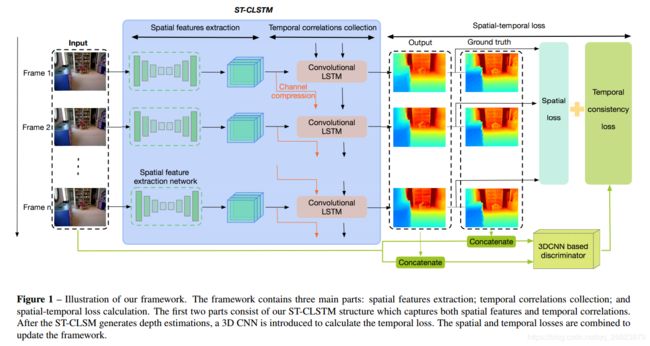

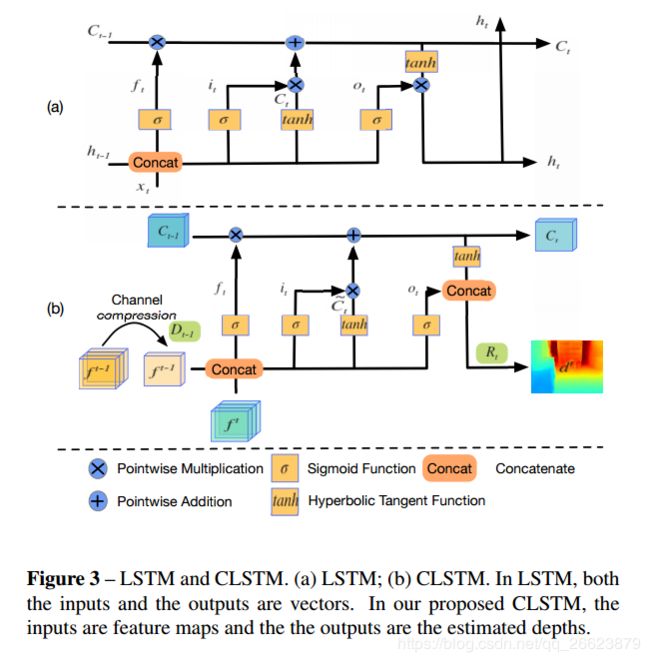

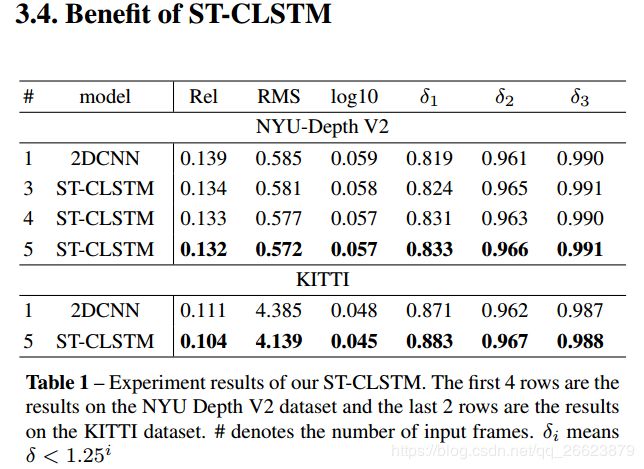

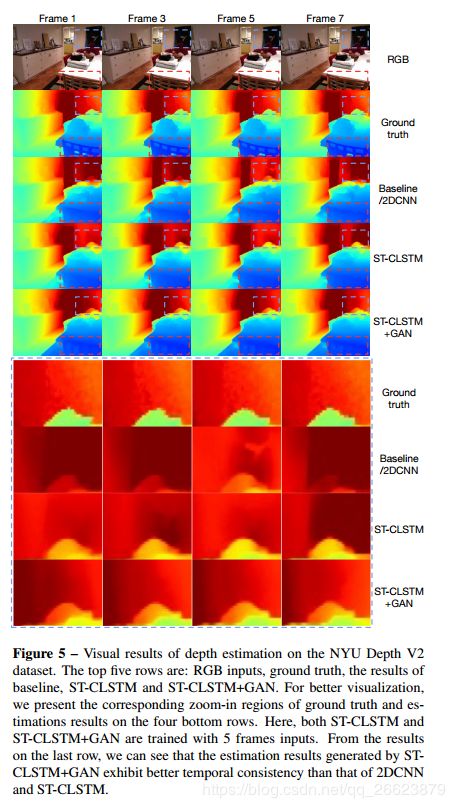

通过利用来自深度卷积神经网络(CNN)的分层特征,最近已经显着改善了静态图像的深度估计的准确性。与静态图像相比,视频帧之间存在大量信息,可以利用这些信息来提高深度估计性能。在这项工作中,我们专注于探索单目视频的时间信息,以进行深度估计。具体而言,我们利用卷积长短期记忆(CLSTM)的优势,并提出一种新颖的时空CSLTM(ST-CLSTM)结构。我们的ST-CLSTM结构不仅可以捕获空间特征,还可以捕获连续视频帧之间的时间相关性/一致性,计算成本可以忽略不计。另外,为了维持估计的深度帧之间的时间一致性,我们应用生成对抗性学习方案并设计时间一致性损失。时间一致性损失与空间损失相结合,以端到端的方式更新模型。通过利用时间信息,我们构建了一个实时运行的视频深度估算框架,并生成视觉上令人满意的结果。此外,我们的方法是灵活的,可以推广到大多数现有的深度估算框架。

贡献

我们提出了一种新颖的ST-CLSTM结构,其能够捕获视频深度估计的空间特征以及时间相关性。 据我们所知,这是第一次将CLSTM用于视频深度估算。

我们使用生成对抗性学习方案设计了一种新的时间一致性损失。 我们的时间损失可以进一步加强时间一致性并改善视频深度估计的性能。

我们提出的视频深度估算框架可以实时执行,并可以推广到大多数现有的深度估计算。

方法

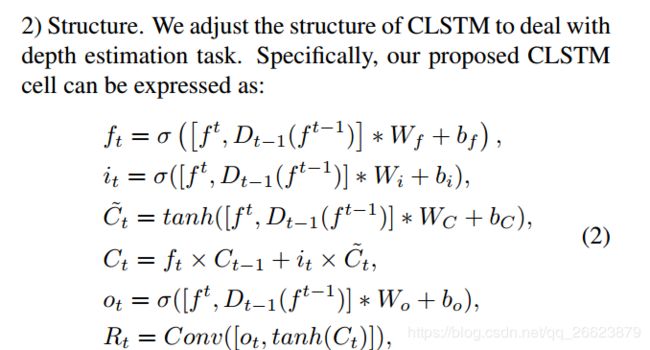

本文主要是使用ST-CLSTM网络,利用卷积CLSTM的特点提高空间特征的捕获能力